diff --git a/README.md b/README.md

index f6b4896..17ec091 100644

--- a/README.md

+++ b/README.md

@@ -2,8 +2,8 @@

-

+

@@ -21,16 +21,15 @@ O penguin-datalayer-collect é um modulo do ecossitema raf-suite criado pela DP6

## Ecossistema raft-suite

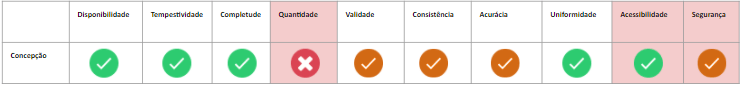

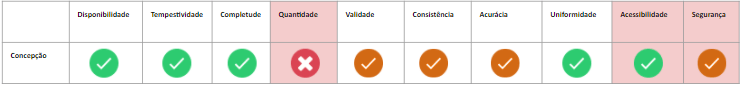

O penguin-datalayer-collect consegue auxiliar as áreas de digital analytics das empresas nos seguintes pilares da qualidade de dados:

-

-* Disponibilidade

-* Completude

-* Validade

-* Consistência

-* Acurácia

-* Uniformidade

-

-Essa abrangência pode ser observada com mais detalhes na imagem abaixo que representa o ciclo de vida do dado, e em quais momentos a solução pode ser aplicada.

+- Disponibilidade

+- Completude

+- Validade

+- Consistência

+- Acurácia

+- Uniformidade

+

+Essa abrangência pode ser observada com mais detalhes na imagem abaixo que representa o ciclo de vida do dado, e em quais momentos a solução pode ser aplicada.

@@ -141,33 +140,70 @@ O código da tag fornecido acima, utiliza a biblioteca [easy-collect](https://gi

O penguin-datalayer-collect também pode ser utilizado para validar a coleta server-side, necessitando apenas que a coleta consiga gerar um array com as chaves implementadas.

## 4. Enriquecendos os dados com informações de negócio

+

A implementação do penguin-datalayer-collect disponibiliza alguns dados brutos, eles são obtidos a partir da validação da camada de dados com base nos schemas fornecido para o validador, é importante salientar que o resulto depende do schema de validação, então sempre que ocorrer uma alteração na especificação técnica da camada de dados os schemas devem refletir as mesmas.

Os dados padrões são:

-| Nome | Tipo | Opcional | Descrição |

-| --------- | --------- | --------- | ----------------------------|

-| data | DATETIME | Não | Datatime com timezone America/Sao_Paulo no padrão yyyy-mm-ddThh:mm:ss|

-| schema | STRING | Não | Nome do schema utilizado para validação das chaves |

-| status | STRING | Não | Status da validação que pode ser (ERRO, WARNING ou OK) |

-| objectName | STRING | Sim | Nome do objeto da camada de dados validada |

-| keyName | STRING | Sim | Chave da camada de dados validada |

-Os dados padrões por si só, possibilita visualizações básicas da saúde da camada de dados, pois com esses dados as possibilidades de cruzamentos e classificação são poucas, entretanto, é muito fácil enriquecer os dados de validação com dados customizados do domínio de negócio, por meio da customização da tag base **3.1 GTM Web**.

+

@@ -21,16 +21,15 @@ O penguin-datalayer-collect é um modulo do ecossitema raf-suite criado pela DP6

## Ecossistema raft-suite

O penguin-datalayer-collect consegue auxiliar as áreas de digital analytics das empresas nos seguintes pilares da qualidade de dados:

-

-* Disponibilidade

-* Completude

-* Validade

-* Consistência

-* Acurácia

-* Uniformidade

-

-Essa abrangência pode ser observada com mais detalhes na imagem abaixo que representa o ciclo de vida do dado, e em quais momentos a solução pode ser aplicada.

+- Disponibilidade

+- Completude

+- Validade

+- Consistência

+- Acurácia

+- Uniformidade

+

+Essa abrangência pode ser observada com mais detalhes na imagem abaixo que representa o ciclo de vida do dado, e em quais momentos a solução pode ser aplicada.

@@ -141,33 +140,70 @@ O código da tag fornecido acima, utiliza a biblioteca [easy-collect](https://gi

O penguin-datalayer-collect também pode ser utilizado para validar a coleta server-side, necessitando apenas que a coleta consiga gerar um array com as chaves implementadas.

## 4. Enriquecendos os dados com informações de negócio

+

A implementação do penguin-datalayer-collect disponibiliza alguns dados brutos, eles são obtidos a partir da validação da camada de dados com base nos schemas fornecido para o validador, é importante salientar que o resulto depende do schema de validação, então sempre que ocorrer uma alteração na especificação técnica da camada de dados os schemas devem refletir as mesmas.

Os dados padrões são:

-| Nome | Tipo | Opcional | Descrição |

-| --------- | --------- | --------- | ----------------------------|

-| data | DATETIME | Não | Datatime com timezone America/Sao_Paulo no padrão yyyy-mm-ddThh:mm:ss|

-| schema | STRING | Não | Nome do schema utilizado para validação das chaves |

-| status | STRING | Não | Status da validação que pode ser (ERRO, WARNING ou OK) |

-| objectName | STRING | Sim | Nome do objeto da camada de dados validada |

-| keyName | STRING | Sim | Chave da camada de dados validada |

-Os dados padrões por si só, possibilita visualizações básicas da saúde da camada de dados, pois com esses dados as possibilidades de cruzamentos e classificação são poucas, entretanto, é muito fácil enriquecer os dados de validação com dados customizados do domínio de negócio, por meio da customização da tag base **3.1 GTM Web**.

+

+

+

+ | Nome |

+ Tipo |

+ Opcional |

+ Descrição |

+

+

+

+

+ | data |

+ DATETIME |

+ Não |

+

+ Datatime com timezone America/Sao_Paulo no padrão yyyy-mm-ddThh:mm:ss

+ |

+

+

+ | schema |

+ STRING |

+ Não |

+ Nome do schema utilizado para validação das chaves |

+

+

+ | status |

+ STRING |

+ Não |

+ Status da validação que pode ser (ERRO, WARNING ou OK) |

+

+

+ | objectName |

+ STRING |

+ Sim |

+ Nome do objeto da camada de dados validada |

+

+

+ | keyName |

+ STRING |

+ Sim |

+ Chave da camada de dados validada |

+

+

+

+

+Os dados padrões por si só, possibilitam visualizações básicas da saúde da camada de dados, pois com esses dados as possibilidades de cruzamentos e classificação são poucas, entretanto, é muito fácil enriquecer os dados de validação com dados customizados do domínio de negócio, por meio da customização da tag base **3.1 GTM Web**.

A adição de novas dimensões é bem simples, basta disponibilizar os dados escolhidos como parâmetros query string no endoint de validação, fazendo isso os parâmetros fornecidos estarão disponíveis para todas as validações, e serão inseridos no bigquery juntos com os dados padrões, na tabela **penguin_datalayer_raw**.

Para que a inserção ocorra com sucesso é necessário apenas atualizar o schema da tabela disponível no json de configuração.

-

Para saber mais sobre o funcionamento do penguin-datalayer-collect e como customizar os dados acesse nossa wiki.

-

## 5. Dashboard de acompanhamento

+

A base de dados criada pelo penguin-datalayer-collect, pode ser utilizada para diversas análises fazendo o cruzamento com os dados de domínio do negócio, porém a DP6 desenvolveu um dashboard base para monitoramento das métricas de erros disponibilizada pelo módulo.

-

## 6. Como contribuir

Pull requests são bem-vindos! Nós vamos adorar ajuda para evoluir esse modulo. Senta-se livre para navegar por open issues buscando por algo que possa fazer. Caso temha uma nova feature ou bug, por favor abra uma nova issue para ser acompanhada pelo nosso time.

diff --git a/codecov.yml b/codecov.yml

deleted file mode 100644

index 5081adf..0000000

--- a/codecov.yml

+++ /dev/null

@@ -1,8 +0,0 @@

-codecov:

- bot: dp6-koopas

- require_ci_to_pass: yes

-

-coverage:

- precision: 2

- round: down

- range: "50...100"

diff --git a/package.json b/package.json

index 26002b7..afc5a74 100644

--- a/package.json

+++ b/package.json

@@ -40,7 +40,15 @@

},

"homepage": "https://github.com/DP6/penguin-datalayer-collect#readme",

"release": {

- "branch": "master"

+ "branch": "master",

+ "plugins": [

+ "@semantic-release/commit-analyzer",

+ "@semantic-release/release-notes-generator",

+ ["@semantic-release/npm", {

+ "npmPublish": false

+ }],

+ ["@semantic-release/github"]

+ ]

},

"dependencies": {

"@dp6/penguin-datalayer-core": "^1.1.3",

diff --git a/terraform/main.tf b/terraform/main.tf

index 8fdc56b..f47f46b 100644

--- a/terraform/main.tf

+++ b/terraform/main.tf

@@ -159,7 +159,7 @@ resource "google_bigquery_data_transfer_config" "query_config_aggregation" {

params = {

destination_table_name_template = local.bq_table_id_aggregation

write_disposition = "WRITE_APPEND"

- query = "SELECT * FROM ${var.project_id}.${local.final_dataset_id}.${local.bq_table_id_aggregation}"

+ query = "SELECT * FROM ${var.project_id}.${local.final_dataset_id}.${local.bq_view_aggregation}"

}

}

@@ -174,7 +174,7 @@ resource "google_bigquery_data_transfer_config" "query_config_diagnostic" {

params = {

destination_table_name_template = local.bq_table_id_diagnostic

write_disposition = "WRITE_APPEND"

- query = "SELECT * FROM ${var.project_id}.${local.final_dataset_id}.${local.bq_table_id_diagnostic}"

+ query = "SELECT * FROM ${var.project_id}.${local.final_dataset_id}.${local.bq_view_diagnostic}"

}

}

-

-

-

-