加入社区

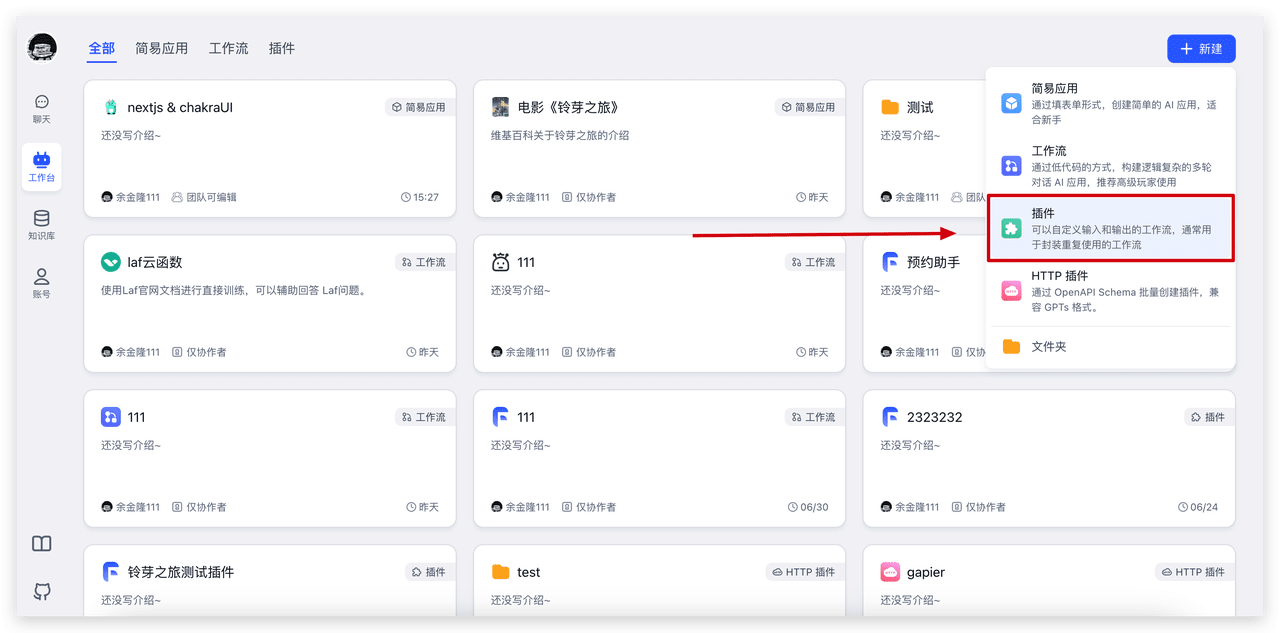

加入 FastGPT 开发者社区和我们一起成长

FastGPT 是一个由用户和贡献者参与推动的开源项目,如果您对产品使用存在疑问和建议,可尝试以下方式寻求支持。我们的团队与社区会竭尽所能为您提供帮助。

📱 扫码加入社区微信交流群👇

🐞 请将任何 FastGPT 的 Bug、问题和需求提交到 GitHub Issue。

FastGPT 开源许可证

FastGPT 项目在 Apache License 2.0 许可下开源,同时包含以下附加条件:

FastGPT 允许被用于商业化,例如作为其他应用的“后端即服务”使用,或者作为应用开发平台提供给企业。然而,当满足以下条件时,必须联系作者获得商业许可:

请通过电子邮件 yujinlong@sealos.io 联系我们咨询许可事宜。

作为贡献者,你必须同意将你贡献的代码用于以下用途:

除此之外,所有其他权利和限制均遵循 Apache License 2.0。如果你需要更多详细信息,可以参考 Apache License 2.0 的完整版本。本产品的交互设计受到外观专利保护。© 2023 Sealos.

FastGPT 隐私政策

最后更新时间:2024年3月3日

我们非常重视您的隐私保护,在您使用FastGPT云服务时(以下简称为“本服务”),我们将按照以下政策收集、使用、披露和保护您的个人信息。请您仔细阅读并充分理解本隐私政策。

我们可能需要收集的信息

我们如何使用收集的信息?

信息披露

我们不会向任何第三方披露您的个人信息,除非:

我们可能与关联公司、合作伙伴分享您的个人信息,但我们会采取相应的保密措施,确保信息安全。

信息保护

用户权利

隐私政策更新

未成年人保护

我们非常重视对未成年人个人信息的保护,如您为未成年人,请在监护人指导下使用本服务,并请监护人帮助您在使用本服务过程中正确处理个人信息。

跨境数据传输

由于我们的服务器可能位于不同国家或地区,您同意我们可能需要将您的个人信息传输至其他国家或地区,并在该等国家或地区存储和处理以向您提供服务。我们会采取适当措施确保跨境传输的数据仍然受到适当保护。

联系我们

FastGPT 服务协议

最后更新时间:2024年3月3日

FastGPT 服务协议是您与珠海环界云计算有限公司(以下简称“我们”或“本公司”)之间就FastGPT云服务(以下简称“本服务”)的使用等相关事项所订立的协议。请您仔细阅读并充分理解本协议各条款,特别是免除或者限制我们责任的条款、对您权益的限制条款、争议解决和法律适用条款等。如您不同意本协议任一内容,请勿注册或使用本服务。

第1条 服务内容

第2条 用户注册与账户管理

第3条 使用规则

第4条 费用及支付

第5条 服务免责与责任限制

第6条 知识产权

第7条 其他条款

加入 FastGPT 开发者社区和我们一起成长

FastGPT 是一个由用户和贡献者参与推动的开源项目,如果您对产品使用存在疑问和建议,可尝试以下方式寻求支持。我们的团队与社区会竭尽所能为您提供帮助。

📱 扫码加入社区微信交流群👇

🐞 请将任何 FastGPT 的 Bug、问题和需求提交到 GitHub Issue。

FastGPT 配置参数介绍

由于环境变量不利于配置复杂的内容,新版 FastGPT 采用了 ConfigMap 的形式挂载配置文件,你可以在 projects/app/data/config.json 看到默认的配置文件。可以参考 docker-compose 快速部署 来挂载配置文件。

开发环境下,你需要将示例配置文件 config.json 复制成 config.local.json 文件才会生效。

这个配置文件中包含了系统参数和各个模型配置:

+ {

+ "feConfigs": {

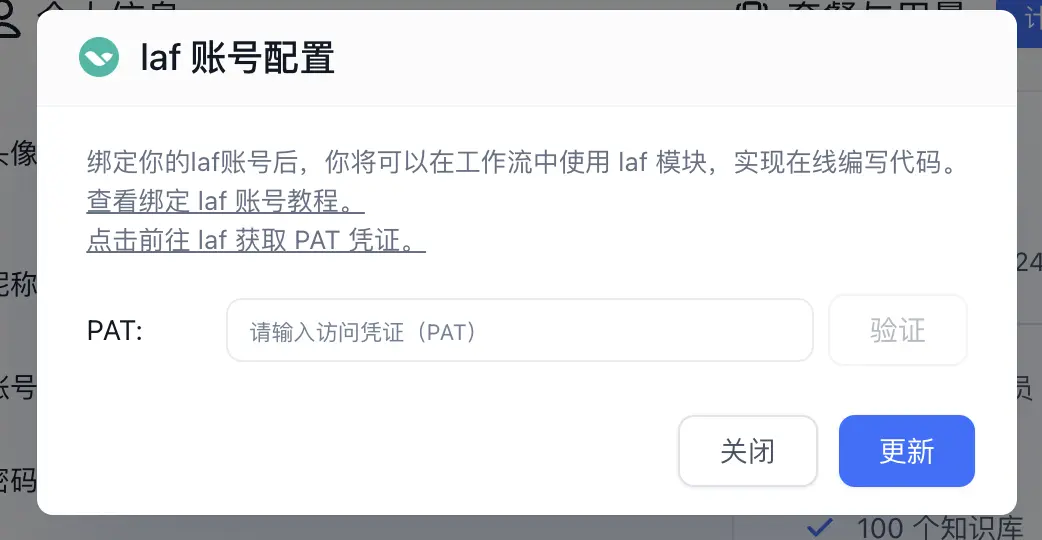

+ "lafEnv": "https://laf.dev" // laf环境。 https://laf.run (杭州阿里云) ,或者私有化的laf环境。如果使用 Laf openapi 功能,需要最新版的 laf 。

+ },

+ "systemEnv": {

+ "vectorMaxProcess": 15, // 向量处理线程数量

+ "qaMaxProcess": 15, // 问答拆分线程数量

+ "tokenWorkers": 50, // Token 计算线程保持数,会持续占用内存,不能设置太大。

+ "pgHNSWEfSearch": 100 // 向量搜索参数。越大,搜索越精确,但是速度越慢。设置为100,有99%+精度。

+ },

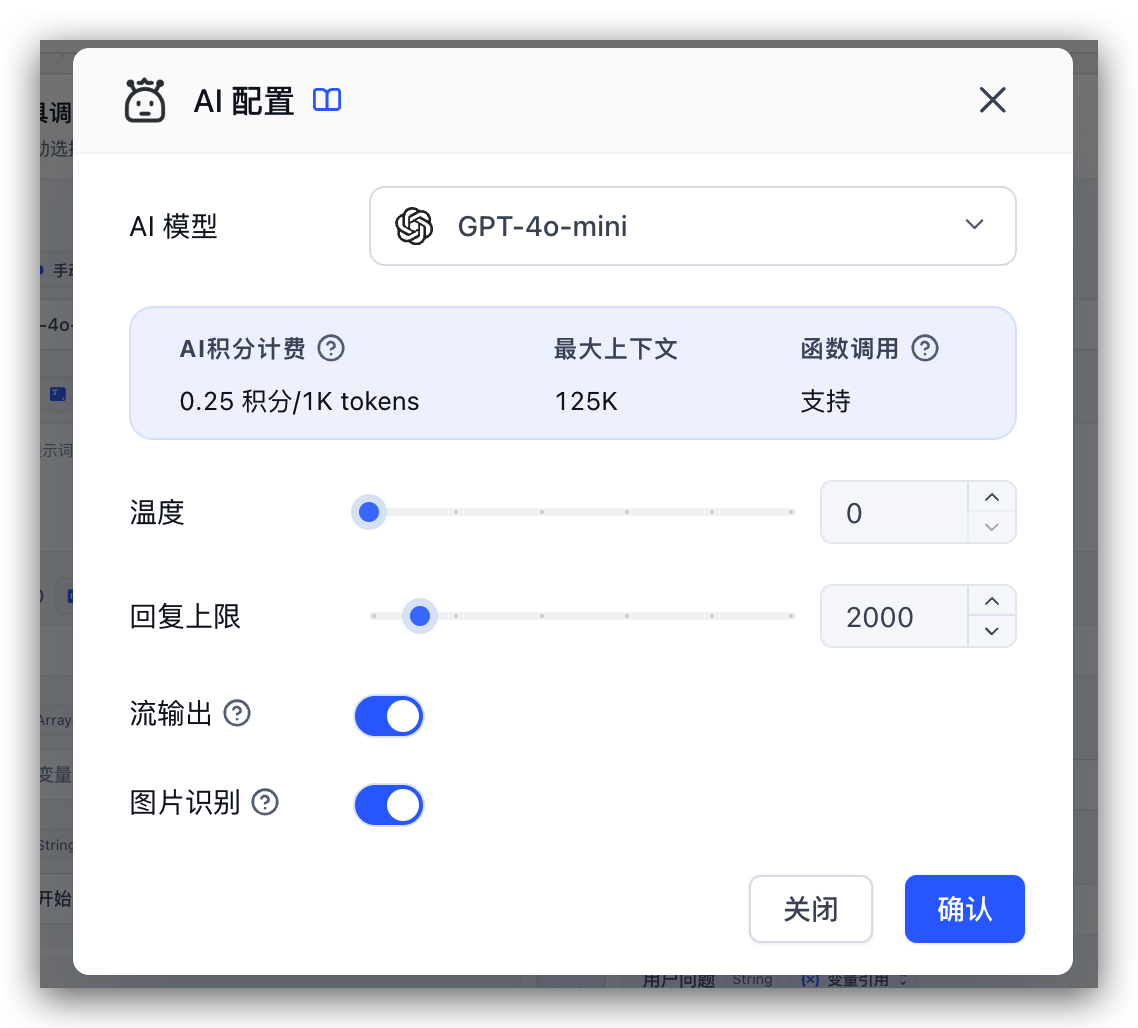

+ "llmModels": [

+ {

+ "provider": "OpenAI", // 模型提供商,主要用于分类展示,目前已经内置提供商包括:https://github.com/labring/FastGPT/blob/main/packages/global/core/ai/provider.ts, 可 pr 提供新的提供商,或直接填写 Other

+ "model": "gpt-4o-mini", // 模型名(对应OneAPI中渠道的模型名)

+ "name": "gpt-4o-mini", // 模型别名

+ "maxContext": 125000, // 最大上下文

+ "maxResponse": 16000, // 最大回复

+ "quoteMaxToken": 120000, // 最大引用内容

+ "maxTemperature": 1.2, // 最大温度

+ "charsPointsPrice": 0, // n积分/1k token(商业版)

+ "censor": false, // 是否开启敏感校验(商业版)

+ "vision": true, // 是否支持图片输入

+ "datasetProcess": true, // 是否设置为文本理解模型(QA),务必保证至少有一个为true,否则知识库会报错

+ "usedInClassify": true, // 是否用于问题分类(务必保证至少有一个为true)

+ "usedInExtractFields": true, // 是否用于内容提取(务必保证至少有一个为true)

+ "usedInToolCall": true, // 是否用于工具调用(务必保证至少有一个为true)

+ "usedInQueryExtension": true, // 是否用于问题优化(务必保证至少有一个为true)

+ "toolChoice": true, // 是否支持工具选择(分类,内容提取,工具调用会用到。)

+ "functionCall": false, // 是否支持函数调用(分类,内容提取,工具调用会用到。会优先使用 toolChoice,如果为false,则使用 functionCall,如果仍为 false,则使用提示词模式)

+ "customCQPrompt": "", // 自定义文本分类提示词(不支持工具和函数调用的模型

+ "customExtractPrompt": "", // 自定义内容提取提示词

+ "defaultSystemChatPrompt": "", // 对话默认携带的系统提示词

+ "defaultConfig": {}, // 请求API时,挟带一些默认配置(比如 GLM4 的 top_p)

+ "fieldMap": {} // 字段映射(o1 模型需要把 max_tokens 映射为 max_completion_tokens)

+ },

+ {

+ "provider": "OpenAI",

+ "model": "gpt-4o",

+ "name": "gpt-4o",

+ "maxContext": 125000,

+ "maxResponse": 4000,

+ "quoteMaxToken": 120000,

+ "maxTemperature": 1.2,

+ "charsPointsPrice": 0,

+ "censor": false,

+ "vision": true,

+ "datasetProcess": true,

+ "usedInClassify": true,

+ "usedInExtractFields": true,

+ "usedInToolCall": true,

+ "usedInQueryExtension": true,

+ "toolChoice": true,

+ "functionCall": false,

+ "customCQPrompt": "",

+ "customExtractPrompt": "",

+ "defaultSystemChatPrompt": "",

+ "defaultConfig": {},

+ "fieldMap": {}

+ },

+ {

+ "provider": "OpenAI",

+ "model": "o1-mini",

+ "name": "o1-mini",

+ "maxContext": 125000,

+ "maxResponse": 65000,

+ "quoteMaxToken": 120000,

+ "maxTemperature": 1.2,

+ "charsPointsPrice": 0,

+ "censor": false,

+ "vision": false,

+ "datasetProcess": true,

+ "usedInClassify": true,

+ "usedInExtractFields": true,

+ "usedInToolCall": true,

+ "usedInQueryExtension": true,

+ "toolChoice": false,

+ "functionCall": false,

+ "customCQPrompt": "",

+ "customExtractPrompt": "",

+ "defaultSystemChatPrompt": "",

+ "defaultConfig": {

+ "temperature": 1,

+ "max_tokens": null,

+ "stream": false

+ }

+ },

+ {

+ "provider": "OpenAI",

+ "model": "o1-preview",

+ "name": "o1-preview",

+ "maxContext": 125000,

+ "maxResponse": 32000,

+ "quoteMaxToken": 120000,

+ "maxTemperature": 1.2,

+ "charsPointsPrice": 0,

+ "censor": false,

+ "vision": false,

+ "datasetProcess": true,

+ "usedInClassify": true,

+ "usedInExtractFields": true,

+ "usedInToolCall": true,

+ "usedInQueryExtension": true,

+ "toolChoice": false,

+ "functionCall": false,

+ "customCQPrompt": "",

+ "customExtractPrompt": "",

+ "defaultSystemChatPrompt": "",

+ "defaultConfig": {

+ "temperature": 1,

+ "max_tokens": null,

+ "stream": false

+ }

+ }

+ ],

+ "vectorModels": [

+ {

+ "provider": "OpenAI",

+ "model": "text-embedding-3-small",

+ "name": "text-embedding-3-small",

+ "charsPointsPrice": 0,

+ "defaultToken": 512,

+ "maxToken": 3000,

+ "weight": 100

+ },

+ {

+ "provider": "OpenAI",

+ "model": "text-embedding-3-large",

+ "name": "text-embedding-3-large",

+ "charsPointsPrice": 0,

+ "defaultToken": 512,

+ "maxToken": 3000,

+ "weight": 100,

+ "defaultConfig": {

+ "dimensions": 1024

+ }

+ },

+ {

+ "provider": "OpenAI",

+ "model": "text-embedding-ada-002", // 模型名(与OneAPI对应)

+ "name": "Embedding-2", // 模型展示名

+ "charsPointsPrice": 0, // n积分/1k token

+ "defaultToken": 700, // 默认文本分割时候的 token

+ "maxToken": 3000, // 最大 token

+ "weight": 100, // 优先训练权重

+ "defaultConfig": {}, // 自定义额外参数。例如,如果希望使用 embedding3-large 的话,可以传入 dimensions:1024,来返回1024维度的向量。(目前必须小于1536维度)

+ "dbConfig": {}, // 存储时的额外参数(非对称向量模型时候需要用到)

+ "queryConfig": {} // 参训时的额外参数

+ }

+ ],

+ "reRankModels": [],

+ "audioSpeechModels": [

+ {

+ "provider": "OpenAI",

+ "model": "tts-1",

+ "name": "OpenAI TTS1",

+ "charsPointsPrice": 0,

+ "voices": [

+ { "label": "Alloy", "value": "alloy", "bufferId": "openai-Alloy" },

+ { "label": "Echo", "value": "echo", "bufferId": "openai-Echo" },

+ { "label": "Fable", "value": "fable", "bufferId": "openai-Fable" },

+ { "label": "Onyx", "value": "onyx", "bufferId": "openai-Onyx" },

+ { "label": "Nova", "value": "nova", "bufferId": "openai-Nova" },

+ { "label": "Shimmer", "value": "shimmer", "bufferId": "openai-Shimmer" }

+ ]

+ }

+ ],

+ "whisperModel": {

+ "provider": "OpenAI",

+ "model": "whisper-1",

+ "name": "Whisper1",

+ "charsPointsPrice": 0

+ }

+}

+ 为了方便模型分类展示,FastGPT 内置了部分模型提供商的名字和 Logo。如果你期望补充提供商,可提交 Issue,并提供几个信息:

目前已支持的提供商, 复制 “-” 之前的字符串,作为 provider 的值。

由于 OneAPI 不支持 Rerank 模型,所以需要单独配置接入,这里

有免费的 bge-reranker-v2-m3 模型可以使用。

+ {

+ "reRankModels": [

+ {

+ "model": "BAAI/bge-reranker-v2-m3", // 这里的model需要对应 siliconflow 的模型名

+ "name": "BAAI/bge-reranker-v2-m3",

+ "requestUrl": "https://api.siliconflow.cn/v1/rerank",

+ "requestAuth": "siliconflow 上申请的 key"

+ }

+ ]

+}

+ 请使用 4.6.6-alpha 以上版本,配置文件中的 reRankModels 为重排模型,虽然是数组,不过目前仅有第1个生效。

reRankModels, 4.6.6 以前是 ReRankModels。

+ {

+ "reRankModels": [

+ {

+ "model": "bge-reranker-base", // 随意

+ "name": "检索重排-base", // 随意

+ "charsPointsPrice": 0,

+ "requestUrl": "{{host}}/v1/rerank",

+ "requestAuth": "安全凭证,已自动补 Bearer"

+ }

+ ]

+}

+ 接入 bge-rerank 重排模型

推荐配置如下:

| 模型名 | 内存 | 显存 | 硬盘空间 | 启动命令 |

|---|---|---|---|---|

| bge-reranker-base | >=4GB | >=4GB | >=8GB | python app.py |

| bge-reranker-large | >=8GB | >=8GB | >=8GB | python app.py |

| bge-reranker-v2-m3 | >=8GB | >=8GB | >=8GB | python app.py |

3 个模型代码分别为:

+ pip install -r requirements.txt

+ 3个模型的 huggingface 仓库地址如下:

在对应代码目录下 clone 模型。目录结构:

+ bge-reranker-base/

+app.py

+Dockerfile

+requirements.txt

+

+ python app.py

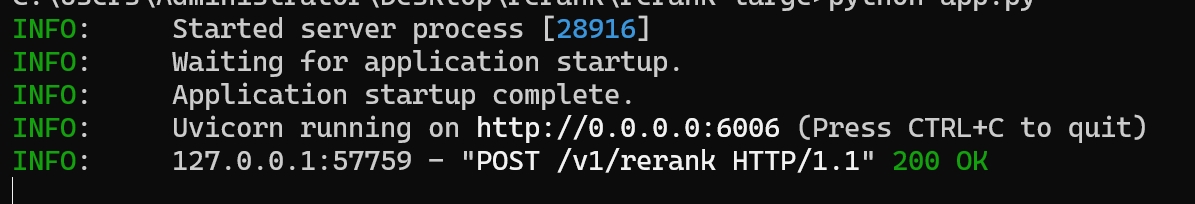

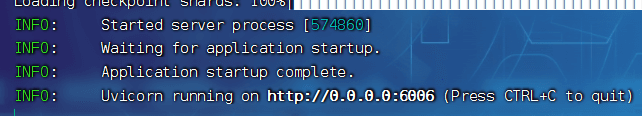

+ 启动成功后应该会显示如下地址:

这里的

http://0.0.0.0:6006就是连接地址。

镜像名分别为:

端口

6006

环境变量

+ ACCESS_TOKEN=访问安全凭证,请求时,Authorization: Bearer ${ACCESS_TOKEN}

+ 运行命令示例

+ # auth token 为mytoken

+docker run -d --name reranker -p 6006:6006 -e ACCESS_TOKEN=mytoken --gpus all registry.cn-hangzhou.aliyuncs.com/fastgpt/bge-rerank-base:v0.1

+ docker-compose.yml示例

+ version: "3"

+services:

+ reranker:

+ image: registry.cn-hangzhou.aliyuncs.com/fastgpt/bge-rerank-base:v0.1

+ container_name: reranker

+ # GPU运行环境,如果宿主机未安装,将deploy配置隐藏即可

+ deploy:

+ resources:

+ reservations:

+ devices:

+ - driver: nvidia

+ count: all

+ capabilities: [gpu]

+ ports:

+ - 6006:6006

+ environment:

+ - ACCESS_TOKEN=mytoken

+ 参考 ReRank模型接入,host 变量为部署的域名。

Bus error (core dumped) 尝试增加 docker-compose.yml 配置项 shm_size ,以增加容器中的共享内存目录大小。

+ ...

+services:

+ reranker:

+ ...

+ container_name: reranker

+ shm_size: '2gb'

+ ...

+ 将 FastGPT 接入私有化模型 ChatGLM2和m3e-large

FastGPT 默认使用了 OpenAI 的 LLM 模型和向量模型,如果想要私有化部署的话,可以使用 ChatGLM2 和 m3e-large 模型。以下是由用户@不做了睡大觉 提供的接入方法。该镜像直接集成了 M3E-Large 和 ChatGLM2-6B 模型,可以直接使用。

stawky/chatglm2-m3e:latestregistry.cn-hangzhou.aliyuncs.com/fastgpt_docker/chatglm2-m3e:latest

+ # 设置安全凭证(即oneapi中的渠道密钥)

+默认值:sk-aaabbbcccdddeeefffggghhhiiijjjkkk

+也可以通过环境变量引入:sk-key。有关docker环境变量引入的方法请自寻教程,此处不再赘述。

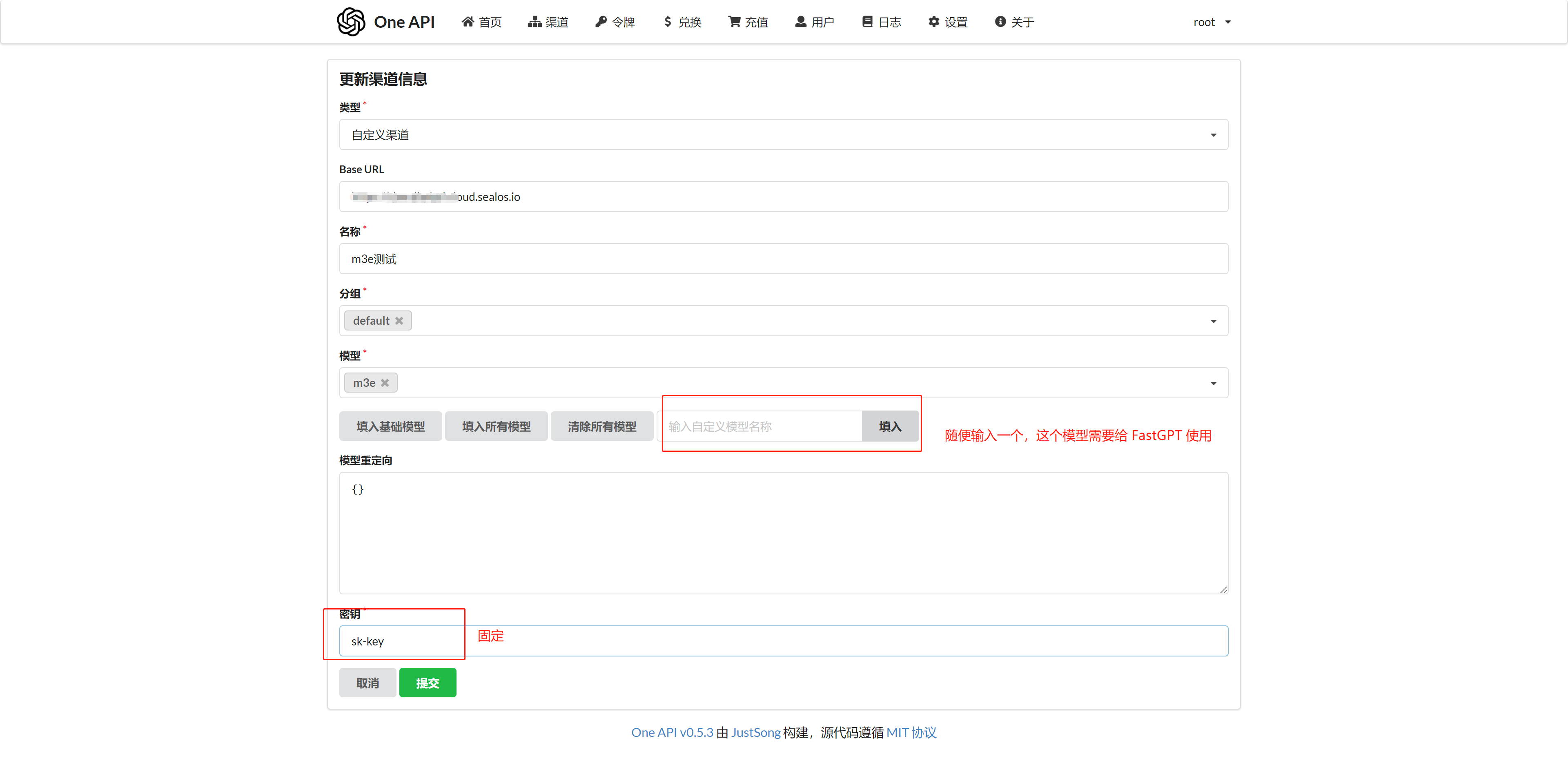

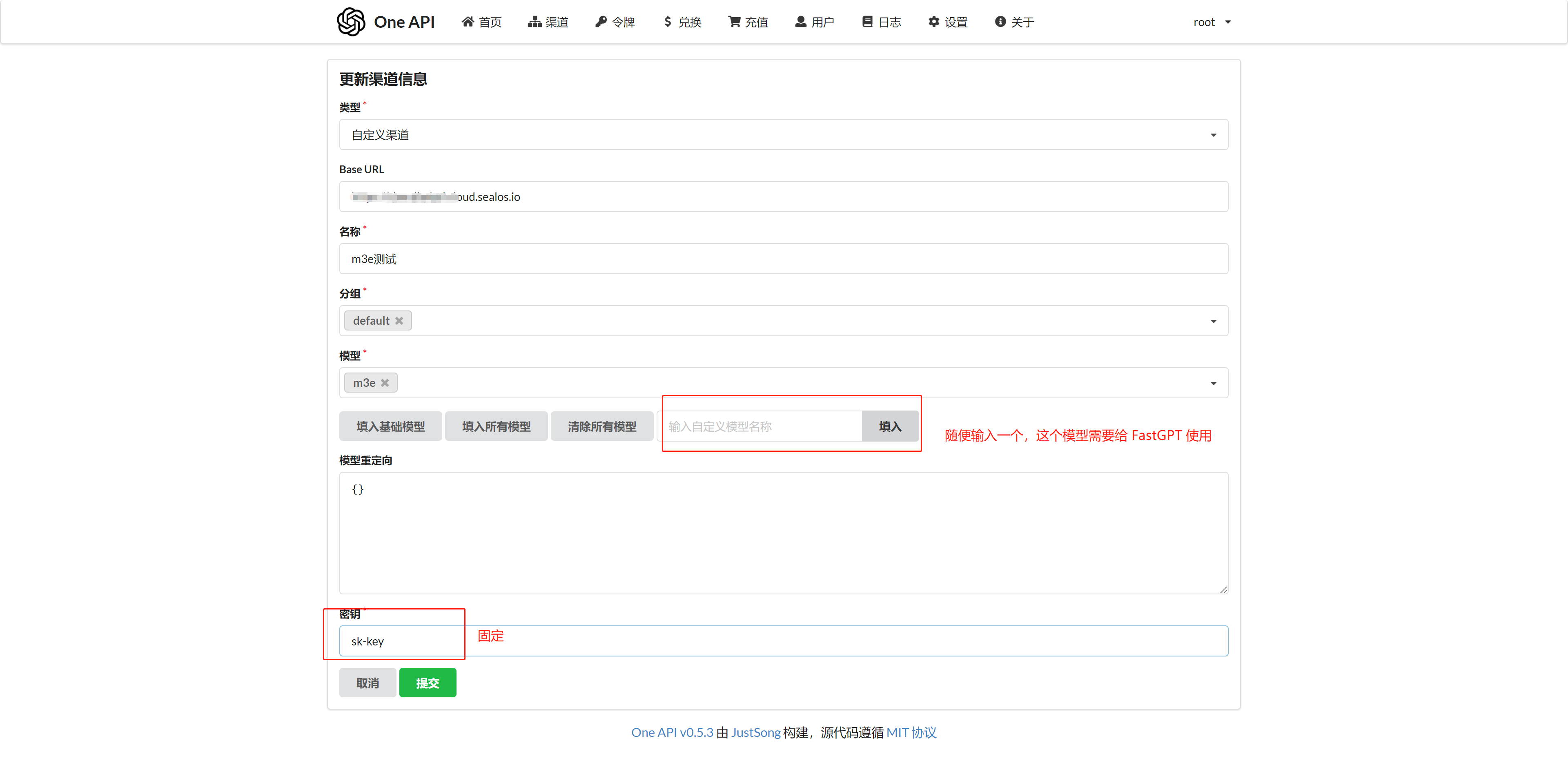

+ 为 chatglm2 和 m3e-large 各添加一个渠道,参数如下:

这里我填入 m3e 作为向量模型,chatglm2 作为语言模型

curl 例子:

+ curl --location --request POST 'https://domain/v1/embeddings' \

+--header 'Authorization: Bearer sk-aaabbbcccdddeeefffggghhhiiijjjkkk' \

+--header 'Content-Type: application/json' \

+--data-raw '{

+ "model": "m3e",

+ "input": ["laf是什么"]

+}'

+

+ curl --location --request POST 'https://domain/v1/chat/completions' \

+--header 'Authorization: Bearer sk-aaabbbcccdddeeefffggghhhiiijjjkkk' \

+--header 'Content-Type: application/json' \

+--data-raw '{

+ "model": "chatglm2",

+ "messages": [{"role": "user", "content": "Hello!"}]

+}'

+ Authorization 为 sk-aaabbbcccdddeeefffggghhhiiijjjkkk。model 为刚刚在 One API 填写的自定义模型。

修改 config.json 配置文件,在 llmModels 中加入 chatglm2, 在 vectorModels 中加入 M3E 模型:

+ "llmModels": [

+ //其他对话模型

+ {

+ "model": "chatglm2",

+ "name": "chatglm2",

+ "maxToken": 8000,

+ "price": 0,

+ "quoteMaxToken": 4000,

+ "maxTemperature": 1.2,

+ "defaultSystemChatPrompt": ""

+ }

+],

+"vectorModels": [

+ {

+ "model": "text-embedding-ada-002",

+ "name": "Embedding-2",

+ "price": 0.2,

+ "defaultToken": 500,

+ "maxToken": 3000

+ },

+ {

+ "model": "m3e",

+ "name": "M3E(测试使用)",

+ "price": 0.1,

+ "defaultToken": 500,

+ "maxToken": 1800

+ }

+],

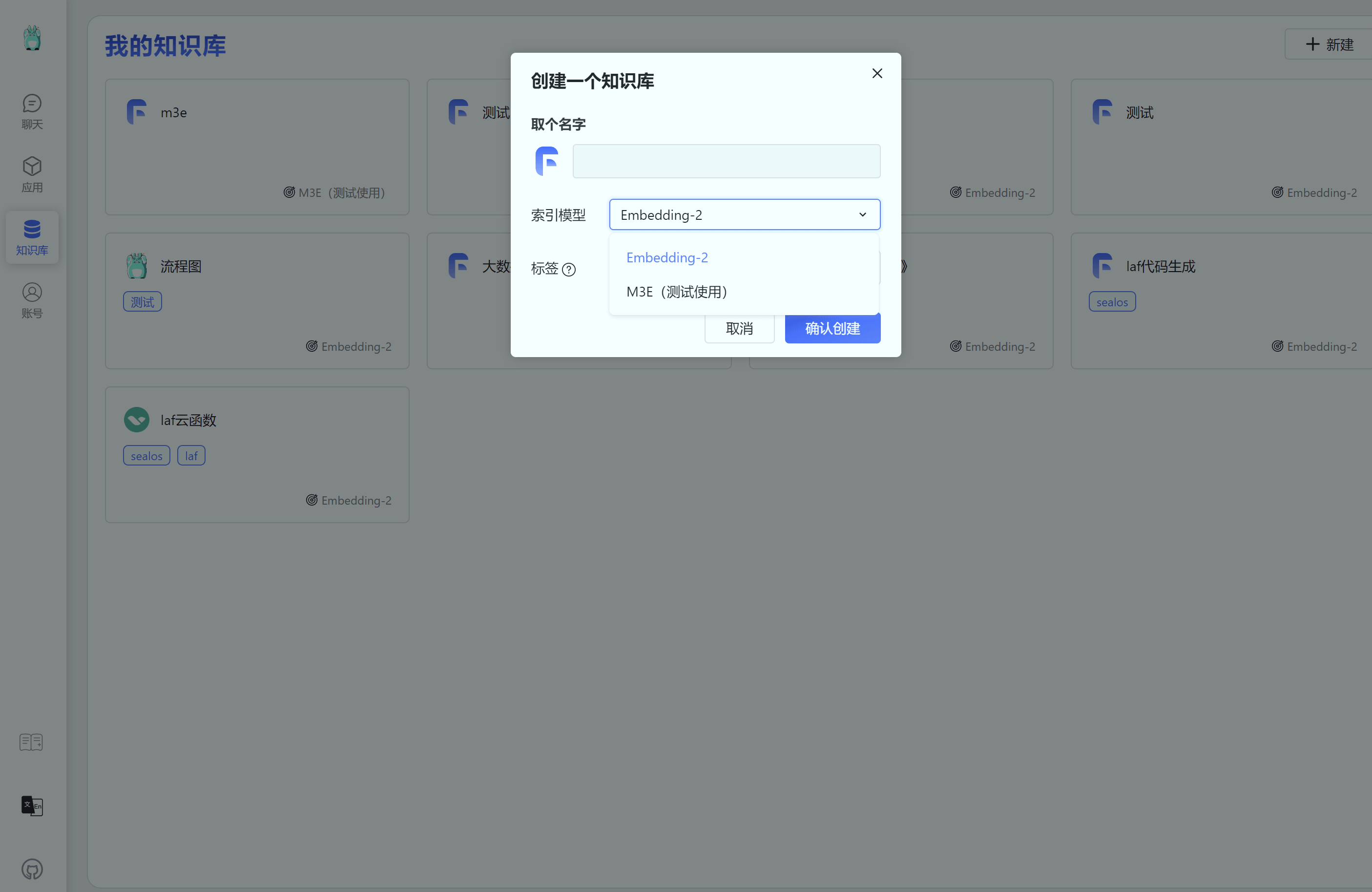

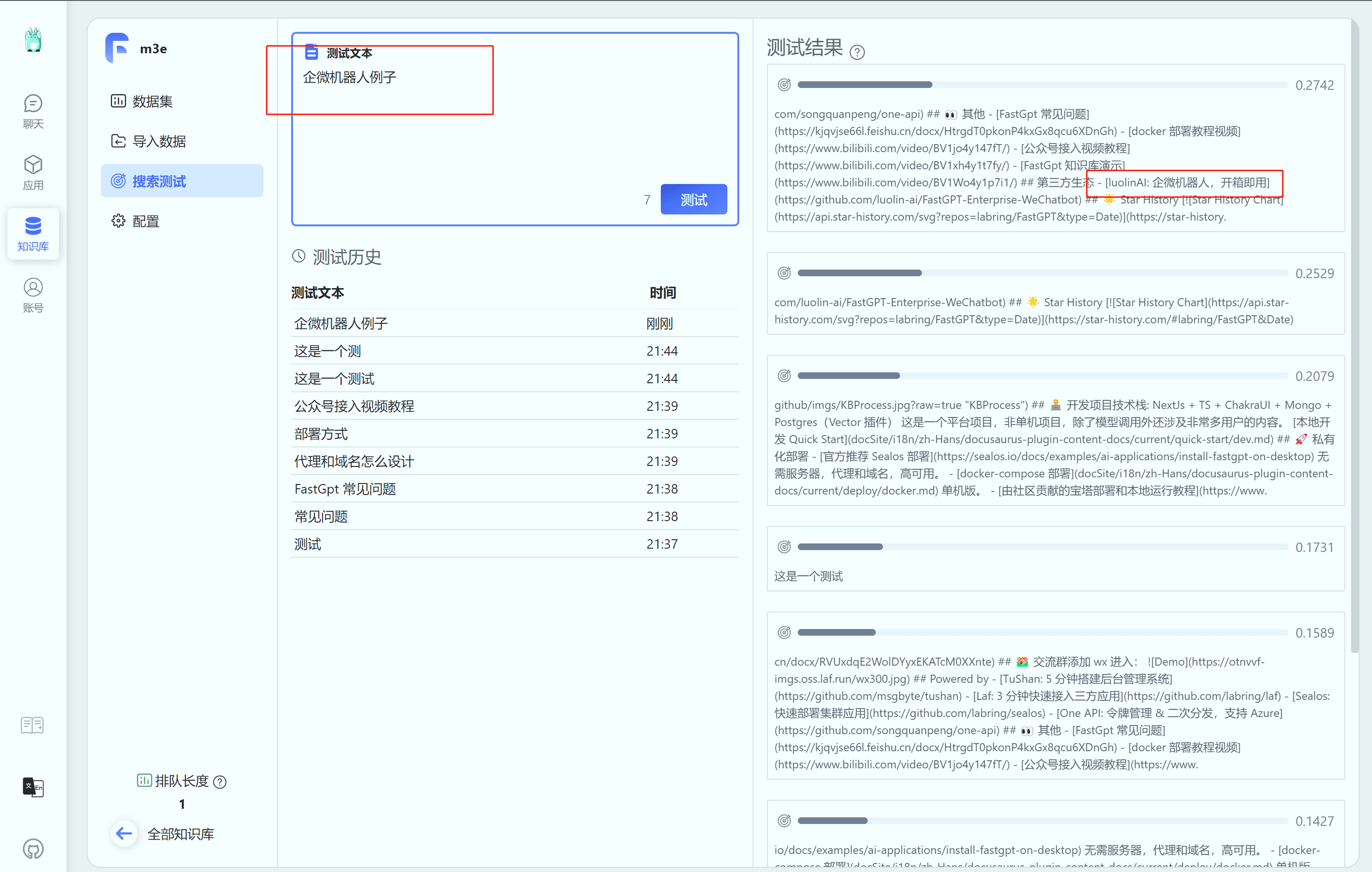

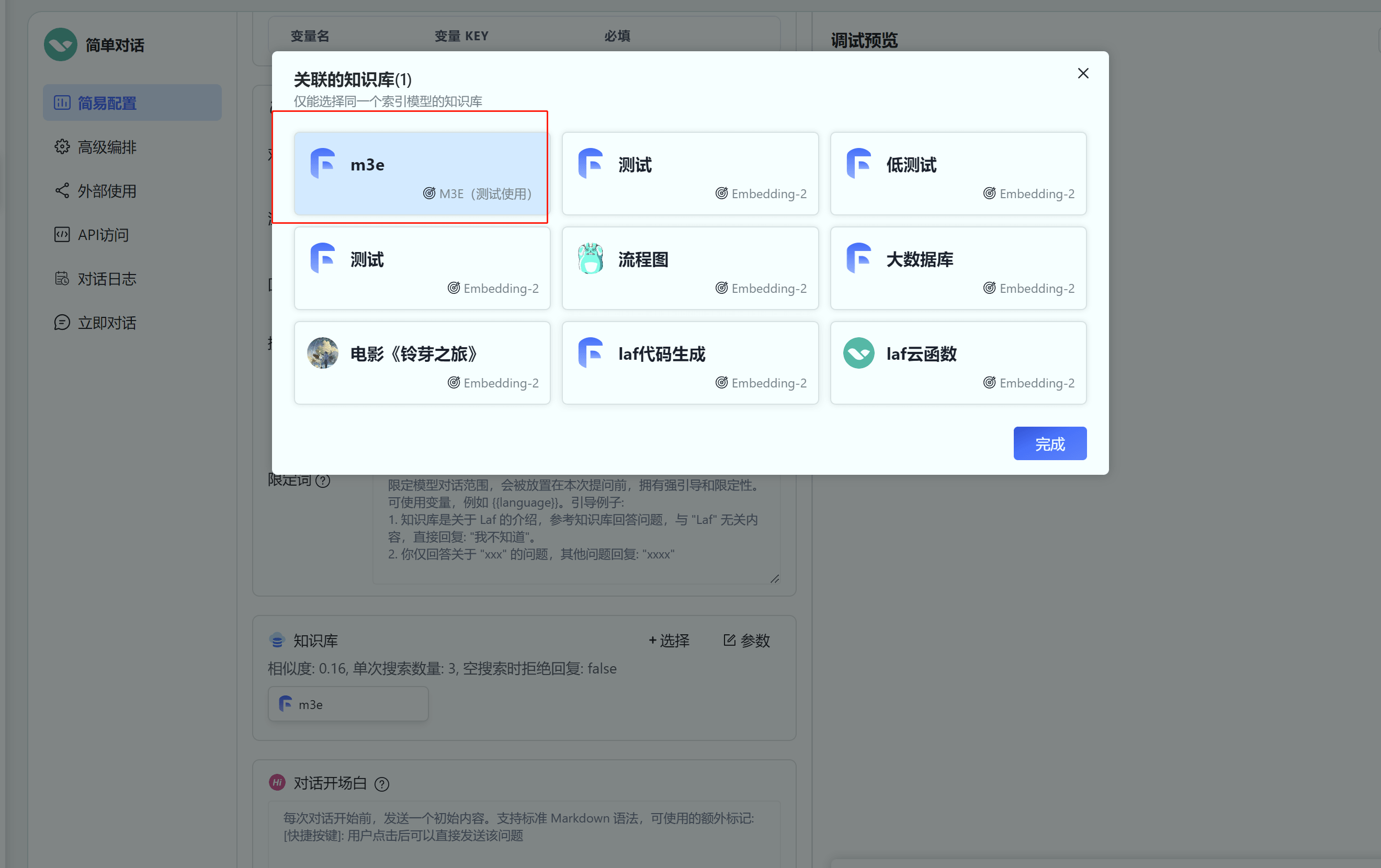

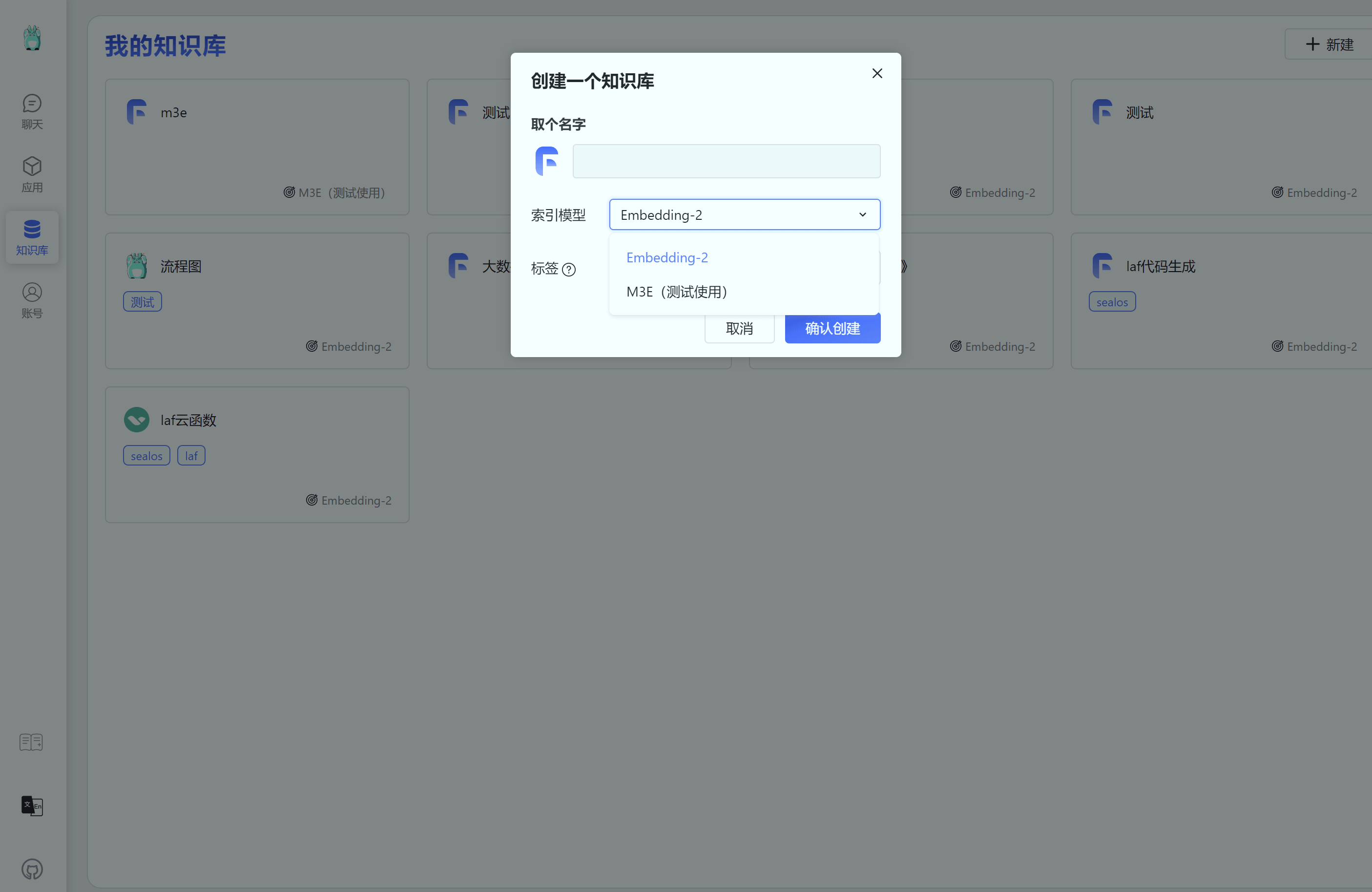

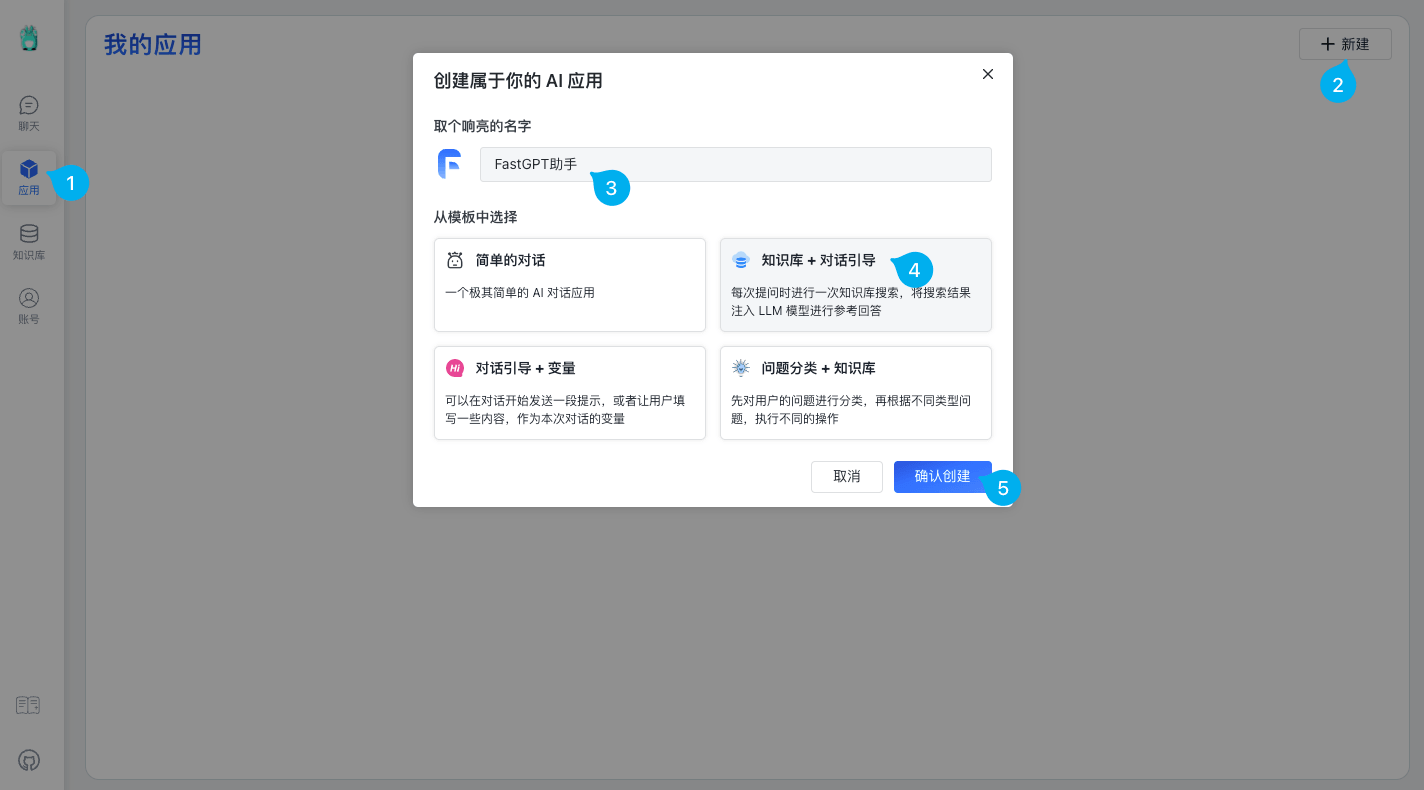

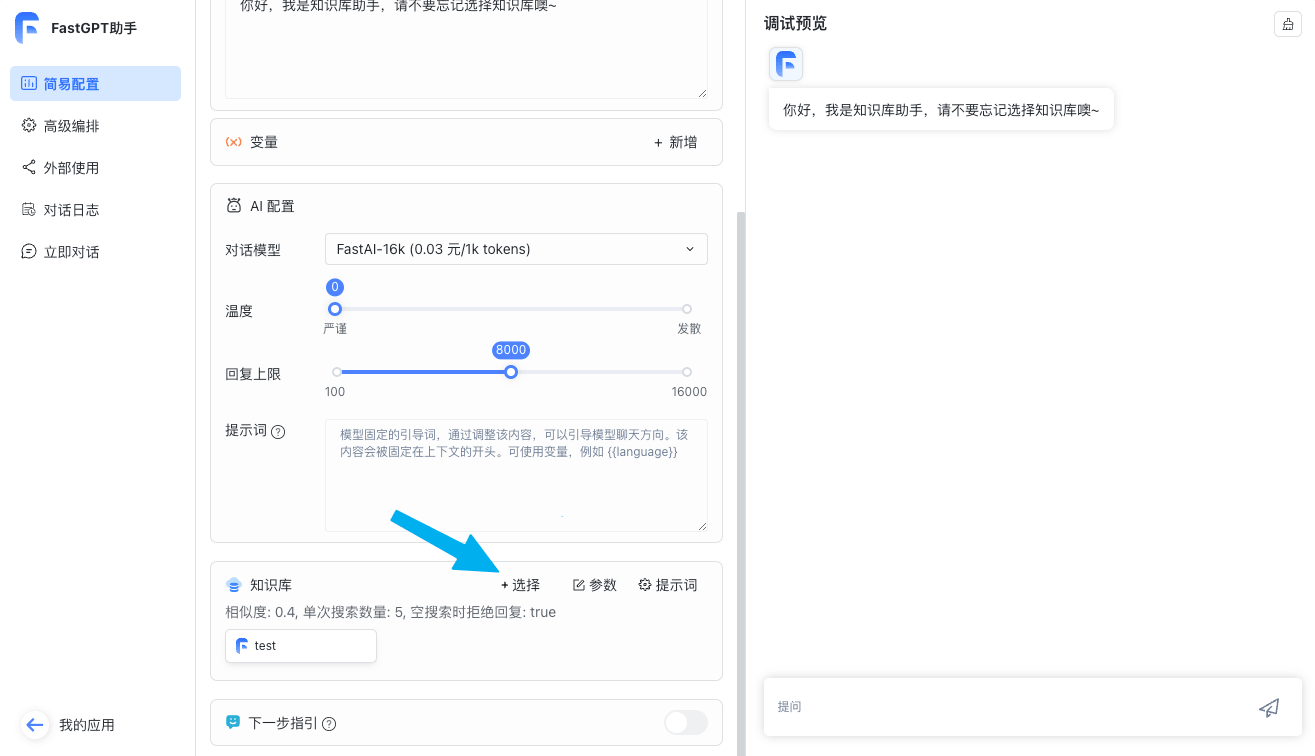

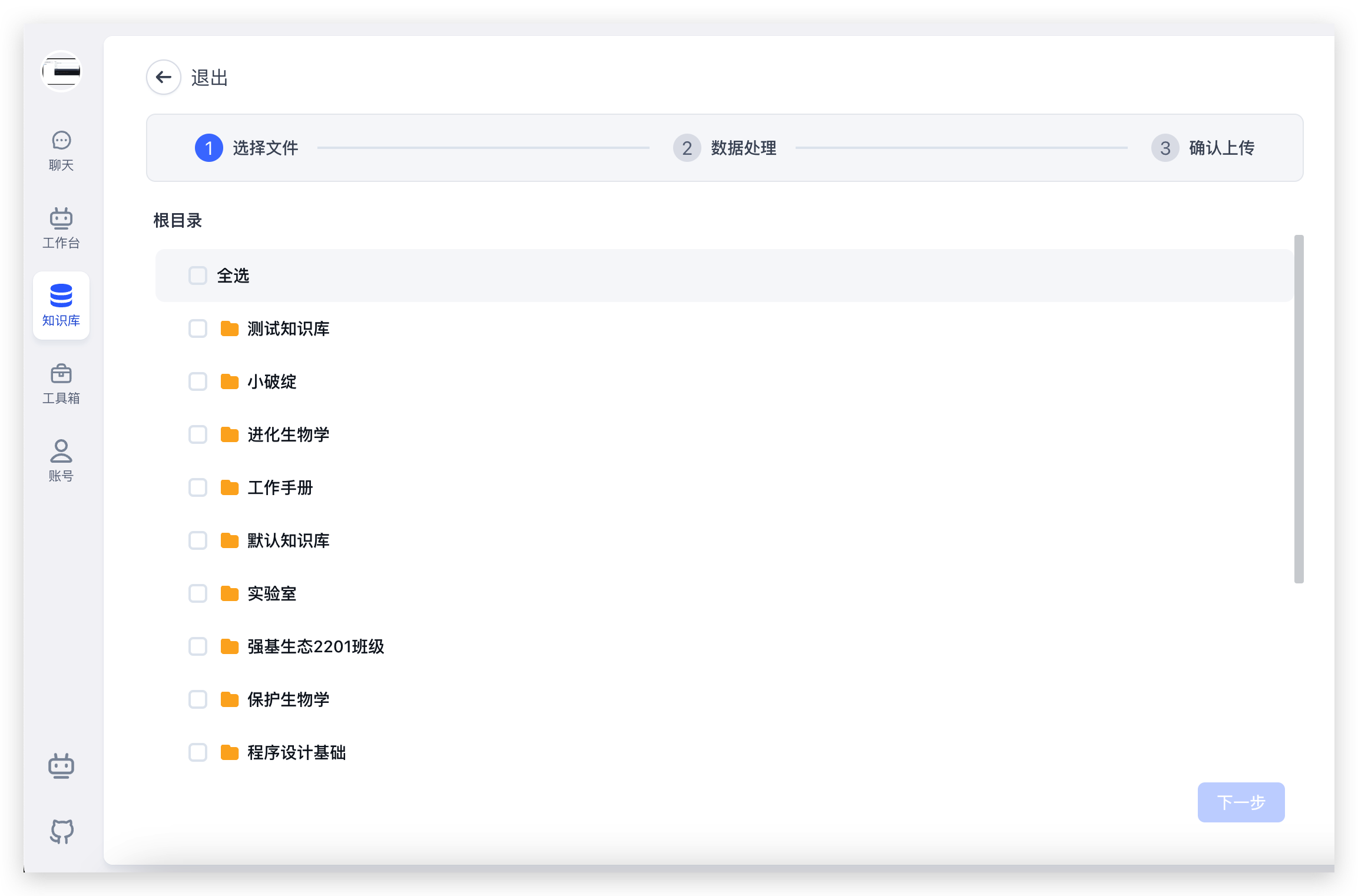

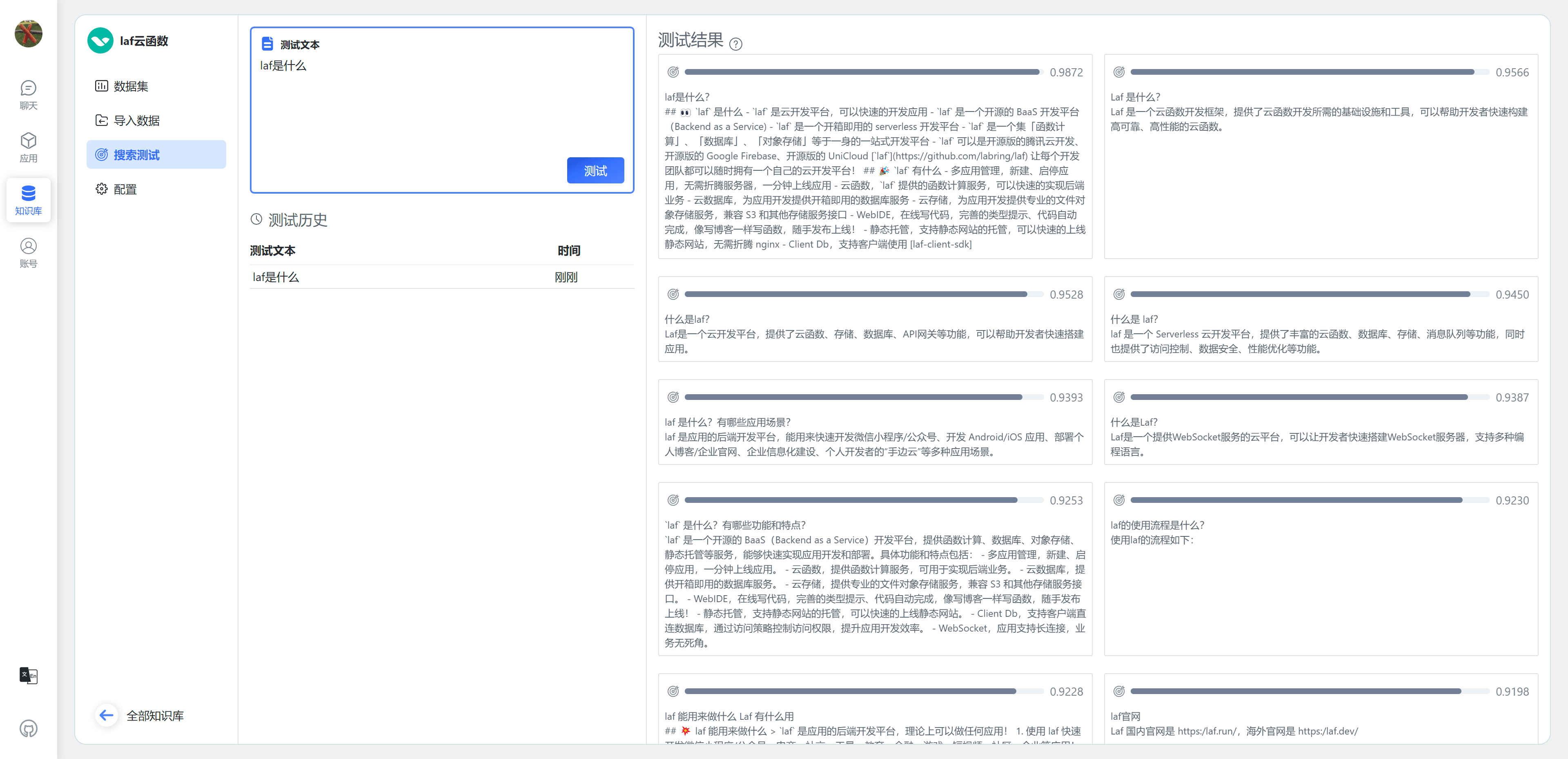

+ M3E 模型的使用方法如下:

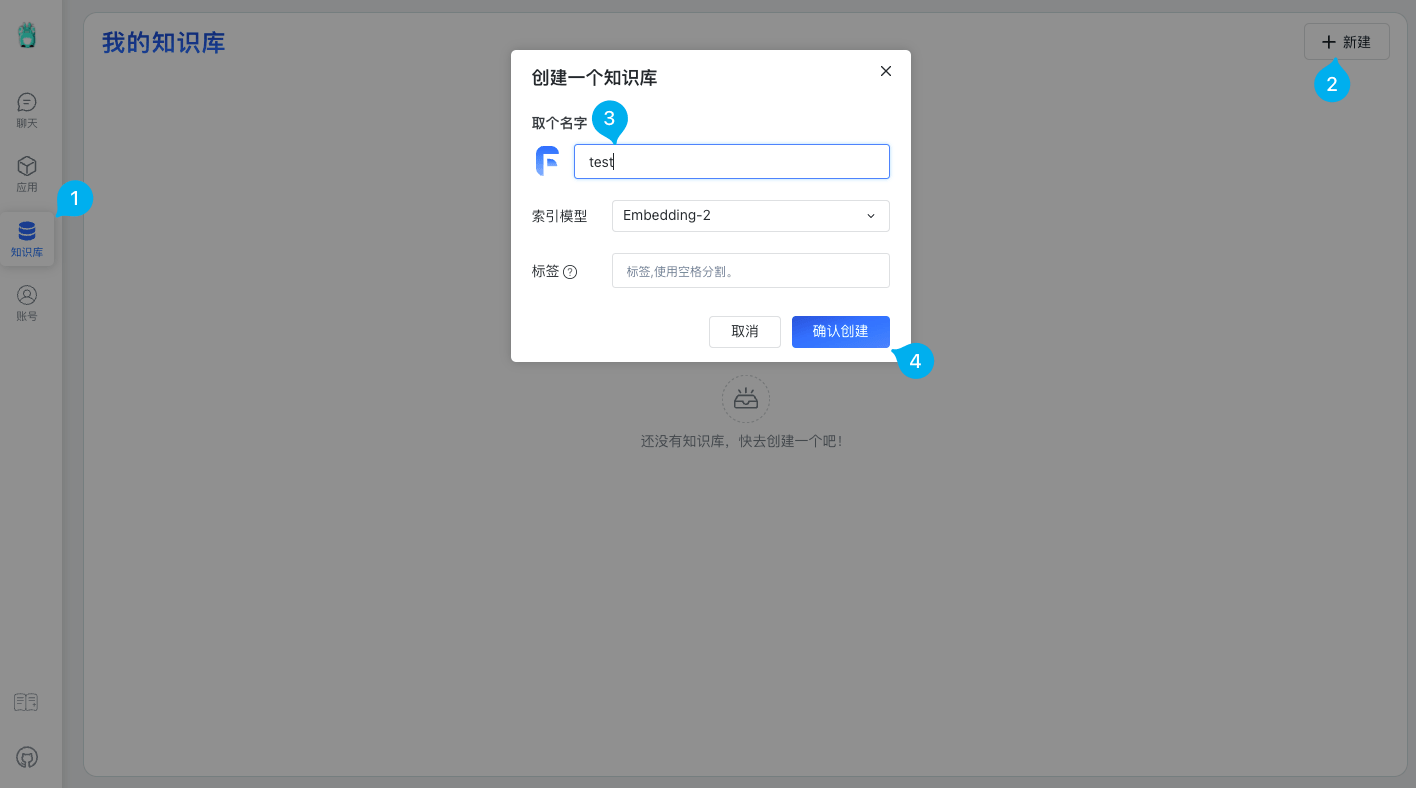

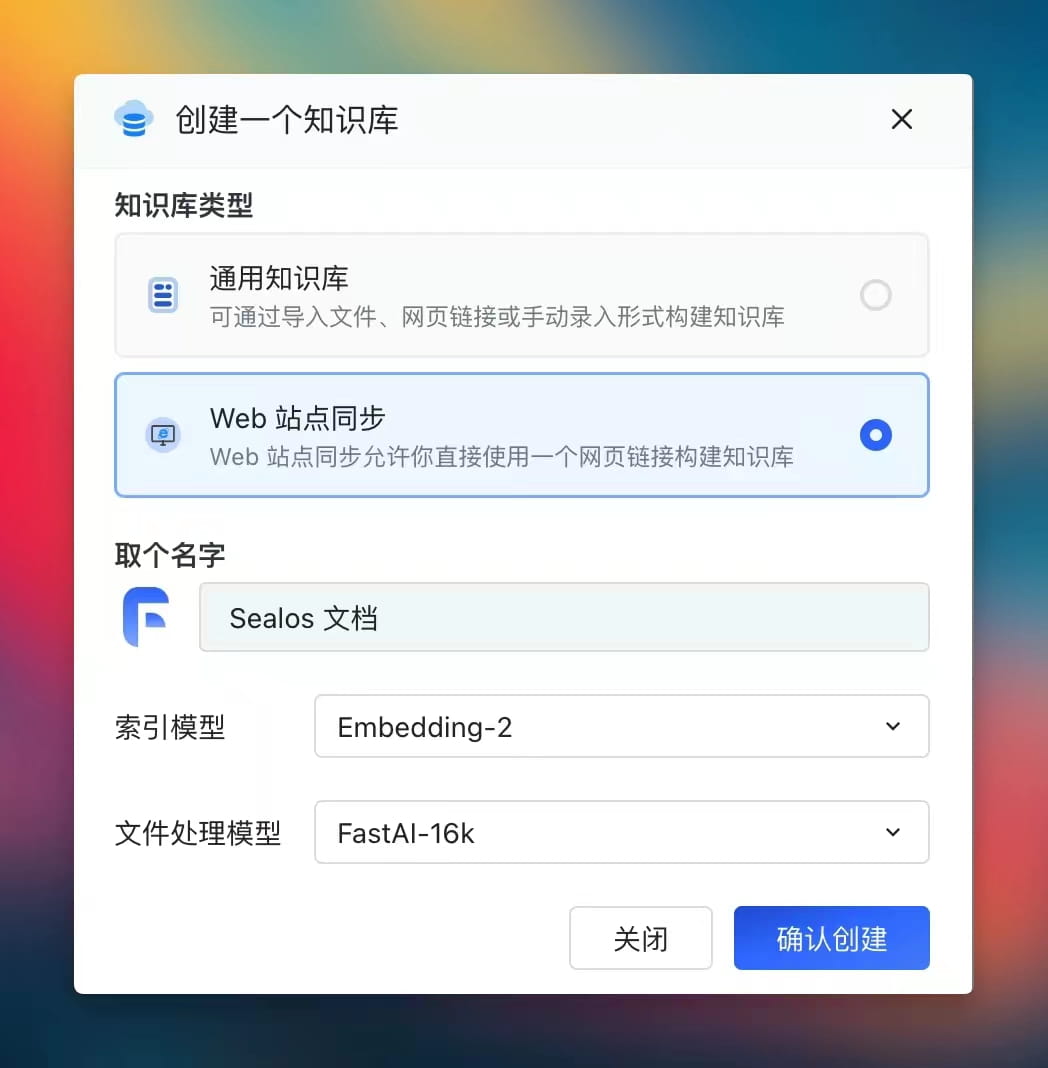

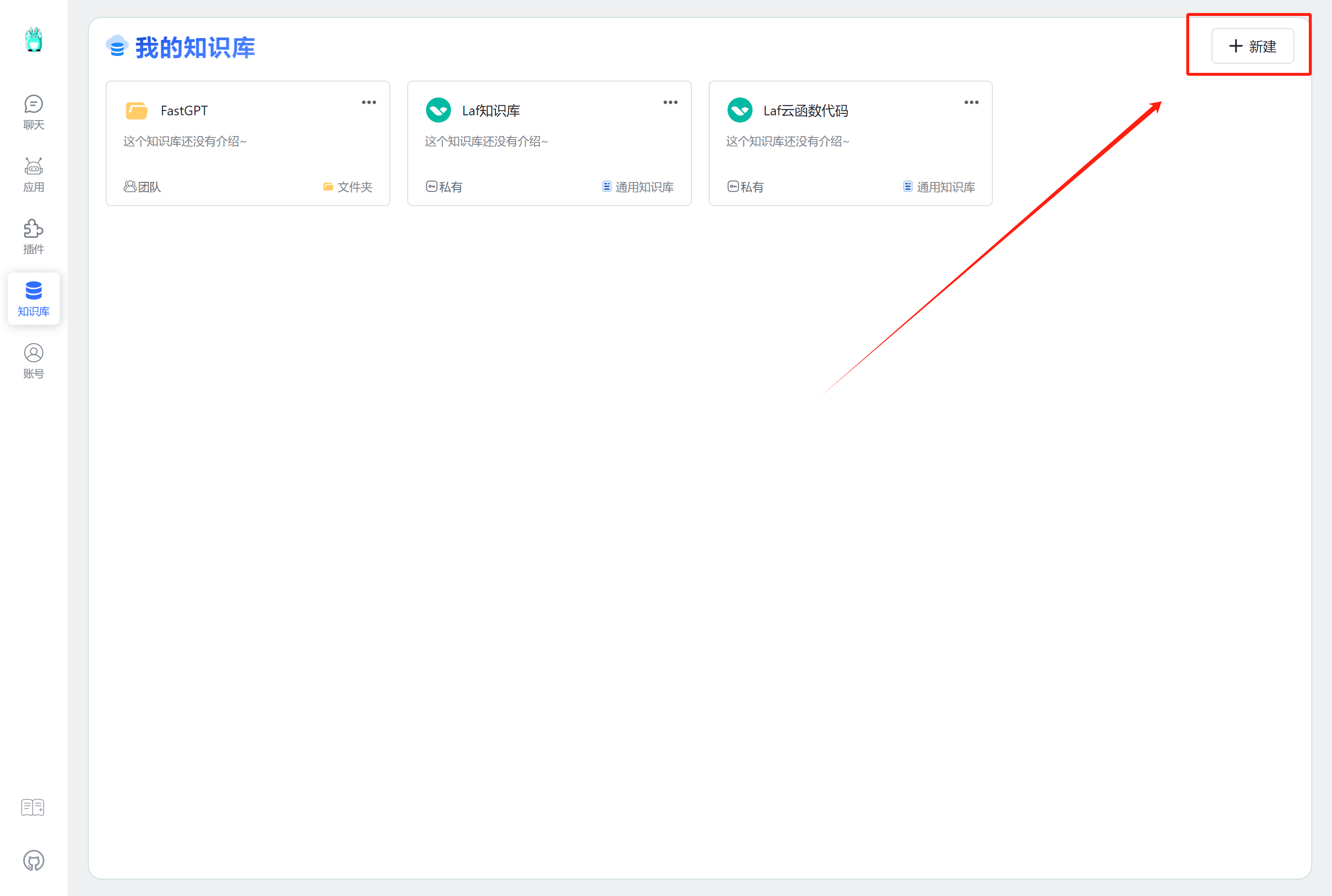

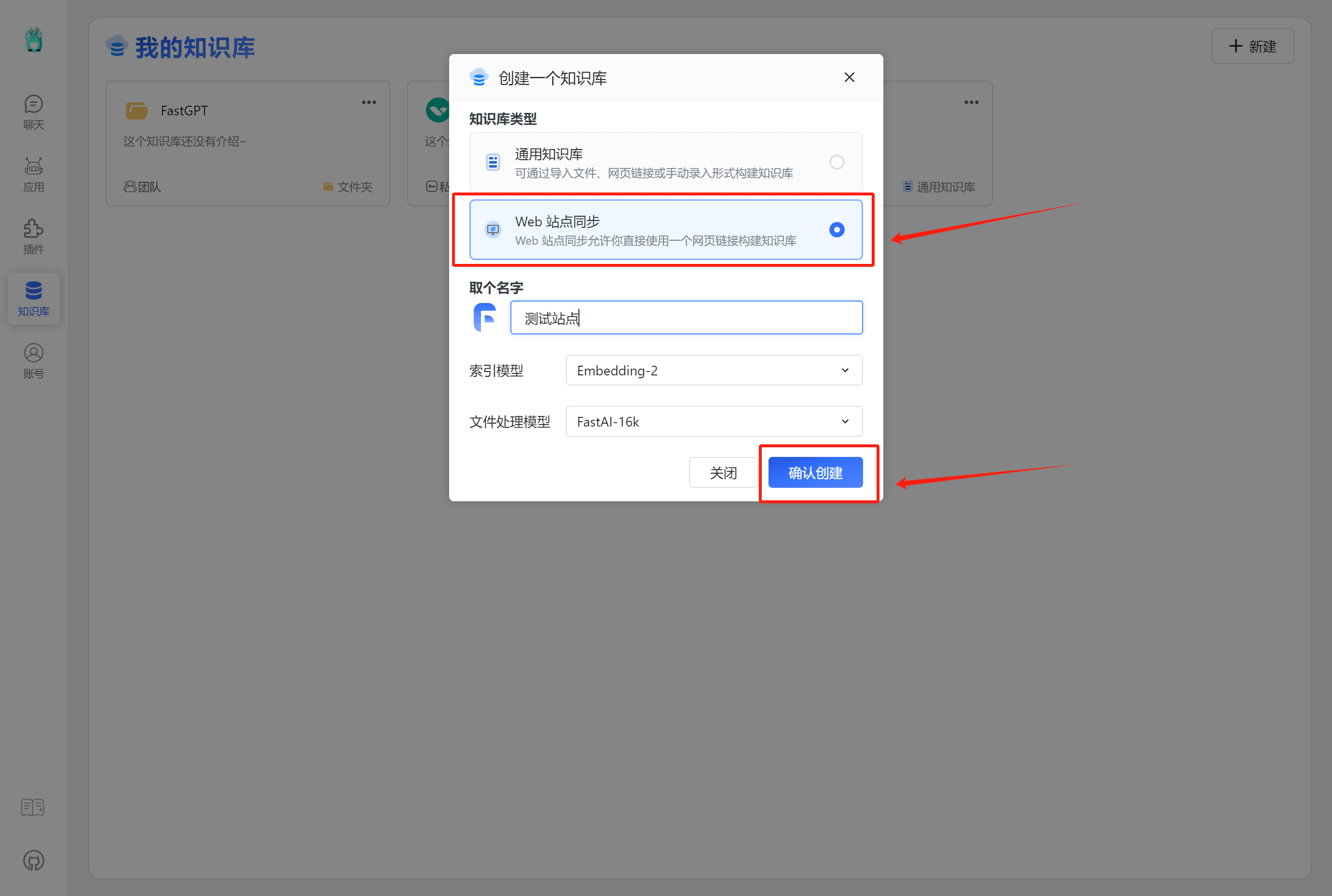

创建知识库时候选择 M3E 模型。

注意,一旦选择后,知识库将无法修改向量模型。

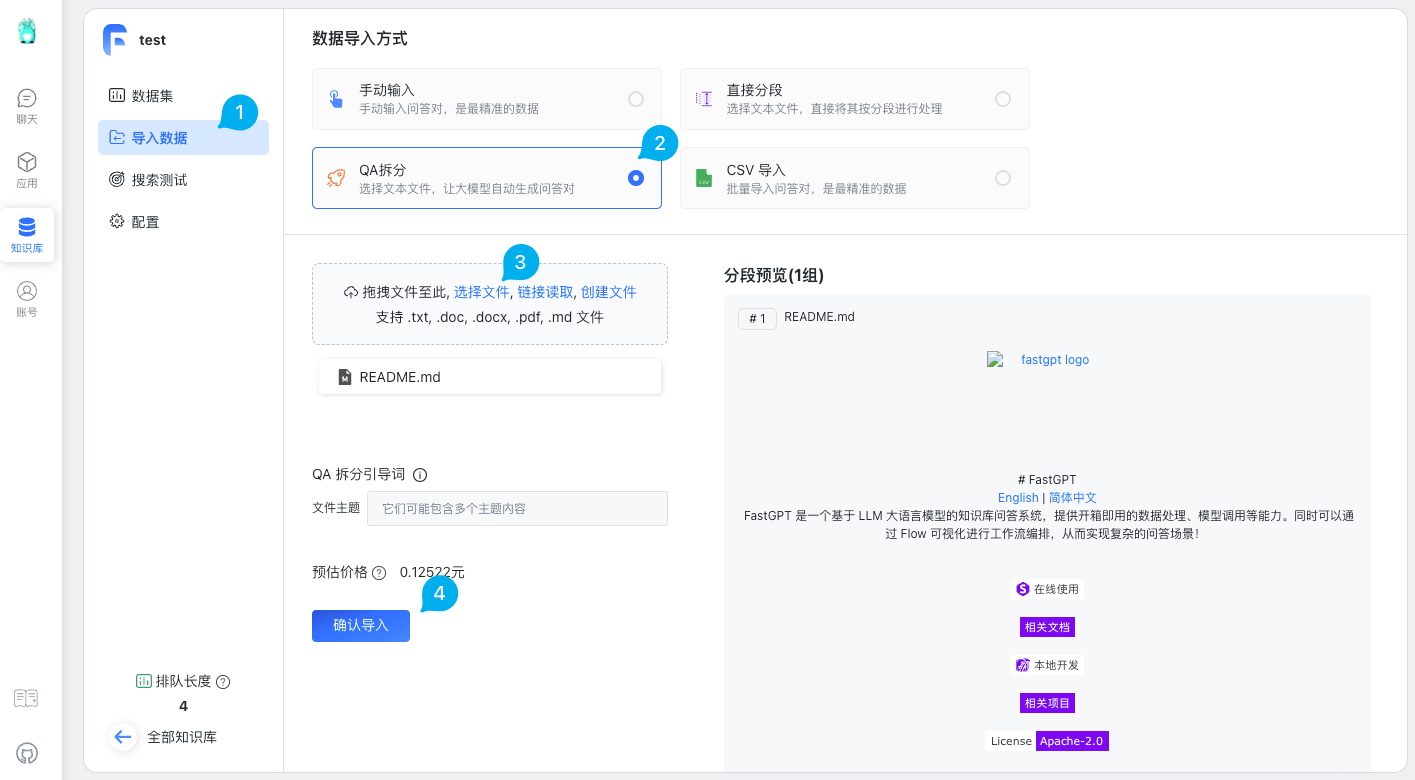

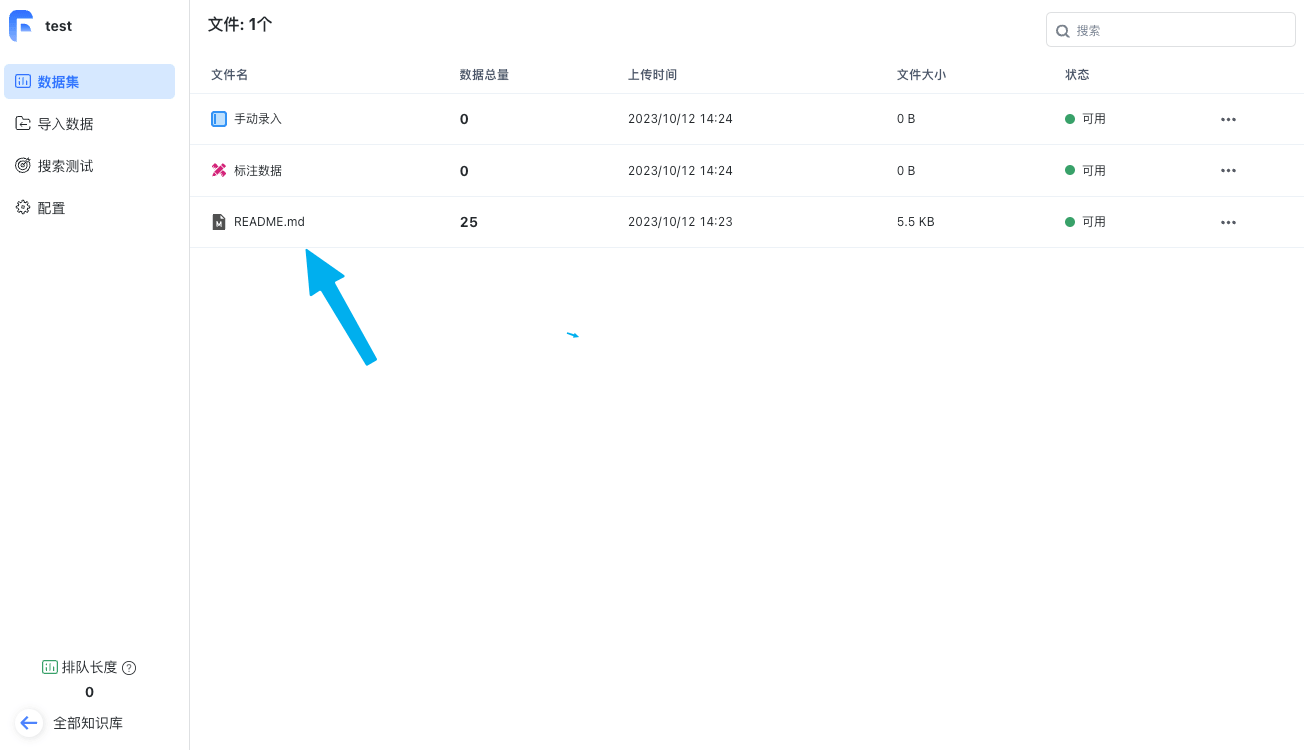

导入数据

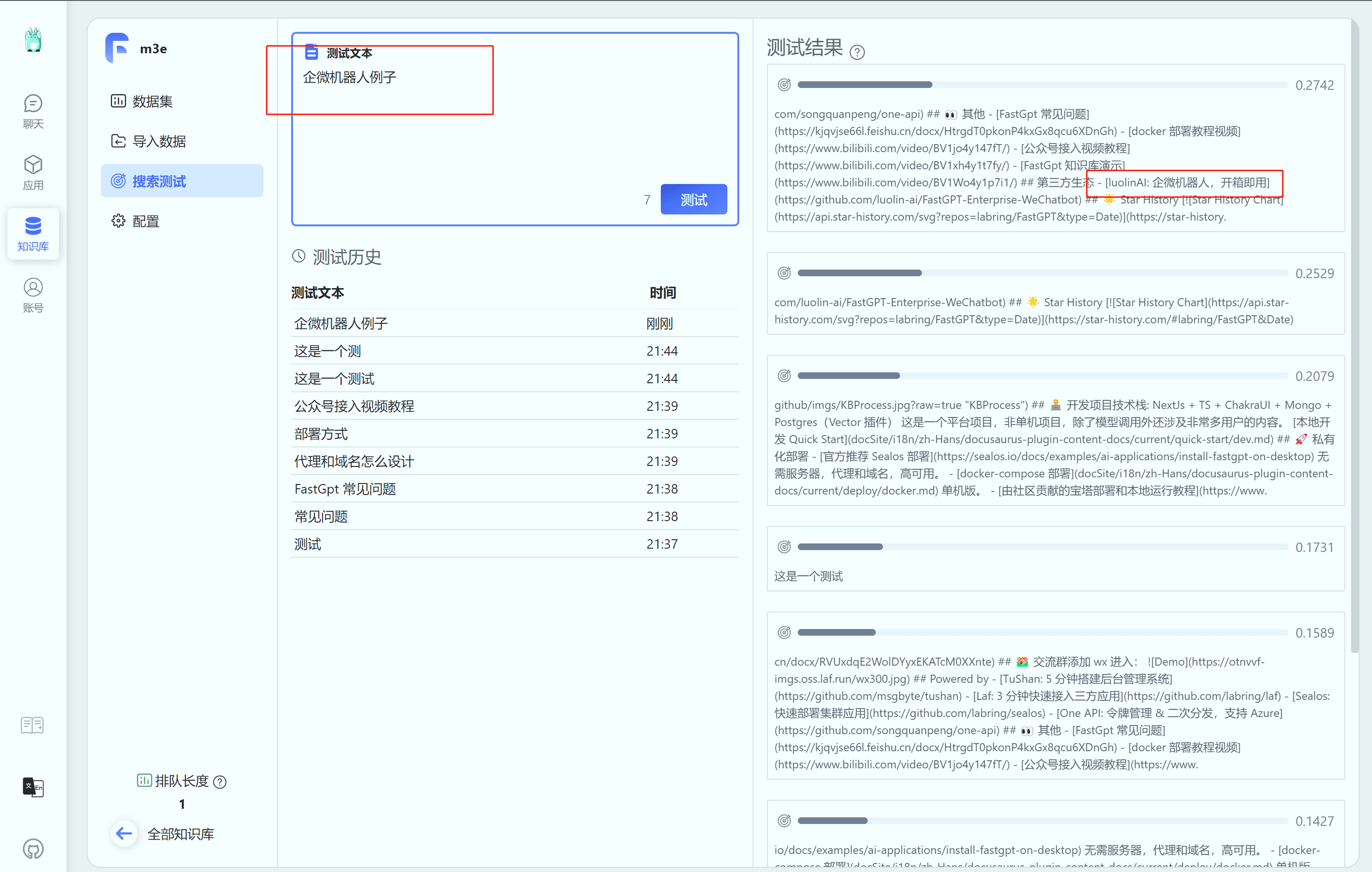

搜索测试

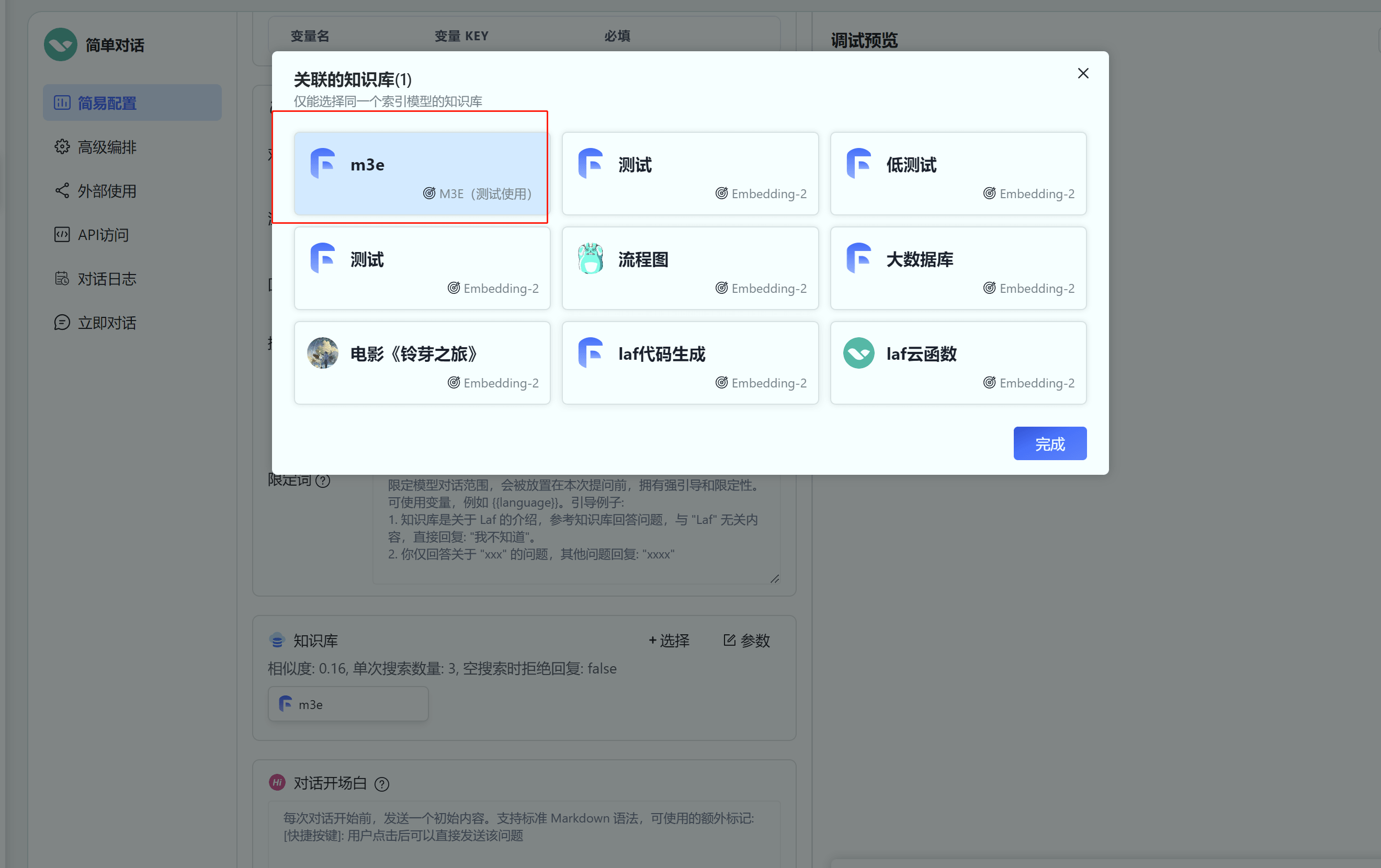

应用绑定知识库

注意,应用只能绑定同一个向量模型的知识库,不能跨模型绑定。并且,需要注意调整相似度,不同向量模型的相似度(距离)会有所区别,需要自行测试实验。

chatglm2 模型的使用方法如下: +模型选择 chatglm2 即可

将 FastGPT 接入私有化模型 ChatGLM2-6B

FastGPT 允许你使用自己的 OpenAI API KEY 来快速调用 OpenAI 接口,目前集成了 GPT-3.5, GPT-4 和 embedding,可构建自己的知识库。但考虑到数据安全的问题,我们并不能将所有的数据都交付给云端大模型。

那么如何在 FastGPT 上接入私有化模型呢?本文就以清华的 ChatGLM2 为例,为各位讲解如何在 FastGPT 中接入私有化模型。

ChatGLM2-6B 是开源中英双语对话模型 ChatGLM-6B 的第二代版本,具体介绍可参阅 ChatGLM2-6B 项目主页。

注意,ChatGLM2-6B 权重对学术研究完全开放,在获得官方的书面许可后,亦允许商业使用。本教程只是介绍了一种用法,无权给予任何授权!

依据官方数据,同样是生成 8192 长度,量化等级为 FP16 要占用 12.8GB 显存、int8 为 8.1GB 显存、int4 为 5.1GB 显存,量化后会稍微影响性能,但不多。

因此推荐配置如下:

| 类型 | 内存 | 显存 | 硬盘空间 | 启动命令 |

|---|---|---|---|---|

| fp16 | >=16GB | >=16GB | >=25GB | python openai_api.py 16 |

| int8 | >=16GB | >=9GB | >=25GB | python openai_api.py 8 |

| int4 | >=16GB | >=6GB | >=25GB | python openai_api.py 4 |

pip install -r requirements.txt;verify_token 方法中配置 token,这里的 token 只是加一层验证,防止接口被人盗用;python openai_api.py --model_name 16。这里的数字根据上面的配置进行选择。然后等待模型下载,直到模型加载完毕为止。如果出现报错先问 GPT。

启动成功后应该会显示如下地址:

这里的

http://0.0.0.0:6006就是连接地址。

镜像和端口

stawky/chatglm2:latestregistry.cn-hangzhou.aliyuncs.com/fastgpt_docker/chatglm2:latest

+ # 设置安全凭证(即oneapi中的渠道密钥)

+默认值:sk-aaabbbcccdddeeefffggghhhiiijjjkkk

+也可以通过环境变量引入:sk-key。有关docker环境变量引入的方法请自寻教程,此处不再赘述。

+ 为 chatglm2 添加一个渠道,参数如下:

这里我填入 chatglm2 作为语言模型

curl 例子:

+ curl --location --request POST 'https://domain/v1/chat/completions' \

+--header 'Authorization: Bearer sk-aaabbbcccdddeeefffggghhhiiijjjkkk' \

+--header 'Content-Type: application/json' \

+--data-raw '{

+ "model": "chatglm2",

+ "messages": [{"role": "user", "content": "Hello!"}]

+}'

+ Authorization 为 sk-aaabbbcccdddeeefffggghhhiiijjjkkk。model 为刚刚在 One API 填写的自定义模型。

修改 config.json 配置文件,在 llmModels 中加入 chatglm2 模型:

+ "llmModels": [

+ //已有模型

+ {

+ "model": "chatglm2",

+ "name": "chatglm2",

+ "maxContext": 4000,

+ "maxResponse": 4000,

+ "quoteMaxToken": 2000,

+ "maxTemperature": 1,

+ "vision": false,

+ "defaultSystemChatPrompt": ""

+ }

+]

+ chatglm2 模型的使用方法如下:

模型选择 chatglm2 即可

FastGPT 对接本地模型

将 FastGPT 接入私有化模型 M3E

FastGPT 默认使用了 openai 的 embedding 向量模型,如果你想私有部署的话,可以使用 M3E 向量模型进行替换。M3E 向量模型属于小模型,资源使用不高,CPU 也可以运行。下面教程是基于 “睡大觉” 同学提供的一个的镜像。

镜像名: stawky/m3e-large-api:latest

国内镜像: registry.cn-hangzhou.aliyuncs.com/fastgpt_docker/m3e-large-api:latest

+端口号: 6008

+环境变量:

+ # 设置安全凭证(即oneapi中的渠道密钥)

+默认值:sk-aaabbbcccdddeeefffggghhhiiijjjkkk

+也可以通过环境变量引入:sk-key。有关docker环境变量引入的方法请自寻教程,此处不再赘述。

+ 添加一个渠道,参数如下:

curl 例子:

+ curl --location --request POST 'https://domain/v1/embeddings' \

+--header 'Authorization: Bearer xxxx' \

+--header 'Content-Type: application/json' \

+--data-raw '{

+ "model": "m3e",

+ "input": ["laf是什么"]

+}'

+ Authorization 为 sk-key。model 为刚刚在 One API 填写的自定义模型。

修改 config.json 配置文件,在 vectorModels 中加入 M3E 模型:

+ "vectorModels": [

+ {

+ "model": "text-embedding-ada-002",

+ "name": "Embedding-2",

+ "price": 0.2,

+ "defaultToken": 500,

+ "maxToken": 3000

+ },

+ {

+ "model": "m3e",

+ "name": "M3E(测试使用)",

+ "price": 0.1,

+ "defaultToken": 500,

+ "maxToken": 1800

+ }

+]

+ 创建知识库时候选择 M3E 模型。

注意,一旦选择后,知识库将无法修改向量模型。

导入数据

搜索测试

应用绑定知识库

注意,应用只能绑定同一个向量模型的知识库,不能跨模型绑定。并且,需要注意调整相似度,不同向量模型的相似度(距离)会有所区别,需要自行测试实验。

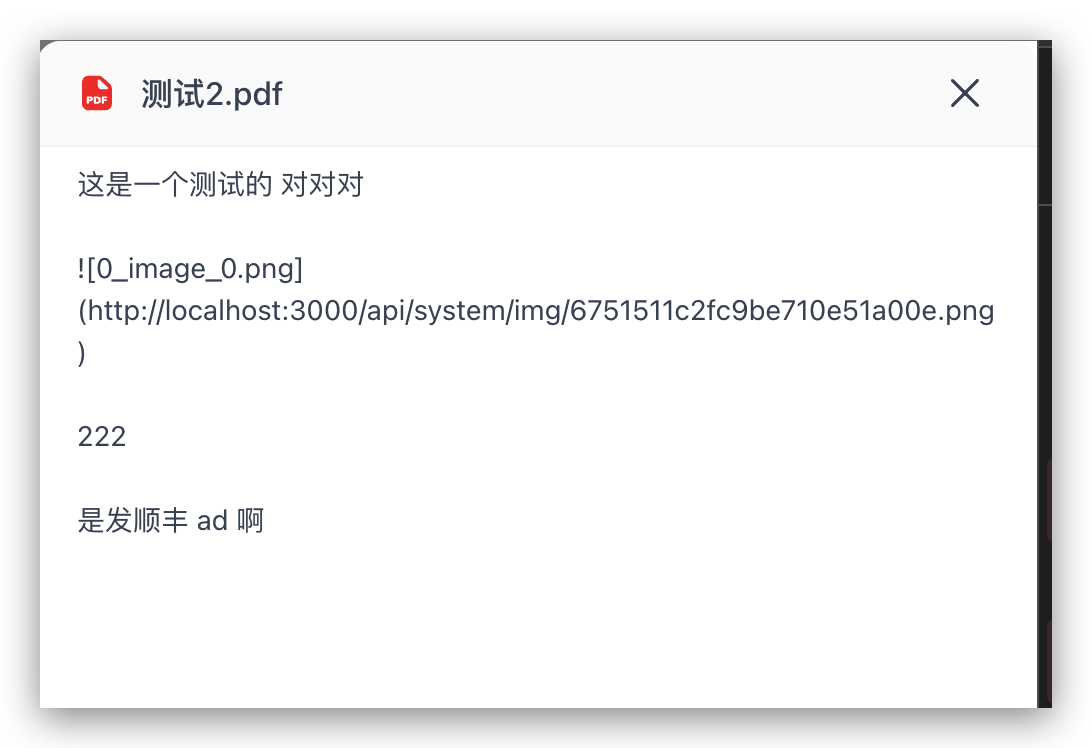

使用 Marker 解析 PDF 文档,可实现图片提取和布局识别

PDF 是一个相对复杂的文件格式,在 FastGPT 内置的 pdf 解析器中,依赖的是 pdfjs 库解析,该库基于逻辑解析,无法有效的理解复杂的 pdf 文件。所以我们在解析 pdf 时候,如果遇到图片、表格、公式等非简单文本内容,会发现解析效果不佳。

市面上目前有多种解析 PDF 的方法,比如使用 Marker,该项目使用了 Surya 模型,基于视觉解析,可以有效提取图片、表格、公式等复杂内容。为了可以让 Marker 快速接入 FastGPT,我们做了一个自定义解析的拓展 Demo。

在 FastGPT 4.8.15 版本中,你可以通过增加一个环境变量,来替换掉 FastGPT 系统内置解析器,实现自定义的文档解析服务。该功能只是 Demo 阶段,后期配置模式和交互规则会发生改动。

参考文档 Marker 安装教程,安装 Marker 模型。封装的 API 已经适配了 FastGPT 自定义解析服务。

这里介绍快速 Docker 安装的方法:

+ docker pull crpi-h3snc261q1dosroc.cn-hangzhou.personal.cr.aliyuncs.com/marker11/marker_images:latest

+docker run --gpus all -itd -p 7231:7231 --name model_pdf_v1 crpi-h3snc261q1dosroc.cn-hangzhou.personal.cr.aliyuncs.com/marker11/marker_images:latest

+

+ CUSTOM_READ_FILE_URL=http://xxxx.com/v1/parse/file

+CUSTOM_READ_FILE_EXTENSION=pdf

+ 通过知识库上传一个 pdf 文件,并确认上传,可以在日志中看到 LOG (LOG_LEVEL需要设置 info 或者 debug):

+ [Info] 2024-12-05 15:04:42 Parsing files from an external service

+[Info] 2024-12-05 15:07:08 Custom file parsing is complete, time: 1316ms

+ 然后你就可以发现,通过 Marker 解析出来的 pdf 会携带图片链接:

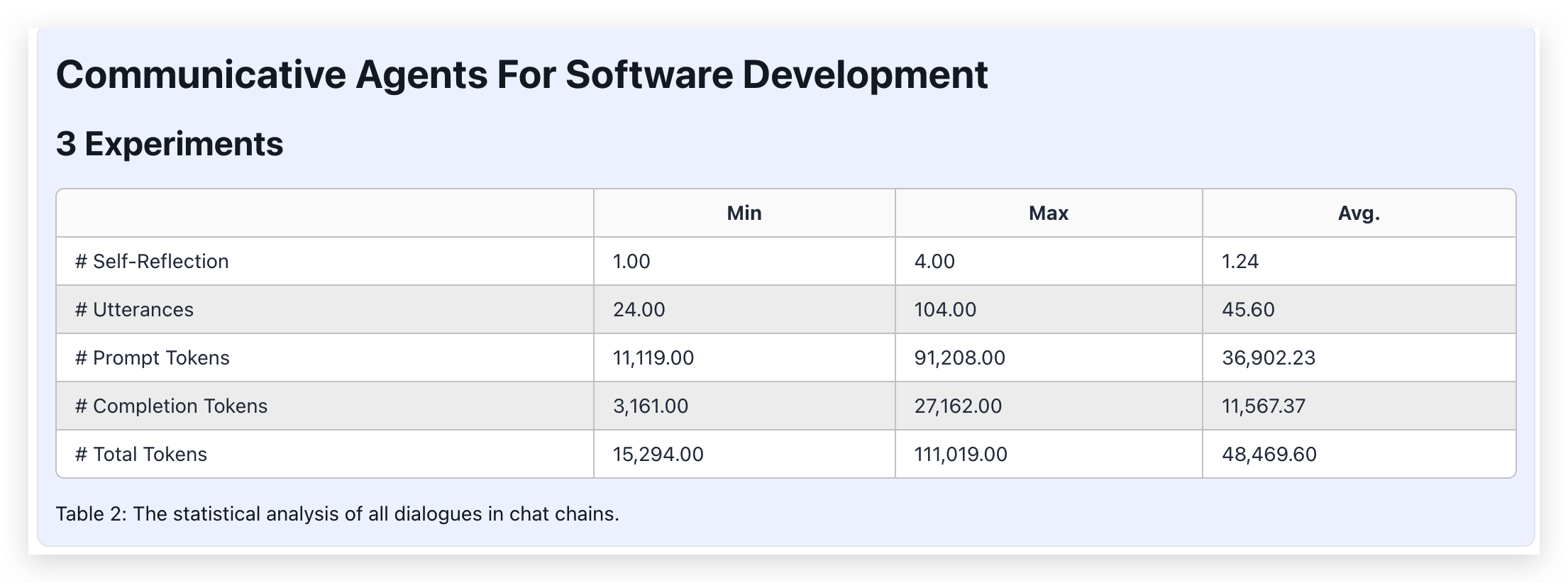

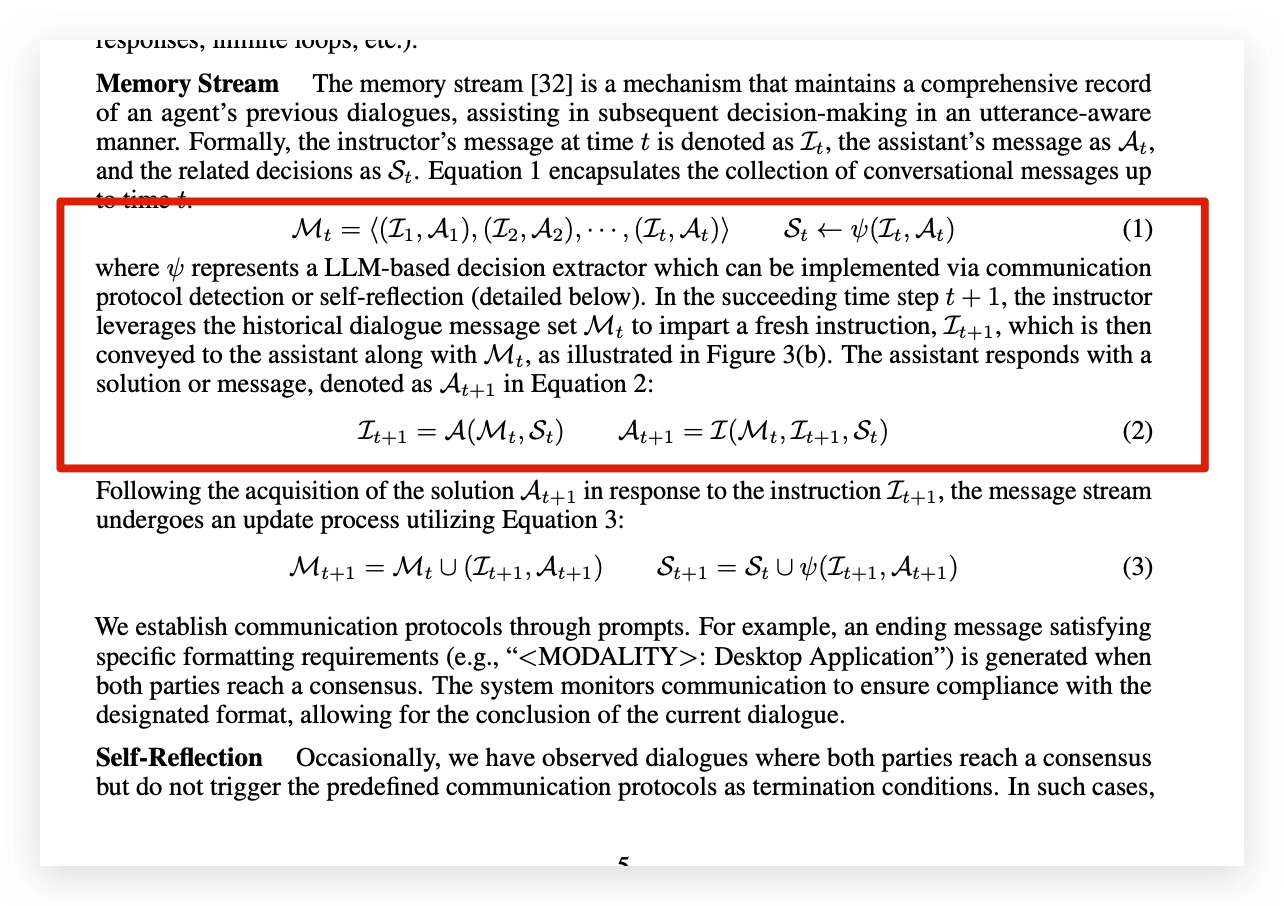

以清华的 ChatDev Communicative Agents for Software Develop.pdf 为例,展示 Marker 解析的效果:

|  |  |

|  |  |

上图是分块后的结果,下图是 pdf 原文。整体图片、公式、表格都可以提取出来,效果还是杠杠的。

不过要注意的是,Marker 的协议是GPL-3.0 license,请在遵守协议的前提下使用。

一站式本地 LLM 私有化部署

Xinference 是一款开源模型推理平台,除了支持 LLM,它还可以部署 Embedding 和 ReRank 模型,这在企业级 RAG 构建中非常关键。同时,Xinference 还提供 Function Calling 等高级功能。还支持分布式部署,也就是说,随着未来应用调用量的增长,它可以进行水平扩展。

Xinference 支持多种推理引擎作为后端,以满足不同场景下部署大模型的需要,下面会分使用场景来介绍一下这三种推理后端,以及他们的使用方法。

如果你的目标是在一台 Linux 或者 Window 服务器上部署大模型,可以选择 Transformers 或 vLLM 作为 Xinference 的推理后端:

假设你服务器配备 NVIDIA 显卡,可以参考这篇文章中的指令来安装 CUDA,从而让 Xinference 最大限度地利用显卡的加速功能。

你可以使用 Xinference 官方的 Docker 镜像来一键安装和启动 Xinference 服务(确保你的机器上已经安装了 Docker),命令如下:

+ docker run -p 9997:9997 --gpus all xprobe/xinference:latest xinference-local -H 0.0.0.0

+ 首先我们需要准备一个 3.9 以上的 Python 环境运行来 Xinference,建议先根据 conda 官网文档安装 conda。 然后使用以下命令来创建 3.11 的 Python 环境:

+ conda create --name py311 python=3.11

+conda activate py311

+ 以下两条命令在安装 Xinference 时,将安装 Transformers 和 vLLM 作为 Xinference 的推理引擎后端:

+ pip install "xinference[transformers]"

+pip install "xinference[vllm]"

+pip install "xinference[transformers,vllm]" # 同时安装

+ PyPi 在 安装 Transformers 和 vLLM 时会自动安装 PyTorch,但自动安装的 CUDA 版本可能与你的环境不匹配,此时你可以根据 PyTorch 官网中的安装指南来手动安装。

只需要输入如下命令,就可以在服务上启动 Xinference 服务:

+ xinference-local -H 0.0.0.0

+ Xinference 默认会在本地启动服务,端口默认为 9997。因为这里配置了-H 0.0.0.0参数,非本地客户端也可以通过机器的 IP 地址来访问 Xinference 服务。

如果你想在自己的 Macbook 或者个人电脑上部署大模型,推荐安装 CTransformers 作为 Xinference 的推理后端。CTransformers 是用 GGML 实现的 C++ 版本 Transformers。

GGML 是一个能让大语言模型在消费级硬件上运行的 C++ 库。 GGML 最大的特色在于模型量化。量化一个大语言模型其实就是降低权重表示精度的过程,从而减少使用模型所需的资源。 例如,表示一个高精度浮点数(例如 0.0001)比表示一个低精度浮点数(例如 0.1)需要更多空间。由于 LLM 在推理时需要加载到内存中的,因此你需要花费硬盘空间来存储它们,并且在执行期间有足够大的 RAM 来加载它们,GGML 支持许多不同的量化策略,每种策略在效率和性能之间提供不同的权衡。

通过以下命令来安装 CTransformers 作为 Xinference 的推理后端:

+ pip install xinference

+pip install ctransformers

+ 因为 GGML 是一个 C++ 库,Xinference 通过 llama-cpp-python 这个库来实现语言绑定。对于不同的硬件平台,我们需要使用不同的编译参数来安装:

CMAKE_ARGS="-DLLAMA_METAL=on" pip install llama-cpp-pythonCMAKE_ARGS="-DLLAMA_CUBLAS=on" pip install llama-cpp-pythonCMAKE_ARGS="-DLLAMA_HIPBLAS=on" pip install llama-cpp-python安装后只需要输入 xinference-local,就可以在你的 Mac 上启动 Xinference 服务。

Xinference 启动之后,在浏览器中输入: http://127.0.0.1:9997,我们可以访问到本地 Xinference 的 Web UI。

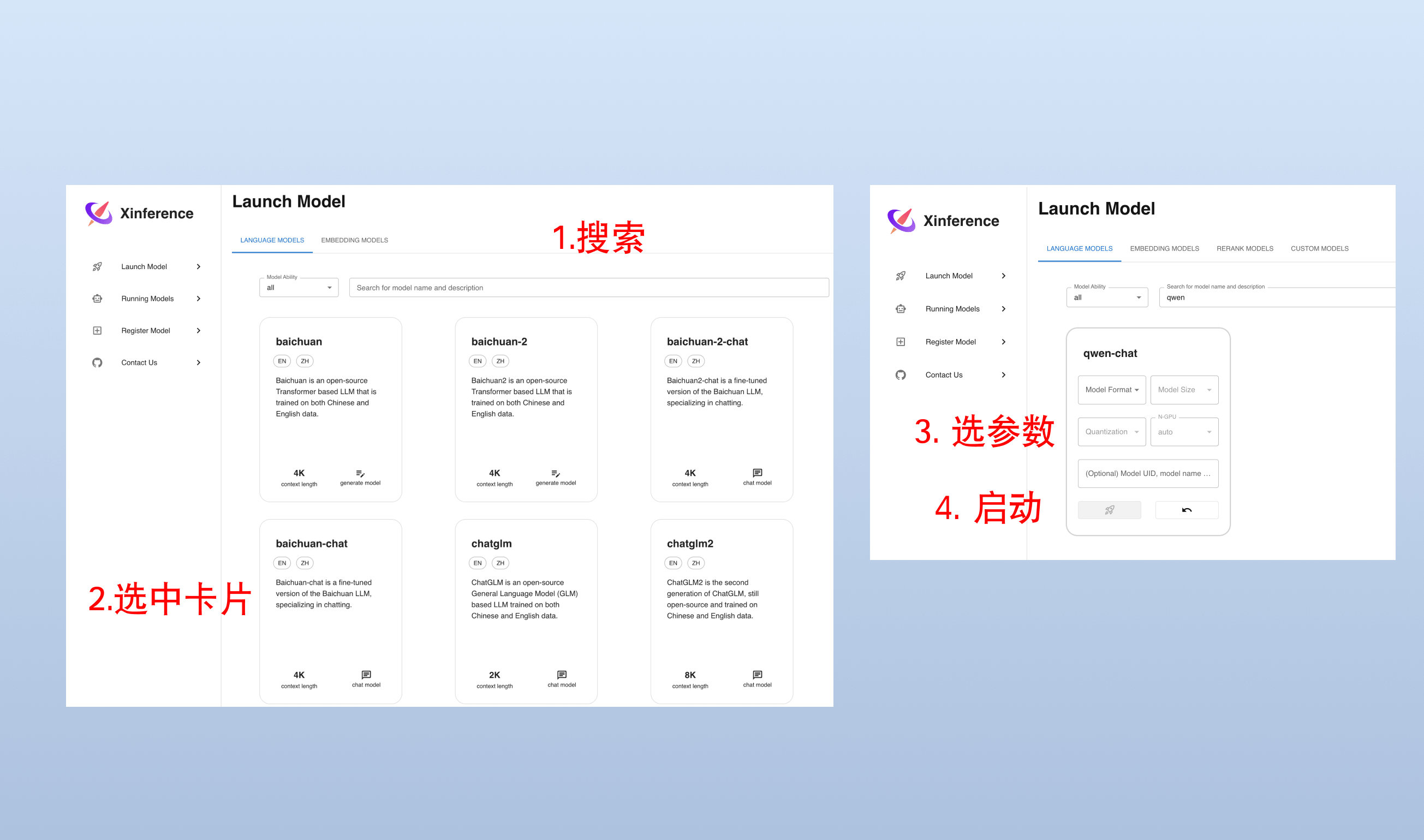

打开“Launch Model”标签,搜索到 qwen-chat,选择模型启动的相关参数,然后点击模型卡片左下方的小火箭🚀按钮,就可以部署该模型到 Xinference。 默认 Model UID 是 qwen-chat(后续通过将通过这个 ID 来访问模型)。

当你第一次启动 Qwen 模型时,Xinference 会从 HuggingFace 下载模型参数,大概需要几分钟的时间。Xinference 将模型文件缓存在本地,这样之后启动时就不需要重新下载了。 Xinference 还支持从其他模型站点下载模型文件,例如 modelscope。

我们也可以使用 Xinference 的命令行工具来启动模型,默认 Model UID 是 qwen-chat(后续通过将通过这个 ID 来访问模型)。

+ xinference launch -n qwen-chat -s 14 -f pytorch

+ 除了 WebUI 和命令行工具, Xinference 还提供了 Python SDK 和 RESTful API 等多种交互方式, 更多用法可以参考 Xinference 官方文档。

One API 的部署和接入请参考这里。

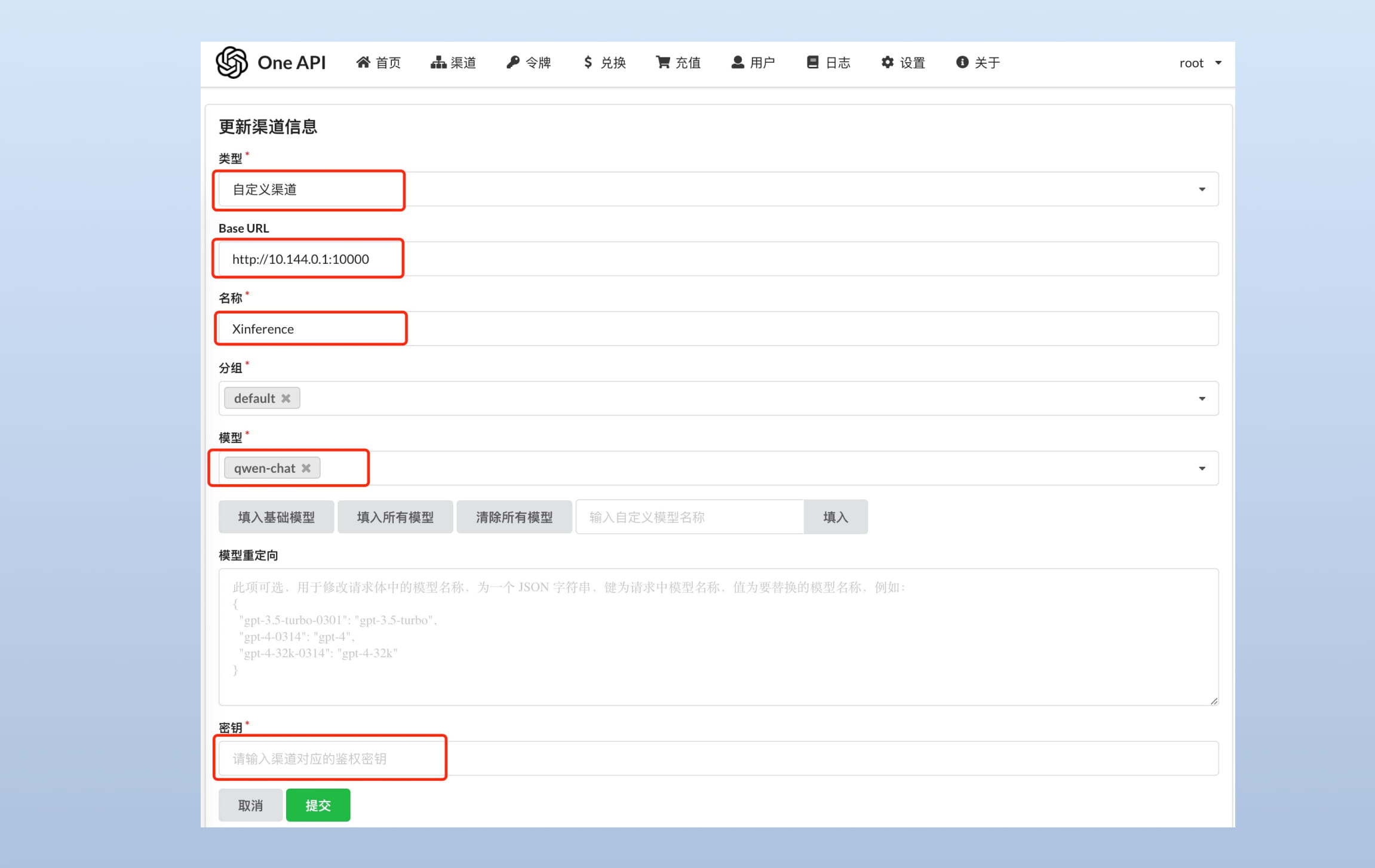

为 qwen1.5-chat 添加一个渠道,这里的 Base URL 需要填 Xinference 服务的端点,并且注册 qwen-chat (模型的 UID) 。

可以使用以下命令进行测试:

+ curl --location --request POST 'https://<oneapi_url>/v1/chat/completions' \

+--header 'Authorization: Bearer <oneapi_token>' \

+--header 'Content-Type: application/json' \

+--data-raw '{

+ "model": "qwen-chat",

+ "messages": [{"role": "user", "content": "Hello!"}]

+}'

+ 将 <oneapi_url> 替换为你的 One API 地址,<oneapi_token> 替换为你的 One API 令牌。model 为刚刚在 One API 填写的自定义模型。

修改 FastGPT 的 config.json 配置文件的 llmModels 部分加入 qwen-chat 模型:

+ ...

+ "llmModels": [

+ {

+ "model": "qwen-chat", // 模型名(对应OneAPI中渠道的模型名)

+ "name": "Qwen", // 模型别名

+ "avatar": "/imgs/model/Qwen.svg", // 模型的logo

+ "maxContext": 125000, // 最大上下文

+ "maxResponse": 4000, // 最大回复

+ "quoteMaxToken": 120000, // 最大引用内容

+ "maxTemperature": 1.2, // 最大温度

+ "charsPointsPrice": 0, // n积分/1k token(商业版)

+ "censor": false, // 是否开启敏感校验(商业版)

+ "vision": true, // 是否支持图片输入

+ "datasetProcess": true, // 是否设置为知识库处理模型(QA),务必保证至少有一个为true,否则知识库会报错

+ "usedInClassify": true, // 是否用于问题分类(务必保证至少有一个为true)

+ "usedInExtractFields": true, // 是否用于内容提取(务必保证至少有一个为true)

+ "usedInToolCall": true, // 是否用于工具调用(务必保证至少有一个为true)

+ "usedInQueryExtension": true, // 是否用于问题优化(务必保证至少有一个为true)

+ "toolChoice": true, // 是否支持工具选择(分类,内容提取,工具调用会用到。)

+ "functionCall": false, // 是否支持函数调用(分类,内容提取,工具调用会用到。会优先使用 toolChoice,如果为false,则使用 functionCall,如果仍为 false,则使用提示词模式)

+ "customCQPrompt": "", // 自定义文本分类提示词(不支持工具和函数调用的模型

+ "customExtractPrompt": "", // 自定义内容提取提示词

+ "defaultSystemChatPrompt": "", // 对话默认携带的系统提示词

+ "defaultConfig": {} // 请求API时,挟带一些默认配置(比如 GLM4 的 top_p)

+ }

+ ],

+...

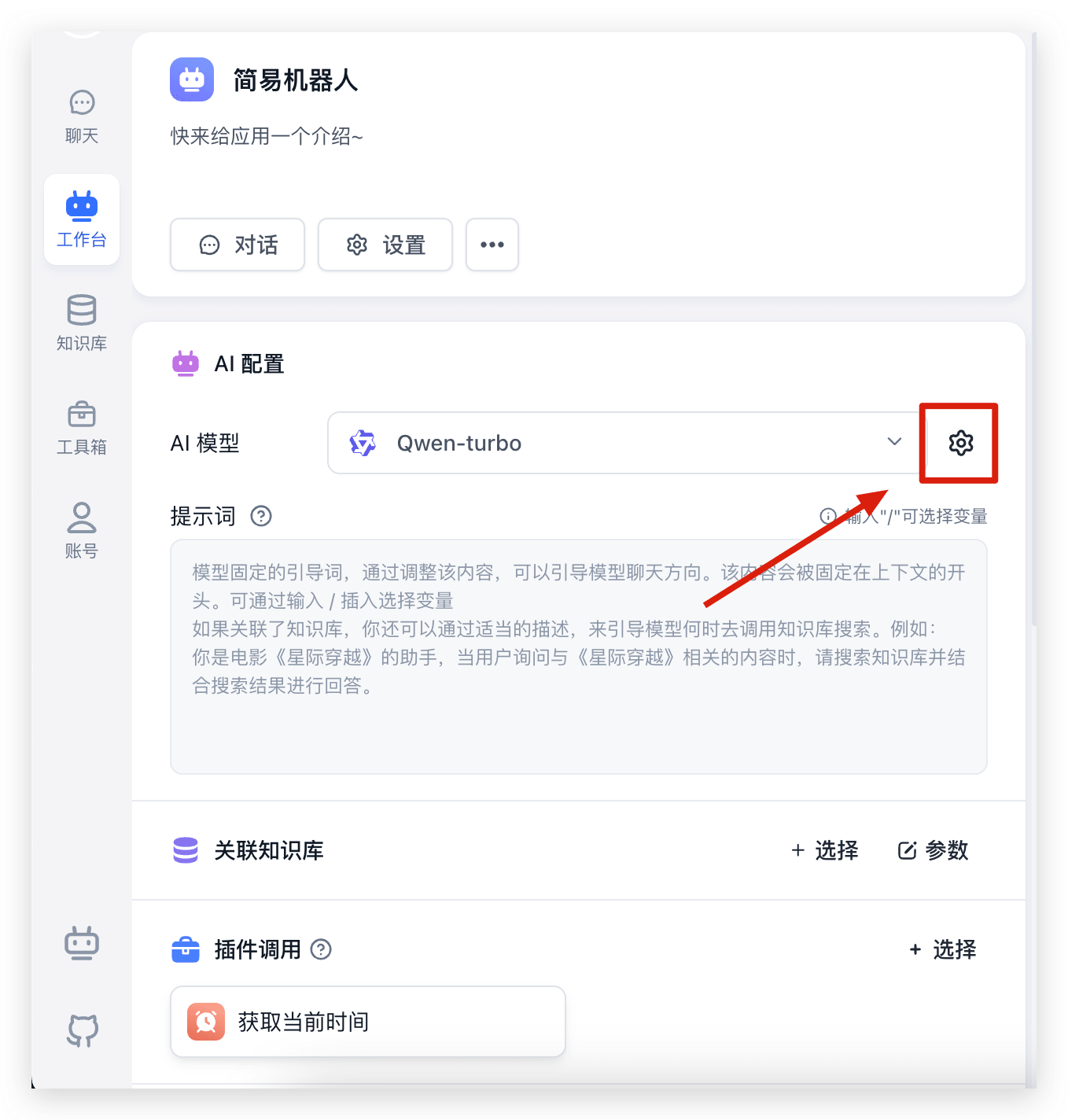

+ 然后重启 FastGPT 就可以在应用配置中选择 Qwen 模型进行对话:

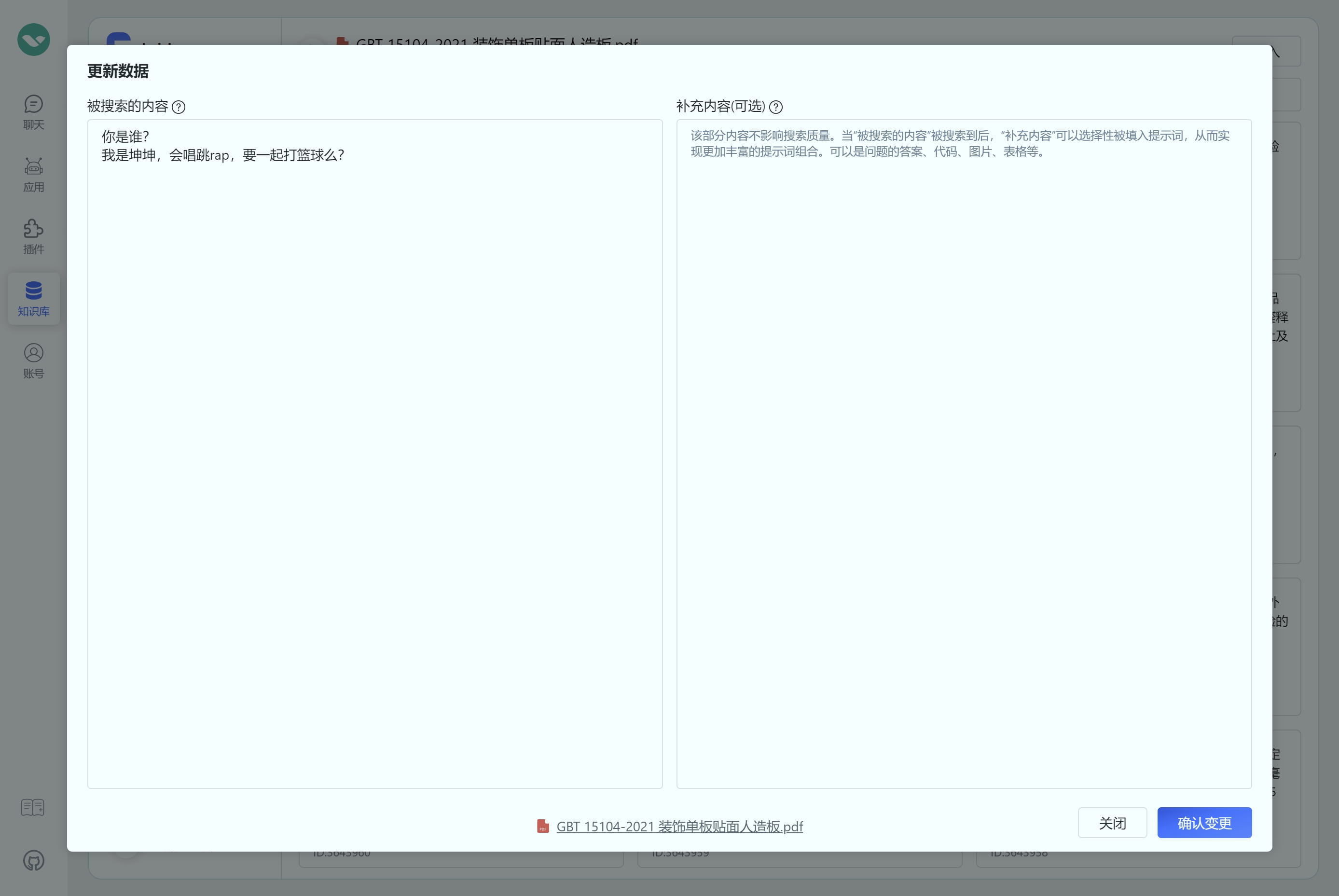

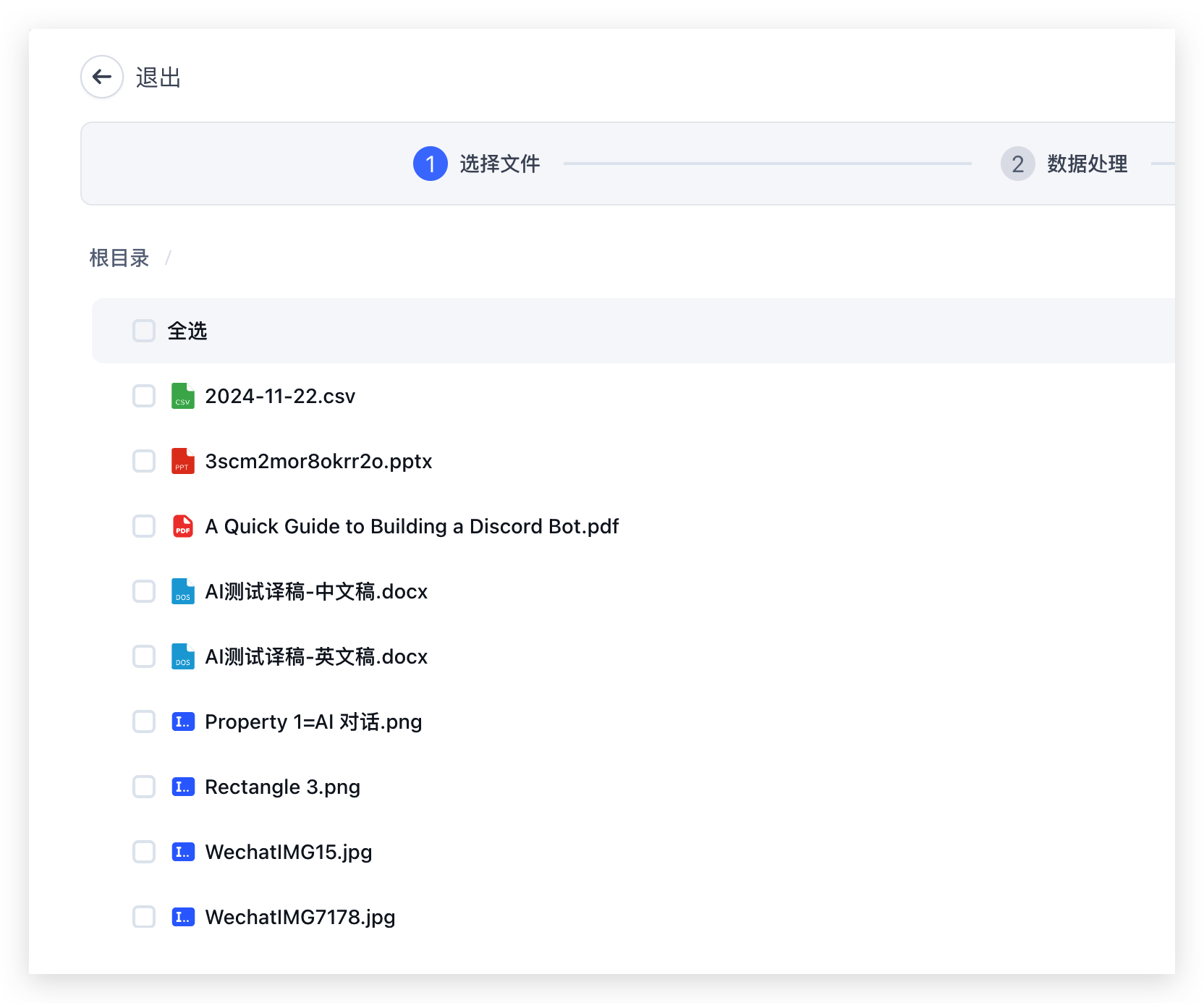

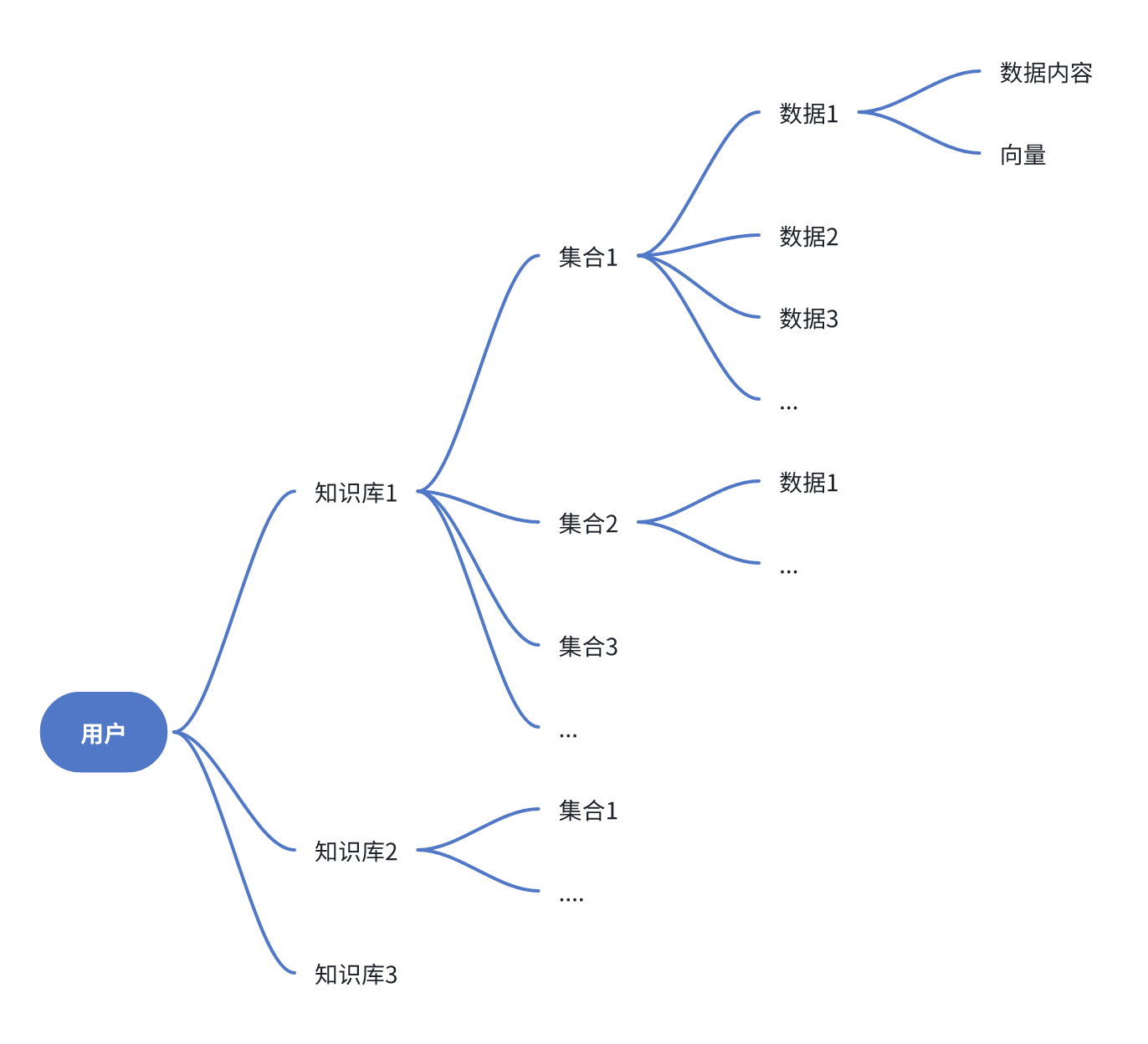

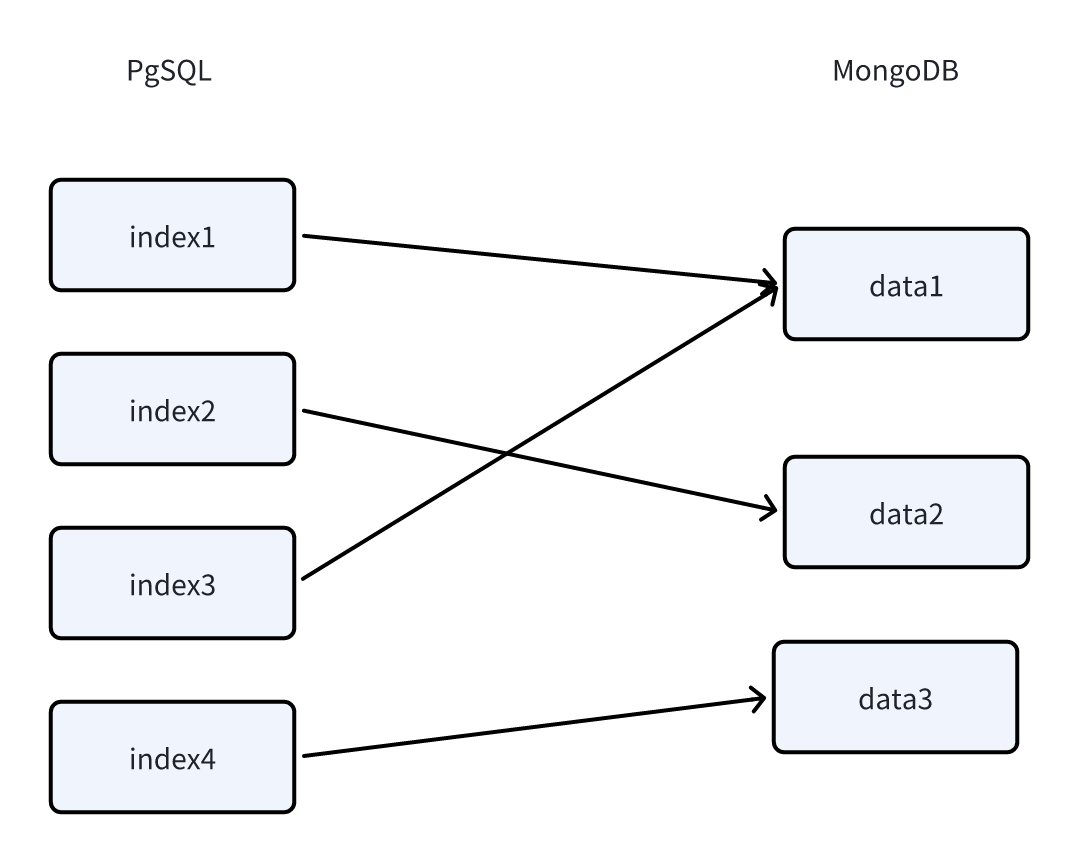

FastGPT 数据集中文件与数据的设计方案

在 FastGPT 中,文件会通过 MongoDB 的 FS 存储,而具体的数据会通过 PostgreSQL 存储,PG 中的数据会有一列 file_id,关联对应的文件。考虑到旧版本的兼容,以及手动输入、标注数据等,我们给 file_id 增加了一些特殊的值,如下:

注意,file_id 仅在插入数据时会写入,变更时无法修改。

unused 状态used,并将数据推送到 mongo training 表中等待训练使用 Docker Compose 快速部署 FastGPT

MongoDB:用于存储除了向量外的各类数据

PostgreSQL/Milvus:存储向量数据

OneAPI: 聚合各类 AI API,支持多模型调用 (任何模型问题,先自行通过 OneAPI 测试校验)

体验测试首选

| 环境 | 最低配置(单节点) | 推荐配置 |

|---|---|---|

| 测试 | 2c2g | 2c4g |

| 100w 组向量 | 4c8g 50GB | 4c16g 50GB |

| 500w 组向量 | 8c32g 200GB | 16c64g 200GB |

生产部署首选,对于千万级以上向量性能更优秀。

| 环境 | 最低配置(单节点) | 推荐配置 |

|---|---|---|

| 测试 | 2c8g | 4c16g |

| 100w 组向量 | 未测试 | |

| 500w 组向量 |

Milvus 的全托管服务,性能优于 Milvus 并提供 SLA,点击使用 Zilliz Cloud。

由于向量库使用了 Cloud,无需占用本地资源,无需太关注。

如果使用OpenAI等国外模型接口,请确保可以正常访问,否则会报错:Connection error 等。 方案可以参考:代理方案

非 Linux 环境或无法访问外网环境,可手动创建一个目录,并下载配置文件和对应版本的docker-compose.yml,在这个文件夹中依据下载的配置文件运行docker,若作为本地开发使用推荐docker-compose-pgvector版本,并且自行拉取并运行sandbox和fastgpt,并在docker配置文件中注释掉sandbox和fastgpt的部分

所有 docker-compose.yml 配置文件中 MongoDB 为 5.x,需要用到AVX指令集,部分 CPU 不支持,需手动更改其镜像版本为 4.4.24**(需要自己在docker hub下载,阿里云镜像没做备份)

Linux 快速脚本

+ mkdir fastgpt

+cd fastgpt

+curl -O https://raw.githubusercontent.com/labring/FastGPT/main/projects/app/data/config.json

+

+# pgvector 版本(测试推荐,简单快捷)

+curl -o docker-compose.yml https://raw.githubusercontent.com/labring/FastGPT/main/files/docker/docker-compose-pgvector.yml

+# milvus 版本

+# curl -o docker-compose.yml https://raw.githubusercontent.com/labring/FastGPT/main/files/docker/docker-compose-milvus.yml

+# zilliz 版本

+# curl -o docker-compose.yml https://raw.githubusercontent.com/labring/FastGPT/main/files/docker/docker-compose-zilliz.yml

+ 找到 yml 文件中,fastgpt 容器的环境变量进行下面操作:

在 docker-compose.yml 同级目录下执行。请确保docker-compose版本最好在2.17以上,否则可能无法执行自动化命令。

+ # 启动容器

+docker-compose up -d

+# 等待10s,OneAPI第一次总是要重启几次才能连上Mysql

+sleep 10

+# 重启一次oneapi(由于OneAPI的默认Key有点问题,不重启的话会提示找不到渠道,临时手动重启一次解决,等待作者修复)

+docker restart oneapi

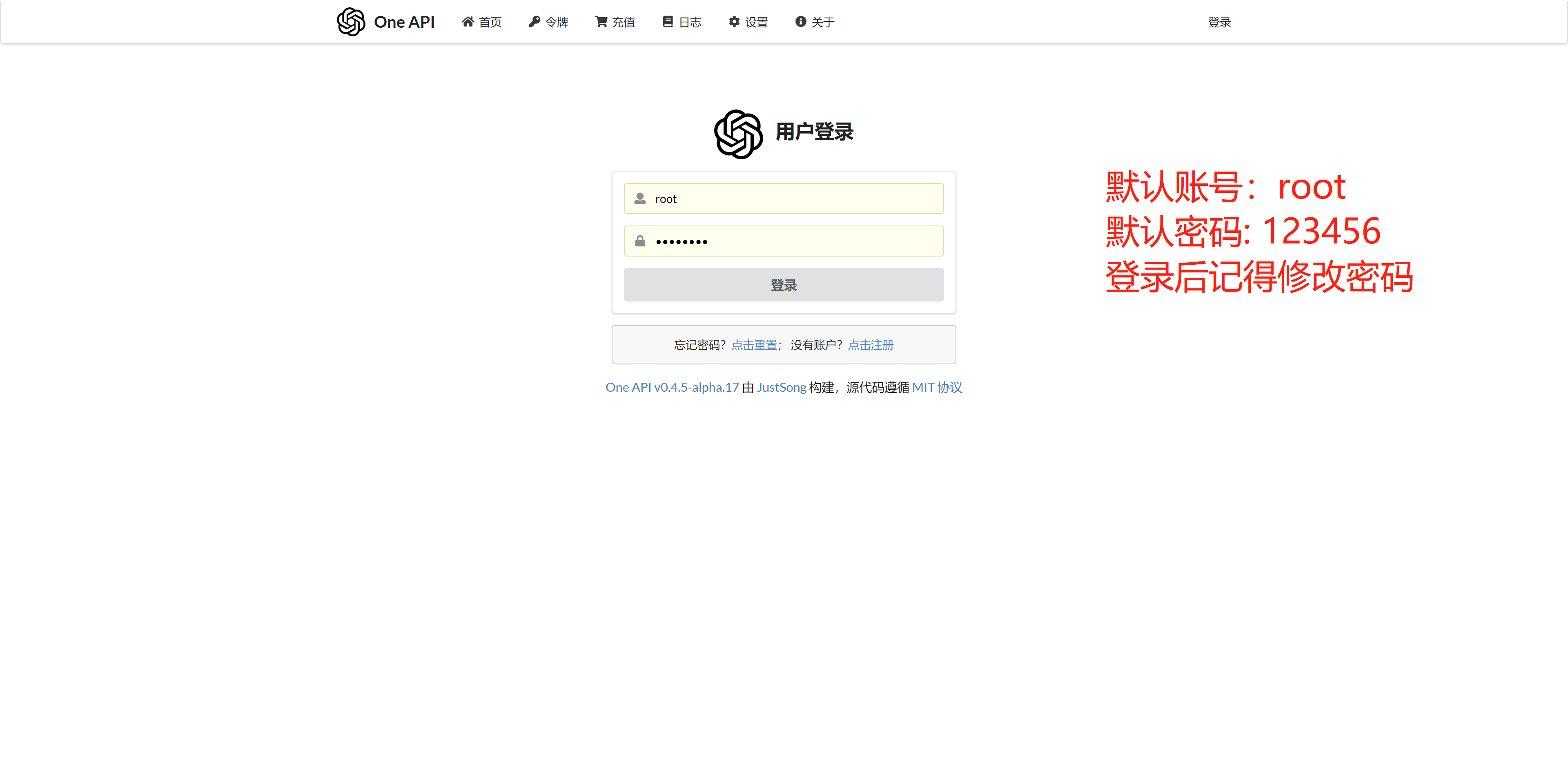

+ 可以通过ip:3001访问OneAPI,默认账号为root密码为123456。

在OneApi中添加合适的AI模型渠道。点击查看相关教程

目前可以通过 ip:3000 直接访问(注意防火墙)。登录用户名为 root,密码为docker-compose.yml环境变量里设置的 DEFAULT_ROOT_PSW。

如果需要域名访问,请自行安装并配置 Nginx。

首次运行,会自动初始化 root 用户,密码为 1234(与环境变量中的DEFAULT_ROOT_PSW一致),日志里会提示一次MongoServerError: Unable to read from a snapshot due to pending collection catalog changes;可忽略。

最新的 docker-compose 示例优化 Mongo 副本集初始化,实现了全自动。目前在 unbuntu20,22 centos7, wsl2, mac, window 均通过测试。仍无法正常启动,大部分是因为 cpu 不支持 AVX 指令集,可以切换 Mongo4.x 版本。

如果是由于,无法自动初始化副本集合,可以手动初始化副本集:

+ openssl rand -base64 756 > ./mongodb.key

+chmod 600 ./mongodb.key

+# 修改密钥权限,部分系统是admin,部分是root

+chown 999:root ./mongodb.key

+

+ mongo:

+ # image: mongo:5.0.18

+ # image: registry.cn-hangzhou.aliyuncs.com/fastgpt/mongo:5.0.18 # 阿里云

+ container_name: mongo

+ ports:

+ - 27017:27017

+ networks:

+ - fastgpt

+ command: mongod --keyFile /data/mongodb.key --replSet rs0

+ environment:

+ # 默认的用户名和密码,只有首次允许有效

+ - MONGO_INITDB_ROOT_USERNAME=myusername

+ - MONGO_INITDB_ROOT_PASSWORD=mypassword

+ volumes:

+ - ./mongo/data:/data/db

+ - ./mongodb.key:/data/mongodb.key

+

+ docker-compose down

+docker-compose up -d

+

+ # 查看 mongo 容器是否正常运行

+docker ps

+# 进入容器

+docker exec -it mongo bash

+

+# 连接数据库(这里要填Mongo的用户名和密码)

+mongo -u myusername -p mypassword --authenticationDatabase admin

+

+# 初始化副本集。如果需要外网访问,mongo:27017 。如果需要外网访问,需要增加Mongo连接参数:directConnection=true

+rs.initiate({

+ _id: "rs0",

+ members: [

+ { _id: 0, host: "mongo:27017" }

+ ]

+})

+# 检查状态。如果提示 rs0 状态,则代表运行成功

+rs.status()

+ 默认是写了OneAPi的连接地址和密钥,可以通过修改docker-compose.yml中,fastgpt容器的环境变量实现。

OPENAI_BASE_URL(API 接口的地址,需要加/v1)

+CHAT_API_KEY(API 接口的凭证)。

修改完后重启:

+ docker-compose down

+docker-compose up -d

+ 查看更新文档,确认要升级的版本,避免跨版本升级。

修改镜像 tag 到指定版本

执行下面命令会自动拉取镜像:

+ docker-compose pull

+docker-compose up -d

+ 执行初始化脚本(如果有)

修改config.json文件,并执行docker-compose down再执行docker-compose up -d重起容器。具体配置,参考配置详解。

docker logs fastgpt 可以查看日志,在启动容器后,第一次请求网页,会进行配置文件读取,可以看看有没有读取成功以及有无错误日志。docker exec -it fastgpt sh 进入 FastGPT 容器,可以通过ls data查看目录下是否成功挂载config.json文件。可通过cat data/config.json查看配置文件。可能不生效的原因

invalid json,配置文件需要是标准的 JSON 文件。docker-compose down再docker-compose up -d,restart是不会重新挂载文件的。docker exec -it fastgpt sh 进入 FastGPT 容器。env命令查看所有环境变量。本地模型镜像 docker-compose.yml中使用了桥接的模式建立了fastgpt网络,如想通过0.0.0.0或镜像名访问其它镜像,需将其它镜像也加入到网络中。

docker-compose 端口定义为:映射端口:运行端口。

桥接模式下,容器运行端口不会有冲突,但是会有映射端口冲突,只需将映射端口修改成不同端口即可。

如果容器1需要连接容器2,使用容器2:运行端口来进行连接即可。

(自行补习 docker 基本知识)

PG 数据库没有连接上/初始化失败,可以查看日志。FastGPT 会在每次连接上 PG 时进行表初始化,如果报错会有对应日志。

可能原因:

auth_codes.findOne() buffering timed out after 10000ms mongo连接失败,查看mongo的运行状态对应日志。

可能原因:

Illegal instruction.... Waiting for MongoDB to start: cpu 不支持 AVX,无法用 mongo5,需要换成 mongo4.x日志会有错误提示。大概率是没有启动 Mongo 副本集模式。

没配置 SSL 证书,无权使用部分功能。

由于服务初始化错误,系统重启导致。

修改docker-compose.yml文件中DEFAULT_ROOT_PSW并重启即可,密码会自动更新。

FastGPT 私有部署常见问题

遇到问题先按下面方式排查。

docker ps -a 查看所有容器运行状态,检查是否全部 running,如有异常,尝试docker logs 容器名查看对应日志。docker logs 容器名 查看报错日志requestId的,都是 OneAPI 提示错误,大部分都是因为模型接口报错。具体内容参考https://fael3z0zfze.feishu.cn/wiki/OFpAw8XzAi36Guk8dfucrCKUnjg。

可以。需要准备好向量模型和LLM模型。

toolChoice=false和functionCall=false,就会默认走提示词模式。目前内置提示词仅针对了商业模型API进行测试。问题分类基本可用,内容提取不太行。customCQPrompt来自定义提示词。URI malformed,请 Issue 反馈具体操作和页面,这是由于特殊字符串编码解析报错。

+ # curl 例子。

+curl --location --request POST 'https://xxx.cn/v1/chat/completions' \

+--header 'Authorization: Bearer sk-xxxx' \

+--header 'Content-Type: application/json' \

+--data-raw '{

+ "model": "gpt-3.5-turbo",

+ "stream": true,

+ "temperature": 1,

+ "max_tokens": 3000,

+ "messages": [

+ {

+ "role": "user",

+ "content": "你是谁"

+ }

+ ]

+}'

+ 页面中是用 stream=true 模式,所以API也需要设置 stream=true 来进行测试。部分模型接口(国产居多)非 Stream 的兼容有点垃圾。 +和上一个问题一样,curl 测试。

先看日志报错信息。有以下几种情况:

网络异常。国内服务器无法请求OpenAI,自行检查与AI模型的连接是否正常。

或者是FastGPT请求不到 OneAPI(没放同一个网络)

带有 requestId 的都是 OneAPI 的报错。

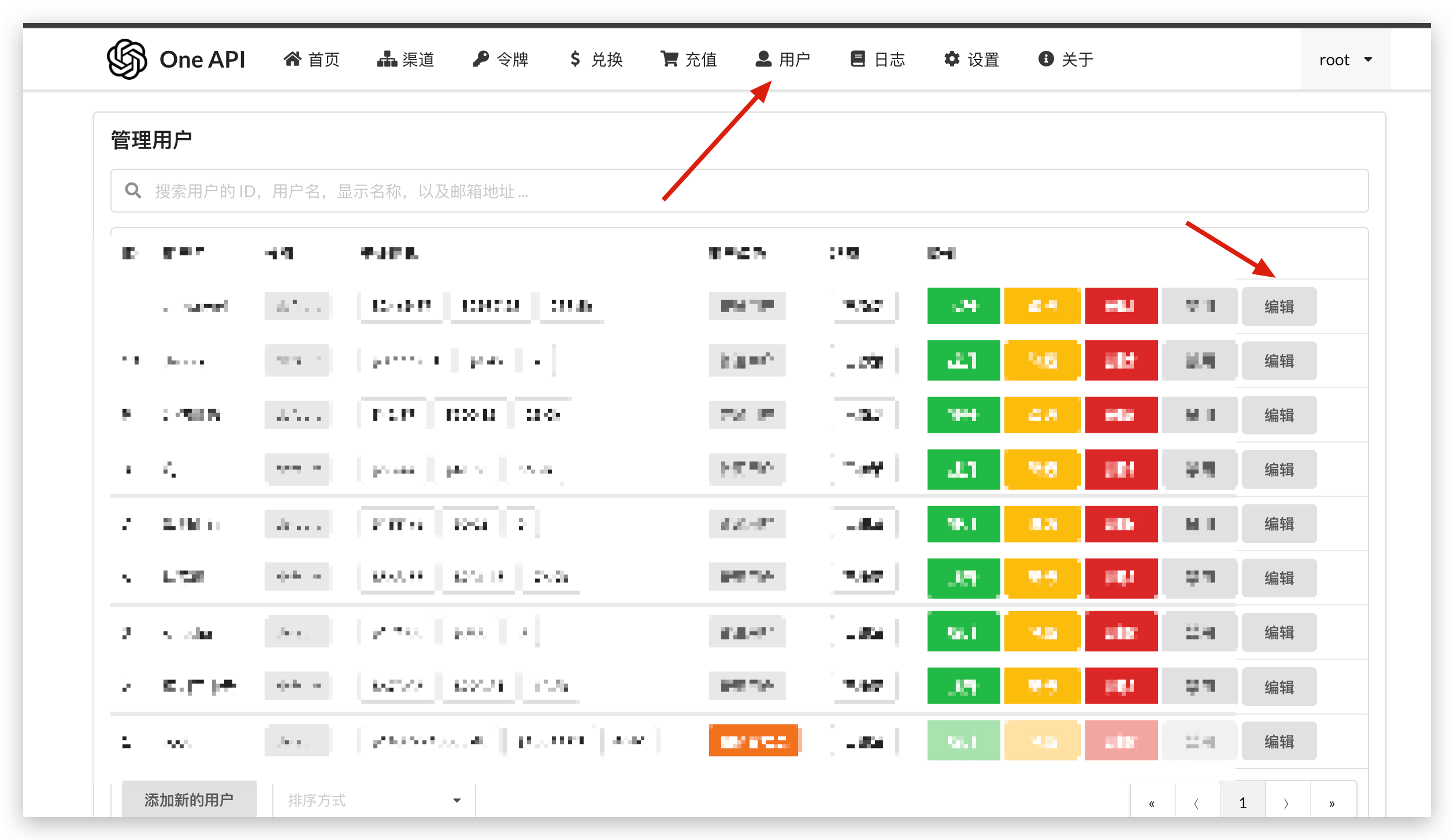

OneAPI 账号的余额不足,默认 root 用户只有 200 刀,可以手动修改。

路径:打开OneAPI -> 用户 -> root用户右边的编辑 -> 剩余余额调大

FastGPT 模型配置文件中的 model 必须与 OneAPI 渠道中的模型对应上,否则就会提示这个错误。可检查下面内容:

如果OneAPI中,没有配置对应的模型,config.json中也不要配置,否则容易报错。

OneAPI 的 API Key 配置错误,需要修改OPENAI_API_KEY环境变量,并重启容器(先 docker-compose down 然后再 docker-compose up -d 运行一次)。

可以exec进入容器,env查看环境变量是否生效。

该错误是由于 stream 模式下,oneapi 直接结束了流请求,并且未返回任何内容导致。

4.8.10 版本新增了错误日志,报错时,会在日志中打印出实际发送的 Body 参数,可以复制该参数后,通过 curl 向 oneapi 发起请求测试。

由于 oneapi 在 stream 模式下,无法正确捕获错误,有时候可以设置成 stream=false 来获取到精确的错误。

可能的报错问题:

测试示例如下,可复制报错日志中的请求体进行测试:

+ curl --location --request POST 'https://api.openai.com/v1/chat/completions' \

+--header 'Authorization: Bearer sk-xxxx' \

+--header 'Content-Type: application/json' \

+--data-raw '{

+ "model": "xxx",

+ "temperature": 0.01,

+ "max_tokens": 1000,

+ "stream": true,

+ "messages": [

+ {

+ "role": "user",

+ "content": " 你是饿"

+ }

+ ]

+}'

+ 需要模型提供商和 oneapi 同时支持工具调用才可使用,测试方法如下:

curl 向 oneapi 发起第一轮 stream 模式的 tool 测试。

+ curl --location --request POST 'https://oneapi.xxx/v1/chat/completions' \

+--header 'Authorization: Bearer sk-xxxx' \

+--header 'Content-Type: application/json' \

+--data-raw '{

+ "model": "gpt-4o-mini",

+ "temperature": 0.01,

+ "max_tokens": 8000,

+ "stream": true,

+ "messages": [

+ {

+ "role": "user",

+ "content": "几点了"

+ }

+ ],

+ "tools": [

+ {

+ "type": "function",

+ "function": {

+ "name": "hCVbIY",

+ "description": "获取用户当前时区的时间。",

+ "parameters": {

+ "type": "object",

+ "properties": {},

+ "required": []

+ }

+ }

+ }

+ ],

+ "tool_choice": "auto"

+}'

+ 如果能正常调用工具,会返回对应 tool_calls 参数。

+ {

+ "id": "chatcmpl-A7kwo1rZ3OHYSeIFgfWYxu8X2koN3",

+ "object": "chat.completion.chunk",

+ "created": 1726412126,

+ "model": "gpt-4o-mini-2024-07-18",

+ "system_fingerprint": "fp_483d39d857",

+ "choices": [

+ {

+ "index": 0,

+ "delta": {

+ "role": "assistant",

+ "content": null,

+ "tool_calls": [

+ {

+ "index": 0,

+ "id": "call_0n24eiFk8OUyIyrdEbLdirU7",

+ "type": "function",

+ "function": {

+ "name": "mEYIcFl84rYC",

+ "arguments": ""

+ }

+ }

+ ],

+ "refusal": null

+ },

+ "logprobs": null,

+ "finish_reason": null

+ }

+ ],

+ "usage": null

+}

+ curl 向 oneapi 发起第二轮 stream 模式的 tool 测试。第二轮请求是把工具结果发送给模型。发起后会得到模型回答的结果。

+ curl --location --request POST 'https://oneapi.xxxx/v1/chat/completions' \

+--header 'Authorization: Bearer sk-xxx' \

+--header 'Content-Type: application/json' \

+--data-raw '{

+ "model": "gpt-4o-mini",

+ "temperature": 0.01,

+ "max_tokens": 8000,

+ "stream": true,

+ "messages": [

+ {

+ "role": "user",

+ "content": "几点了"

+ },

+ {

+ "role": "assistant",

+ "tool_calls": [

+ {

+ "id": "kDia9S19c4RO",

+ "type": "function",

+ "function": {

+ "name": "hCVbIY",

+ "arguments": "{}"

+ }

+ }

+ ]

+ },

+ {

+ "tool_call_id": "kDia9S19c4RO",

+ "role": "tool",

+ "name": "hCVbIY",

+ "content": "{\n \"time\": \"2024-09-14 22:59:21 Sunday\"\n}"

+ }

+ ],

+ "tools": [

+ {

+ "type": "function",

+ "function": {

+ "name": "hCVbIY",

+ "description": "获取用户当前时区的时间。",

+ "parameters": {

+ "type": "object",

+ "properties": {},

+ "required": []

+ }

+ }

+ }

+ ],

+ "tool_choice": "auto"

+}'

+ 本地开发 FastGPT 必看

对 FastGPT 进行开发调试

本文档介绍了如何设置开发环境以构建和测试 FastGPT,。

您需要在计算机上安装和配置以下依赖项才能构建 FastGPT:

Asia/Shanghai,非 linux 环境时候,获取系统时间会异常,本地开发时候,可以将用户的时区调整成 UTC(+0)。您需要 Fork 存储库。

克隆您在 GitHub 上 Fork 的存储库:

+ git clone git@github.com:<github_username>/FastGPT.git

+ 目录简要说明

projects 目录下为 FastGPT 应用代码。其中 app 为 FastGPT 核心应用。(后续可能会引入其他应用)src/pages/api 目录内。packages 目录为共用代码,通过 workspace 被注入到 projects 中,已配置 monorepo 自动注入,无需额外打包。第一次开发,需要先部署数据库,建议本地开发可以随便找一台 2C2G 的轻量小数据库实践,或者新建文件夹并配置相关文件用以运行docker。数据库部署教程:Docker 快速部署。部署完了,可以本地访问其数据库。

Mongo 数据库需要注意,需要注意在连接地址中增加 directConnection=true 参数,才能连接上副本集的数据库。

以下文件均在 projects/app 路径下。

1. 环境变量

复制.env.template文件,在同级目录下生成一个.env.local 文件,修改.env.local 里内容才是有效的变量。变量说明见 .env.template,主要需要修改API_KEY和数据库的地址与端口以及数据库账号的用户名和密码,具体配置需要和docker配置文件相同,其中用户名和密码如需修改需要修改docker配置文件、数据库和.env.local文件,不能只改一处。

2. config 配置文件

复制 data/config.json 文件,生成一个 data/config.local.json 配置文件,具体配置参数说明,可参考 config 配置说明

注意:json 配置文件不能包含注释,介绍中为了方便看才加入的注释

这个文件大部分时候不需要修改。只需要关注 systemEnv 里的参数:

vectorMaxProcess: 向量生成最大进程,根据数据库和 key 的并发数来决定,通常单个 120 号,2c4g 服务器设置 10~15。qaMaxProcess: QA 生成最大进程pgHNSWEfSearch: PostgreSQL vector 索引参数,越大搜索精度越高但是速度越慢,具体可看 pgvector 官方说明。可参考项目根目录下的 dev.md,第一次编译运行可能会有点慢,需要点耐心哦

+ # 给自动化脚本代码执行权限(非 linux 系统, 可以手动执行里面的 postinstall.sh 文件内容)

+chmod -R +x ./scripts/

+# 代码根目录下执行,会安装根 package、projects 和 packages 内所有依赖

+# 如果提示 isolate-vm 安装失败,可以参考:https://github.com/laverdet/isolated-vm?tab=readme-ov-file#requirements

+pnpm i

+

+# 非 Make 运行

+cd projects/app

+pnpm dev

+

+# Make 运行

+make dev name=app

+

+ # Docker cmd: Build image, not proxy

+docker build -f ./projects/app/Dockerfile -t registry.cn-hangzhou.aliyuncs.com/fastgpt/fastgpt:v4.8.1 . --build-arg name=app

+# Make cmd: Build image, not proxy

+make build name=app image=registry.cn-hangzhou.aliyuncs.com/fastgpt/fastgpt:v4.8.1

+

+# Docker cmd: Build image with proxy

+docker build -f ./projects/app/Dockerfile -t registry.cn-hangzhou.aliyuncs.com/fastgpt/fastgpt:v4.8.1 . --build-arg name=app --build-arg proxy=taobao

+# Make cmd: Build image with proxy

+make build name=app image=registry.cn-hangzhou.aliyuncs.com/fastgpt/fastgpt:v4.8.1 proxy=taobao

+ 如果不使用 docker 打包,需要手动把 Dockerfile 里 run 阶段的内容全部手动执行一遍(非常不推荐)。

如果遇到问题,比如合并冲突或不知道如何打开拉取请求,请查看 GitHub 的拉取请求教程,了解如何解决合并冲突和其他问题。一旦您的 PR 被合并,您将自豪地被列为贡献者表中的一员。

host改成localhost或127.0.0.1directConnection=true 参数,才能连接上副本集的数据库。mongocompass客户端进行连接测试和可视化管理。navicat进行连接和管理。FastGPT 在pnpm i后会执行postinstall脚本,用于自动生成ChakraUI的Type。如果没有权限,可以先执行chmod -R +x ./scripts/,再执行pnpm i。

仍不可行的话,可以手动执行./scripts/postinstall.sh里的内容。

+如果是Windows下的话,可以使用git bash给postinstall脚本添加执行权限并执行sh脚本

删除所有的node_modules,用 Node18 重新 install 试试,可能最新的 Node 有问题。 本地开发流程:

pnpm iconfig.json -> config.local.json.env.template -> .env.localcd projects/apppnpm dev这个错误可能是之前停止容器时有文件残留导致的,首先需要确认相关镜像都全部关闭,然后手动删除相关文件或者重启docker即可

遇到困难了吗?有任何问题吗? 加入飞书群与开发者和用户保持沟通。

FastGPT 使用了 nextjs 的 page route 作为框架。为了区分好前后端代码,在目录分配上会分成 global, service, web 3个自目录,分别对应着 前后端共用、后端专用、前端专用的代码。

FastGPT 采用 pnpm workspace 方式构建 monorepo 项目,主要分为两个部分:

FastGPT 在代码模块划分时,按DDD的思想进行划分,主要分为以下几个领域:

core - 核心功能(知识库,工作流,应用,对话) +support - 支撑功能(用户体系,计费,鉴权等) +common - 基础功能(日志管理,文件读写等)

.

+├── .github // github 相关配置

+├── .husky // 格式化配置

+├── docSite // 文档

+├── files // 一些外部文件,例如 docker-compose, helm

+├── packages // 子包

+│ ├── global // 前后端通用子包

+│ ├── plugins // 工作流插件(需要自定义包时候使用到)

+│ ├── service // 后端子包

+│ └── web // 前端子包

+├── projects

+│ └── app // FastGPT 主项目

+├── python // 存放一些模型代码,和 FastGPT 本身无关

+└── scripts // 一些自动化脚本

+ ├── icon // icon预览脚本,可以在顶层 pnpm initIcon(把svg写入到代码中), pnpm previewIcon(预览icon)

+ └── postinstall.sh // chakraUI自定义theme初始化 ts 类型

+├── package.json // 顶层monorepo

+├── pnpm-lock.yaml

+├── pnpm-workspace.yaml // monorepo 声明

+├── Dockerfile

+├── LICENSE

+├── README.md

+├── README_en.md

+├── README_ja.md

+├── dev.md

+FastGPT Docker 数据库备份和迁移

Docker 部署数据库都会通过 volume 挂载本地的目录进入容器,如果要迁移,直接复制这些目录即可。

PG 数据: pg/data

+Mongo 数据: mongo/data

FastGPT Docker Mongo迁移

如何使用Mongodump来完成从A环境到B环境的Fastgpt的mongodb迁移

前提说明:

A环境:我在阿里云上部署的fastgpt,现在需要迁移到B环境。 +B环境:是新环境比如腾讯云新部署的fastgpt,更特殊一点的是,NAS(群晖或者QNAP)部署了fastgpt,mongo必须改成4.2或者4.4版本(其实云端更方便,支持fastgpt mongo默认版本) +C环境:妥善考虑,用本地电脑作为C环境过渡,保存相关文件并分离操作 +

+ docker exec -it mongo sh

+mongo -u 'username' -p 'password'

+>> show dbs

+ 看到fastgpt数据库,以及其它几个,确定下导出数据库名称 +准备: +检查数据库,容器和宿主机都创建一下 backup 目录 【A环境 + C环境】

检查数据库,容器和宿主机都创建一下“数据导出导入”临时目录 ,比如data/backup 【A环境建目录 + C环境建目录用于同步到容器中】

容器:(先进入fastgpt docker容器)

+ docker exec -it fastgpt sh

+mkdir -p /data/backup

+ 建好后,未来导出mongo的数据,会在A环境本地fastgpt的安装目录/Data/下看到自动同步好的目录,数据会在data\backup中,然后可以衔接后续的压缩和下载转移动作。如果没有同步到本地,也可以手动建一下,配合docker cp 把文件拷到本地用(基本不会发生)

到fastgpt目录,进入mongo目录,有data目录,下面建backup

+ mkdir -p /fastgpt/data/backup

+ 准备好后,后续上传

+ ### 新fastgpt环境【B】中也需要建一个,比如/fastgpt/mongobackup目录,注意不要在fastgpt/data目录下建立目录

+ mkdir -p /fastgpt/mongobackup

+

+###2. 正题开始,从fastgpt老环境【A】中导出数据

+进入A环境,使用mongodump 导出mongo数据库。

+

+#### 2.1 导出

+可以使用mongodump在源头容器中导出数据文件, 导出路径为上面指定临时目录,即"data\backup"

+

+[导出的文件在代码中指定为/data/backup,因为fastgpt配置文件已经建立了data的持久化,所以会同步到容器所在环境本地fast/mongo/data应该就能看到这个导出的目录:backup,里面有文件]

+

+一行指令导出代码,在服务器本地环境运行,不需要进入容器。

+ docker exec -it mongo bash -c “mongodump –db fastgpt -u ‘username’ -p ‘password’ –authenticationDatabase admin –out /data/backup”

+

+也可以进入环境,熟手可以结合建目录,一次性完成建导出目录,以及使用mongodump导出数据到该目录

+ 1.docker exec -it fastgpt sh

2.mkdir -p /data/backup

+ docker cp mongo:/data/backup <A环境本地fastgpt目录>:/fastgpt/data/backup>

+```

+

+2.2 对新手,建议稳妥起见,压缩这个文件目录,并将压缩文件下载到本地过渡环境【A环境 -> C环境】;原因是因为留存一份,并且检查文件数量是否一致。

+

+ 熟手可以直接复制到新部署服务器(腾讯云或者NAS)【A环境-> B环境】

+

+

+2.2.1 先进入 【A环境】源头系统的本地环境 fastgpt/mongo/data 目录

+ cd /usr/fastgpt/mongo/data

+

+#执行,压缩文件命令

+ tar -czvf ../fastgpt-mongo-backup-$(date +%Y-%m-%d).tar.gz ./ 【A环境】

+ #接下来,把压缩包下载到本地 【A环境-> C环境】,以便于检查和留存版本。熟手,直接将该压缩包同步到B环境中新fastgpt目录data目录下备用。

+ scp -i /Users/path/<user.pem换成你自己的pem文件链接> root@<fastgpt所在云服务器地址>:/usr/fastgpt/mongo/fastgptbackup-2024-05-03.tar.gz /<本地电脑路径>/Downloads/fastgpt

+ 熟手直接换成新环境地址

+

+ scp -i /Users/path/<user.pem换成你自己的pem文件链接> root@<老环境fastgpt服务器地址>:/usr/fastgpt/mongo/fastgptbackup-2024-05-03.tar.gz root@<新环境fastgpt服务器地址>:/Downloads/fastgpt2

+

+2.2 【C环境】检查压缩文件是否完整,如果不完整,重新导出。事实上,我也出现过问题,因为跨环境scp会出现丢数据的情况。

+

+压缩数据包导入到C环境本地后,可以考虑在宿主机目录解压缩,放在一个自定义目录比如. < user/fastgpt/mongobackup/data>

+ tar -xvzf fastgptbackup-2024-05-03.tar.gz -C user/fastgpt/mongobackup/data

+ 解压缩后里面是bson文件,这里可以检查下,压缩文件数量是否一致。如果不一致,后续启动新环境的fastgpt容器,也不会有任何数据。

+

+<img width="1561" alt="image" src="https://github.com/labring/FastGPT/assets/103937568/cbb8a93c-5834-4a0d-be6c-c45c701f593e">

+

+

+如果没问题,准备进入下一步,将压缩包文件上传到B环境,也就是新fastgpt环境里的指定目录,比如/fastgpt/mongobackup, 注意不要放到fastgpt/data目录下,因为下面会先清空一次这个目录,否则导入会报错。

+ scp -rfv <本地电脑路径>/Downloads/fastgpt/fastgptbackup-2024-05-03.tar.gz root@<新环境fastgpt服务器地址>:/Downloads/fastgpt/backup

+

+## 3 导入恢复: 实际恢复和导入步骤

+

+### 3.1. 进入新fastgpt本地环境的安装目录后,找到迁移的压缩文件包fastgptbackup-2024-05-03.tar.gz,解压缩到指定目录

+ tar -xvzf fastgptbackup-2024-05-03.tar.gz -C user/fastgpt/mongobackup/data

+ 再次核对文件数量,和上面对比一下。

+

+熟手可以用tar指令检查文件完整性,上面是给新手准备的,便于比对核查。

+

+

+### 3.2 手动上传新fastgpt docker容器里备用 【C环境】

+说明:因为没有放在data里,所以不会自动同步到容器里。而且要确保容器的data目录被清理干净,否则导入时会报错。

+ docker cp user/fastgpt/mongobackup/data mongo:/tmp/backup +```

如果不是初始化的 mongo/db 目录, mongorestore 导入可能会报错。如果报错,建议尝试初始化mongo。

操作指令

+ cd /fastgpt安装目录/mongo/data

+rm -rf *

+

4.恢复: mongorestore 恢复 [C环境】 +简单一点,退回到本地环境,用 docker 命令一键导入,当然你也可以在容器里操作

+ docker exec -it mongo mongorestore -u "username" -p "password" --authenticationDatabase admin /tmp/backup/ --db fastgpt

+ 5.重启容器 【C环境】

+ docker compose restart

+docker logs -f mongo **强烈建议先检查mongo运行情况,在去做登录动作,如果mongo报错,访问web也会报错”

+ 如果mongo启动正常,显示的是类似这样的,而不是 “mongo is restarting”,后者就是错误

+

报错情况

+

FastGPT 迁移&备份

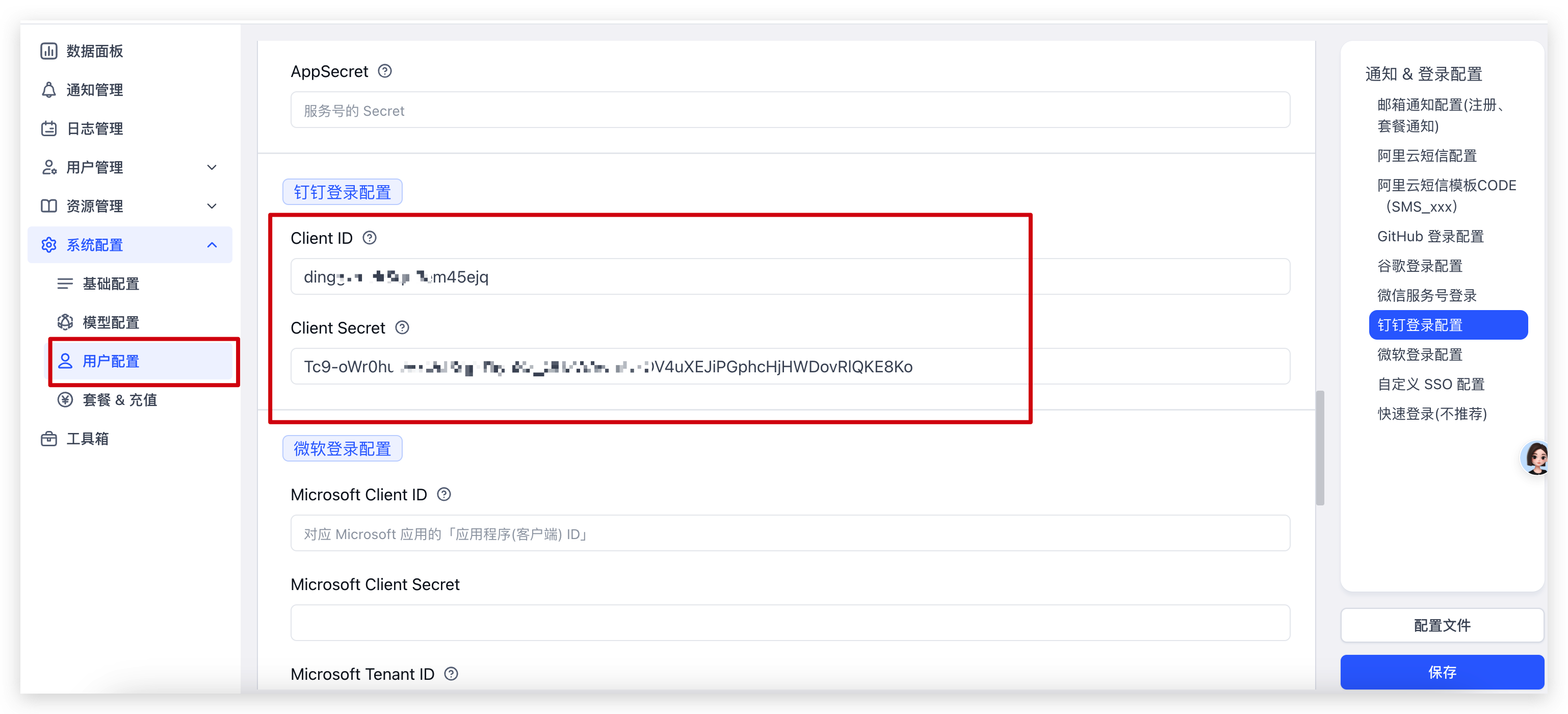

本模型配置方案

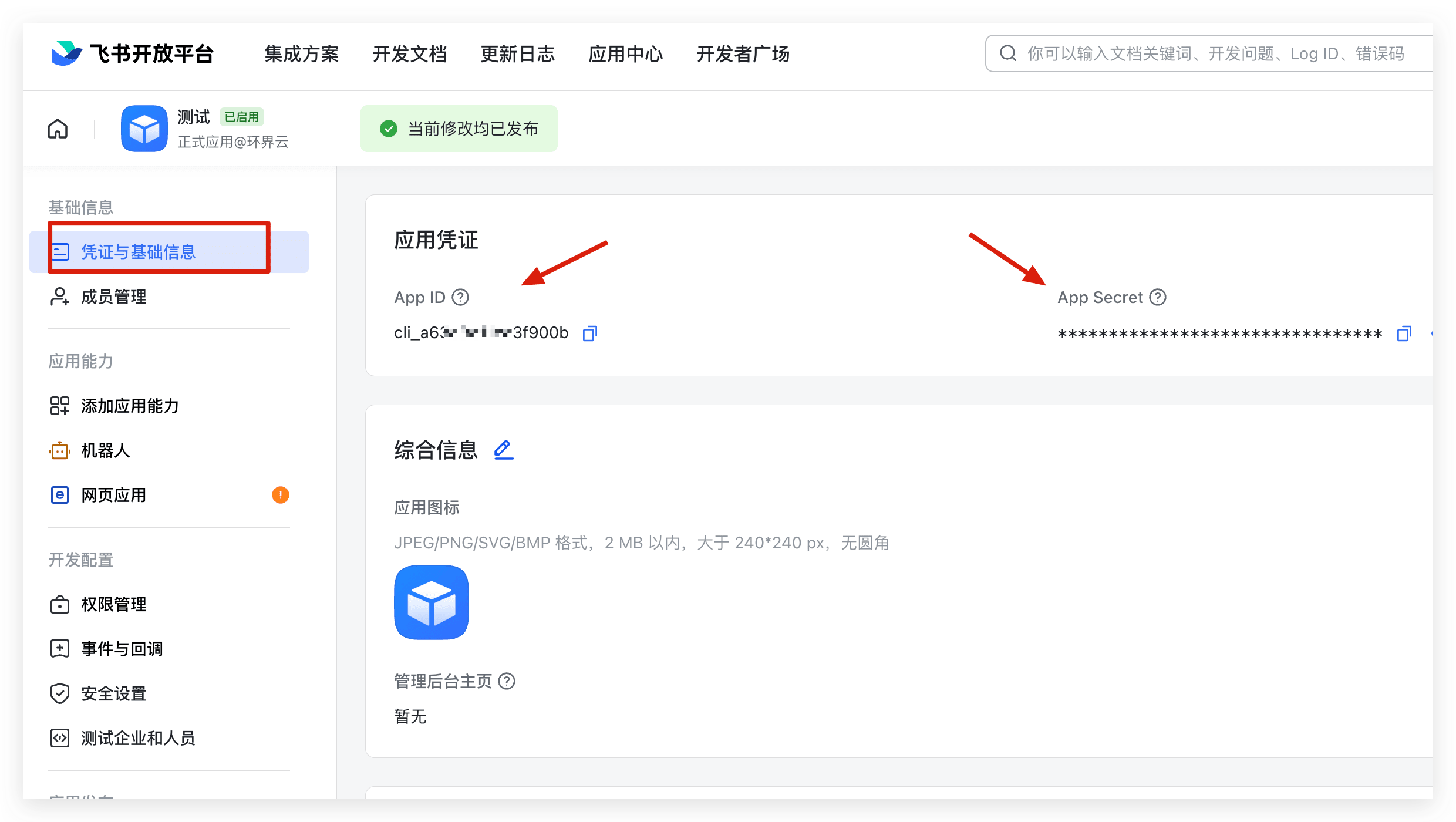

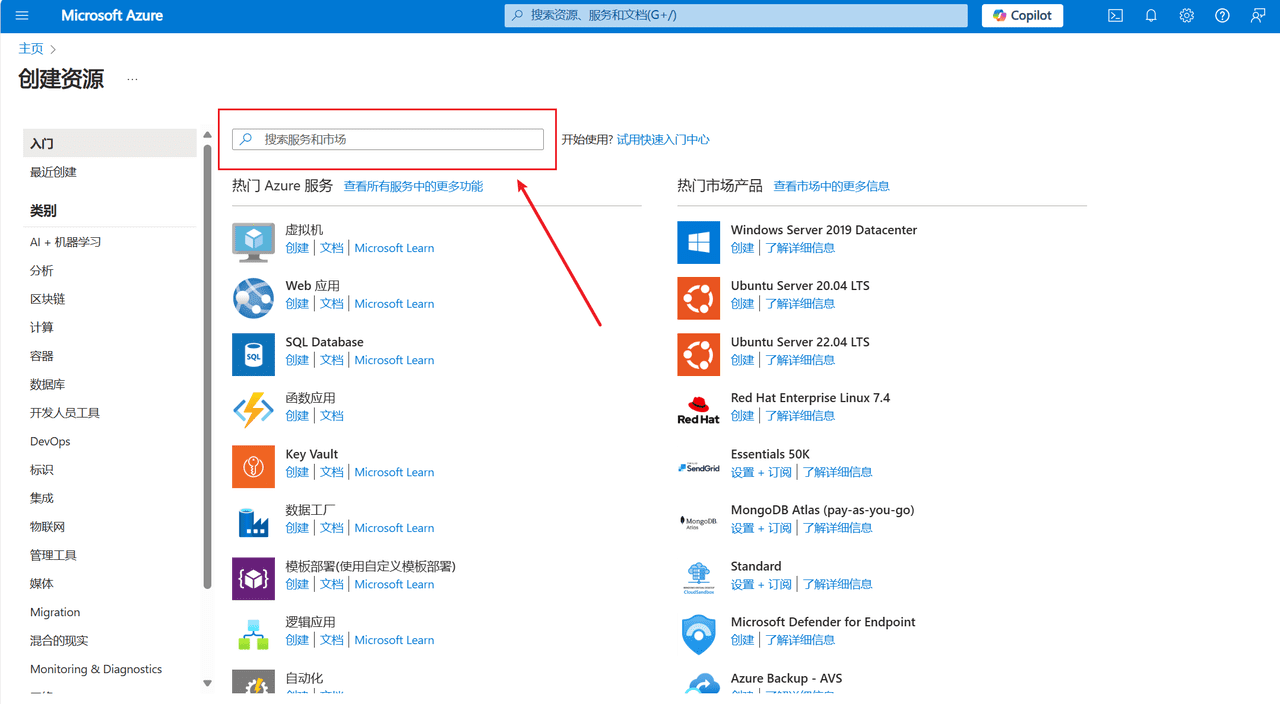

通过 OneAPI 接入模型

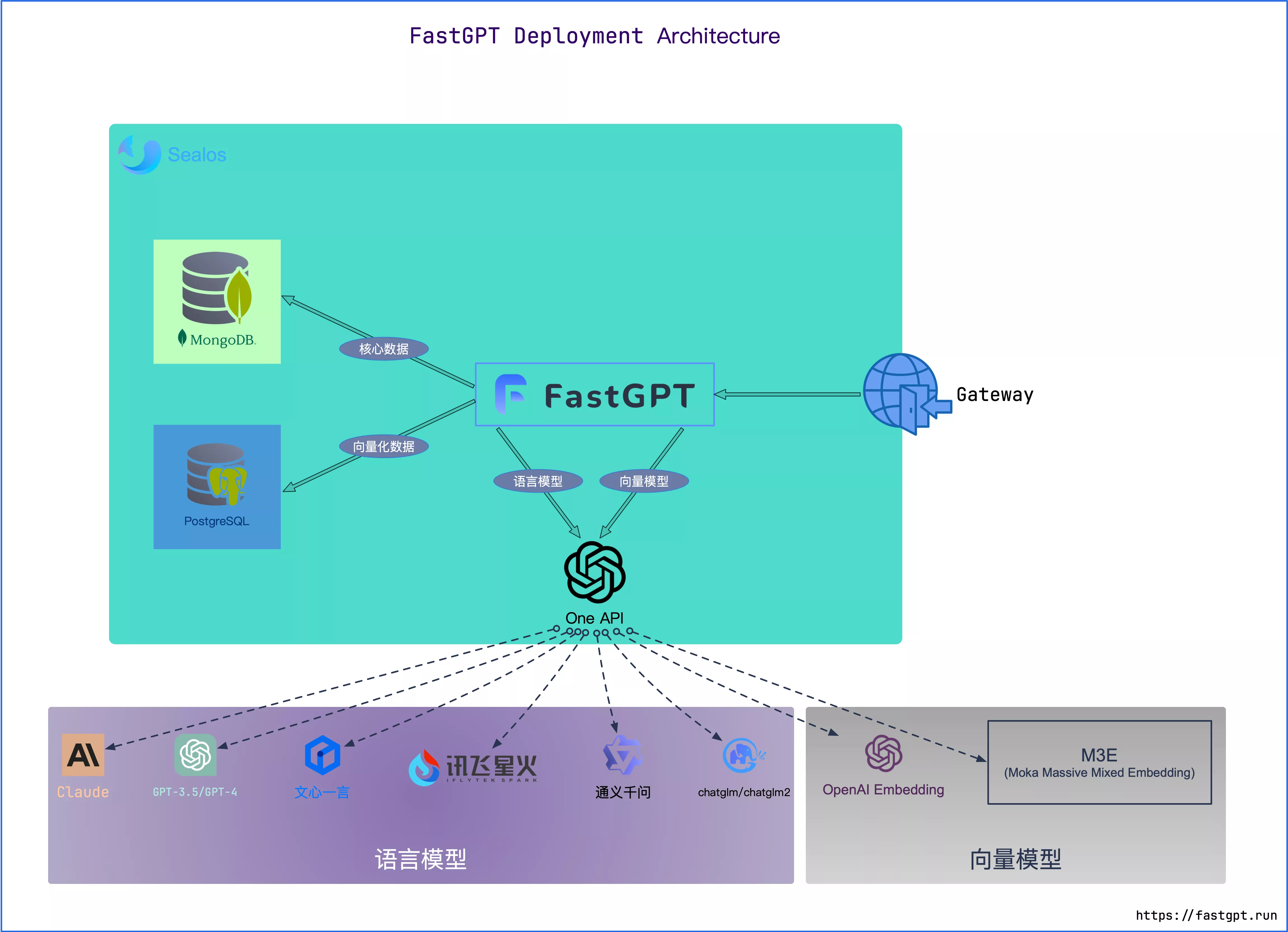

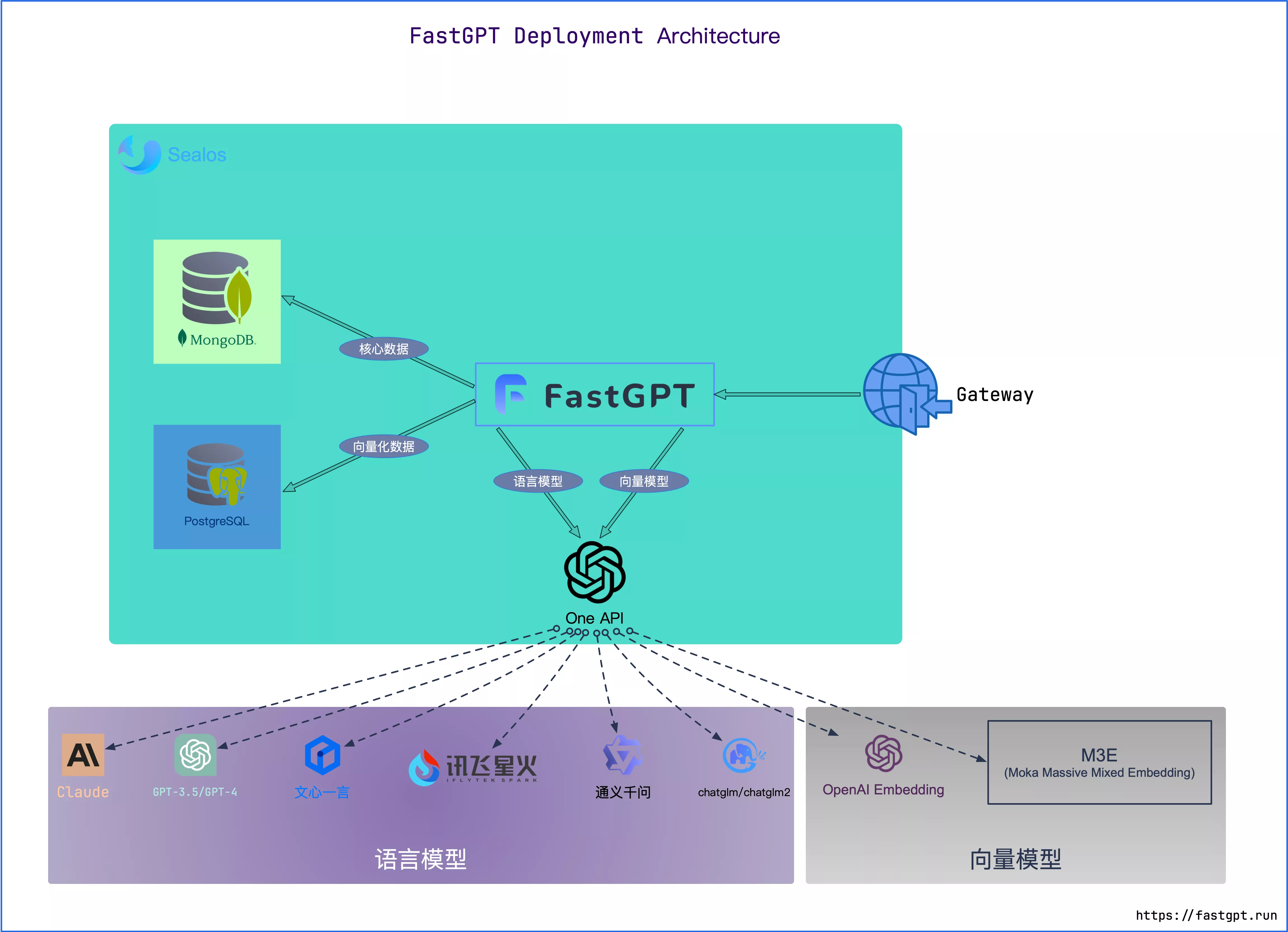

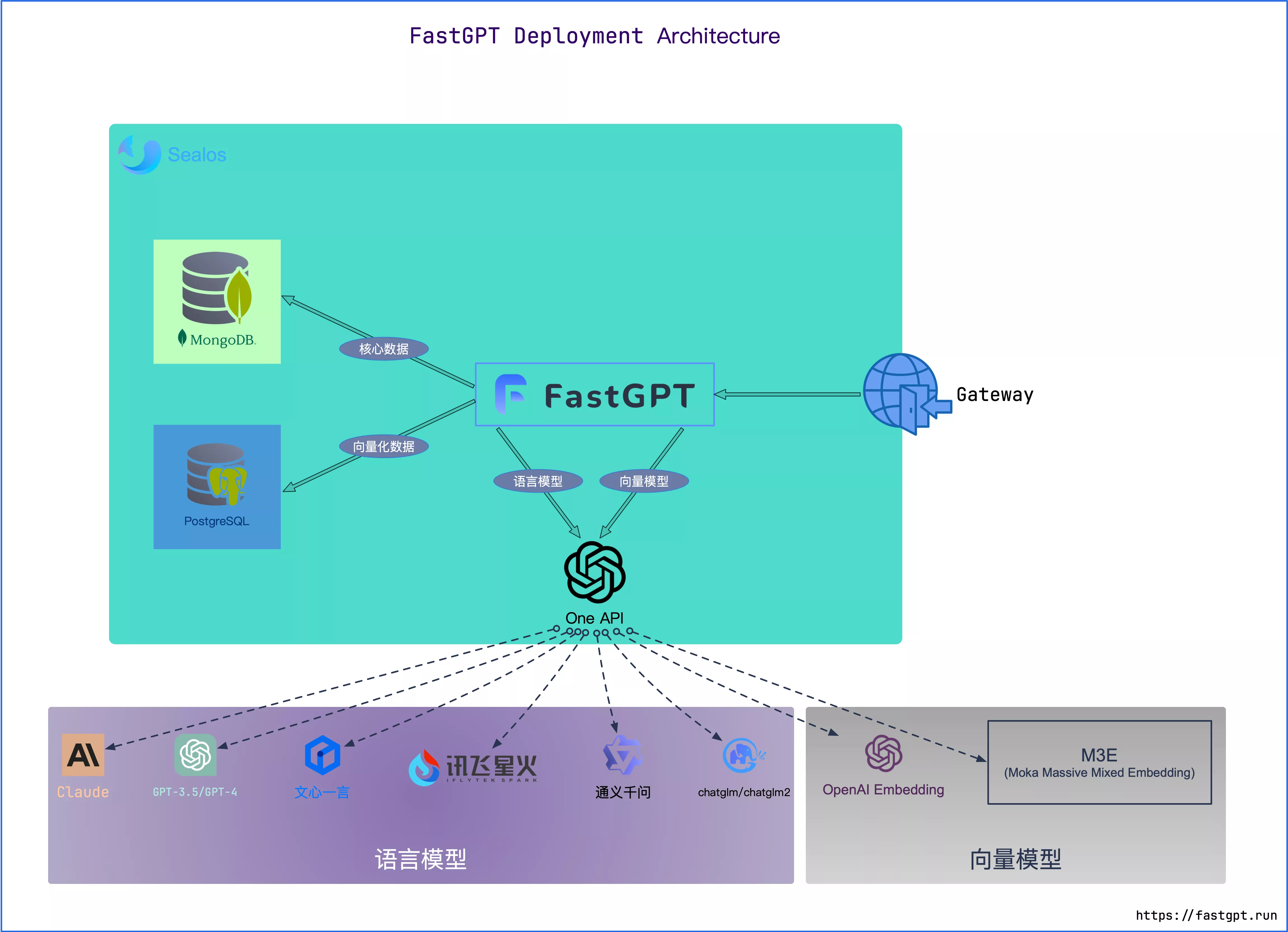

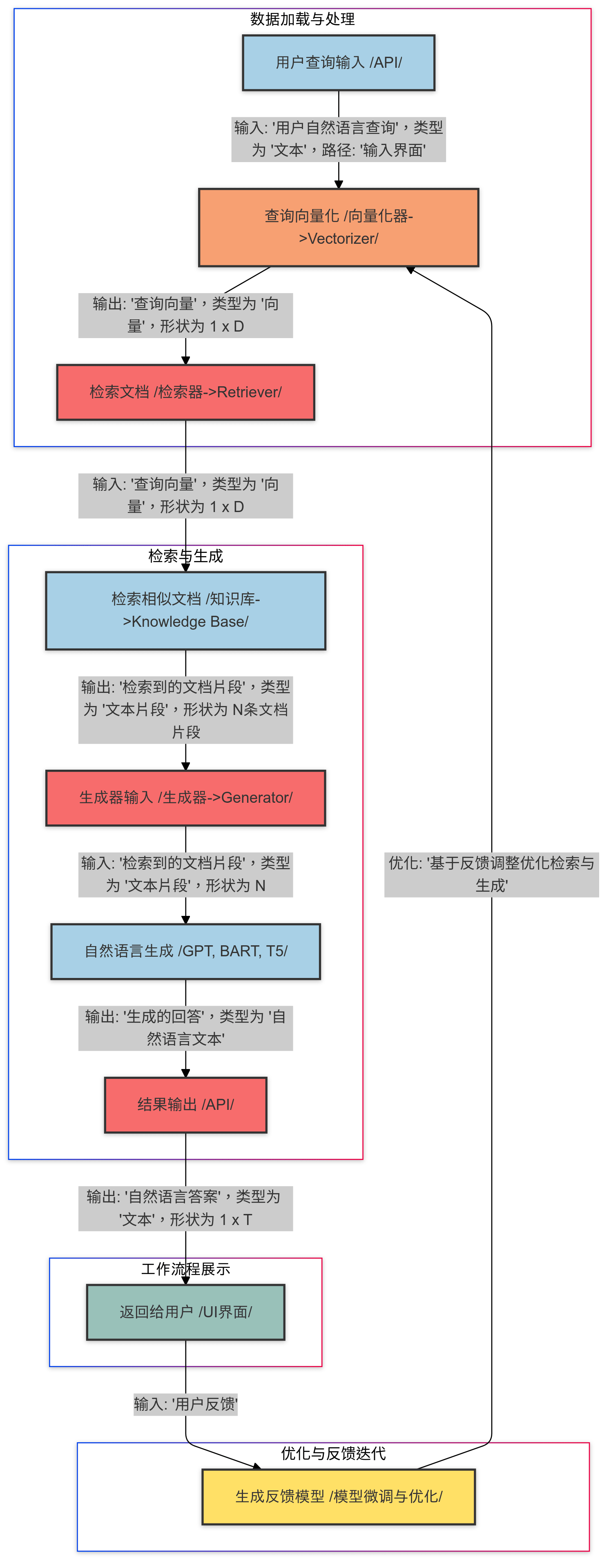

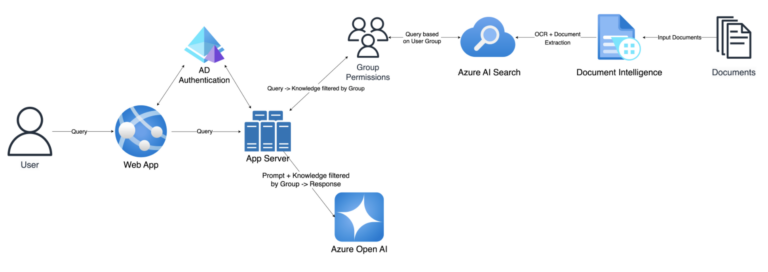

FastGPT 目前采用模型分离的部署方案,FastGPT 中只兼容 OpenAI 的模型规范(OpenAI 不存在的模型采用一个较为通用的规范),并通过 One API 来实现对不同模型接口的统一。

One API 是一个 OpenAI 接口管理 & 分发系统,可以通过标准的 OpenAI API 格式访问所有的大模型,开箱即用。

可以把 One API 当做一个网关,FastGPT 与 One API 关系:

docker-compose.yml 文件已加入了 OneAPI 配置,可直接使用。默认暴露在 3001 端口。

部署完后,可以打开 OneAPI 访问链接,进行下一步操作。

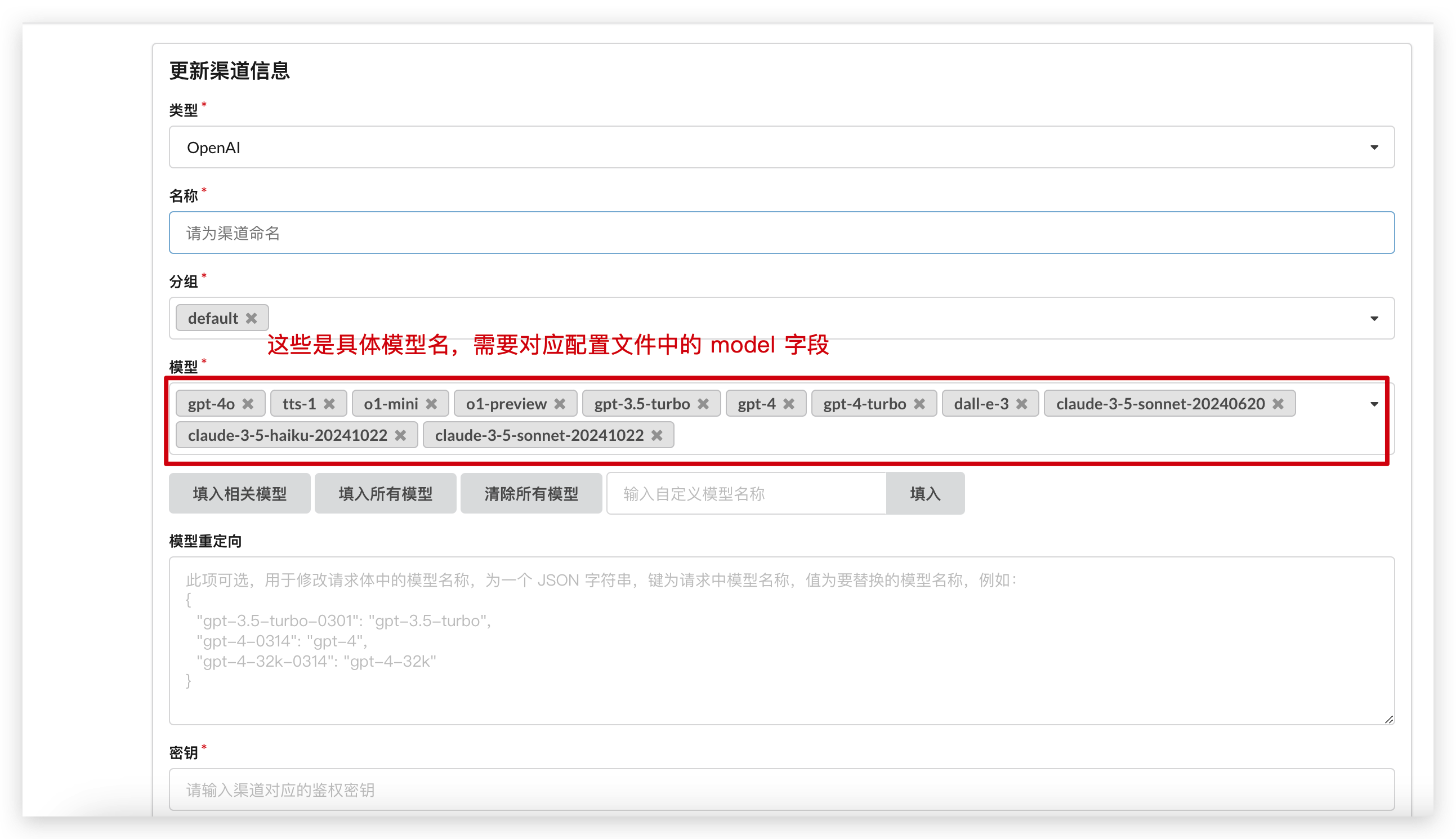

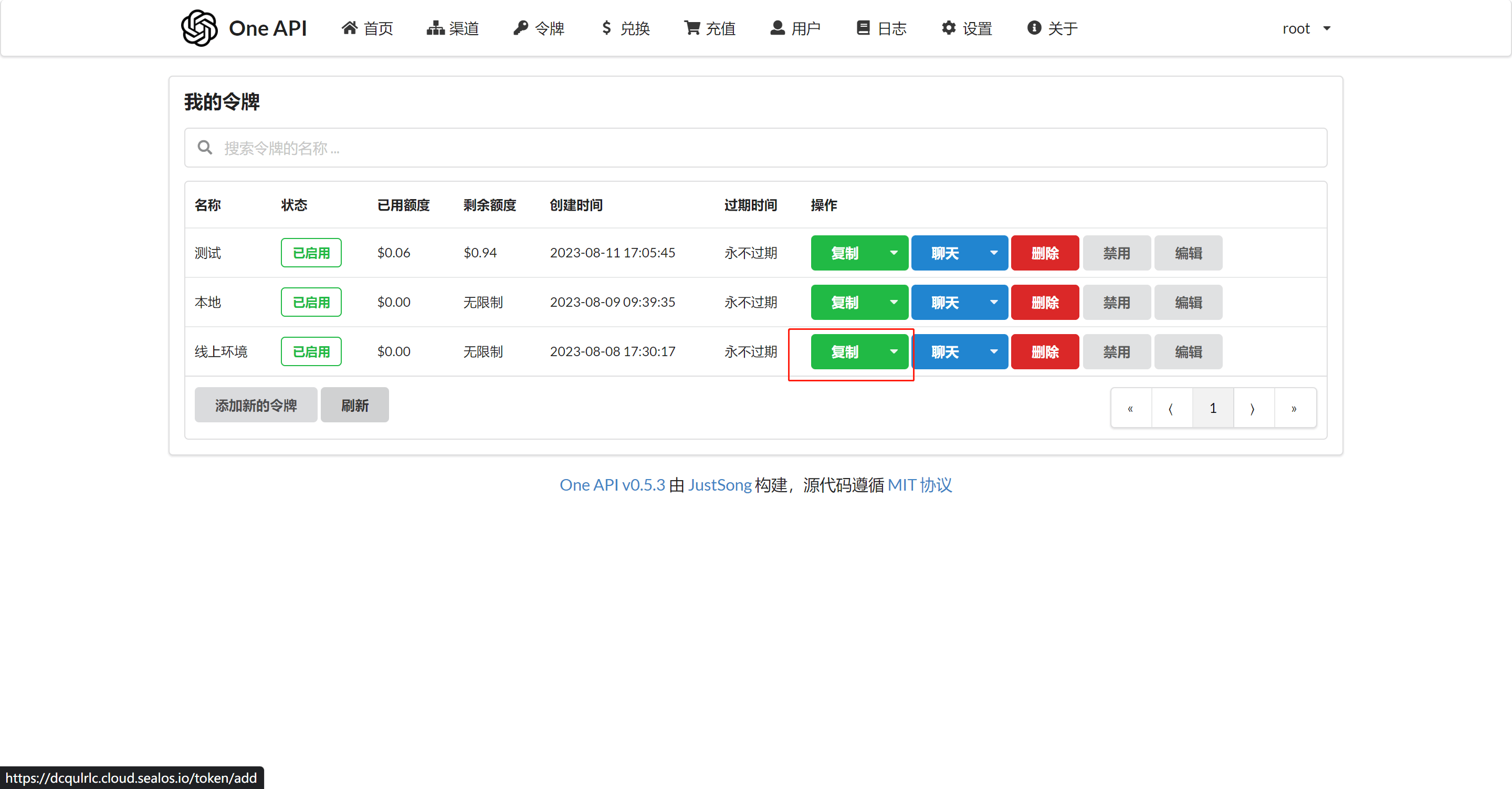

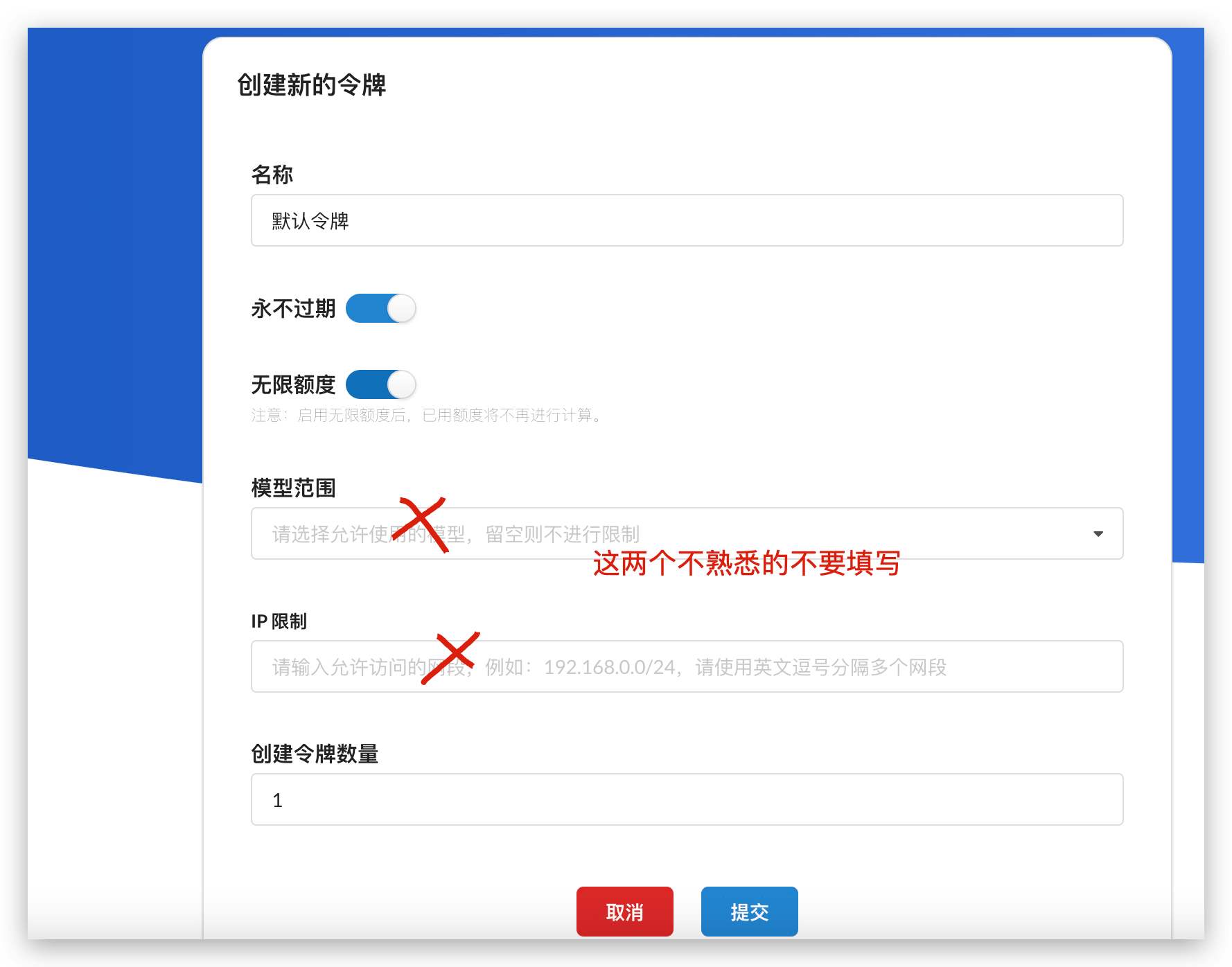

Api Key,这个 Api Key 可以是GPT、微软、ChatGLM、文心一言的。一个Api Key通常可以调用同一个厂商的多个模型。模型来决定使用哪一个渠道,如果一个模型对应了多个渠道,则会随机调用。1个凭证即可访问One API上配置的模型。因此FastGPT中,只需要配置One API的baseurl和令牌即可。令牌不要设置任何的模型范围权限,否则容易报错。

model 参数,匹配对应的渠道(根据渠道里的模型进行匹配,必须完全一致)。如果匹配到多个渠道,则随机选择一个(同优先级)。

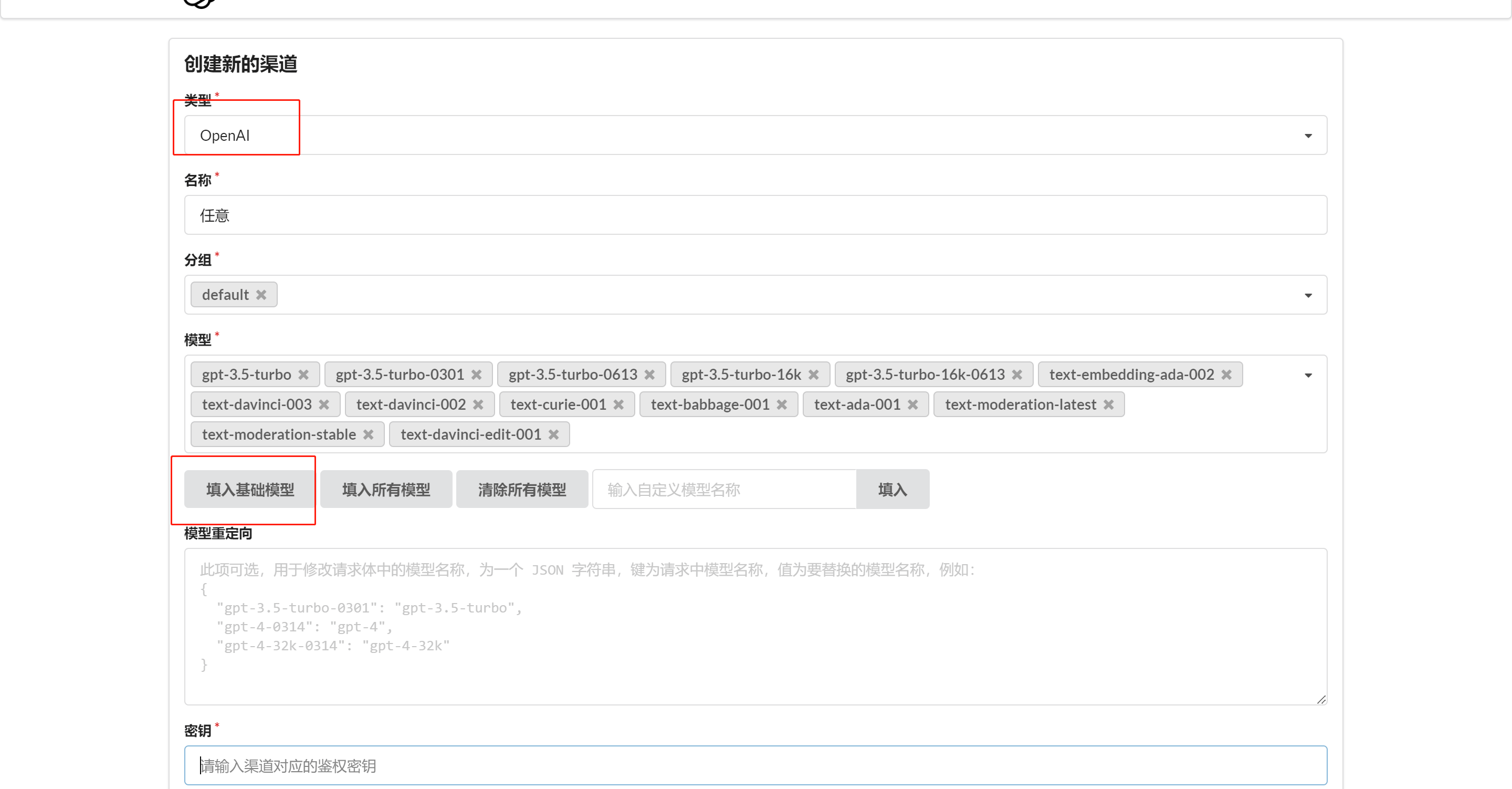

在 One API 中添加对应渠道,直接点击 【添加基础模型】,不要遗漏了向量模型(Embedding)

|  |

One API 默认 root 用户只有 200刀,可以自行修改编辑。

有了 One API 令牌后,FastGPT 可以通过修改 baseurl 和 key 去请求到 One API,再由 One API 去请求不同的模型。修改下面两个环境变量:

+ # 务必写上 v1。如果在同一个网络内,可改成内网地址。

+OPENAI_BASE_URL=https://xxxx.cloud.sealos.io/v1

+# 下面的 key 是由 One API 提供的令牌

+CHAT_API_KEY=sk-xxxxxx

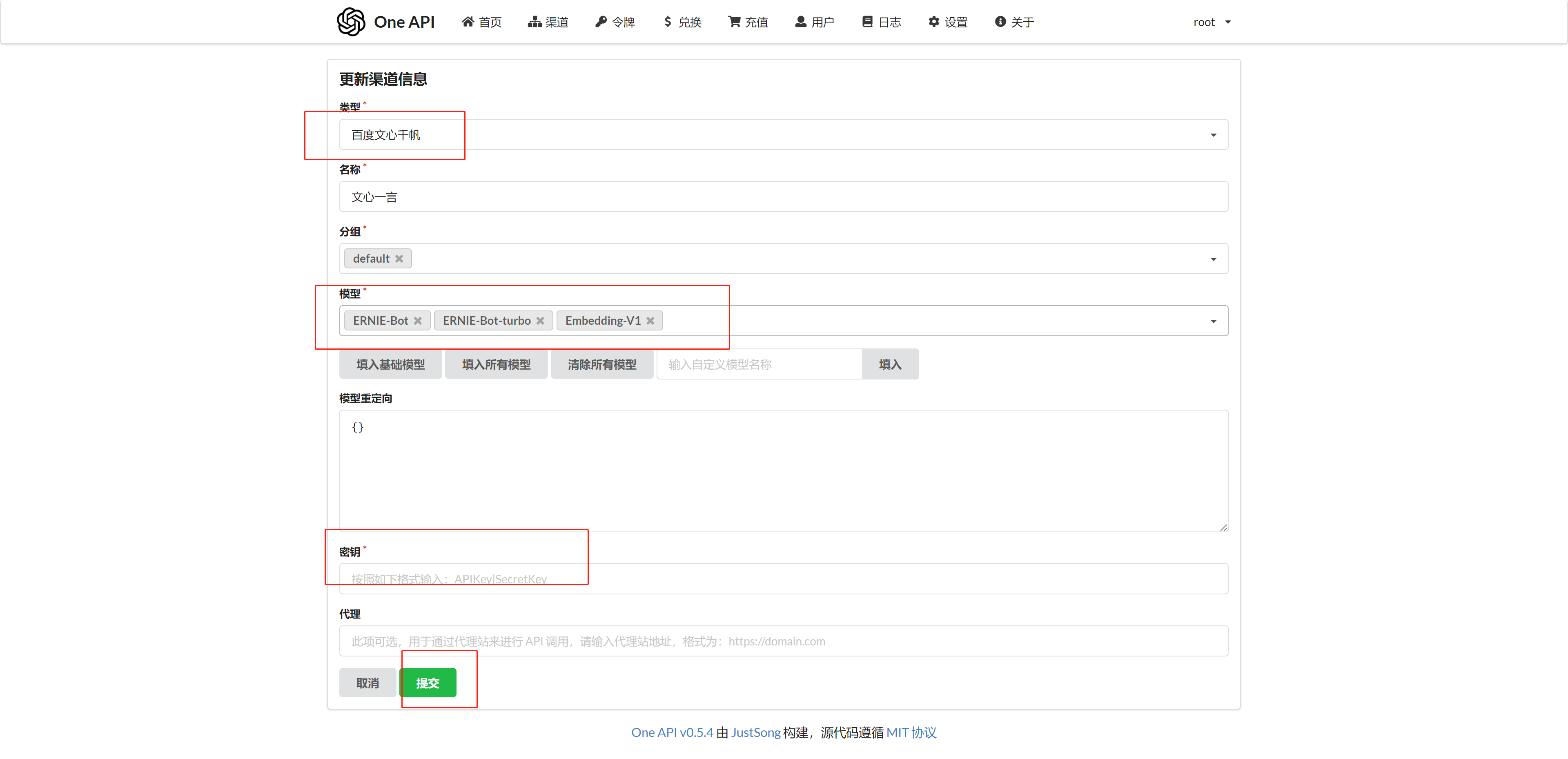

+ 以添加文心一言为例:

类型选择百度文心千帆。

可以在 /projects/app/src/data/config.json 里找到配置文件(本地开发需要复制成 config.local.json),按下面内容修改配置文件,最新/更具体的配置说明,可查看FastGPT 配置文件说明。

配置模型关键点在于model 需要与 OneAPI 渠道中的模型一致。

+ {

+ "llmModels": [ // 语言模型配置

+ {

+ "model": "ERNIE-Bot", // 这里的模型需要对应 One API 的模型

+ "name": "文心一言", // 对外展示的名称

+ "avatar": "/imgs/model/openai.svg", // 模型的logo

+ "maxContext": 16000, // 最大上下文

+ "maxResponse": 4000, // 最大回复

+ "quoteMaxToken": 13000, // 最大引用内容

+ "maxTemperature": 1.2, // 最大温度

+ "charsPointsPrice": 0,

+ "censor": false,

+ "vision": false, // 是否支持图片输入

+ "datasetProcess": true, // 是否设置为知识库处理模型

+ "usedInClassify": true, // 是否用于问题分类

+ "usedInExtractFields": true, // 是否用于字段提取

+ "usedInToolCall": true, // 是否用于工具调用

+ "usedInQueryExtension": true, // 是否用于问题优化

+ "toolChoice": true, // 是否支持工具选择

+ "functionCall": false, // 是否支持函数调用

+ "customCQPrompt": "", // 自定义文本分类提示词(不支持工具和函数调用的模型

+ "customExtractPrompt": "", // 自定义内容提取提示词

+ "defaultSystemChatPrompt": "", // 对话默认携带的系统提示词

+ "defaultConfig":{} // 请求API时,挟带一些默认配置(比如 GLM4 的 top_p)

+ }

+ ],

+ "vectorModels": [ // 向量模型配置

+ {

+ "model": "text-embedding-ada-002",

+ "name": "Embedding-2",

+ "avatar": "/imgs/model/openai.svg",

+ "charsPointsPrice": 0,

+ "defaultToken": 700,

+ "maxToken": 3000,

+ "weight": 100

+ },

+ ]

+}

+ Docker 版本

+ docker-compose down

+docker-compose up -d

+ Sealos 版本

直接找到 FastGPT 服务,点击重启即可。

这章介绍一些提供商接入 OneAPI 的教程,配置后不要忘记修改 FastGPT 配置文件。

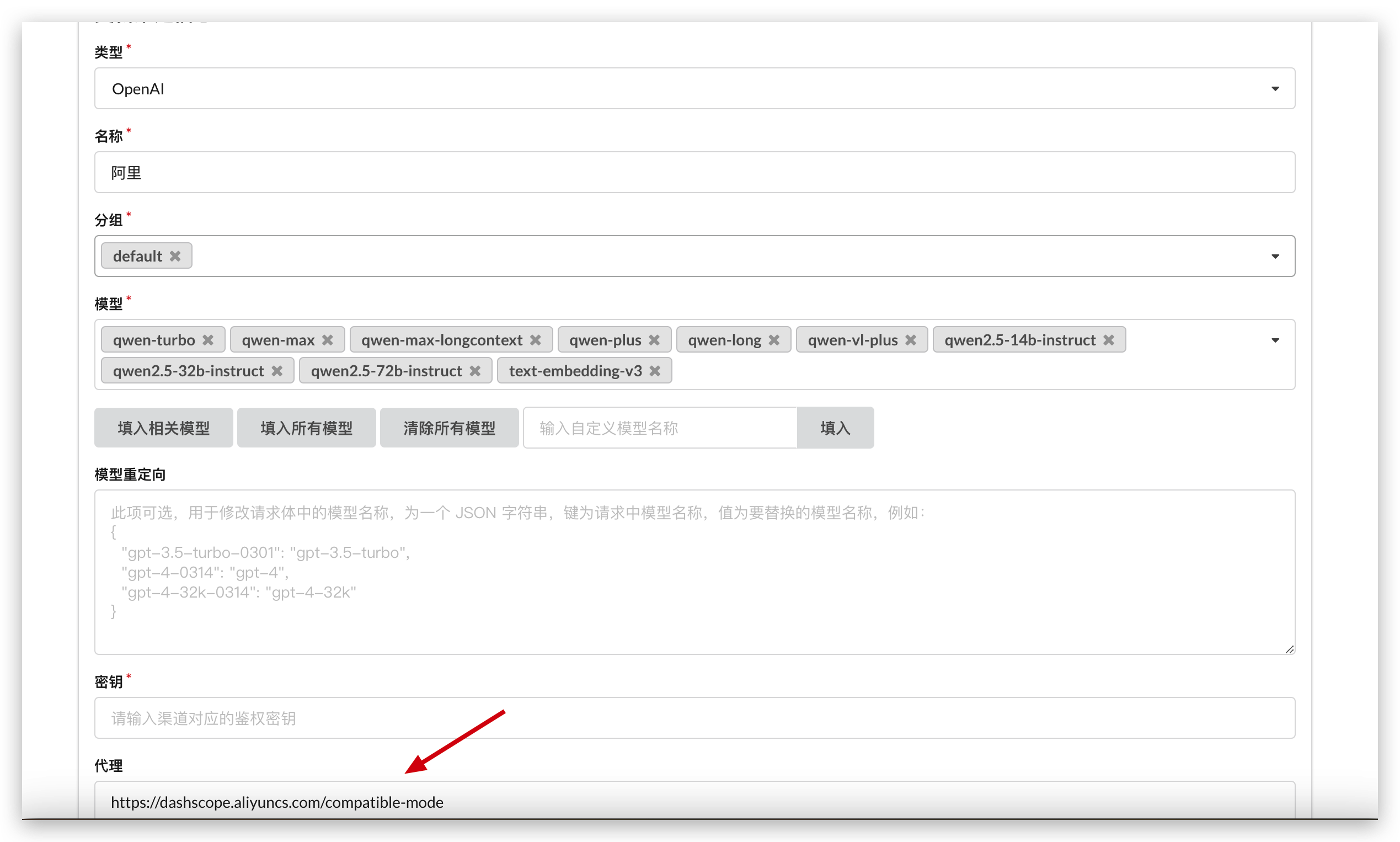

千问目前已经兼容 GPT 格式,可以直接选择 OpenAI 类型来接入即可。如下图,选择类型为OpenAI,代理填写阿里云的代理地址。

目前可以直接使用阿里云的语言模型和 text-embedding-v3 向量模型(实测已经归一化,可直接使用)

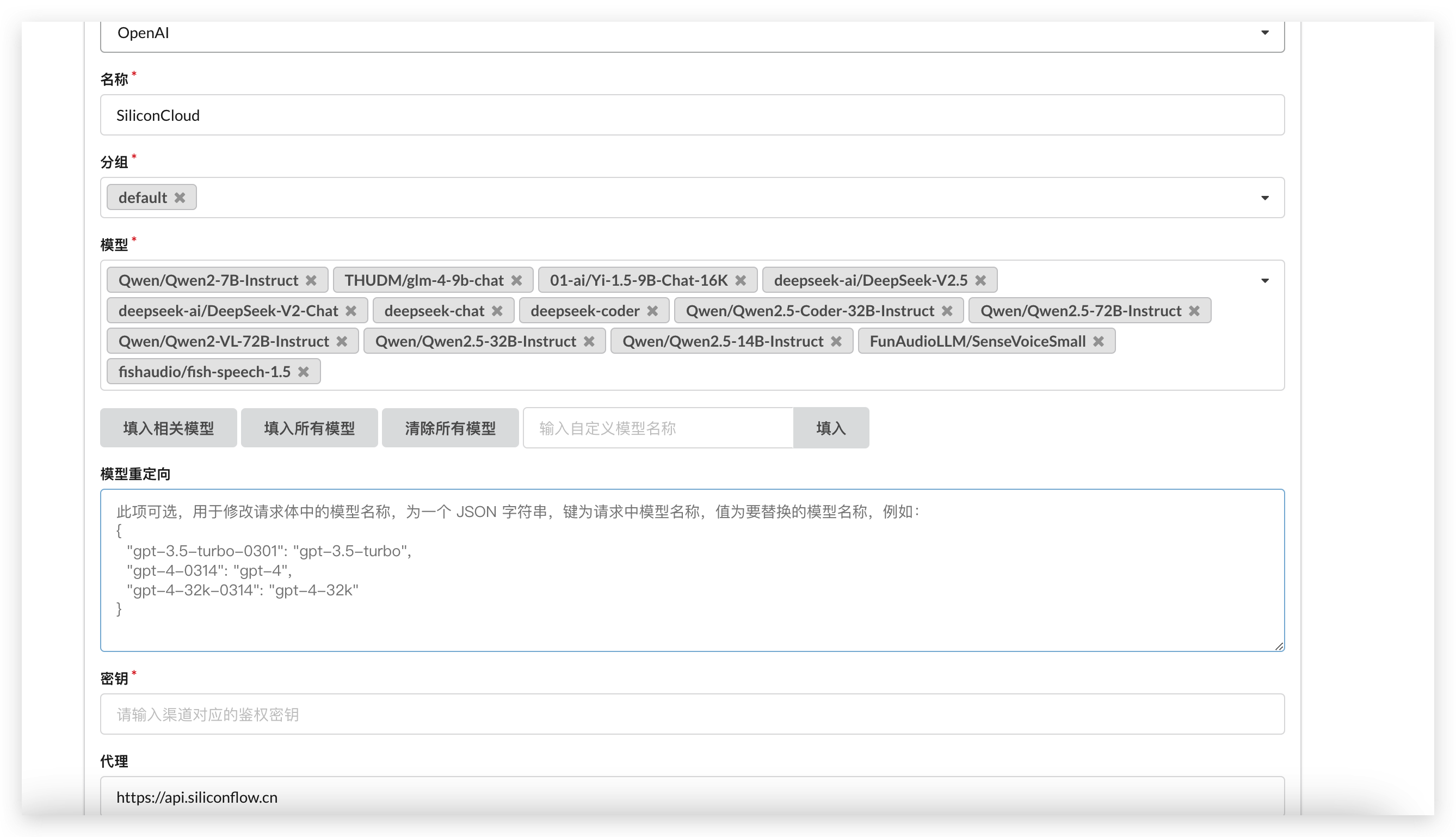

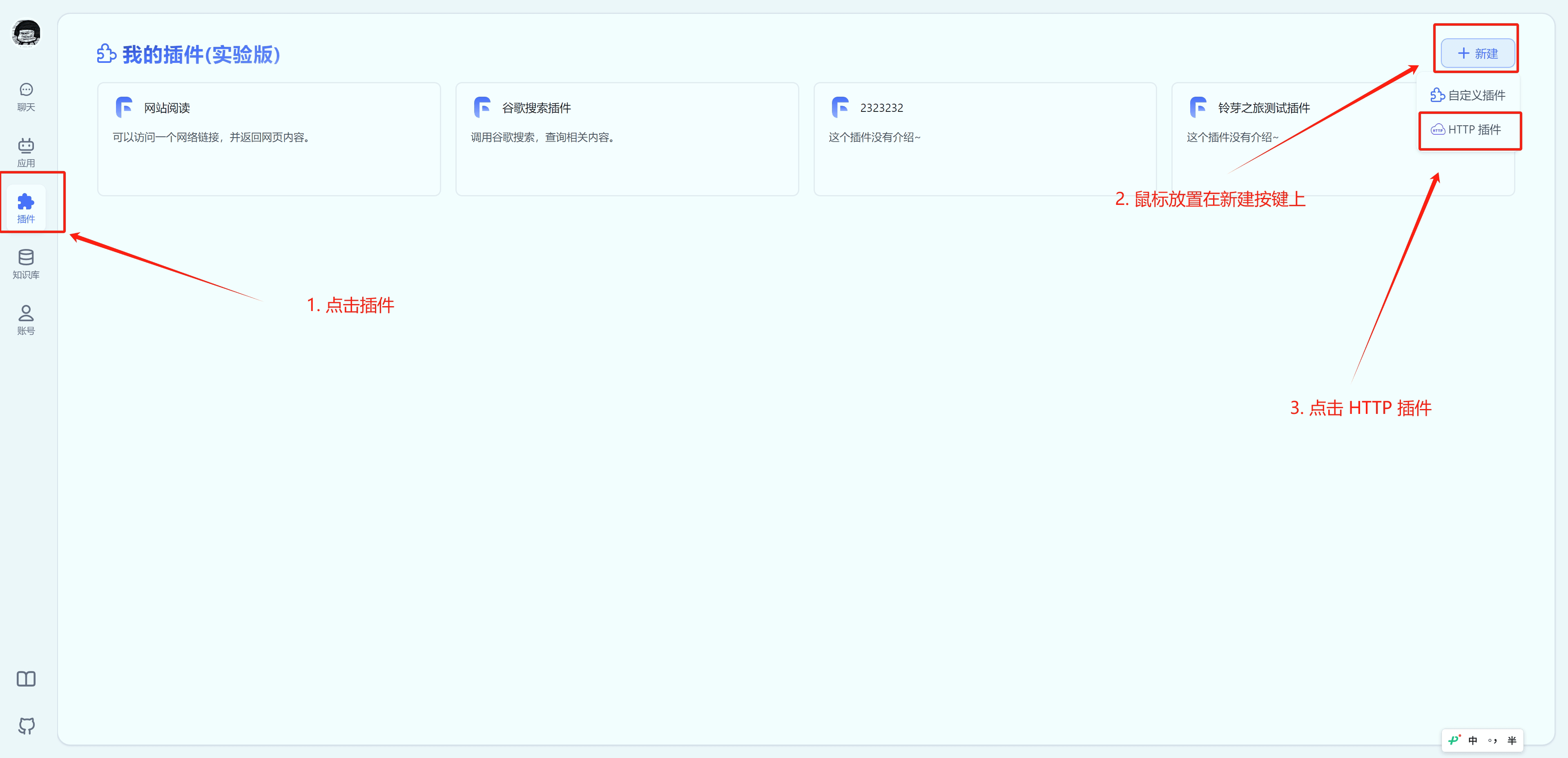

硅基流动 是一个专门提供开源模型调用平台,并拥有自己的加速引擎。模型覆盖面广,非常适合低成本来测试开源模型。接入教程:

OpenAI类型,代理填写:https://api.siliconflow.cn,密钥是第二步创建的密钥。

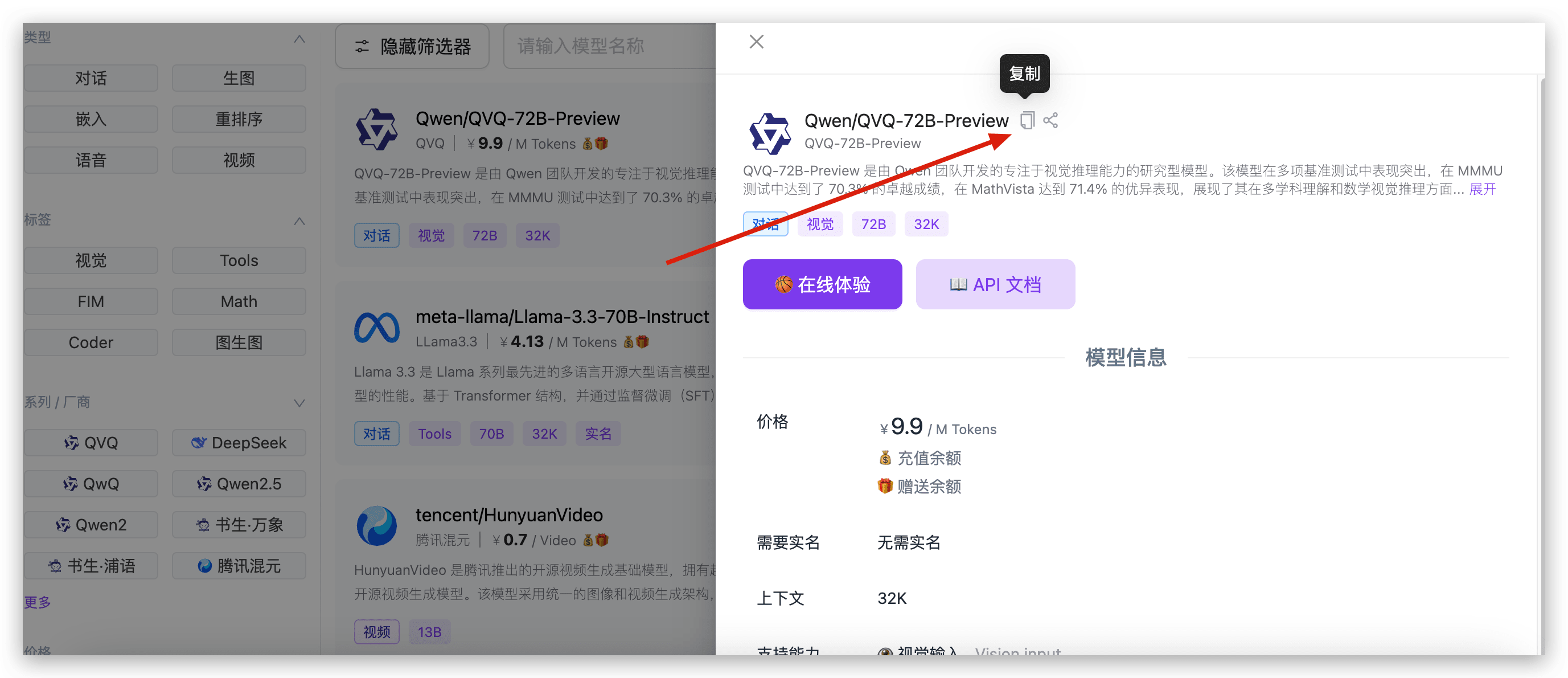

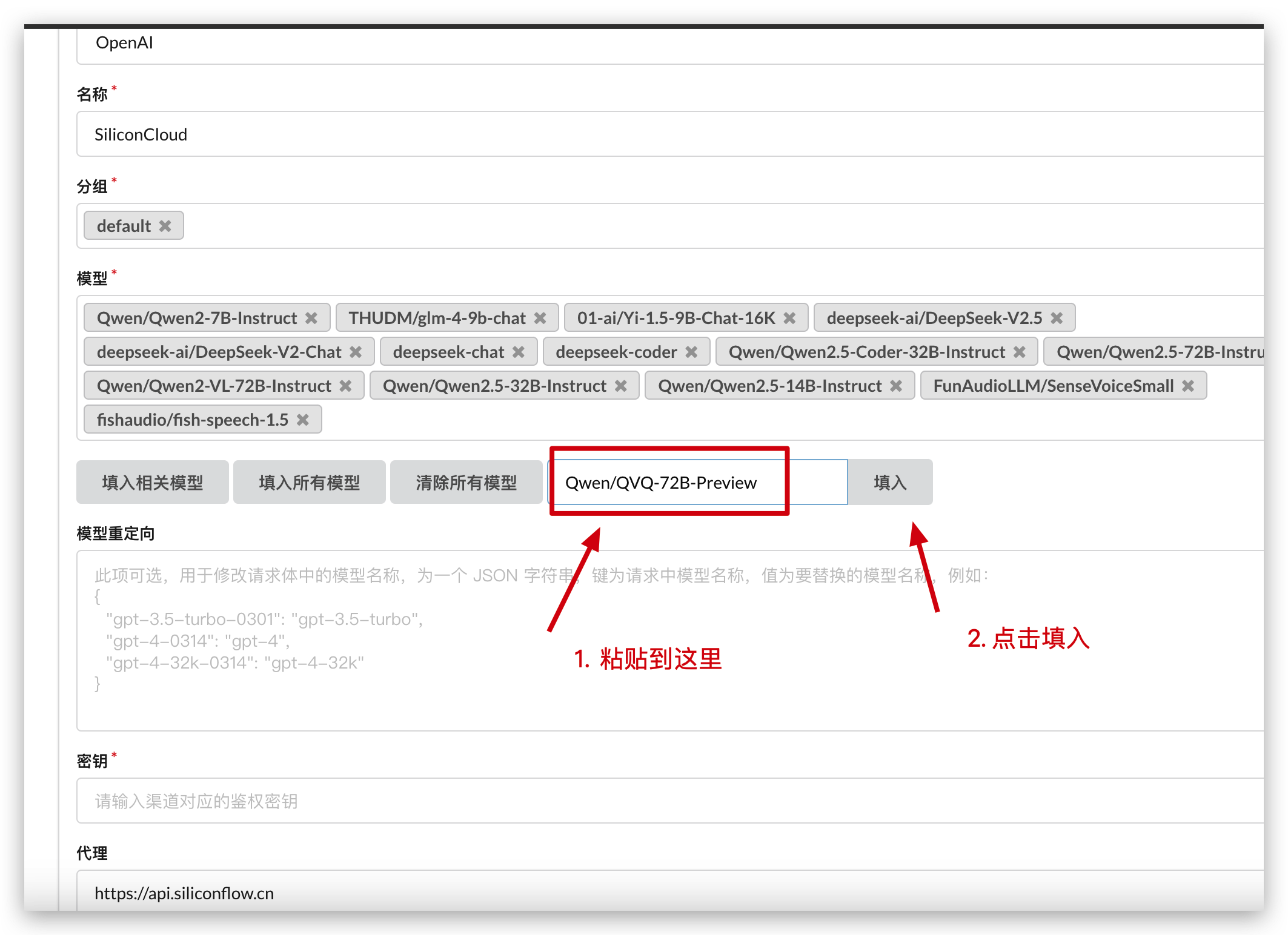

由于 OneAPI 未内置 硅基流动 的模型名,可以通过自定义模型名称来填入,下面是获取模型名称的教程:

|  |  |

通过 SiliconCloud 体验开源模型

SiliconCloud(硅基流动) 是一个以提供开源模型调用为主的平台,并拥有自己的加速引擎。帮助用户低成本、快速的进行开源模型的测试和使用。实际体验下来,他们家模型的速度和稳定性都非常不错,并且种类丰富,覆盖语言、向量、重排、TTS、STT、绘图、视频生成模型,可以满足 FastGPT 中所有模型需求。

如果你想部分模型使用 SiliconCloud 的模型,可额外参考OneAPI接入硅基流动。

本文会介绍完全使用 SiliconCloud 模型来部署 FastGPT 的方案。

+ OPENAI_BASE_URL=https://api.siliconflow.cn/v1

+# 填写 SiliconCloud 控制台提供的 Api Key

+CHAT_API_KEY=sk-xxxxxx

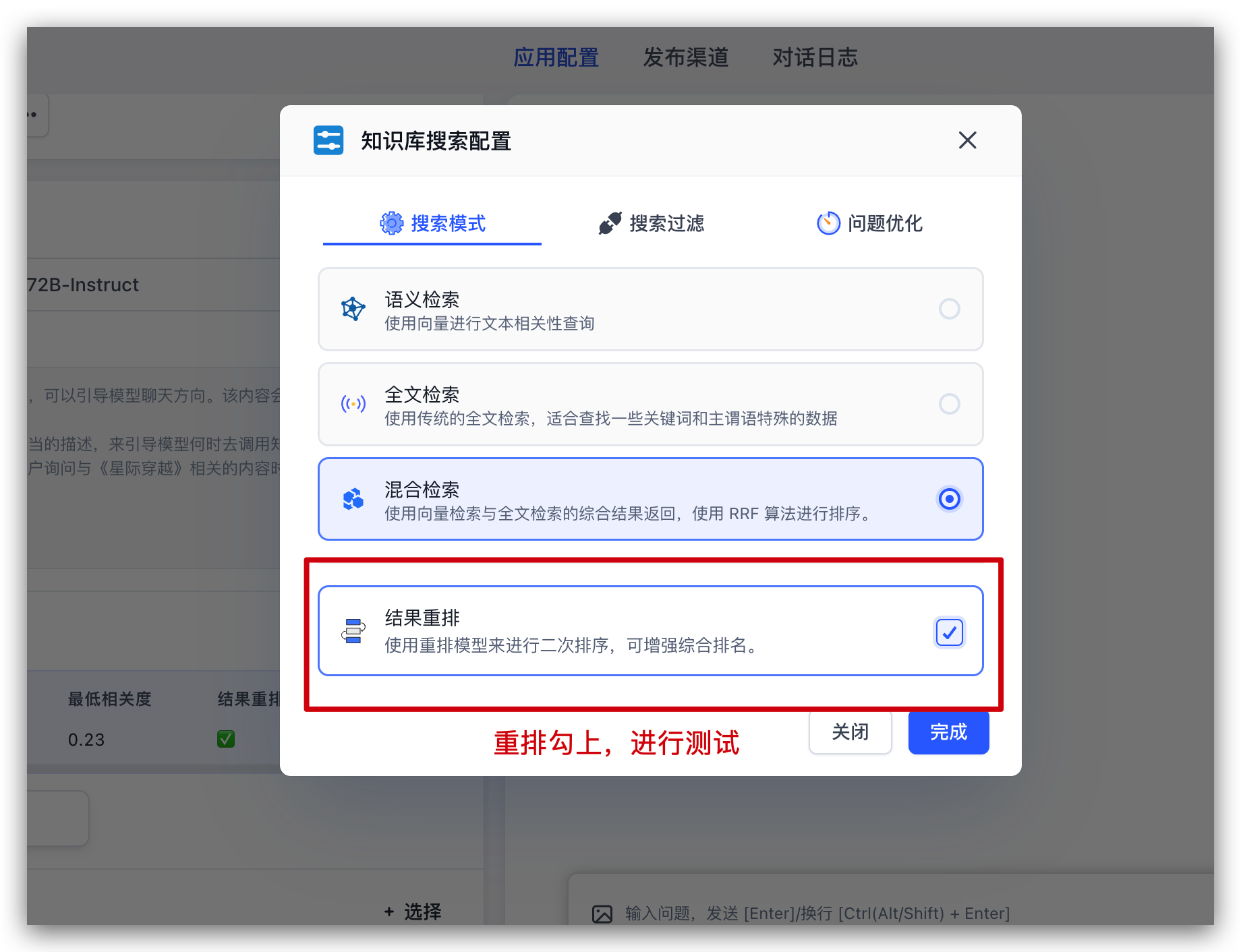

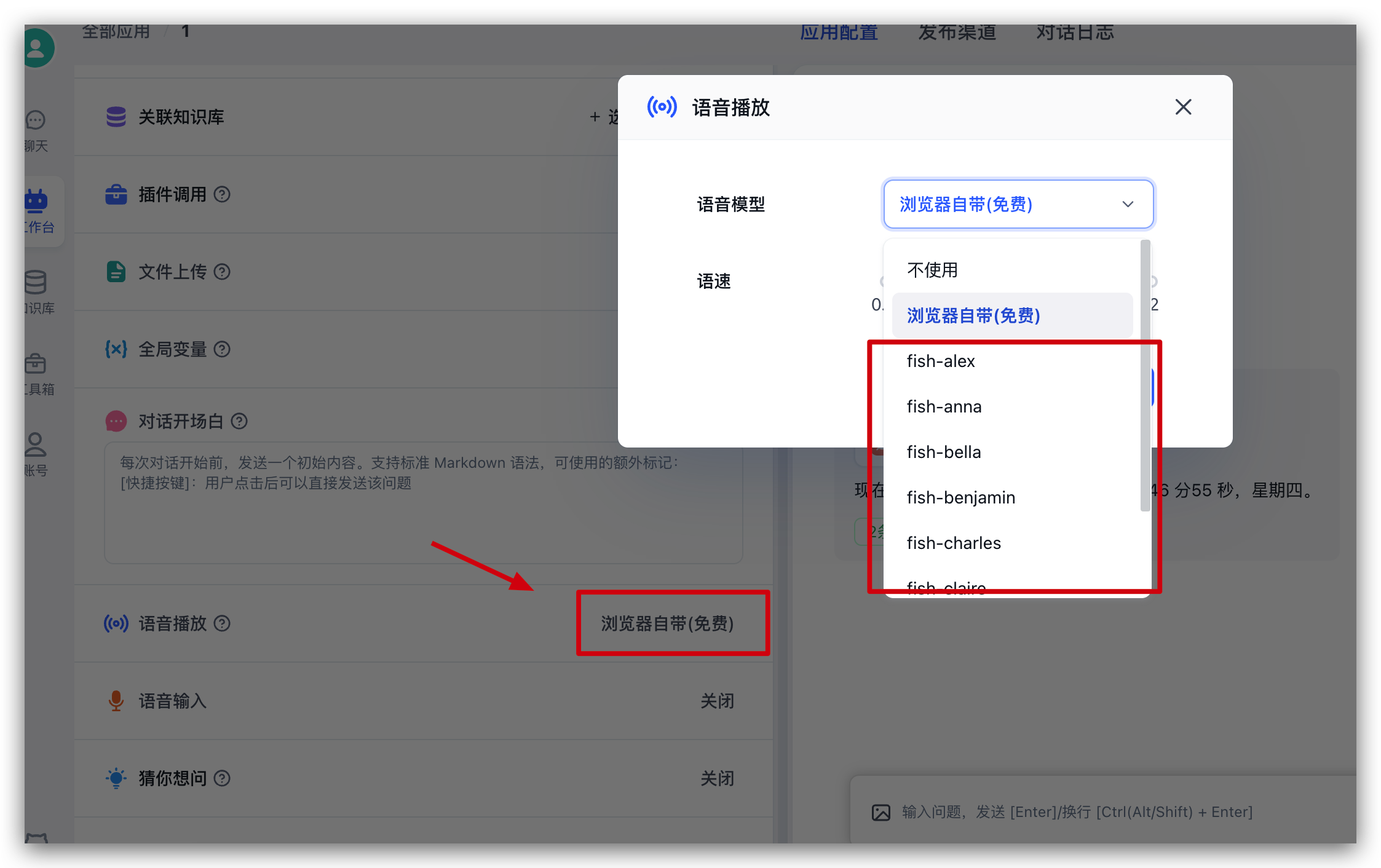

+ 我们选取 SiliconCloud 中的模型作为 FastGPT 配置。这里配置了 Qwen2.5 72b 的纯语言和视觉模型;选择 bge-m3 作为向量模型;选择 bge-reranker-v2-m3 作为重排模型。选择 fish-speech-1.5 作为语音模型;选择 SenseVoiceSmall 作为语音输入模型。

注意:ReRank 模型仍需配置一次 Api Key

+ {

+ "llmModels": [

+ {

+ "provider": "Other", // 模型提供商,主要用于分类展示,目前已经内置提供商包括:https://github.com/labring/FastGPT/blob/main/packages/global/core/ai/provider.ts, 可 pr 提供新的提供商,或直接填写 Other

+ "model": "Qwen/Qwen2.5-72B-Instruct", // 模型名(对应OneAPI中渠道的模型名)

+ "name": "Qwen2.5-72B-Instruct", // 模型别名

+ "maxContext": 32000, // 最大上下文

+ "maxResponse": 4000, // 最大回复

+ "quoteMaxToken": 30000, // 最大引用内容

+ "maxTemperature": 1, // 最大温度

+ "charsPointsPrice": 0, // n积分/1k token(商业版)

+ "censor": false, // 是否开启敏感校验(商业版)

+ "vision": false, // 是否支持图片输入

+ "datasetProcess": true, // 是否设置为文本理解模型(QA),务必保证至少有一个为true,否则知识库会报错

+ "usedInClassify": true, // 是否用于问题分类(务必保证至少有一个为true)

+ "usedInExtractFields": true, // 是否用于内容提取(务必保证至少有一个为true)

+ "usedInToolCall": true, // 是否用于工具调用(务必保证至少有一个为true)

+ "usedInQueryExtension": true, // 是否用于问题优化(务必保证至少有一个为true)

+ "toolChoice": true, // 是否支持工具选择(分类,内容提取,工具调用会用到。)

+ "functionCall": false, // 是否支持函数调用(分类,内容提取,工具调用会用到。会优先使用 toolChoice,如果为false,则使用 functionCall,如果仍为 false,则使用提示词模式)

+ "customCQPrompt": "", // 自定义文本分类提示词(不支持工具和函数调用的模型

+ "customExtractPrompt": "", // 自定义内容提取提示词

+ "defaultSystemChatPrompt": "", // 对话默认携带的系统提示词

+ "defaultConfig": {}, // 请求API时,挟带一些默认配置(比如 GLM4 的 top_p)

+ "fieldMap": {} // 字段映射(o1 模型需要把 max_tokens 映射为 max_completion_tokens)

+ },

+ {

+ "provider": "Other",

+ "model": "Qwen/Qwen2-VL-72B-Instruct",

+ "name": "Qwen2-VL-72B-Instruct",

+ "maxContext": 32000,

+ "maxResponse": 4000,

+ "quoteMaxToken": 30000,

+ "maxTemperature": 1,

+ "charsPointsPrice": 0,

+ "censor": false,

+ "vision": true,

+ "datasetProcess": false,

+ "usedInClassify": false,

+ "usedInExtractFields": false,

+ "usedInToolCall": false,

+ "usedInQueryExtension": false,

+ "toolChoice": false,

+ "functionCall": false,

+ "customCQPrompt": "",

+ "customExtractPrompt": "",

+ "defaultSystemChatPrompt": "",

+ "defaultConfig": {}

+ }

+ ],

+ "vectorModels": [

+ {

+ "provider": "Other",

+ "model": "Pro/BAAI/bge-m3",

+ "name": "Pro/BAAI/bge-m3",

+ "charsPointsPrice": 0,

+ "defaultToken": 512,

+ "maxToken": 5000,

+ "weight": 100

+ }

+ ],

+ "reRankModels": [

+ {

+ "model": "BAAI/bge-reranker-v2-m3", // 这里的model需要对应 siliconflow 的模型名

+ "name": "BAAI/bge-reranker-v2-m3",

+ "requestUrl": "https://api.siliconflow.cn/v1/rerank",

+ "requestAuth": "siliconflow 上申请的 key"

+ }

+ ],

+ "audioSpeechModels": [

+ {

+ "model": "fishaudio/fish-speech-1.5",

+ "name": "fish-speech-1.5",

+ "voices": [

+ {

+ "label": "fish-alex",

+ "value": "fishaudio/fish-speech-1.5:alex",

+ "bufferId": "fish-alex"

+ },

+ {

+ "label": "fish-anna",

+ "value": "fishaudio/fish-speech-1.5:anna",

+ "bufferId": "fish-anna"

+ },

+ {

+ "label": "fish-bella",

+ "value": "fishaudio/fish-speech-1.5:bella",

+ "bufferId": "fish-bella"

+ },

+ {

+ "label": "fish-benjamin",

+ "value": "fishaudio/fish-speech-1.5:benjamin",

+ "bufferId": "fish-benjamin"

+ },

+ {

+ "label": "fish-charles",

+ "value": "fishaudio/fish-speech-1.5:charles",

+ "bufferId": "fish-charles"

+ },

+ {

+ "label": "fish-claire",

+ "value": "fishaudio/fish-speech-1.5:claire",

+ "bufferId": "fish-claire"

+ },

+ {

+ "label": "fish-david",

+ "value": "fishaudio/fish-speech-1.5:david",

+ "bufferId": "fish-david"

+ },

+ {

+ "label": "fish-diana",

+ "value": "fishaudio/fish-speech-1.5:diana",

+ "bufferId": "fish-diana"

+ }

+ ]

+ }

+ ],

+ "whisperModel": {

+ "model": "FunAudioLLM/SenseVoiceSmall",

+ "name": "SenseVoiceSmall",

+ "charsPointsPrice": 0

+ }

+}

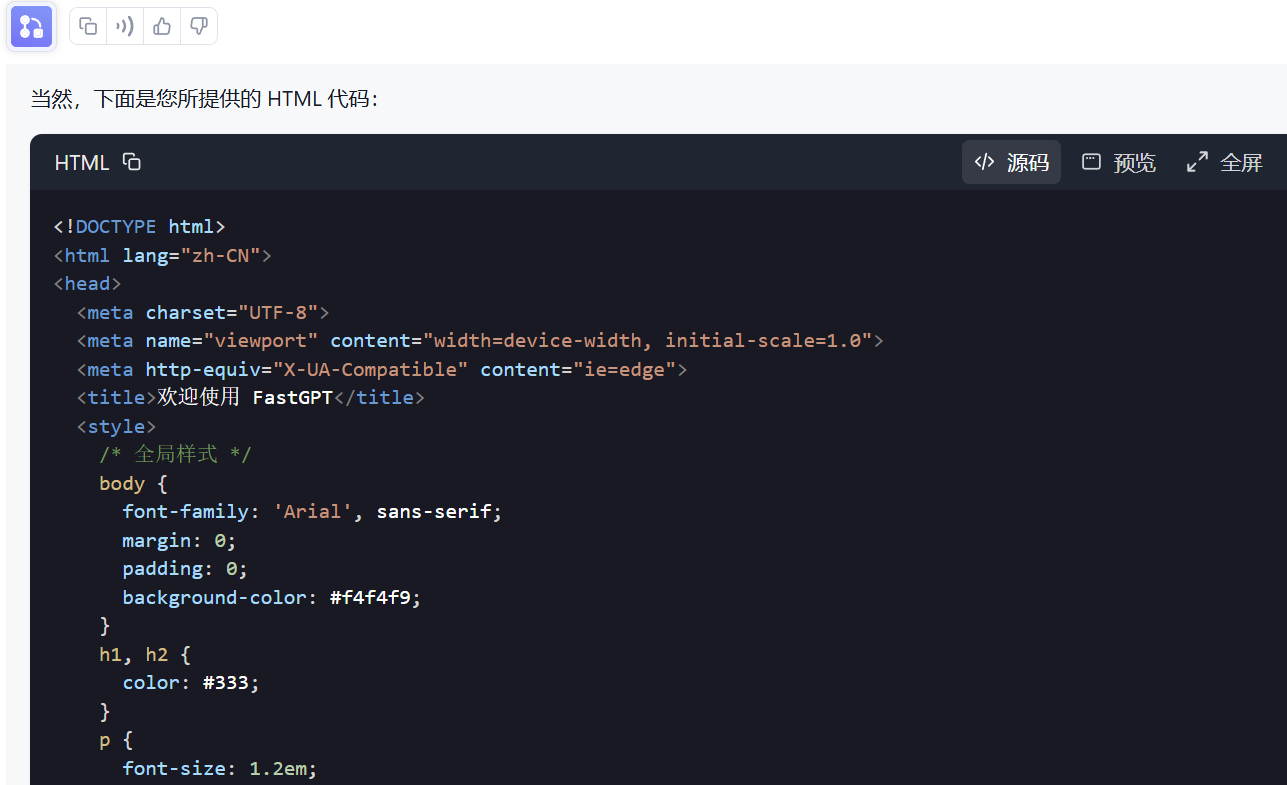

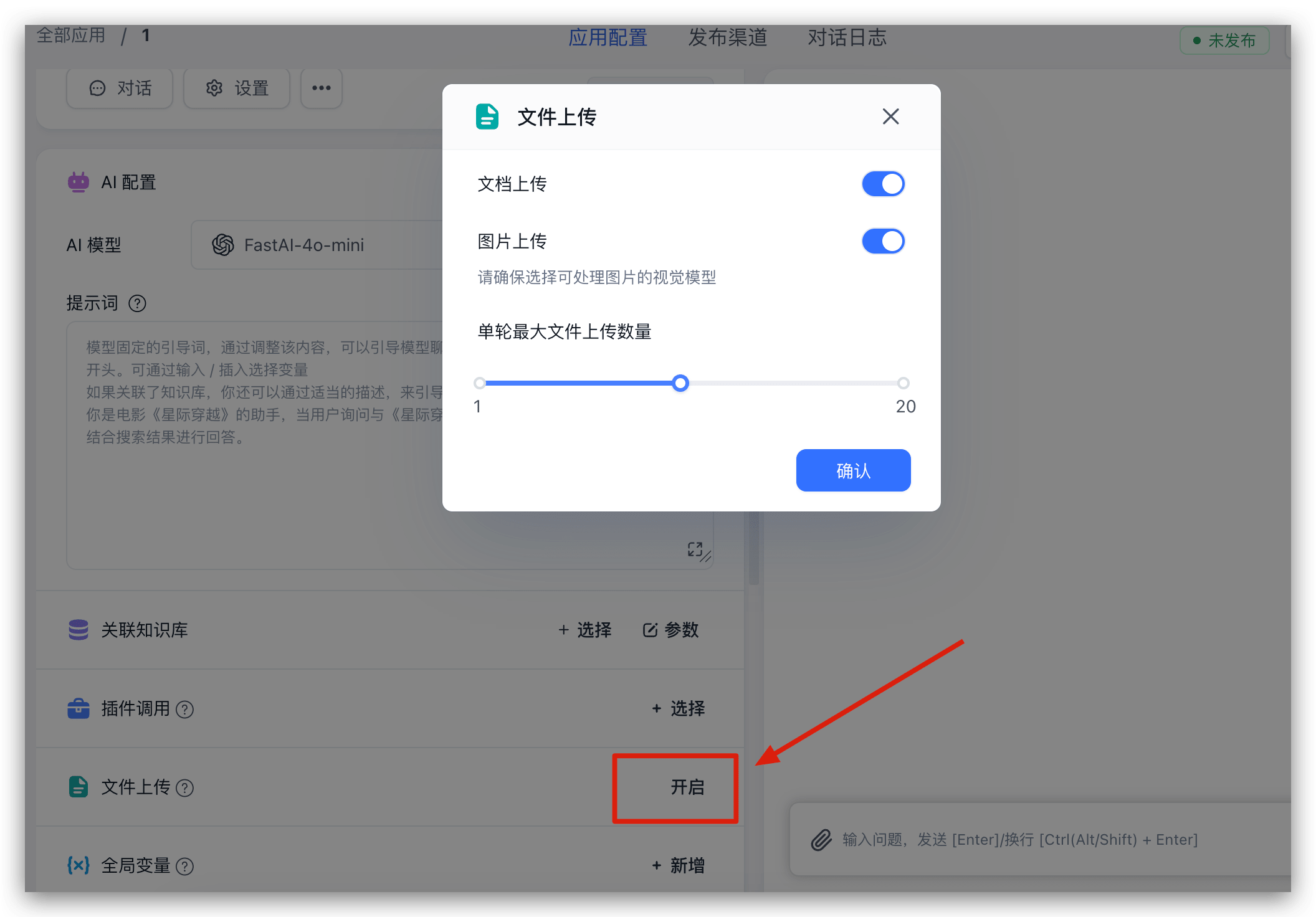

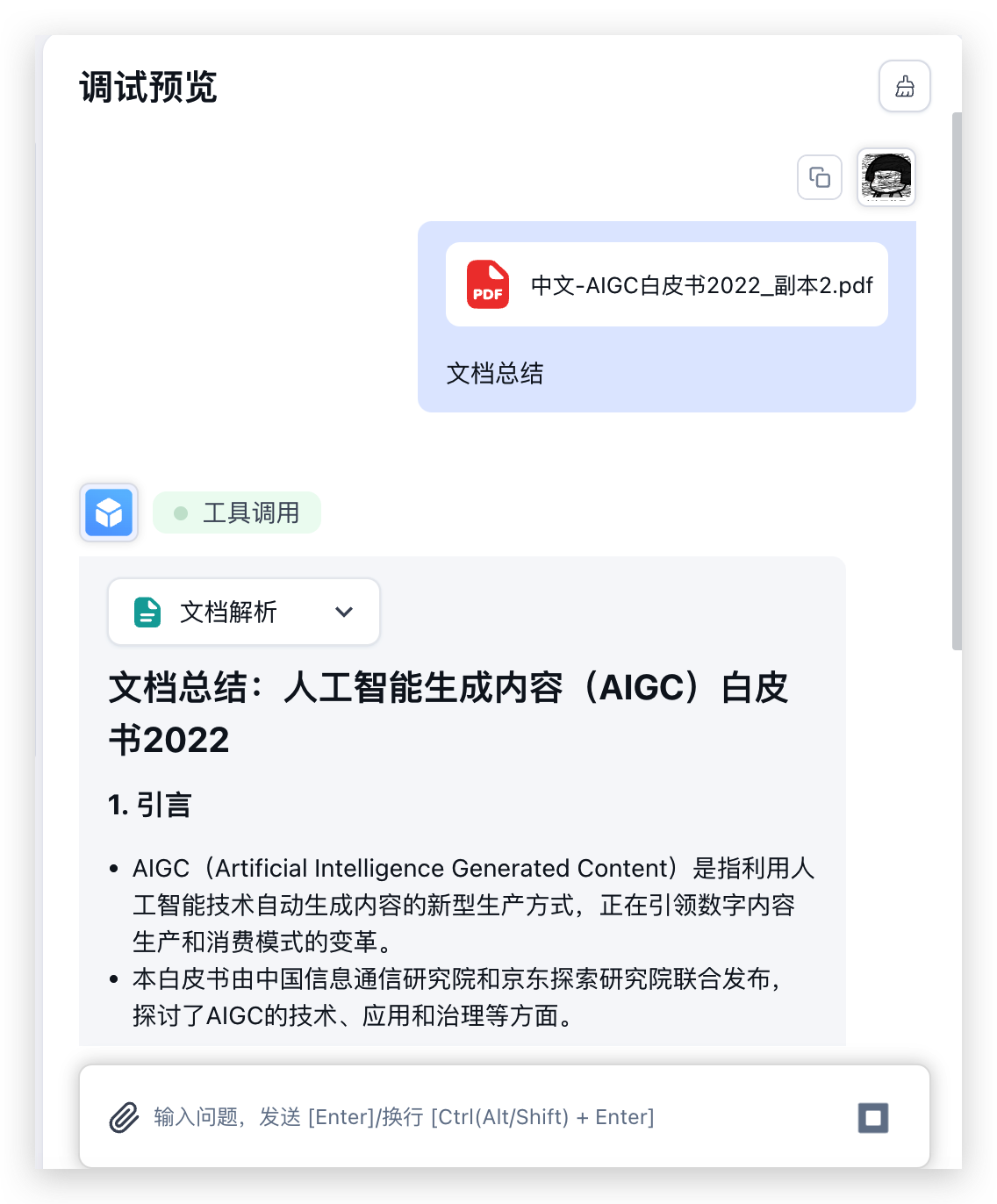

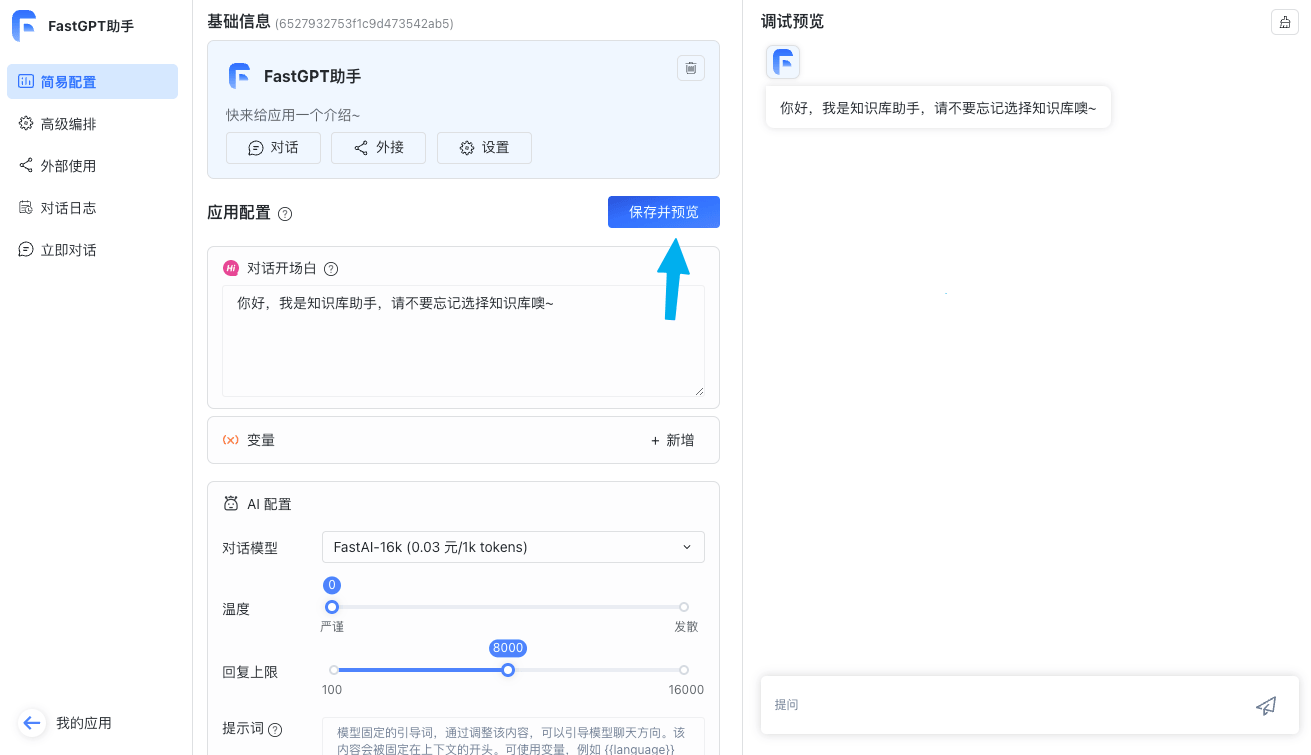

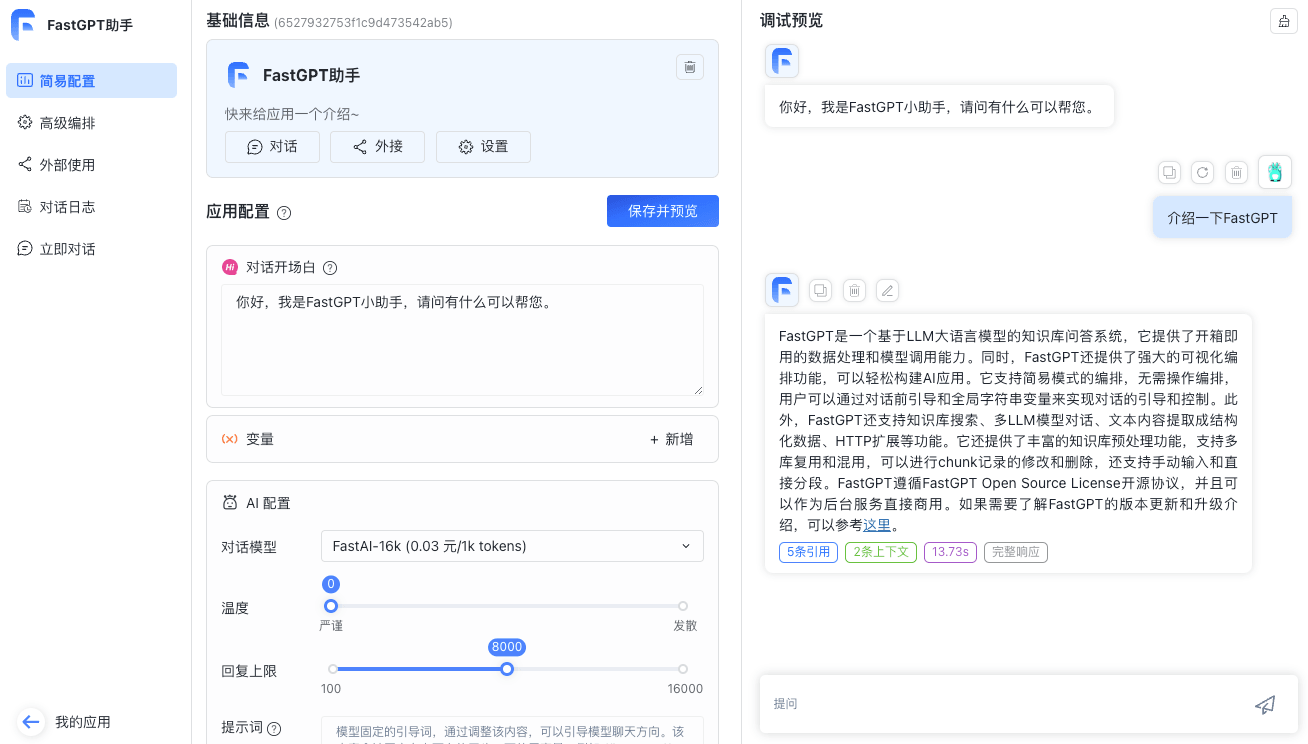

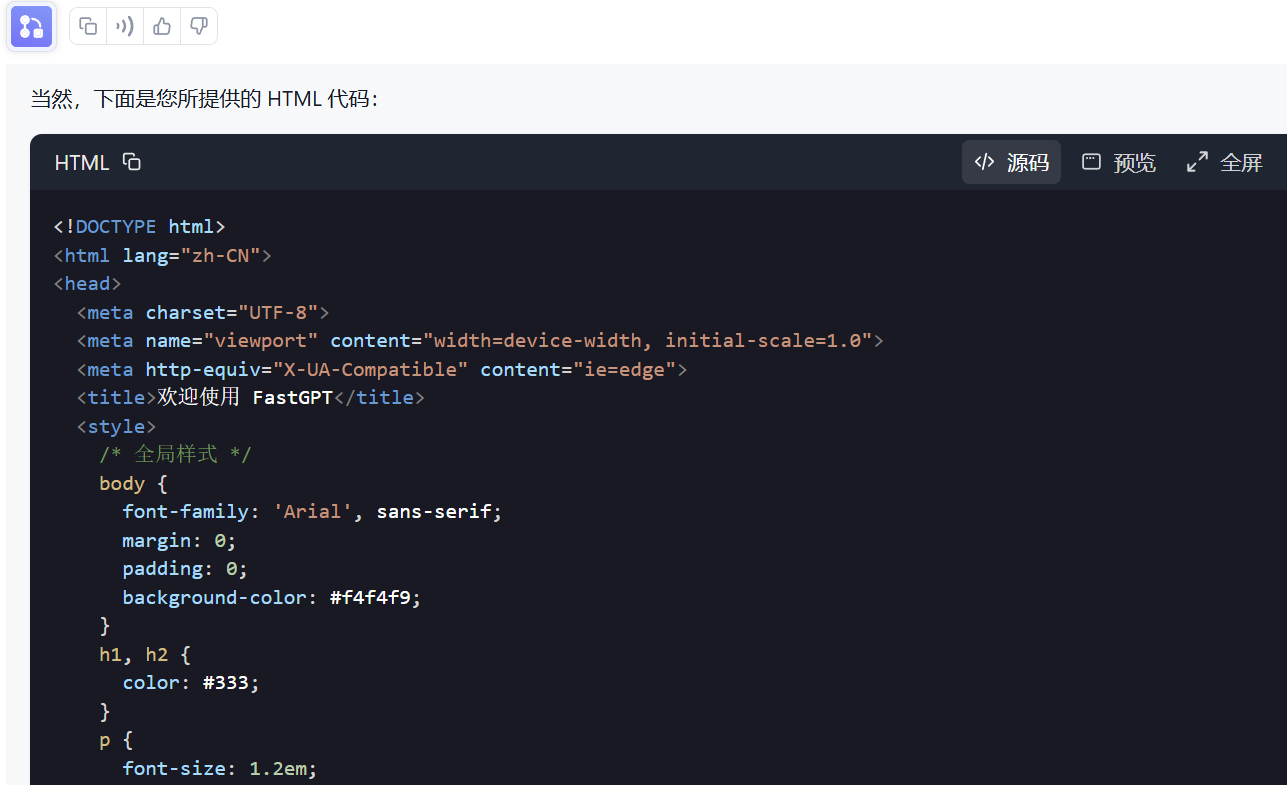

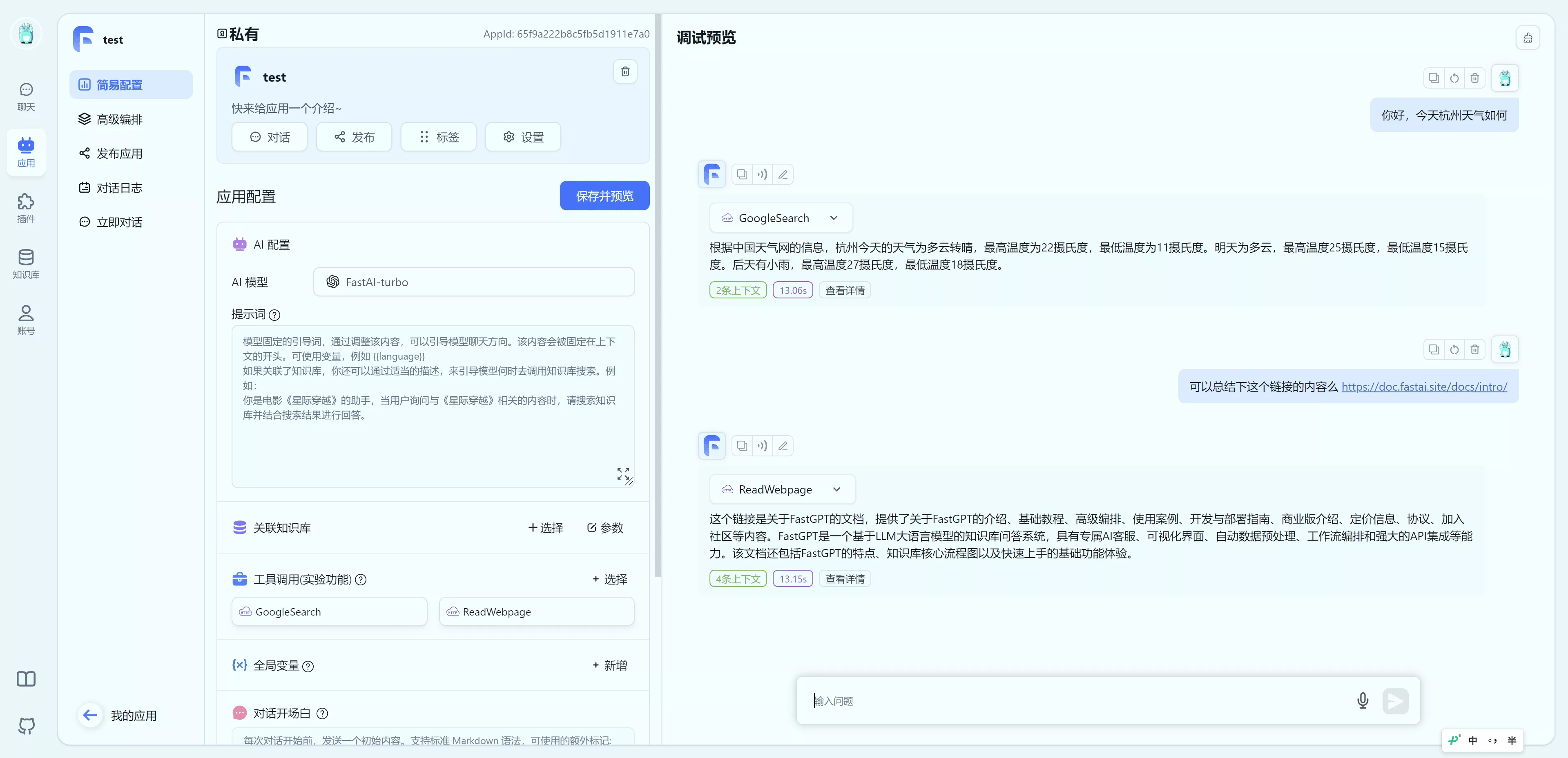

+ 随便新建一个简易应用,选择对应模型,并开启图片上传后进行测试:

|  |

可以看到,72B 的模型,性能还是非常快的,这要是本地没几个 4090,不说配置环境,输出怕都要 30s 了。

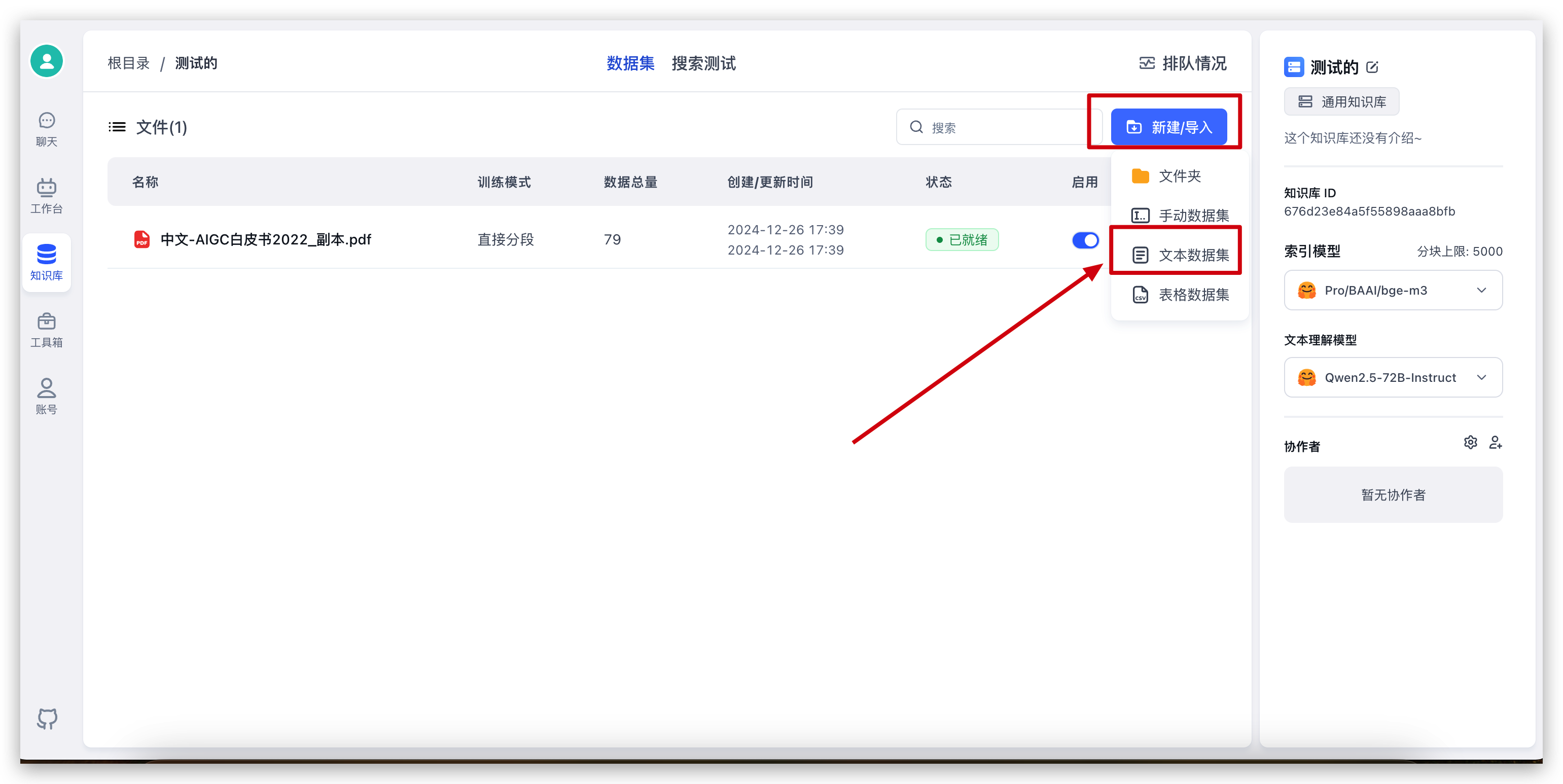

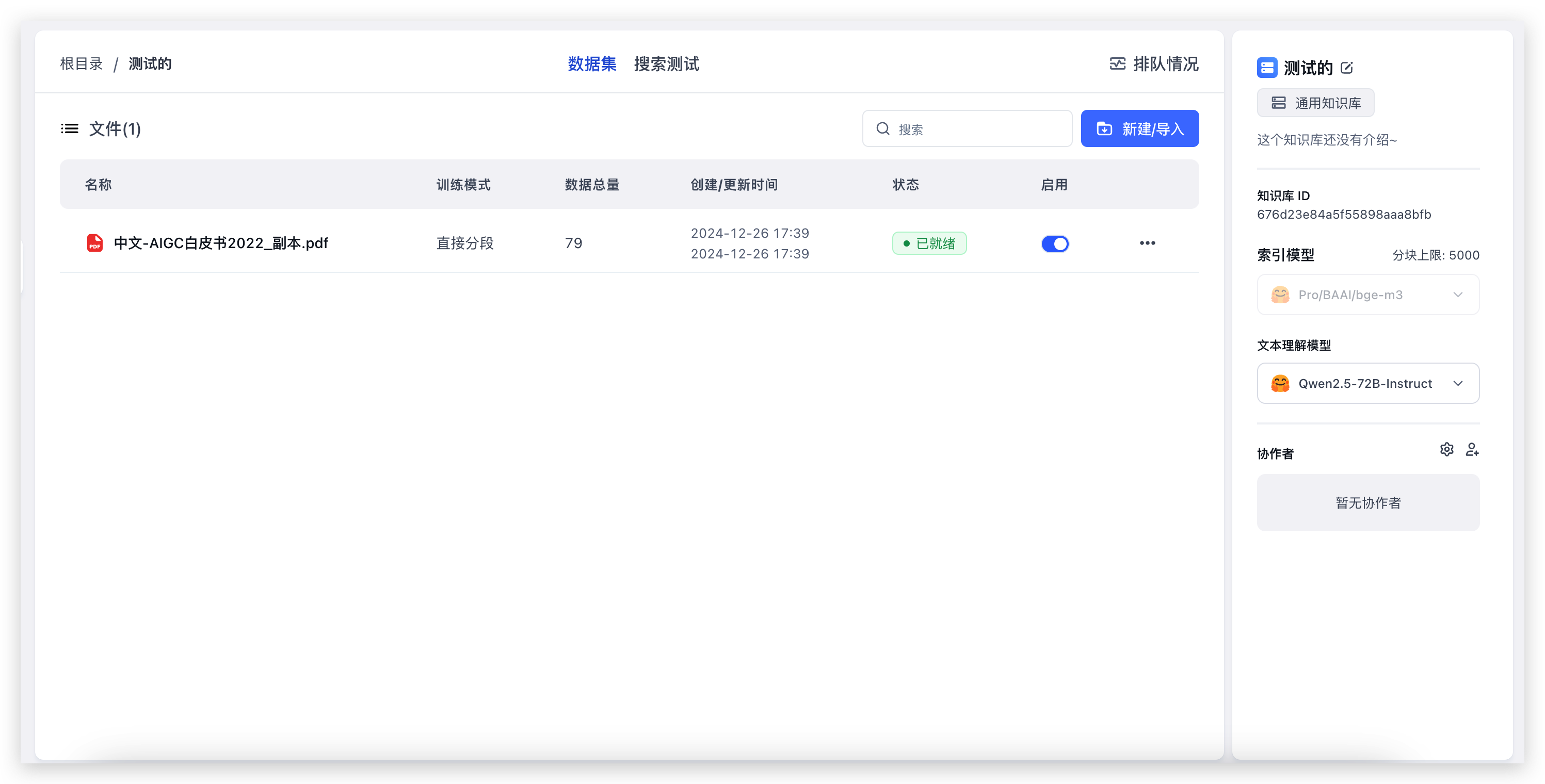

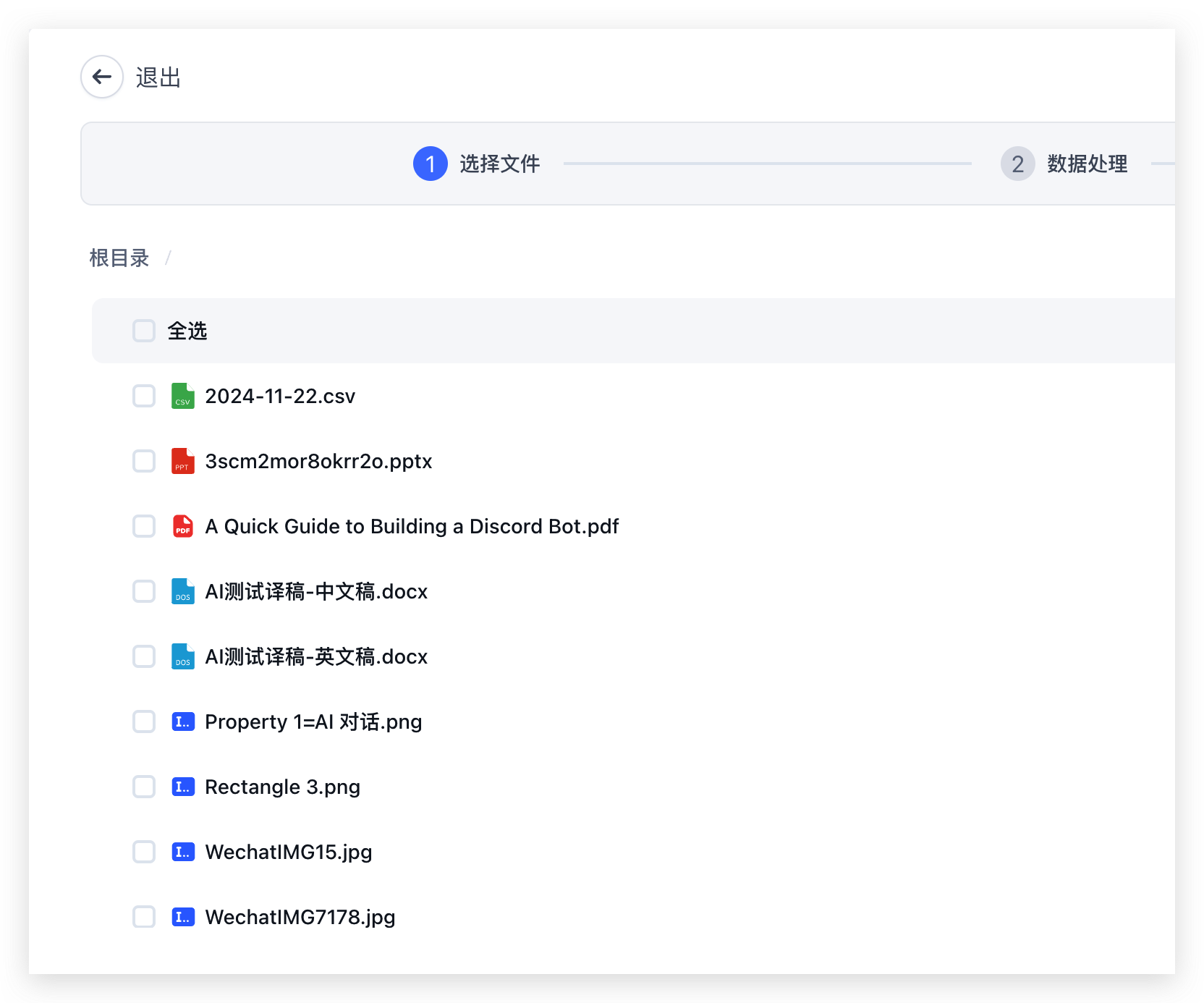

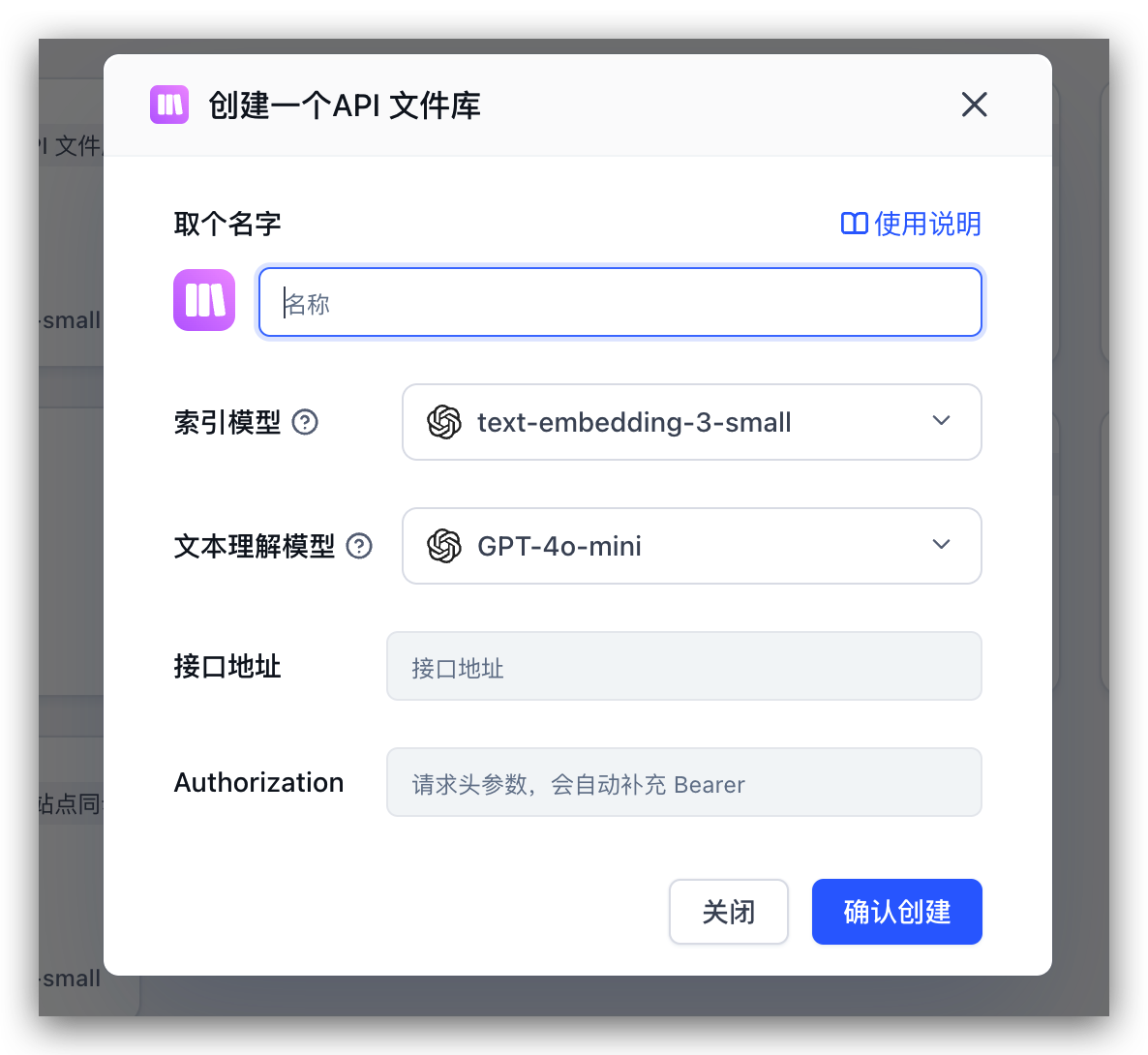

新建一个知识库(由于只配置了一个向量模型,页面上不会展示向量模型选择)

|  |

导入本地文件,直接选择文件,然后一路下一步即可。79 个索引,大概花了 20s 的时间就完成了。现在我们去测试一下知识库问答。

首先回到我们刚创建的应用,选择知识库,调整一下参数后即可开始对话:

|  |  |

对话完成后,点击底部的引用,可以查看引用详情,同时可以看到具体的检索和重排得分:

|  |

继续在刚刚的应用中,左侧配置中找到语音播放,点击后可以从弹窗中选择语音模型,并进行试听:

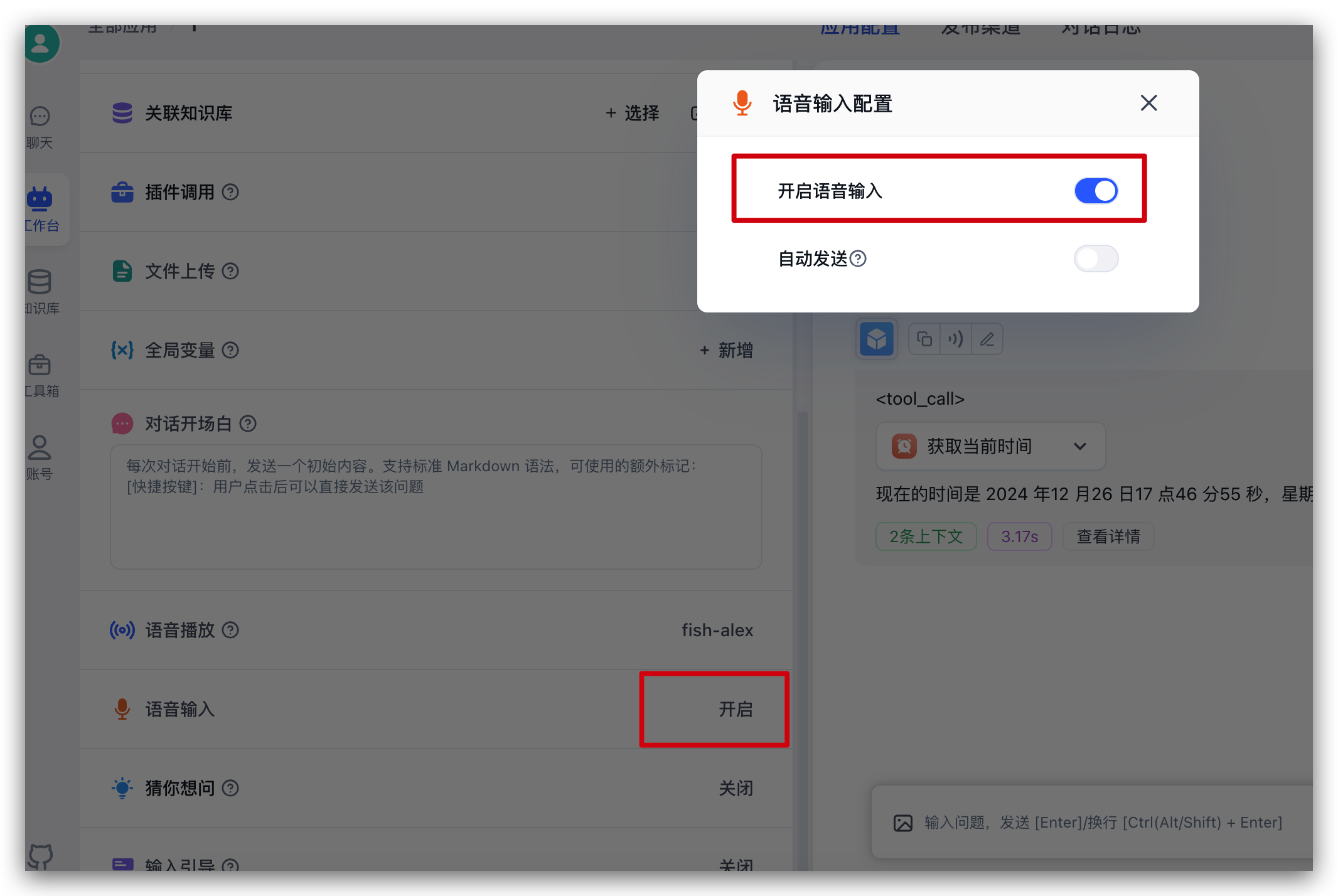

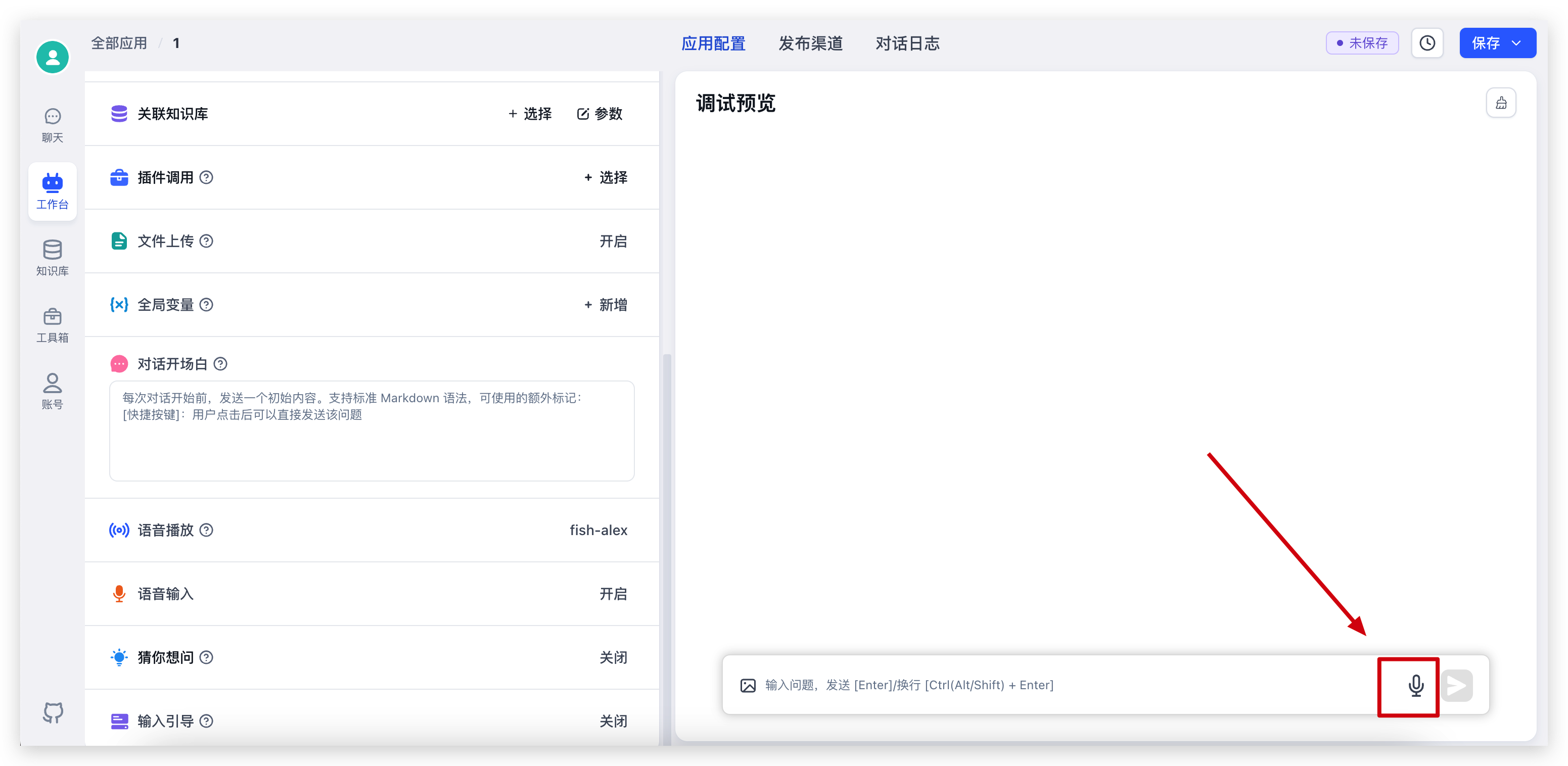

继续在刚刚的应用中,左侧配置中找到语音输入,点击后可以从弹窗中开启语言输入

开启后,对话输入框中,会增加一个话筒的图标,点击可进行语音输入:

|  |

如果你想快速的体验开源模型或者快速的使用 FastGPT,不想在不同服务商申请各类 Api Key,那么可以选择 SiliconCloud 的模型先进行快速体验。

如果你决定未来私有化部署模型和 FastGPT,前期可通过 SiliconCloud 进行测试验证,后期再进行硬件采购,减少 POC 时间和成本。

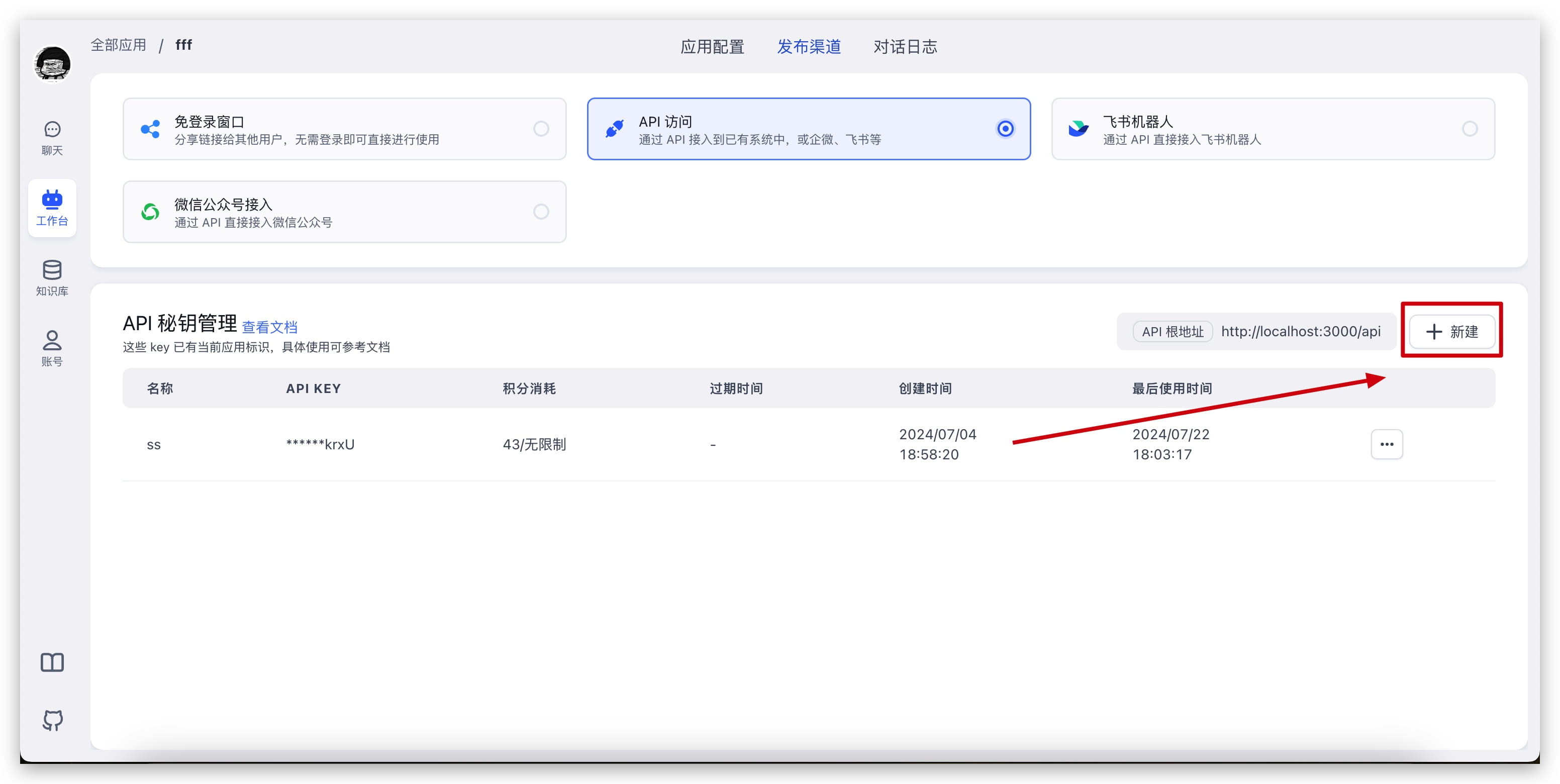

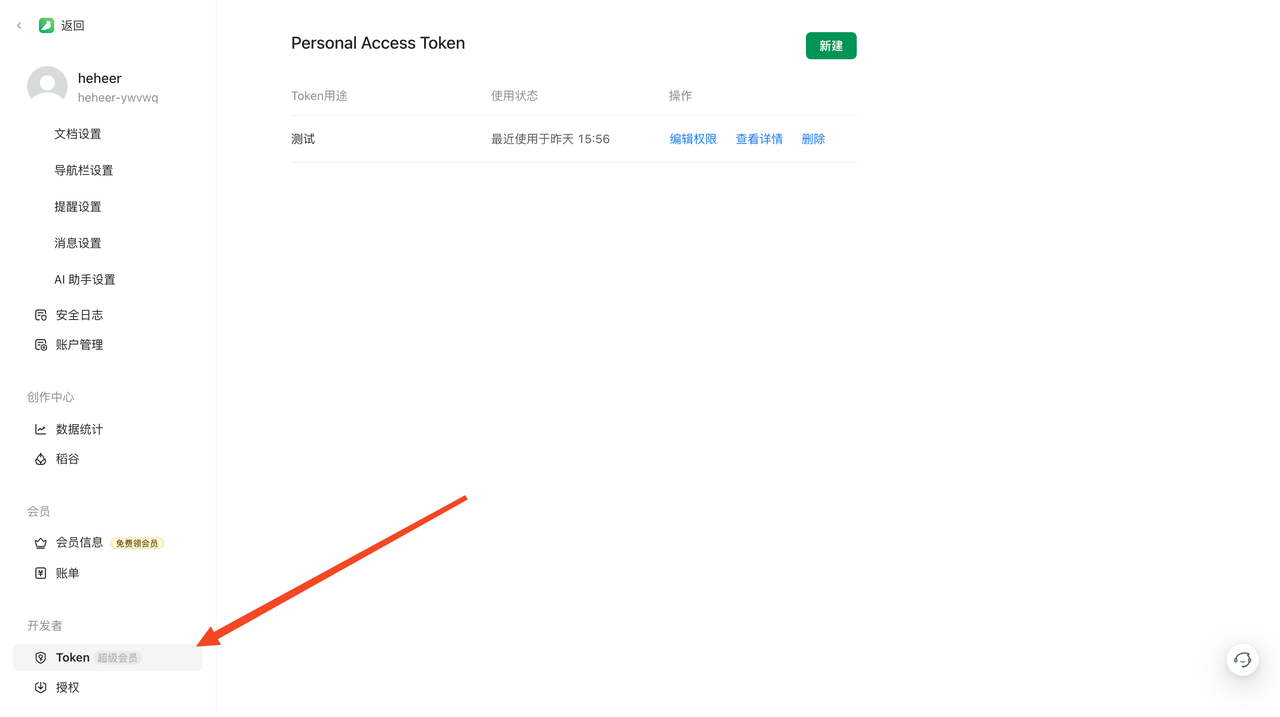

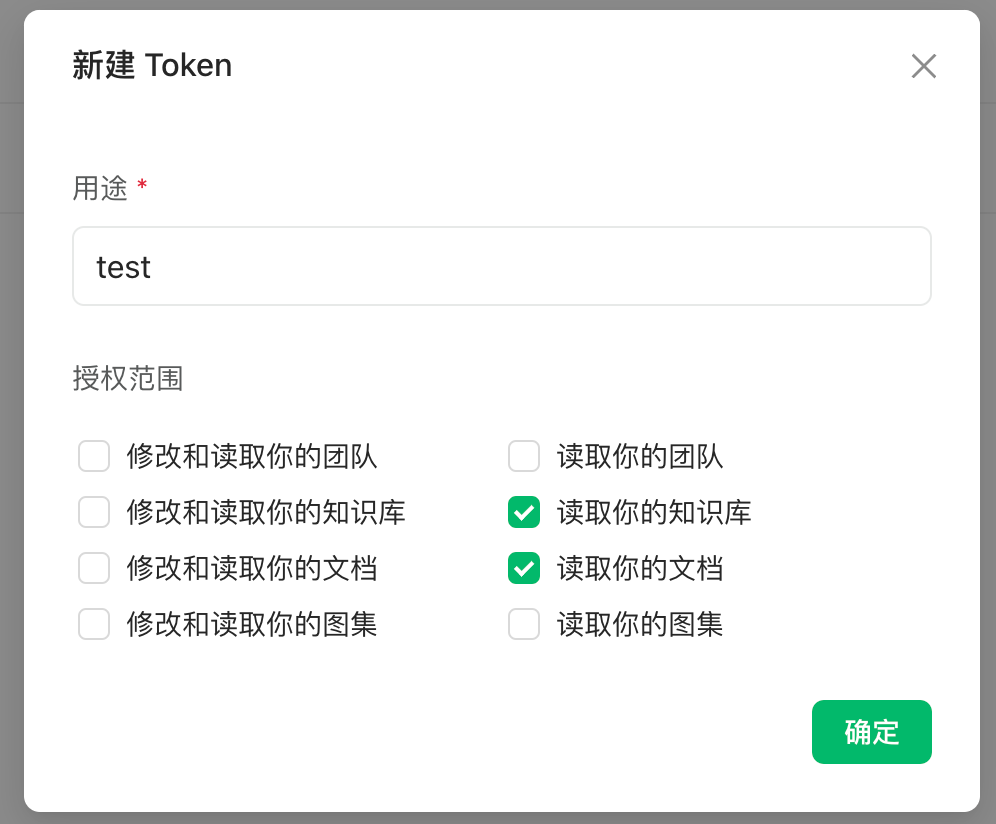

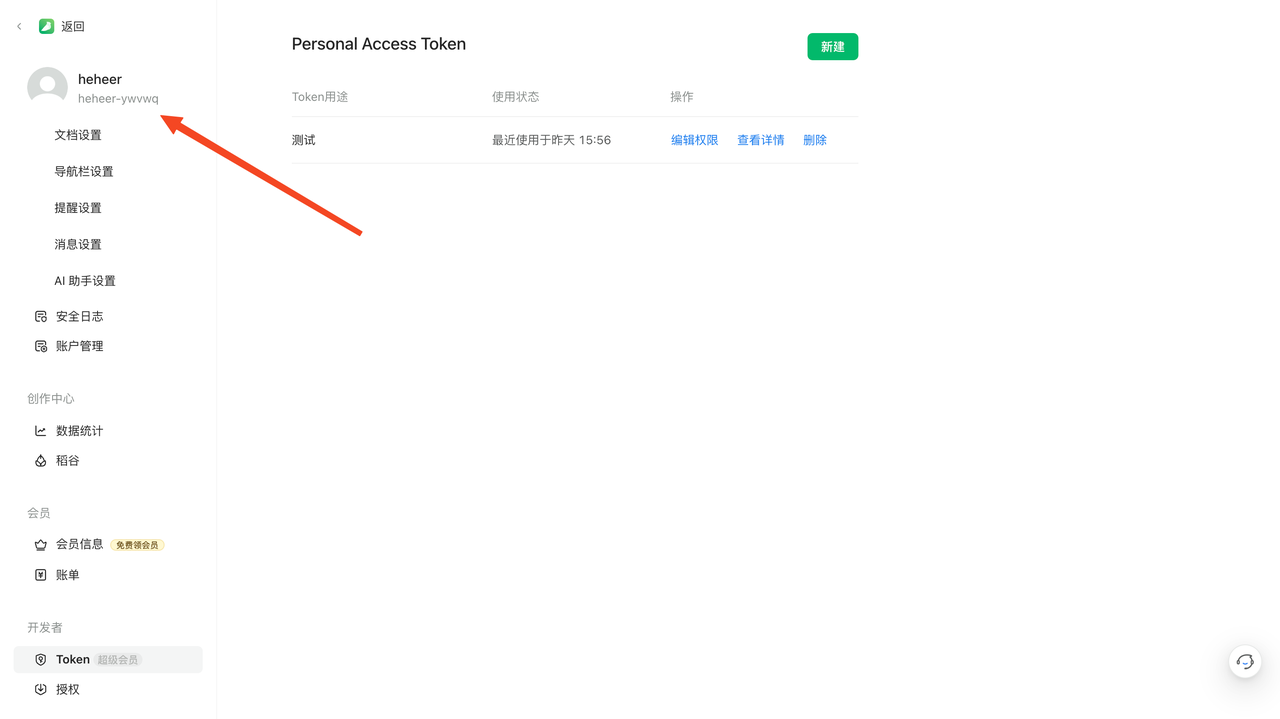

FastGPT Api Key 使用与鉴权

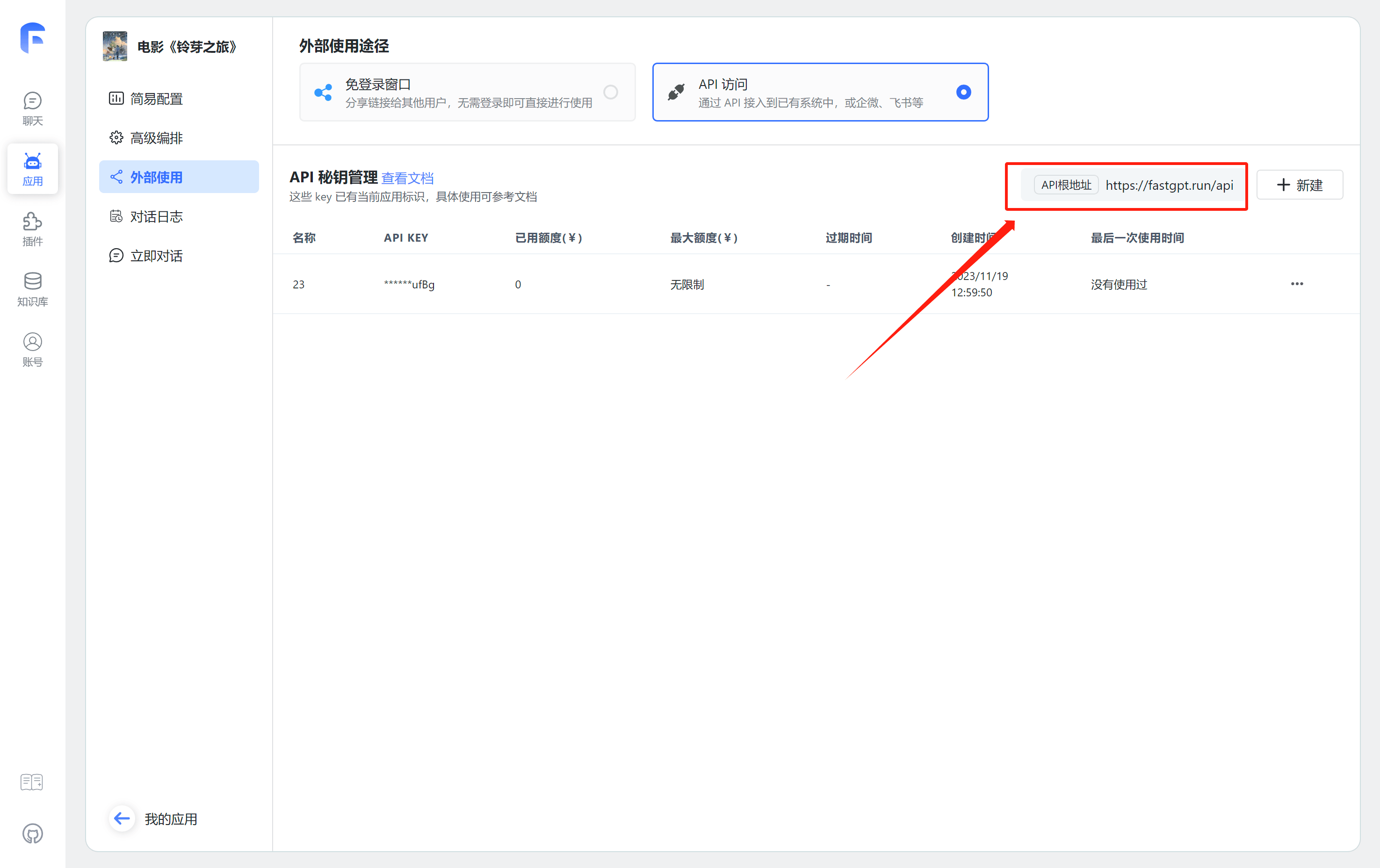

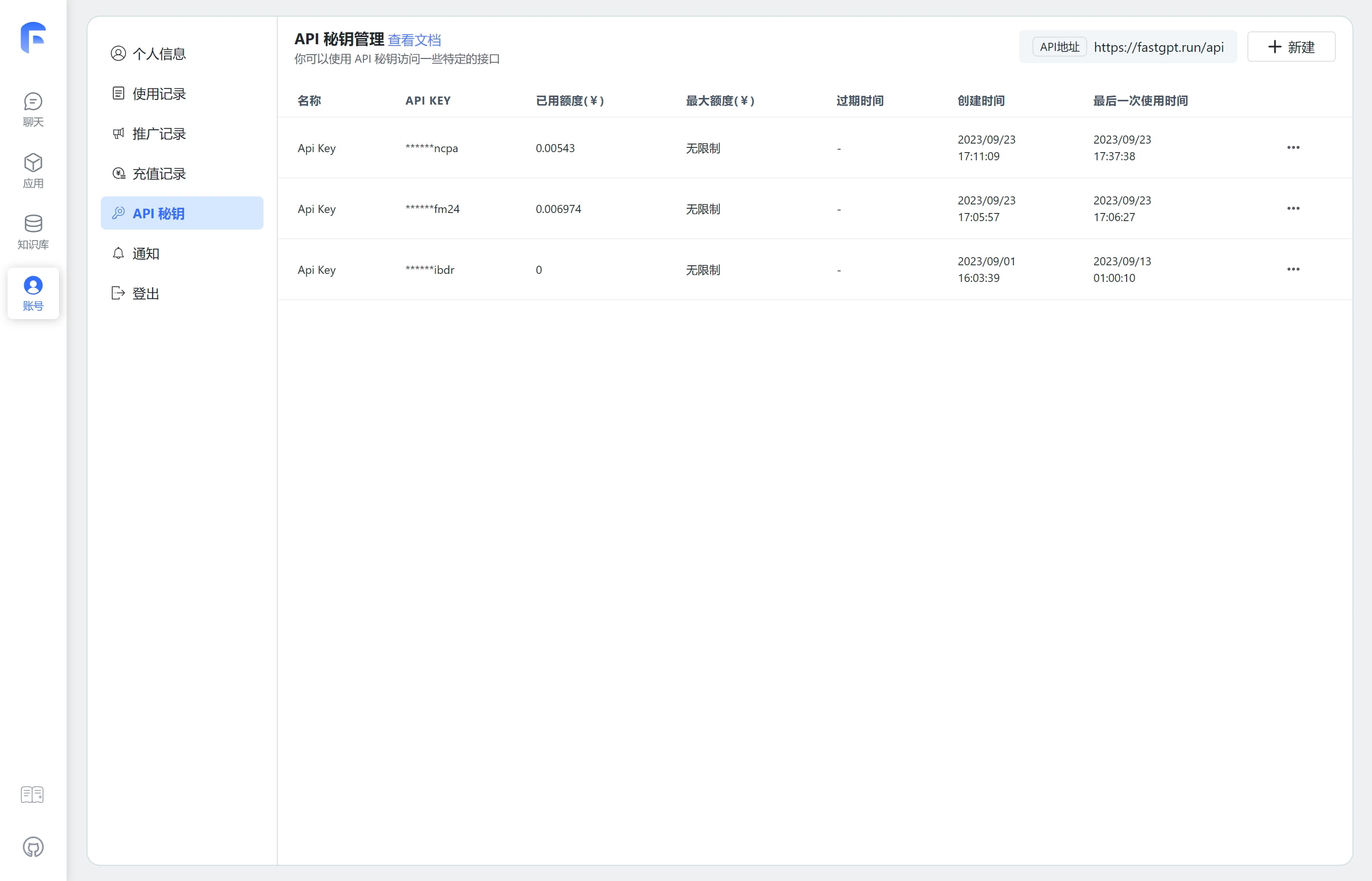

FasGPT OpenAPI 接口允许你使用 Api Key 进行鉴权,从而操作 FastGPT 上的相关服务和资源,例如:调用应用对话接口、上传知识库数据、搜索测试等等。出于兼容性和安全考虑,并不是所有的接口都允许通过 Api Key 访问。

注意:BaseURL 不是接口地址,而是所有接口的根地址,直接请求 BaseURL 是没有用的。

FastGPT 的 API Key 有 2 类,一类是全局通用的 key (无法直接调用应用对话);一类是携带了 AppId 也就是有应用标记的 key (可直接调用应用对话)。

我们建议,仅操作应用或者对话的相关接口使用 应用特定key,其他接口使用 通用key。

| 通用key | 应用特定 key |

|---|---|

|  |

OpenAPI 中,所有的接口都通过 Header.Authorization 进行鉴权。

+ baseUrl: "https://api.fastgpt.in/api"

+headers: {

+ Authorization: "Bearer {{apikey}}"

+}

+ 发起应用对话示例

+ curl --location --request POST 'https://api.fastgpt.in/api/v1/chat/completions' \

+--header 'Authorization: Bearer fastgpt-xxxxxx' \

+--header 'Content-Type: application/json' \

+--data-raw '{

+ "chatId": "111",

+ "stream": false,

+ "detail": false,

+ "messages": [

+ {

+ "content": "导演是谁",

+ "role": "user"

+ }

+ ]

+}'

+ FastGPT OpenAPI 对话接口

该接口的 API Key 需使用应用特定的 key,否则会报错。

有些包调用时,BaseUrl需要添加v1路径,有些不需要,如果出现404情况,可补充v1重试。

对话接口兼容GPT的接口!如果你的项目使用的是标准的GPT官方接口,可以直接通过修改BaseUrl和 Authorization来访问 FastGpt 应用,不过需要注意下面几个规则:

传入的model,temperature等参数字段均无效,这些字段由编排决定,不会根据 API 参数改变。

不会返回实际消耗Token值,如果需要,可以设置detail=true,并手动计算 responseData 里的tokens值。

如果工作流中包含交互节点,依然是调用该 API 接口,需要设置detail=true,并可以从event=interactive的数据中获取交互节点的配置信息。如果是stream=false,则可以从 choice 中获取type=interactive的元素,获取交互节点的选择信息。

当你调用一个带交互节点的工作流时,如果工作流遇到了交互节点,那么会直接返回,你可以得到下面的信息:

紧接着上一节,当你接收到交互节点信息后,可以根据这些数据进行 UI 渲染,引导用户输入或选择相关信息。然后需要再次发起对话,来继续工作流。调用的接口与仍是该接口,你需要按以下格式来发起请求:

插件的接口与对话接口一致,仅请求参数略有区别,有以下规定:

detail模式。chatId,因为插件只能运行一轮。messages。variables来代表插件的输入。pluginData来获取插件输出。

+ curl --location --request POST 'http://localhost:3000/api/v1/chat/completions' \

+--header 'Authorization: Bearer test-xxxxx' \

+--header 'Content-Type: application/json' \

+--data-raw '{

+ "stream": false,

+ "chatId": "test",

+ "variables": {

+ "query":"你好" # 我的插件输入有一个参数,变量名叫 query

+ }

+}'

+ 以下接口可使用任意API Key调用。

4.8.12 以上版本才能使用

重要字段

仅会情况通过 API Key 创建的对话历史记录,不会清空在线使用、分享链接等其他来源的对话历史记录。

指的是某个 chatId 下的对话记录操作。

4.8.16 后新版接口

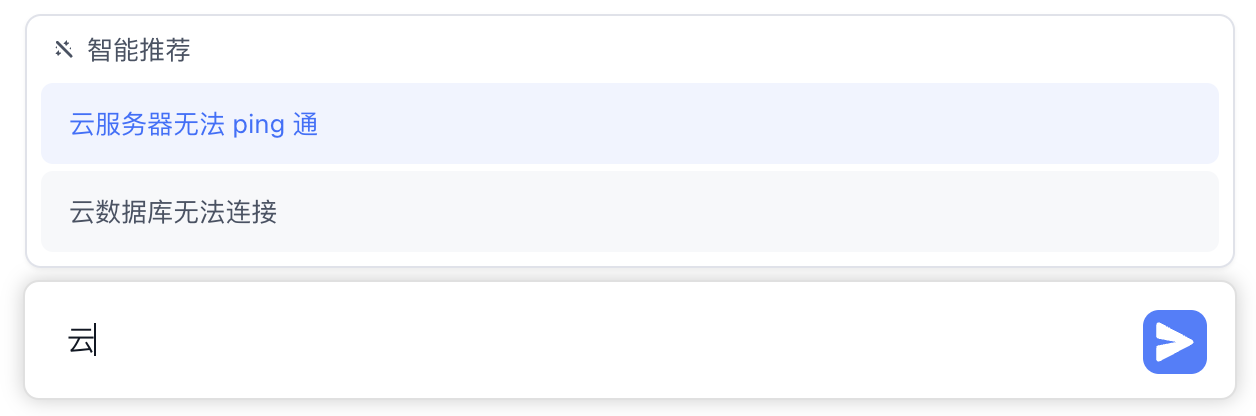

新版猜你想问,必须包含 appId 和 chatId 的参数才可以进行使用。会自动根据 chatId 去拉取最近 6 轮对话记录作为上下文来引导回答。

4.8.16 前旧版接口:

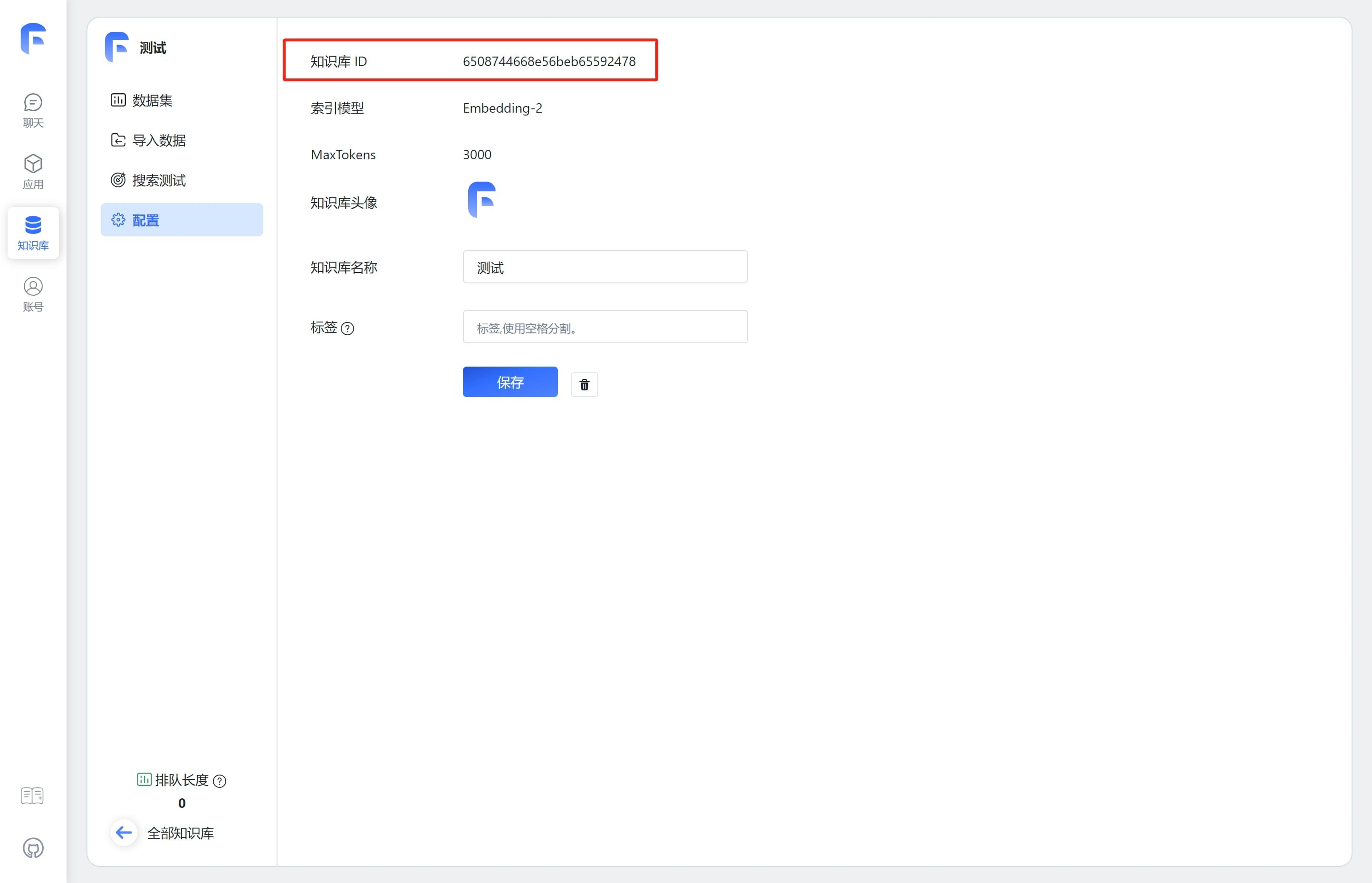

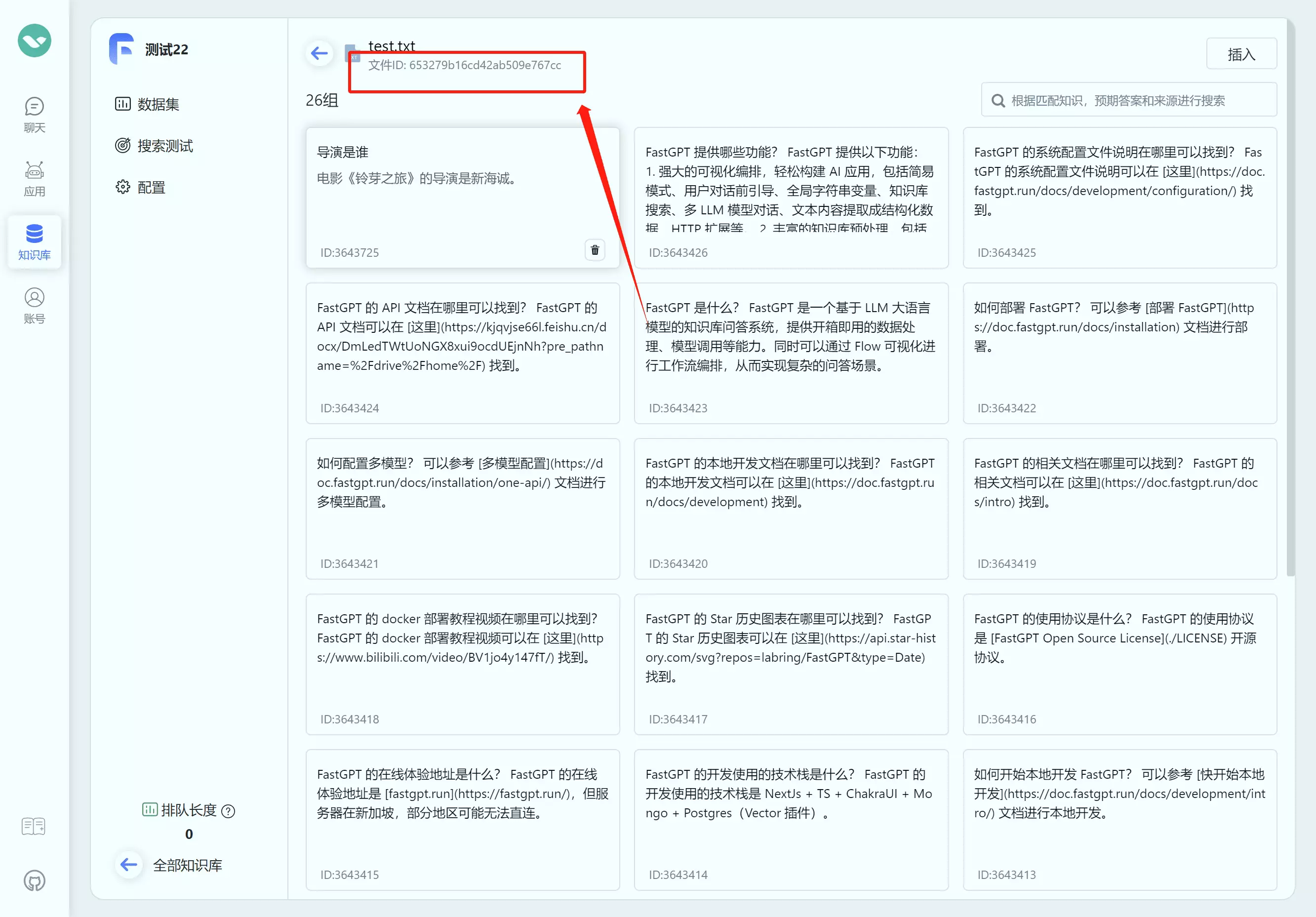

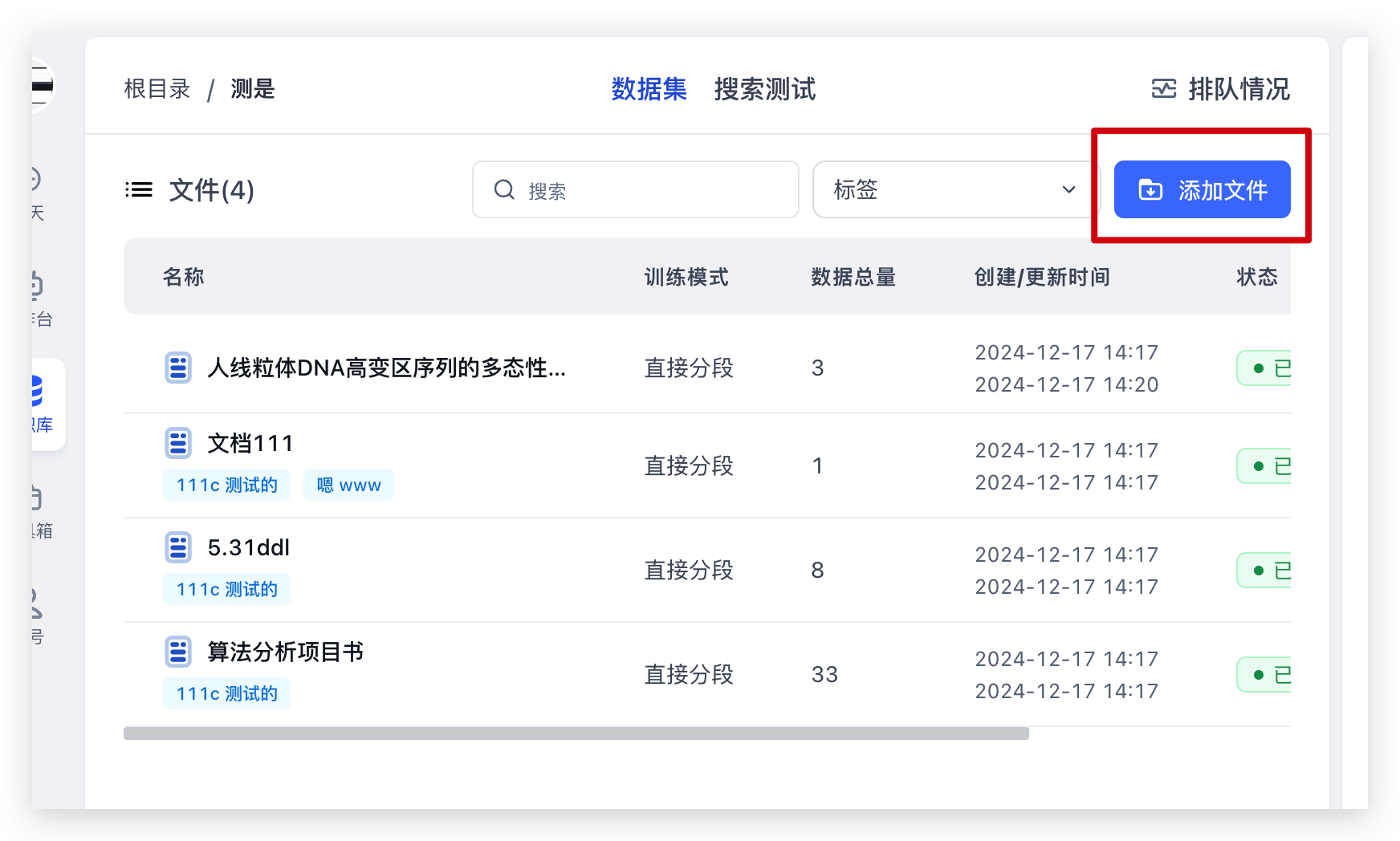

FastGPT OpenAPI 知识库接口

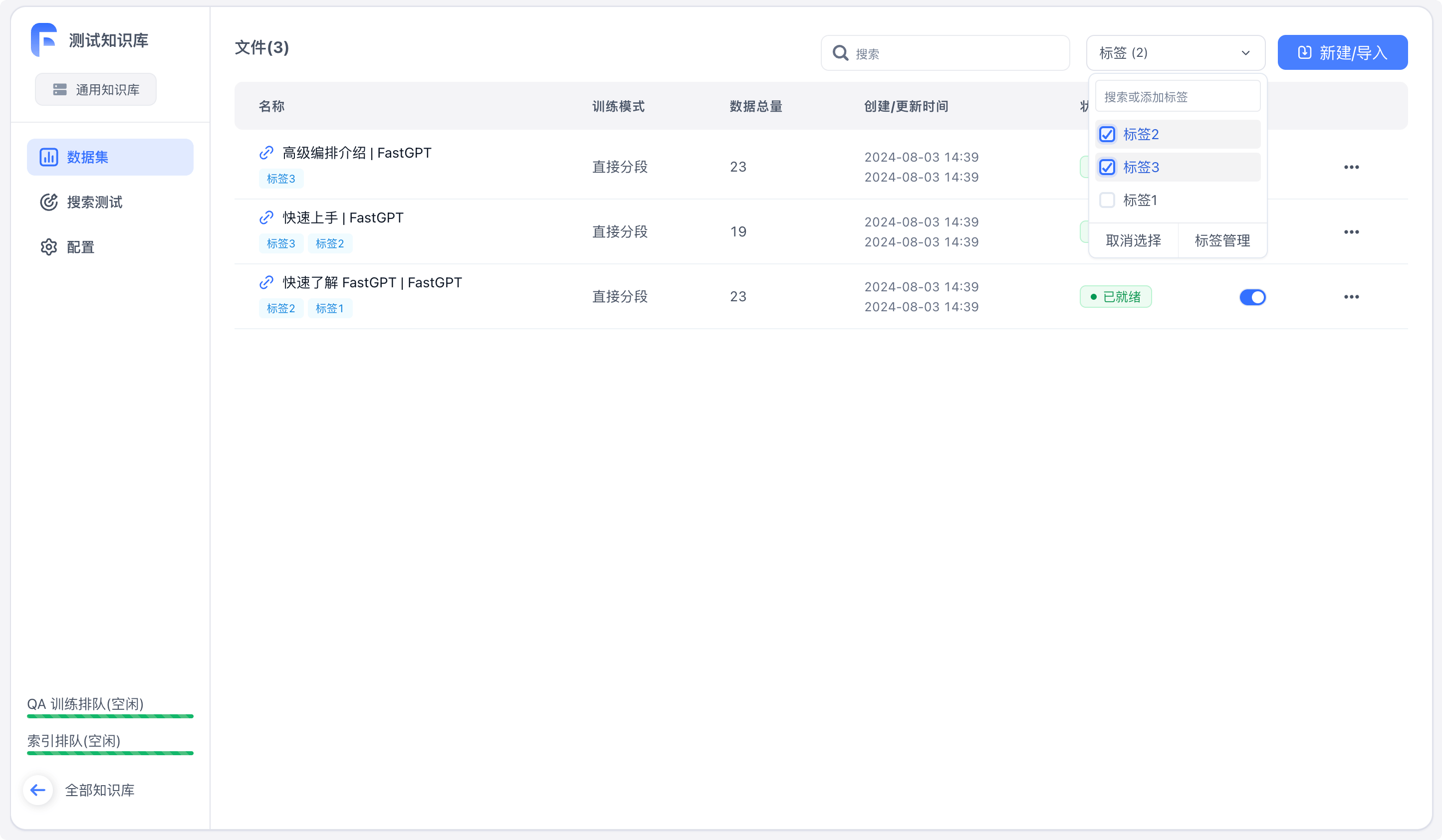

| 如何获取知识库ID(datasetId) | 如何获取文件集合ID(collection_id) |

|---|---|

|  |

入参

| 参数 | 说明 | 必填 |

|---|---|---|

| datasetId | 知识库ID | ✅ |

| parentId: | 父级ID,不填则默认为根目录 | |

| trainingType | 训练模式。chunk: 按文本长度进行分割;qa: QA拆分;auto: 增强训练 | ✅ |

| chunkSize | 预估块大小 | |

| chunkSplitter | 自定义最高优先分割符号 | |

| qaPrompt | qa拆分提示词 | |

| tags | 集合标签(字符串数组) | |

| createTime | 文件创建时间(Date / String) |

出参

传入一段文字,创建一个集合,会根据传入的文字进行分割。

传入一个网络链接,创建一个集合,会先去对应网页抓取内容,再抓取的文字进行分割。

传入一个文件,创建一个集合,会读取文件内容进行分割。目前支持:pdf, docx, md, txt, html, csv。

传入一个文件的 id,创建一个集合,会读取文件内容进行分割。目前支持:pdf, docx, md, txt, html, csv。

Data结构

| 字段 | 类型 | 说明 | 必填 |

|---|---|---|---|

| teamId | String | 团队ID | ✅ |

| tmbId | String | 成员ID | ✅ |

| datasetId | String | 知识库ID | ✅ |

| collectionId | String | 集合ID | ✅ |

| q | String | 主要数据 | ✅ |

| a | String | 辅助数据 | ✖ |

| fullTextToken | String | 分词 | ✖ |

| indexes | Index[] | 向量索引 | ✅ |

| updateTime | Date | 更新时间 | ✅ |

| chunkIndex | Number | 分块下表 | ✖ |

Index结构

每组数据的自定义索引最多5个

| 字段 | 类型 | 说明 | 必填 |

|---|---|---|---|

| defaultIndex | Boolean | 是否为默认索引 | ✅ |

| dataId | String | 关联的向量ID | ✅ |

| text | String | 文本内容 | ✅ |

注意,每次最多推送 200 组数据。

FastGPT OpenAPI 文档

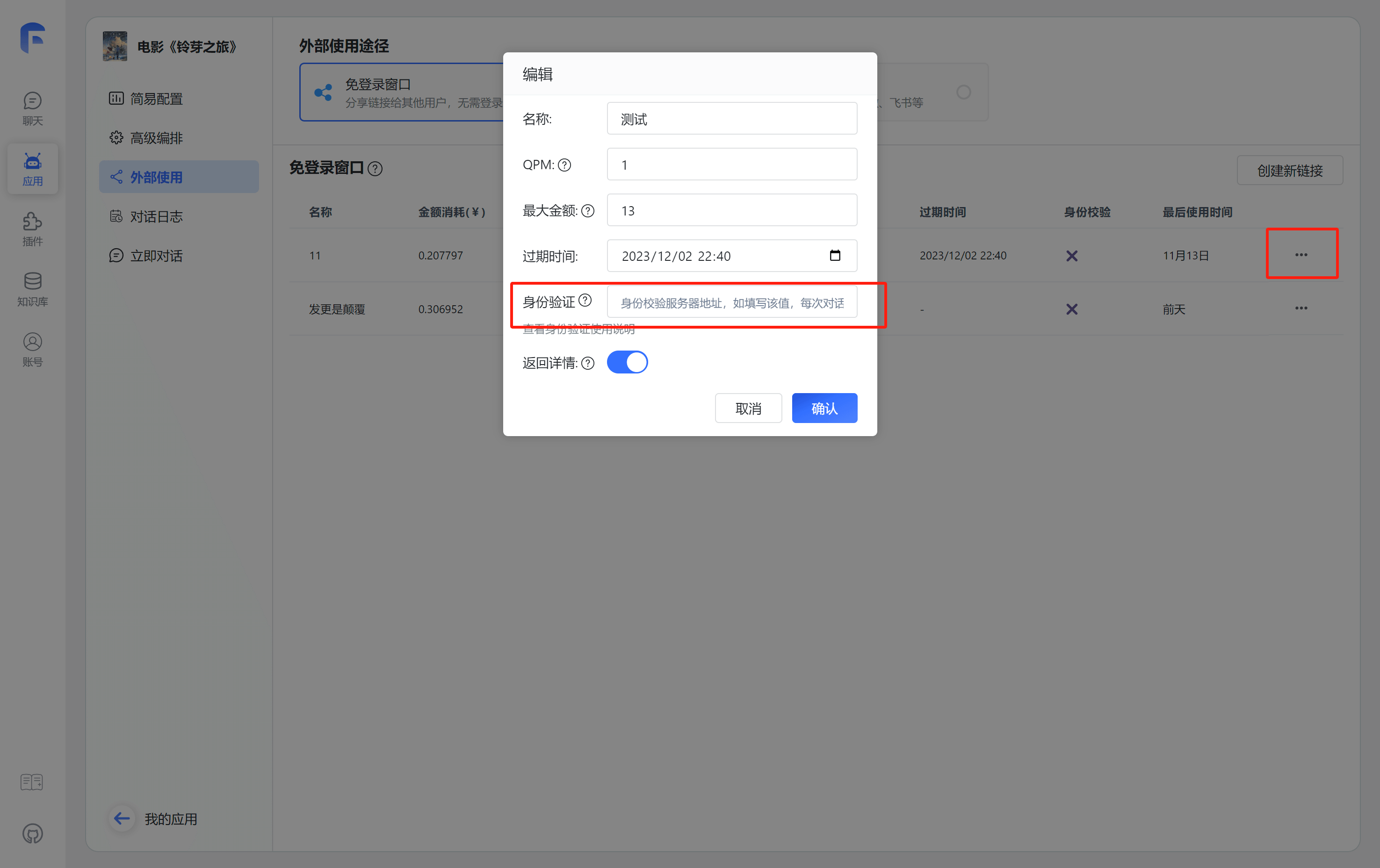

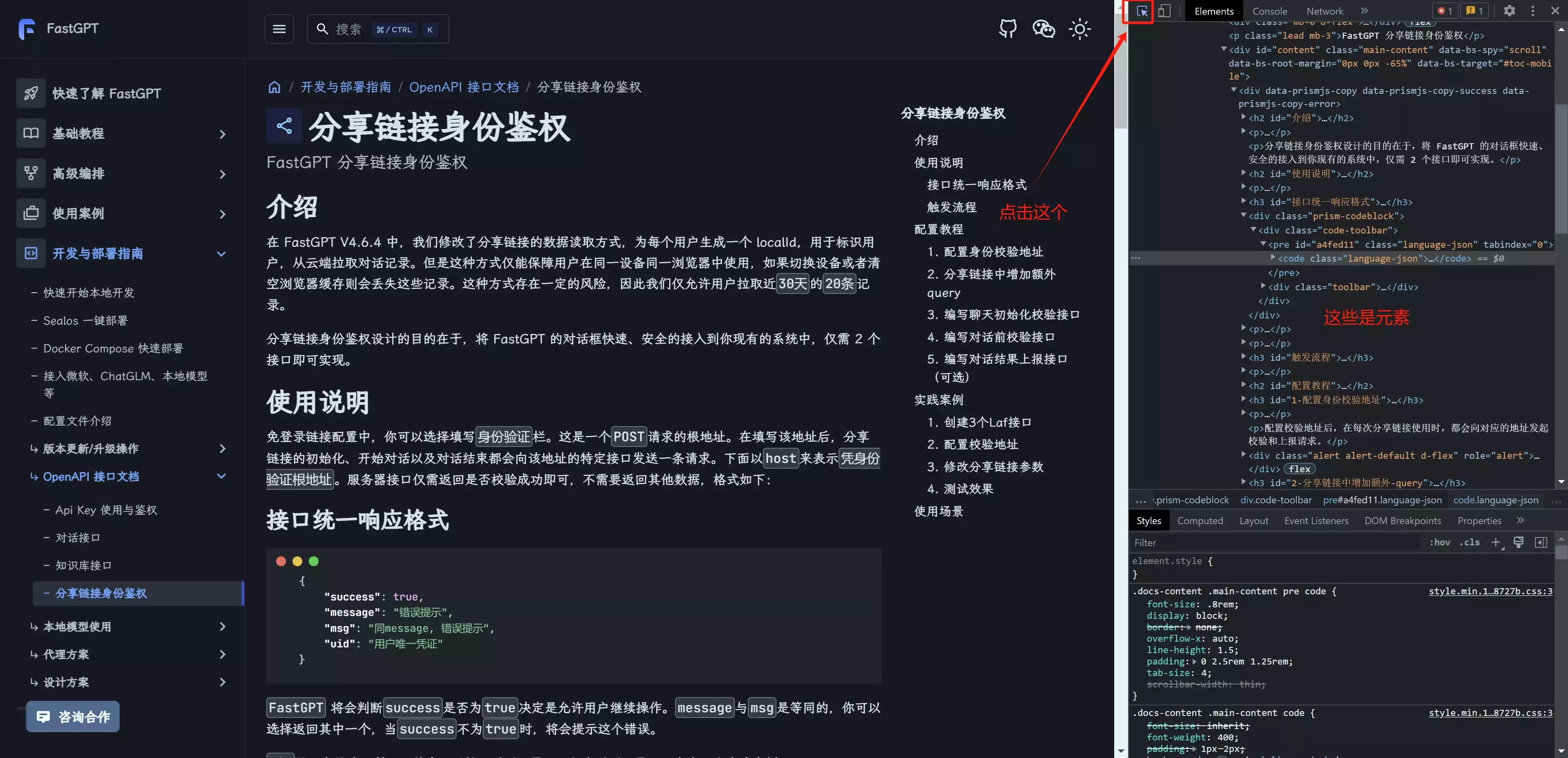

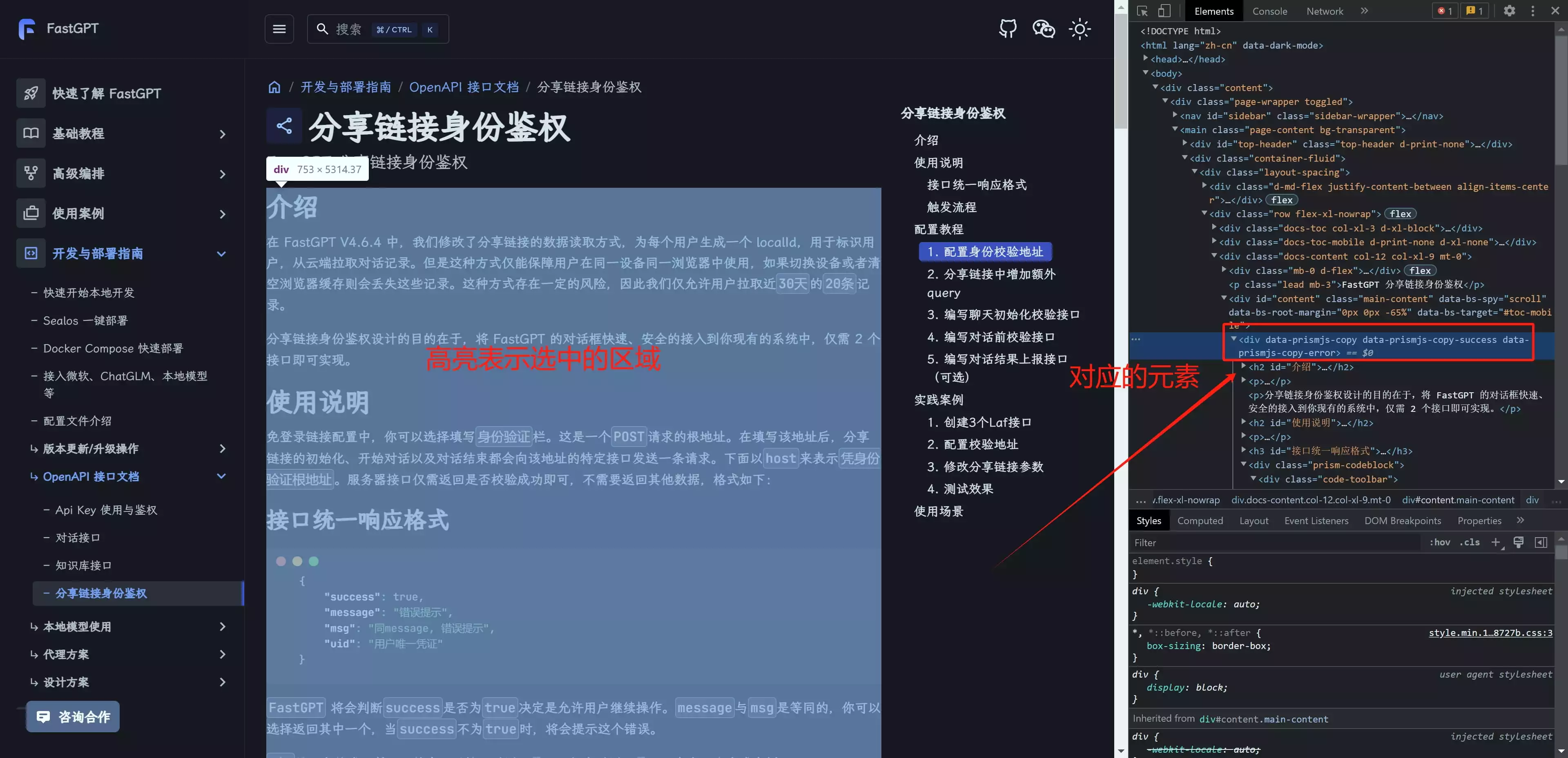

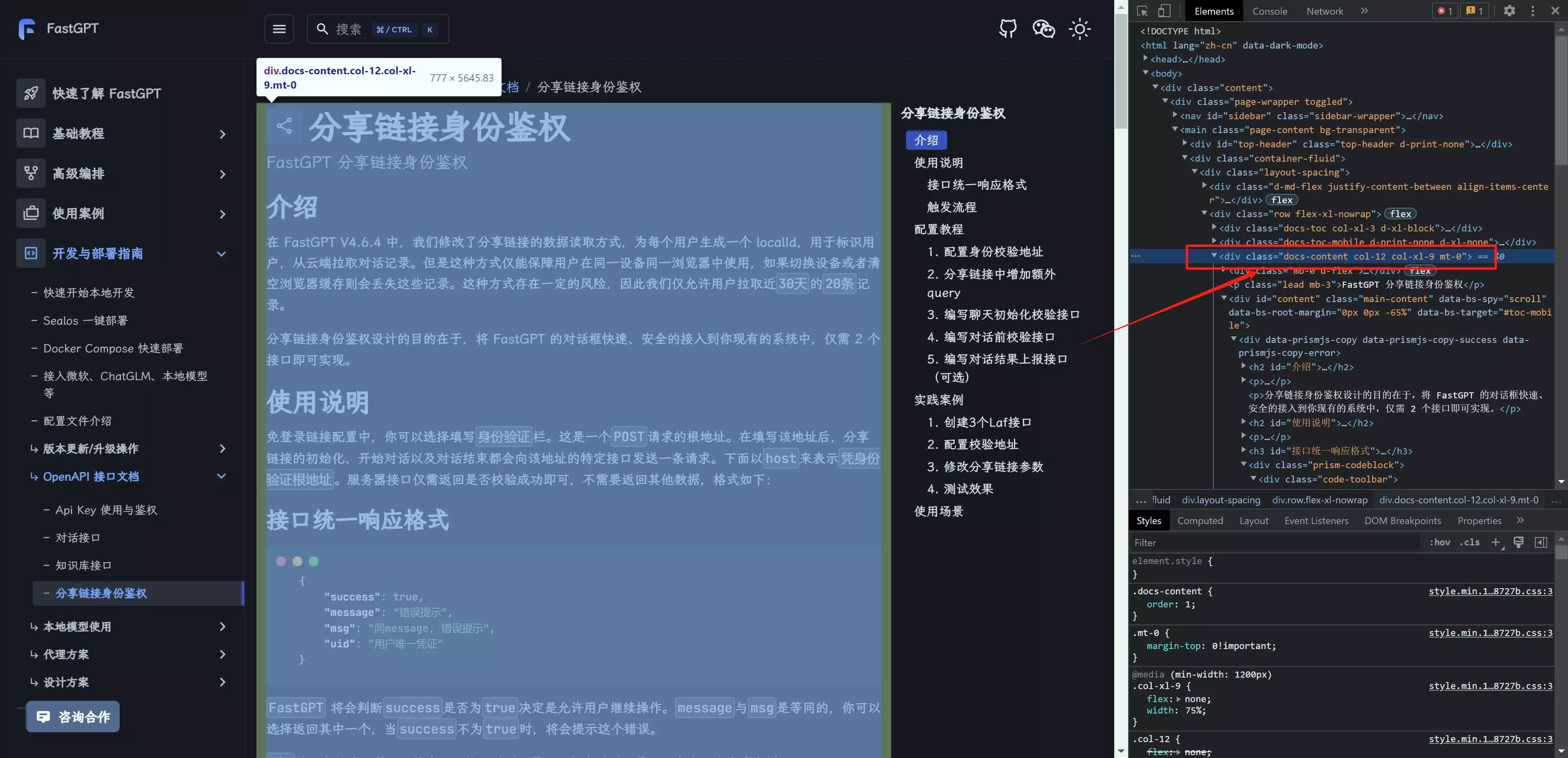

FastGPT 分享链接身份鉴权

在 FastGPT V4.6.4 中,我们修改了分享链接的数据读取方式,为每个用户生成一个 localId,用于标识用户,从云端拉取对话记录。但是这种方式仅能保障用户在同一设备同一浏览器中使用,如果切换设备或者清空浏览器缓存则会丢失这些记录。这种方式存在一定的风险,因此我们仅允许用户拉取近30天的20条记录。

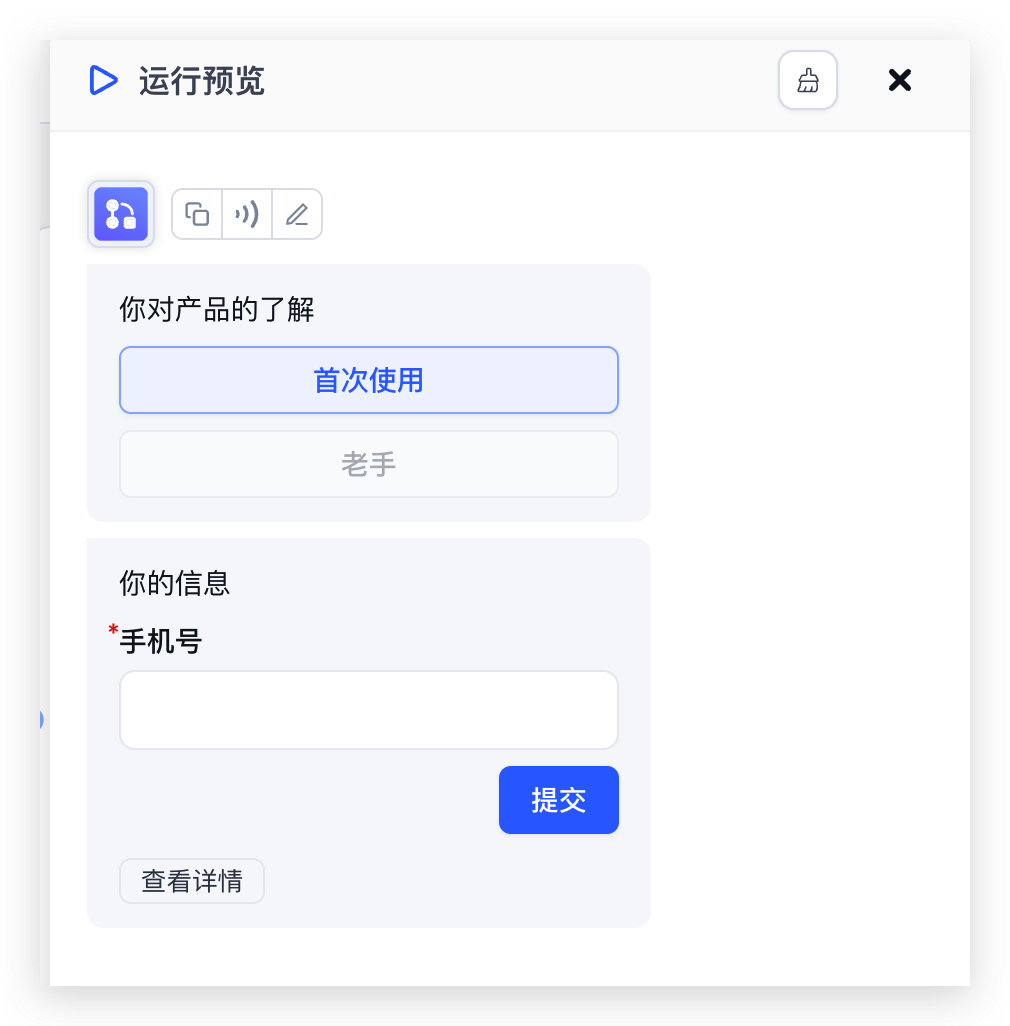

分享链接身份鉴权设计的目的在于,将 FastGPT 的对话框快速、安全的接入到你现有的系统中,仅需 2 个接口即可实现。

免登录链接配置中,你可以选择填写身份验证栏。这是一个POST请求的根地址。在填写该地址后,分享链接的初始化、开始对话以及对话结束都会向该地址的特定接口发送一条请求。下面以host来表示凭身份验证根地址。服务器接口仅需返回是否校验成功即可,不需要返回其他数据,格式如下:

+ {

+ "success": true,

+ "message": "错误提示",

+ "msg": "同message, 错误提示",

+ "data": {

+ "uid": "用户唯一凭证"

+ }

+}

+ FastGPT 将会判断success是否为true决定是允许用户继续操作。message与msg是等同的,你可以选择返回其中一个,当success不为true时,将会提示这个错误。

uid是用户的唯一凭证,将会用于拉取对话记录以及保存对话记录。可参考下方实践案例。

配置校验地址后,在每次分享链接使用时,都会向对应的地址发起校验和上报请求。

这里仅需配置根地址,无需具体到完整请求路径。

在分享链接的地址中,增加一个额外的参数: authToken。例如:

原始的链接:https://share.tryfastgpt.ai/chat/share?shareId=648aaf5ae121349a16d62192

完整链接: https://share.tryfastgpt.ai/chat/share?shareId=648aaf5ae121349a16d62192&authToken=userid12345

这个authToken通常是你系统生成的用户唯一凭证(Token之类的)。FastGPT 会在鉴权接口的body中携带 token={{authToken}} 的参数。

该接口无规定返回值。

响应值与chat 接口格式相同,仅多了一个token。

重点关注:totalPoints(总消耗AI积分),token(Token消耗总数)

+ curl --location --request POST '{{host}}/shareAuth/finish' \

+--header 'Content-Type: application/json' \

+--data-raw '{

+ "token": "{{authToken}}",

+ "responseData": [

+ {

+ "moduleName": "core.module.template.Dataset search",

+ "moduleType": "datasetSearchNode",

+ "totalPoints": 1.5278,

+ "query": "导演是谁\n《铃芽之旅》的导演是谁?\n这部电影的导演是谁?\n谁是《铃芽之旅》的导演?",

+ "model": "Embedding-2(旧版,不推荐使用)",

+ "tokens": 1524,

+ "similarity": 0.83,

+ "limit": 400,

+ "searchMode": "embedding",

+ "searchUsingReRank": false,

+ "extensionModel": "FastAI-4k",

+ "extensionResult": "《铃芽之旅》的导演是谁?\n这部电影的导演是谁?\n谁是《铃芽之旅》的导演?",

+ "runningTime": 2.15

+ },

+ {

+ "moduleName": "AI 对话",

+ "moduleType": "chatNode",

+ "totalPoints": 0.593,

+ "model": "FastAI-4k",

+ "tokens": 593,

+ "query": "导演是谁",

+ "maxToken": 2000,

+ "quoteList": [

+ {

+ "id": "65bb346a53698398479a8854",

+ "q": "导演是谁?",

+ "a": "电影《铃芽之旅》的导演是新海诚。",

+ "chunkIndex": 0,

+ "datasetId": "65af9b947916ae0e47c834d2",

+ "collectionId": "65bb345c53698398479a868f",

+ "sourceName": "dataset - 2024-01-23T151114.198.csv",

+ "sourceId": "65bb345b53698398479a868d",

+ "score": [

+ {

+ "type": "embedding",

+ "value": 0.9377183318138123,

+ "index": 0

+ },

+ {

+ "type": "rrf",

+ "value": 0.06557377049180328,

+ "index": 0

+ }

+ ]

+ }

+ ],

+ "historyPreview": [

+ {

+ "obj": "Human",

+ "value": "使用 <Data></Data> 标记中的内容作为本次对话的参考:\n\n<Data>\n导演是谁?\n电影《铃芽之旅》的导演是新海诚。\n------\n电影《铃芽之旅》的编剧是谁?22\n新海诚是本片的编剧。\n------\n电影《铃芽之旅》的女主角是谁?\n电影的女主角是铃芽。\n------\n电影《铃芽之旅》的制作团队中有哪位著名人士?2\n川村元气是本片的制作团队成员之一。\n------\n你是谁?\n我是电影《铃芽之旅》助手\n------\n电影《铃芽之旅》男主角是谁?\n电影《铃芽之旅》男主角是宗像草太,由松村北斗配音。\n------\n电影《铃芽之旅》的作者新海诚写了一本小说,叫什么名字?\n小说名字叫《铃芽之旅》。\n------\n电影《铃芽之旅》的女主角是谁?\n电影《铃芽之旅》的女主角是岩户铃芽,由原菜乃华配音。\n------\n电影《铃芽之旅》的故事背景是什么?\n日本\n------\n谁担任电影《铃芽之旅》中岩户环的配音?\n深津绘里担任电影《铃芽之旅》中岩户环的配音。\n</Data>\n\n回答要求:\n- 如果你不清楚答案,你需要澄清。\n- 避免提及你是从 <Data></Data> 获取的知识。\n- 保持答案与 <Data></Data> 中描述的一致。\n- 使用 Markdown 语法优化回答格式。\n- 使用与问题相同的语言回答。\n\n问题:\"\"\"导演是谁\"\"\""

+ },

+ {

+ "obj": "AI",

+ "value": "电影《铃芽之旅》的导演是新海诚。"

+ }

+ ],

+ "contextTotalLen": 2,

+ "runningTime": 1.32

+ }

+ ]

+

+

+}'

+ responseData 完整字段说明:

+ type ResponseType = {

+ moduleType: FlowNodeTypeEnum; // 模块类型

+ moduleName: string; // 模块名

+ moduleLogo?: string; // logo

+ runningTime?: number; // 运行时间

+ query?: string; // 用户问题/检索词

+ textOutput?: string; // 文本输出

+

+ tokens?: number; // 上下文总Tokens

+ model?: string; // 使用到的模型

+ contextTotalLen?: number; // 上下文总长度

+ totalPoints?: number; // 总消耗AI积分

+

+ temperature?: number; // 温度

+ maxToken?: number; // 模型的最大token

+ quoteList?: SearchDataResponseItemType[]; // 引用列表

+ historyPreview?: ChatItemType[]; // 上下文预览(历史记录会被裁剪)

+

+ similarity?: number; // 最低相关度

+ limit?: number; // 引用上限token

+ searchMode?: `${DatasetSearchModeEnum}`; // 搜索模式

+ searchUsingReRank?: boolean; // 是否使用rerank

+ extensionModel?: string; // 问题扩展模型

+ extensionResult?: string; // 问题扩展结果

+ extensionTokens?: number; // 问题扩展总字符长度

+

+ cqList?: ClassifyQuestionAgentItemType[]; // 分类问题列表

+ cqResult?: string; // 分类问题结果

+

+ extractDescription?: string; // 内容提取描述

+ extractResult?: Record<string, any>; // 内容提取结果

+

+ params?: Record<string, any>; // HTTP模块params

+ body?: Record<string, any>; // HTTP模块body

+ headers?: Record<string, any>; // HTTP模块headers

+ httpResult?: Record<string, any>; // HTTP模块结果

+

+ pluginOutput?: Record<string, any>; // 插件输出

+ pluginDetail?: ChatHistoryItemResType[]; // 插件详情

+

+ isElseResult?: boolean; // 判断器结果

+}

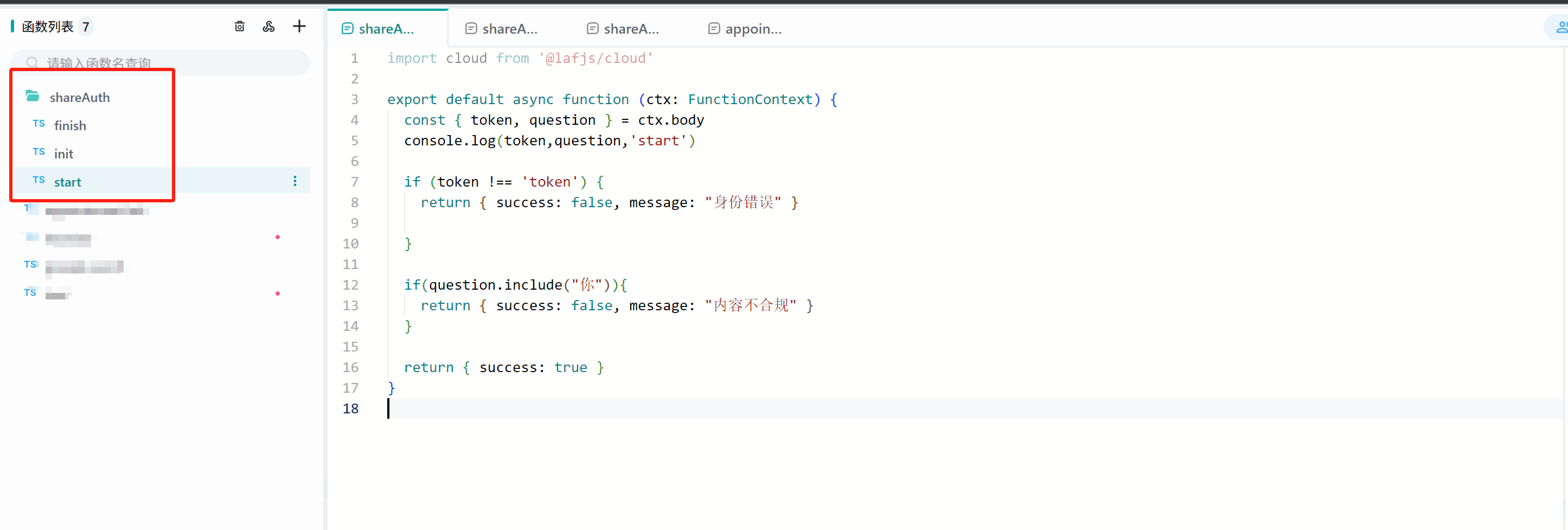

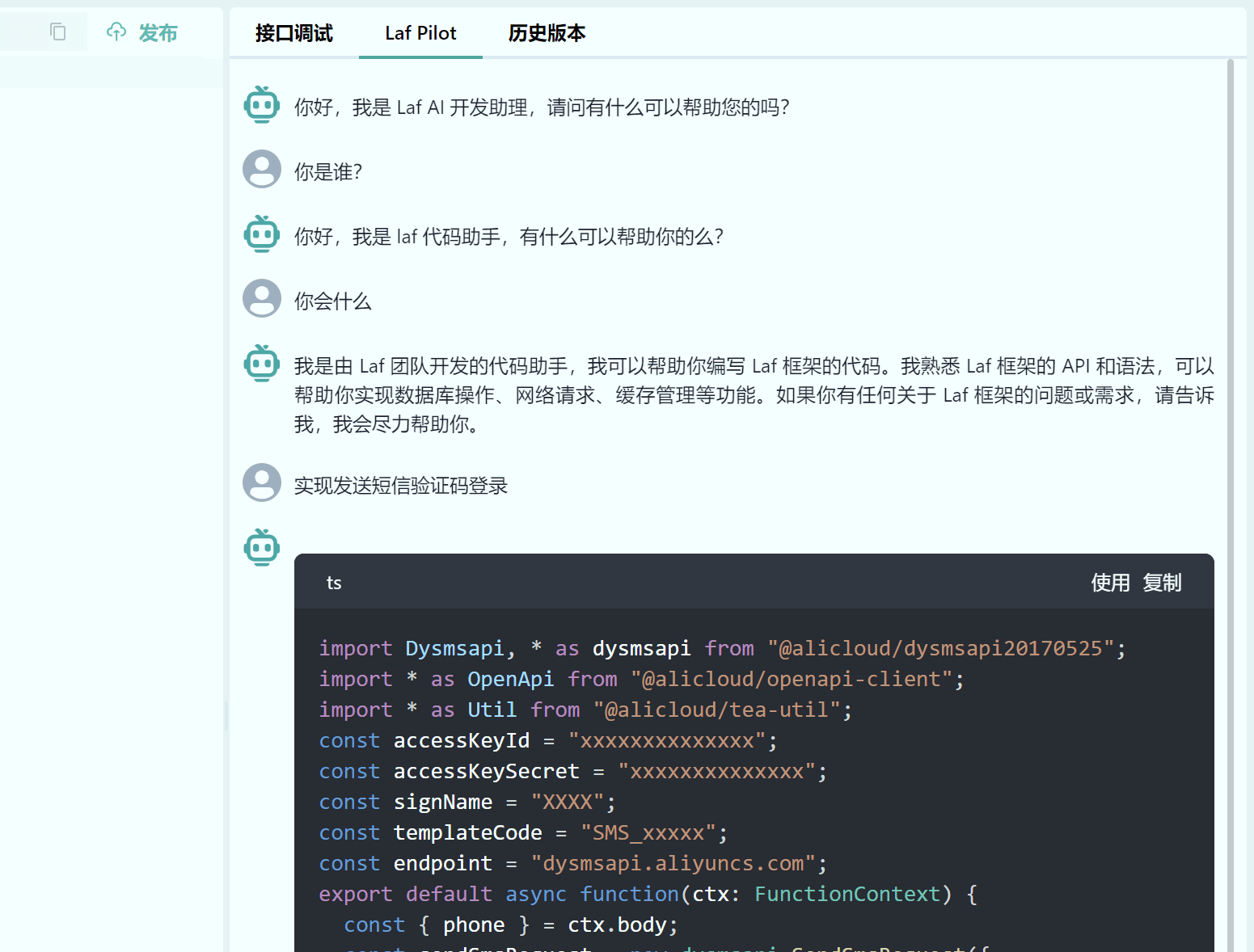

+ 我们以Laf作为服务器为例,简单展示这 3 个接口的使用方式。

我们随便复制3个地址中一个接口: https://d8dns0.laf.dev/shareAuth/finish, 去除/shareAuth/finish后填入身份校验:https://d8dns0.laf.dev

源分享链接:https://share.tryfastgpt.ai/chat/share?shareId=64be36376a438af0311e599c

修改后:https://share.tryfastgpt.ai/chat/share?shareId=64be36376a438af0311e599c&authToken=fastgpt

authToken不等于fastgpt的链接会提示身份错误。这个鉴权方式通常是帮助你直接嵌入分享链接到你的应用中,在你的应用打开分享链接前,应做authToken的拼接后再打开。

除了对接已有系统的用户外,你还可以对接余额功能,通过结果上报接口扣除用户余额,通过对话前校验接口检查用户的余额。

使用 Cloudflare Worker 实现中转

workers 配置文件

+ const TELEGRAPH_URL = 'https://api.openai.com';

+

+addEventListener('fetch', (event) => {

+ event.respondWith(handleRequest(event.request));

+});

+

+async function handleRequest(request) {

+ // 安全校验

+ if (request.headers.get('auth') !== 'auth_code') {

+ return new Response('UnAuthorization', { status: 403 });

+ }

+

+ const url = new URL(request.url);

+ url.host = TELEGRAPH_URL.replace(/^https?:\/\//, '');

+

+ const modifiedRequest = new Request(url.toString(), {

+ headers: request.headers,

+ method: request.method,

+ body: request.body,

+ redirect: 'follow'

+ });

+

+ const response = await fetch(modifiedRequest);

+ const modifiedResponse = new Response(response.body, response);

+

+ // 添加允许跨域访问的响应头

+ modifiedResponse.headers.set('Access-Control-Allow-Origin', '*');

+

+ return modifiedResponse;

+}

+ 修改 FastGPT 的环境变量

务必别忘了填 v1!

+ OPENAI_BASE_URL=https://xxxxxx/v1

+OPENAI_BASE_URL_AUTH=auth_code

+ 使用 HTTP 代理实现中转

如果你有代理工具(例如 Clash 或者 sing-box),也可以使用 HTTP 代理来访问 OpenAI。只需要添加以下两个环境变量即可:

+ AXIOS_PROXY_HOST=

+AXIOS_PROXY_PORT=

+ 以 Clash 为例,建议指定 api.openai.com 走代理,其他请求都直连。示例配置如下:

+ mixed-port: 7890

+allow-lan: false

+bind-address: '*'

+mode: rule

+log-level: warning

+dns:

+ enable: true

+ ipv6: false

+ nameserver:

+ - 8.8.8.8

+ - 8.8.4.4

+ cache-size: 400

+proxies:

+ -

+proxy-groups:

+ - { name: '♻️ 自动选择', type: url-test, proxies: [香港V01×1.5], url: 'https://api.openai.com', interval: 3600}

+rules:

+ - 'DOMAIN-SUFFIX,api.openai.com,♻️ 自动选择'

+ - 'MATCH,DIRECT'

+ 然后给 FastGPT 添加两个环境变量:

+ AXIOS_PROXY_HOST=127.0.0.1

+AXIOS_PROXY_PORT=7890

+ FastGPT 私有化部署代理方案

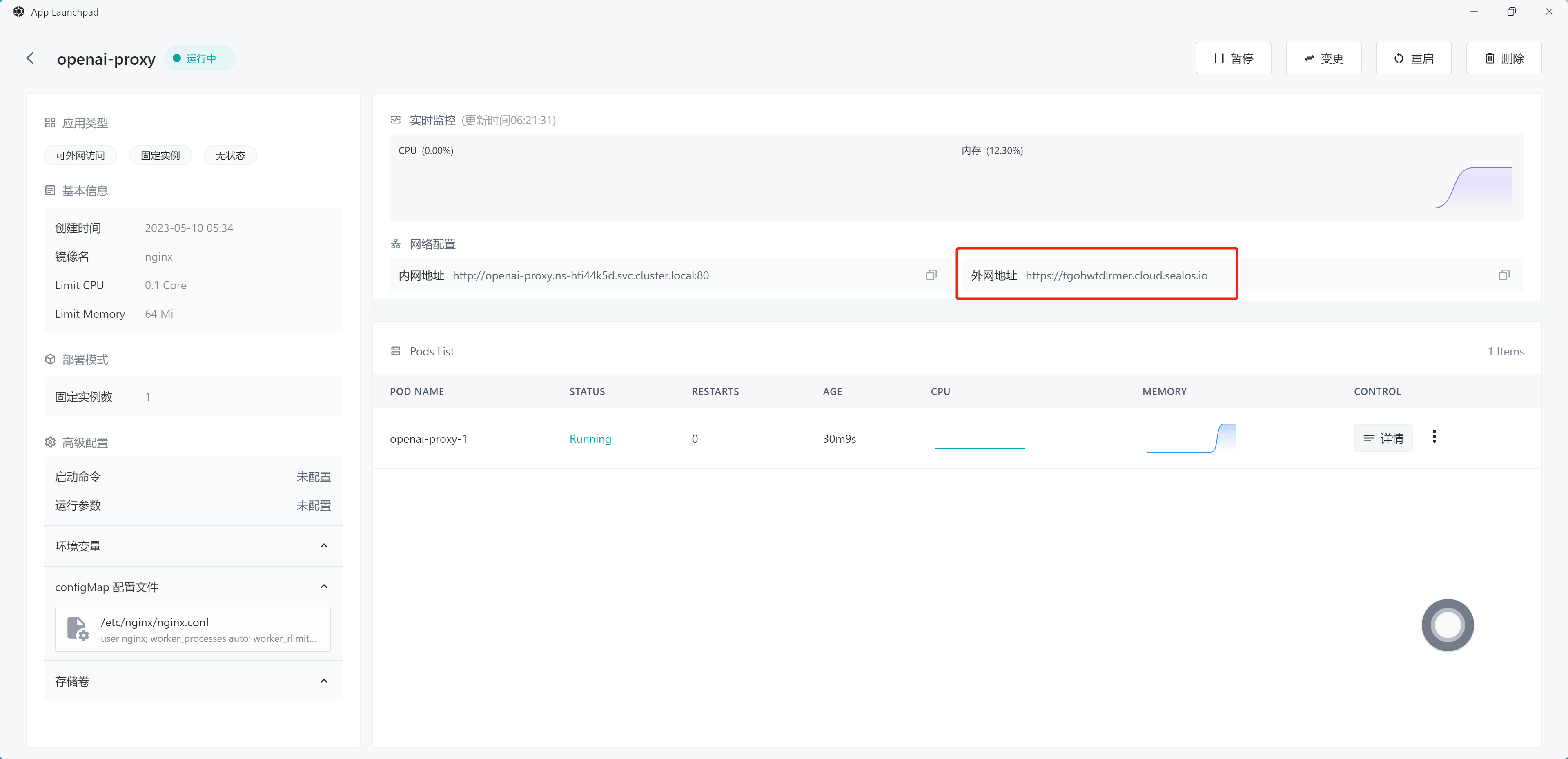

使用 Sealos 部署 Nginx 实现中转

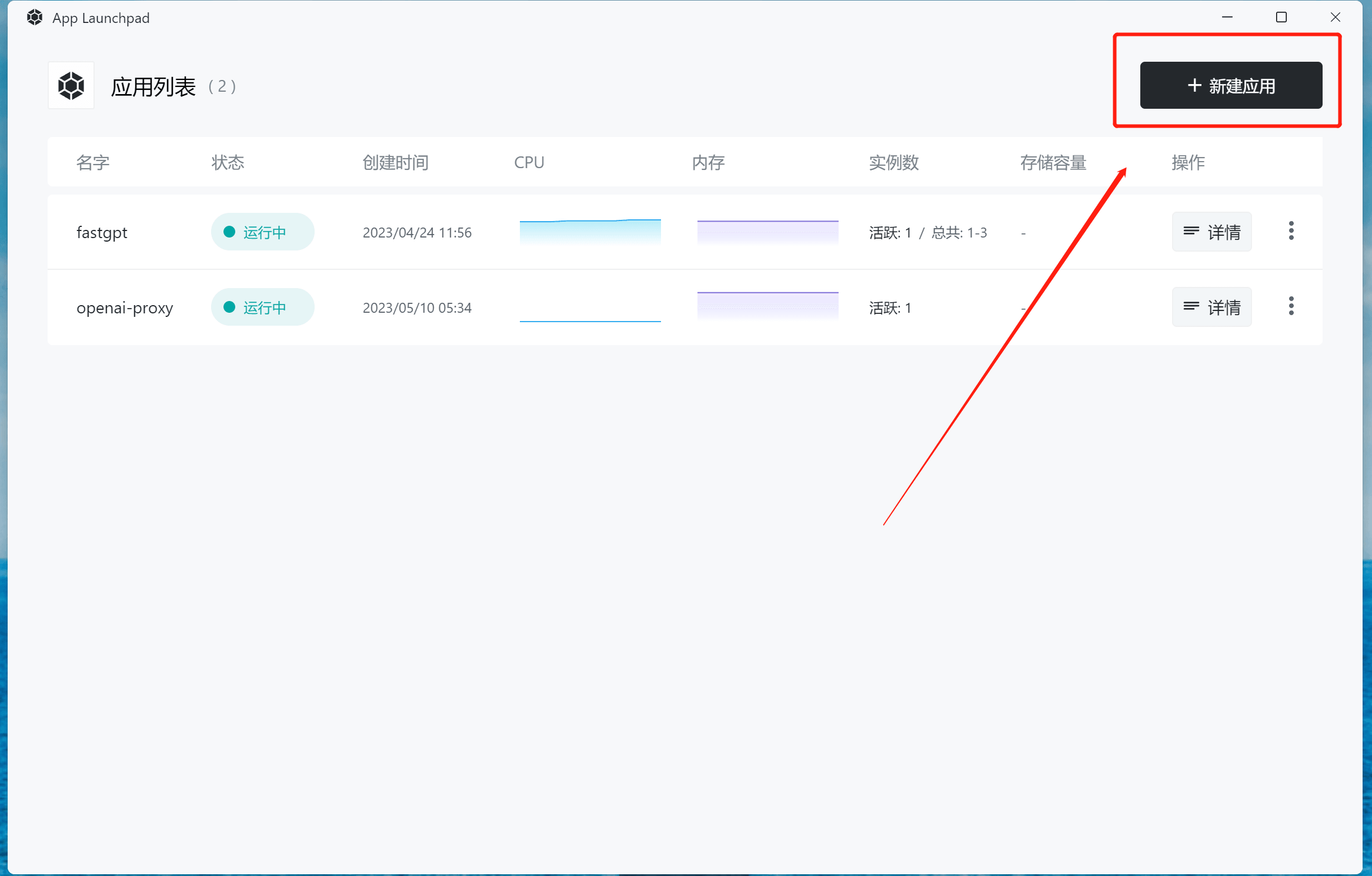

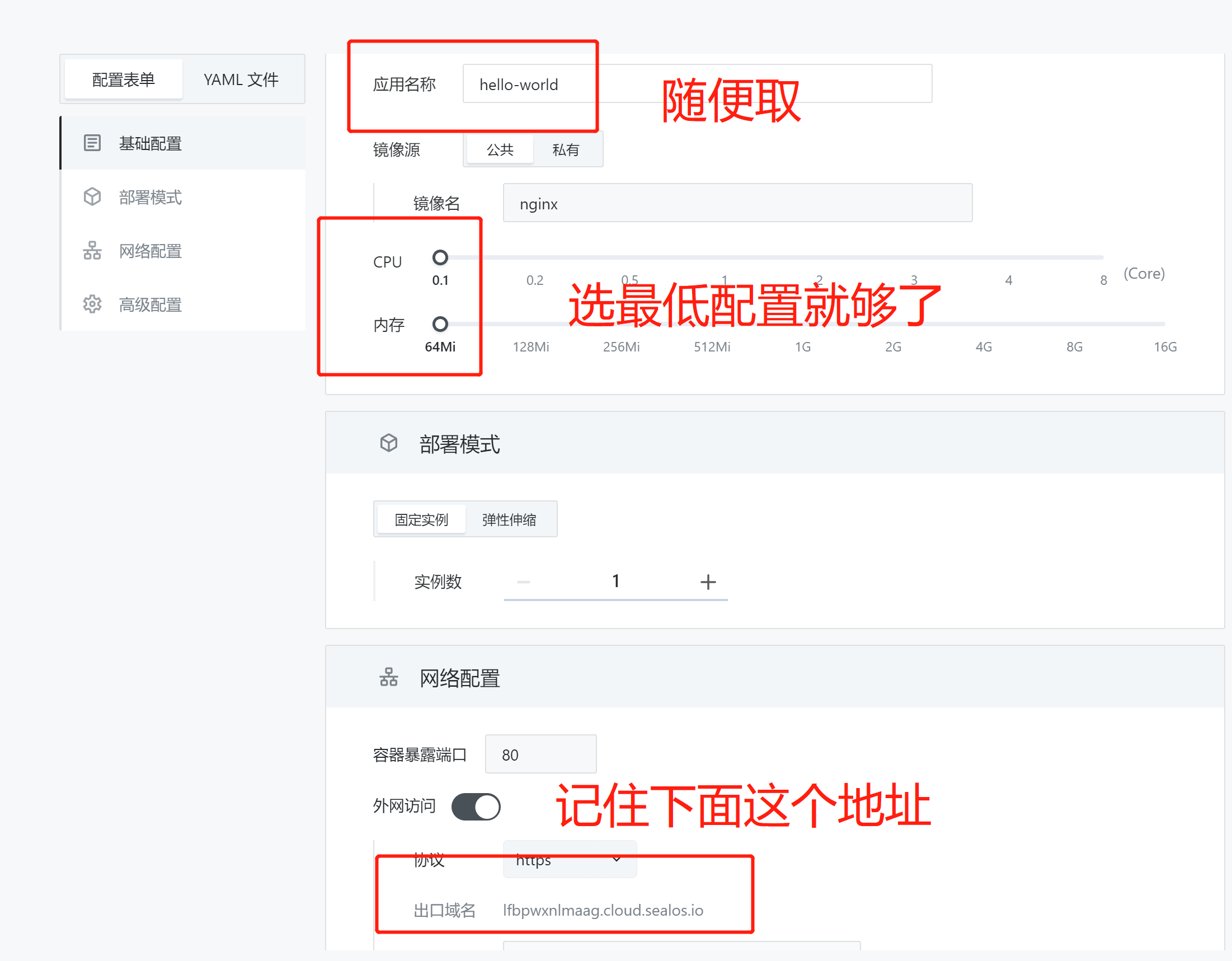

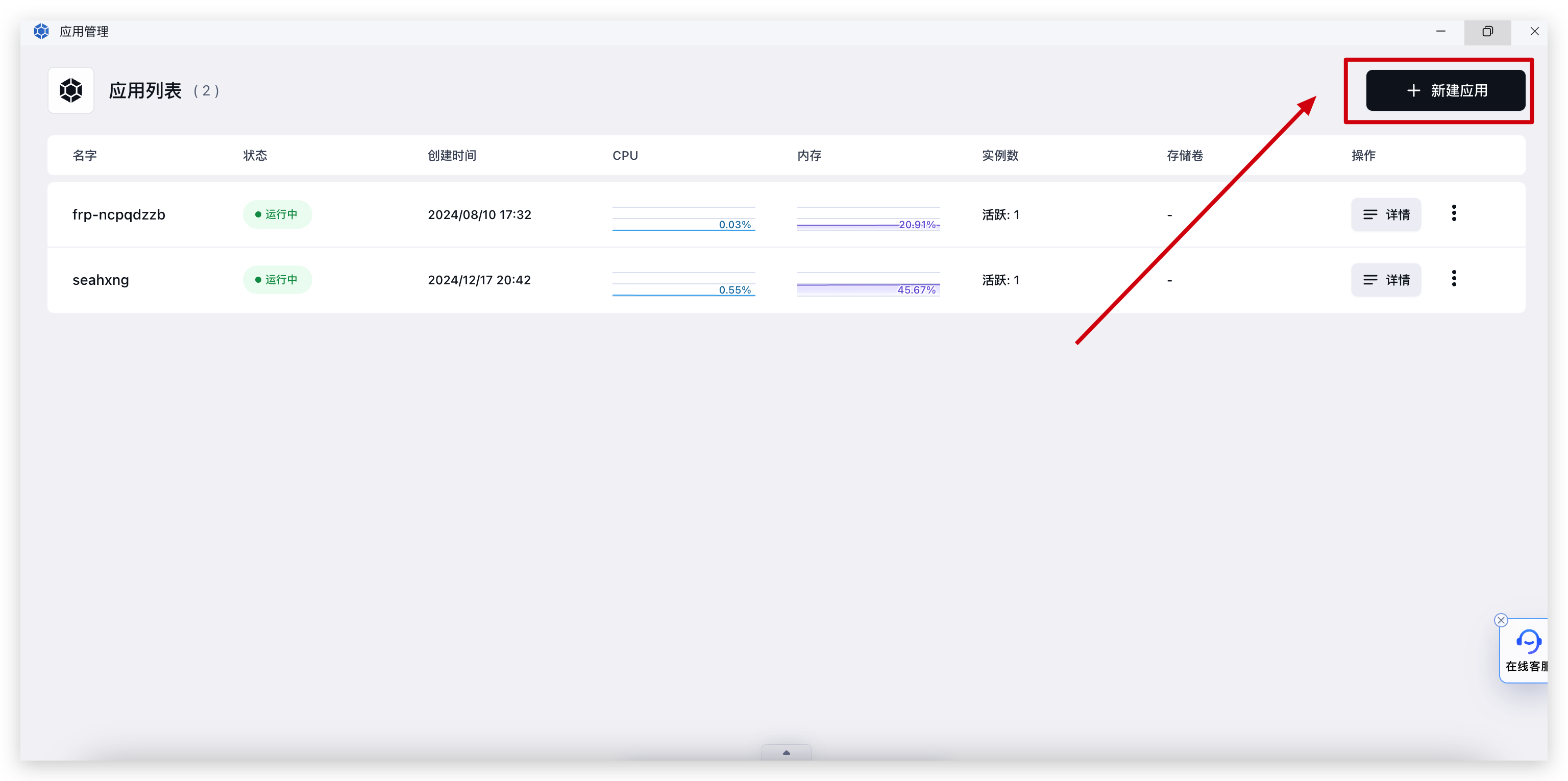

打开 「应用管理」,点击「新建应用」:

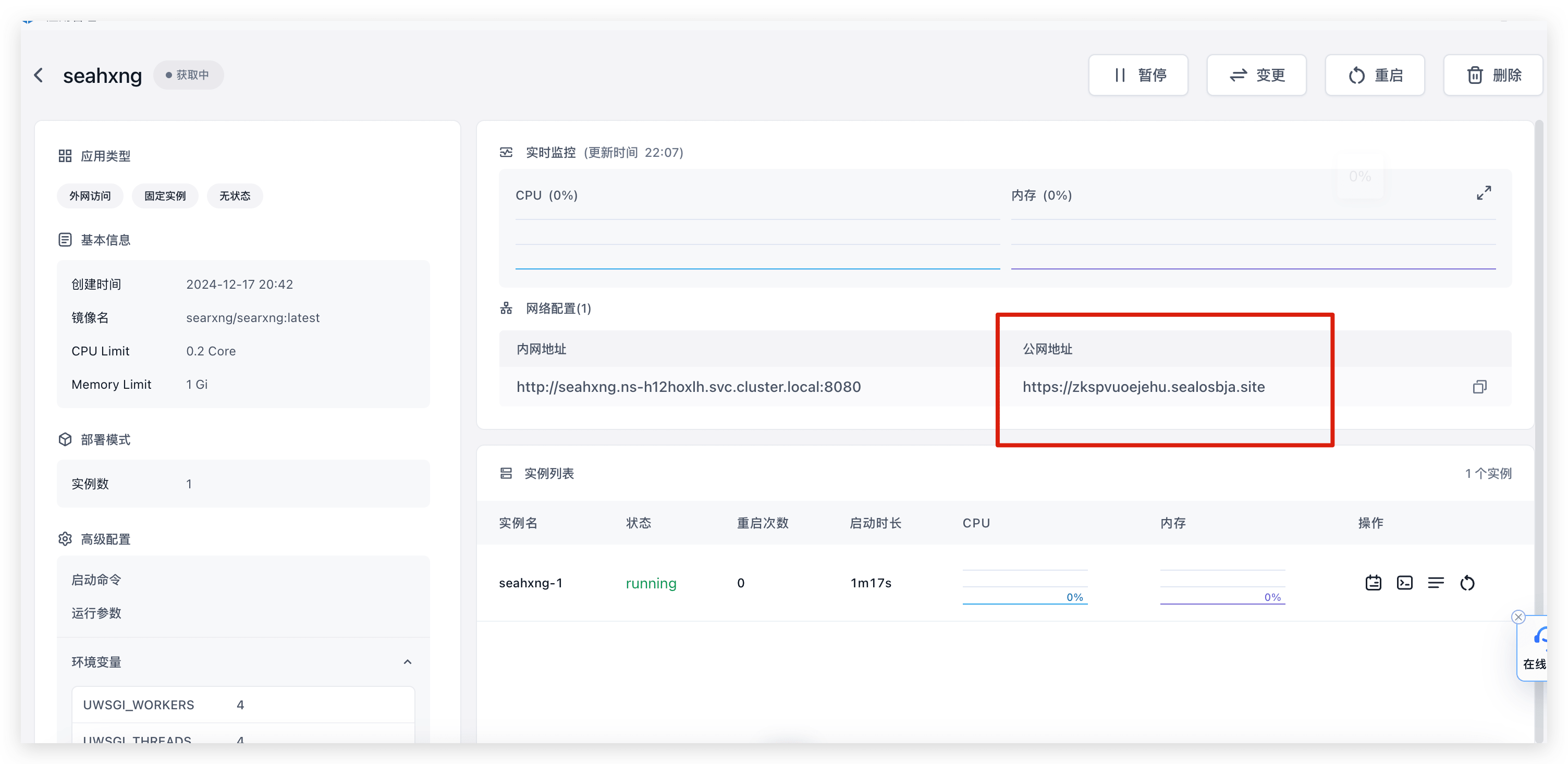

务必开启外网访问,复制外网访问提供的地址。

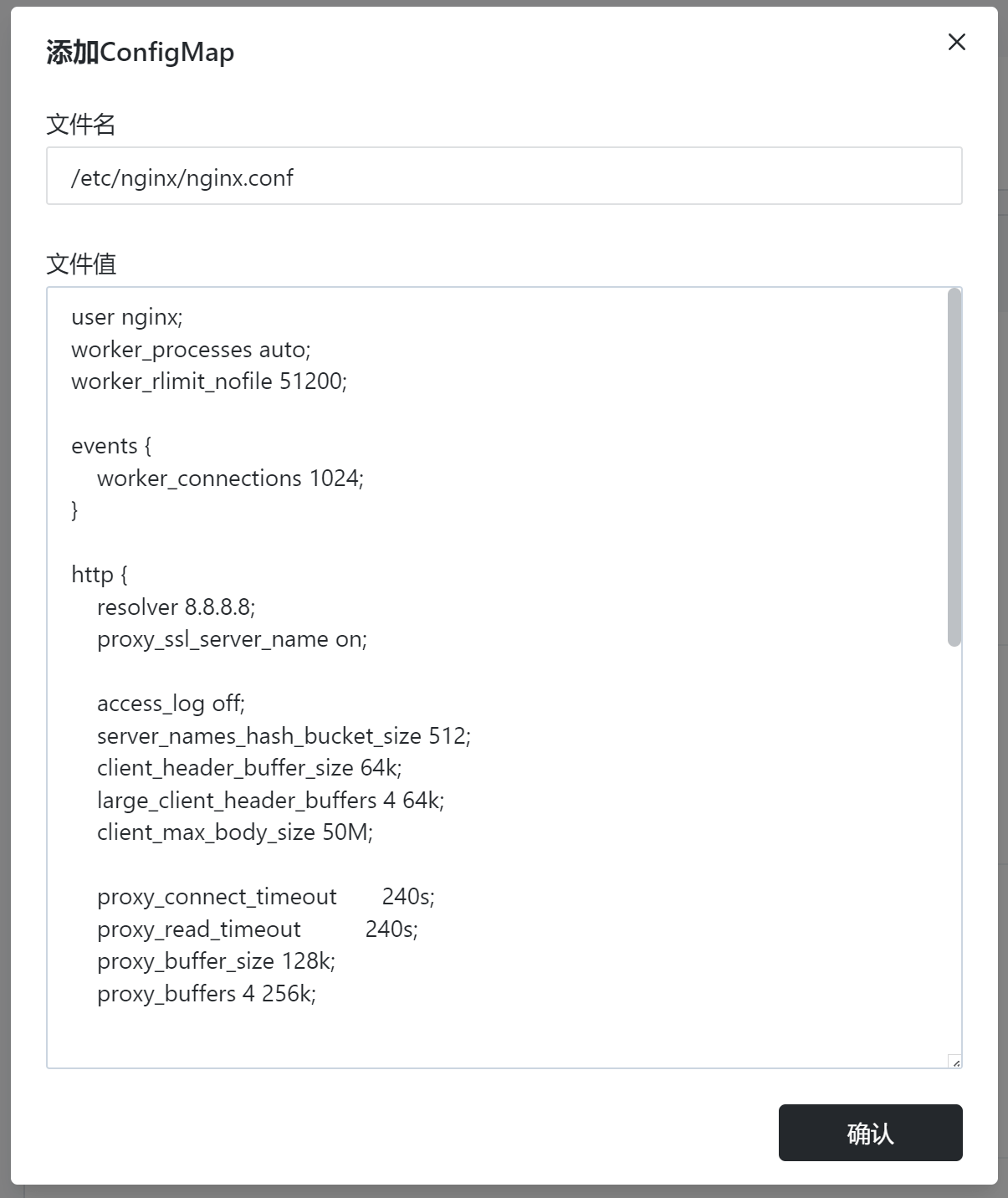

复制下面这段配置文件,注意 server_name 后面的内容替换成第二步的外网访问地址。

+ user nginx;

+worker_processes auto;

+worker_rlimit_nofile 51200;

+

+events {

+ worker_connections 1024;

+}

+

+http {

+ resolver 8.8.8.8;

+ proxy_ssl_server_name on;

+

+ access_log off;

+ server_names_hash_bucket_size 512;

+ client_header_buffer_size 64k;

+ large_client_header_buffers 4 64k;

+ client_max_body_size 50M;

+

+ proxy_connect_timeout 240s;

+ proxy_read_timeout 240s;

+ proxy_buffer_size 128k;

+ proxy_buffers 4 256k;

+

+ server {

+ listen 80;

+ server_name tgohwtdlrmer.cloud.sealos.io; # 这个地方替换成 Sealos 提供的外网地址

+

+ location ~ /openai/(.*) {

+ proxy_pass https://api.openai.com/$1$is_args$args;

+ proxy_set_header Host api.openai.com;

+ proxy_set_header X-Real-IP $remote_addr;

+ proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

+ # 如果响应是流式的

+ proxy_set_header Connection '';

+ proxy_http_version 1.1;

+ chunked_transfer_encoding off;

+ proxy_buffering off;

+ proxy_cache off;

+ # 如果响应是一般的

+ proxy_buffer_size 128k;

+ proxy_buffers 4 256k;

+ proxy_busy_buffers_size 256k;

+ }

+ }

+}

+ 点开高级配置。

点击「新增配置文件」。

文件名写: /etc/nginx/nginx.conf。

文件值为刚刚复制的那段代码。

点击确认。

填写完毕后,点击右上角的「部署」,即可完成部署。

进入刚刚部署应用的详情,复制外网地址

注意:这是个 API 地址,点击打开是无效的。如需验证,可以访问:

*.cloud.sealos.io/openai/api,如果提示Invalid URL (GET /api)则代表成功。

修改环境变量(是 FastGPT 的环境变量,不是 Sealos 的):

+ OPENAI_BASE_URL=https://tgohwtdlrmer.cloud.sealos.io/openai/v1

+ Done!

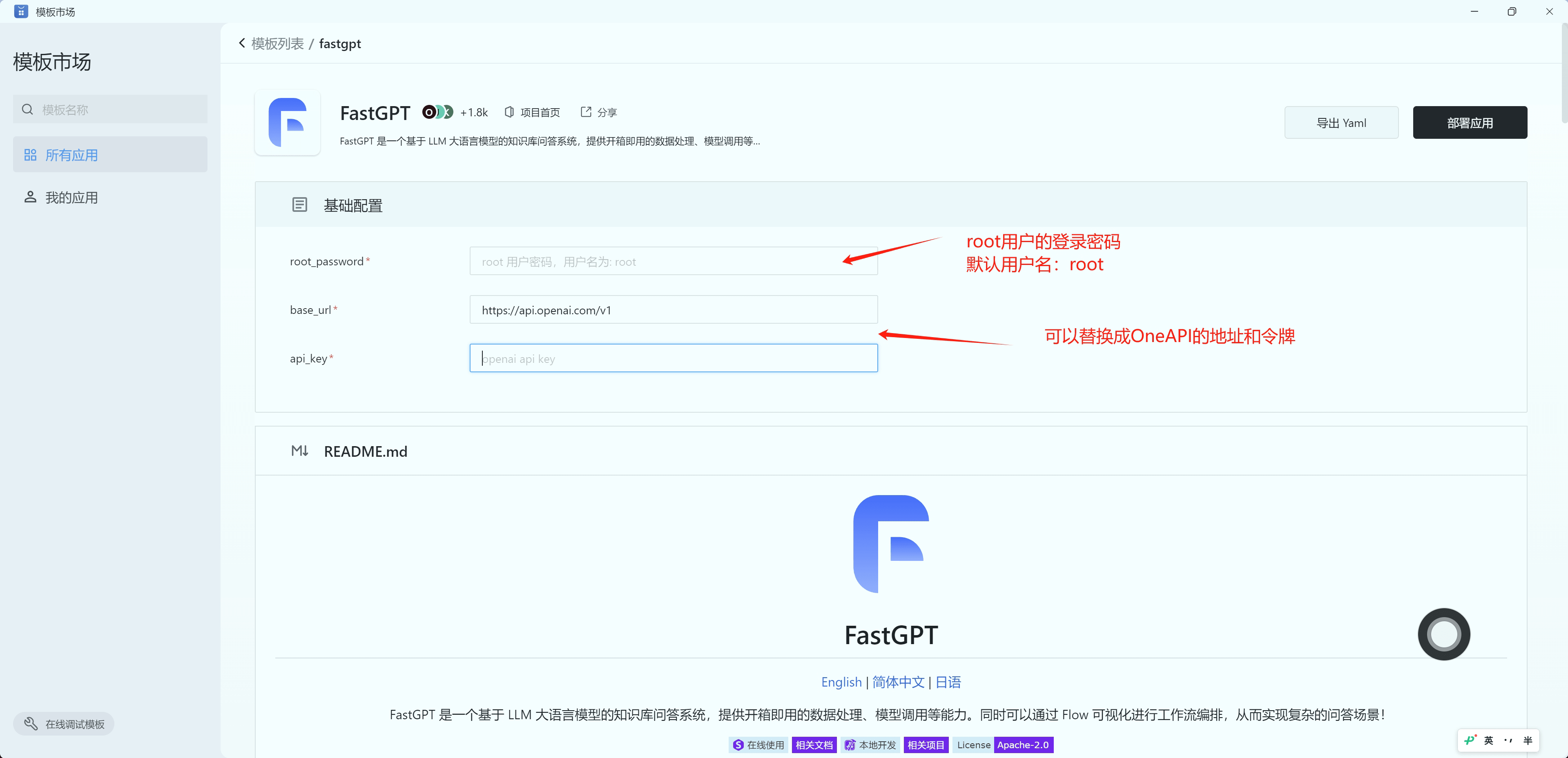

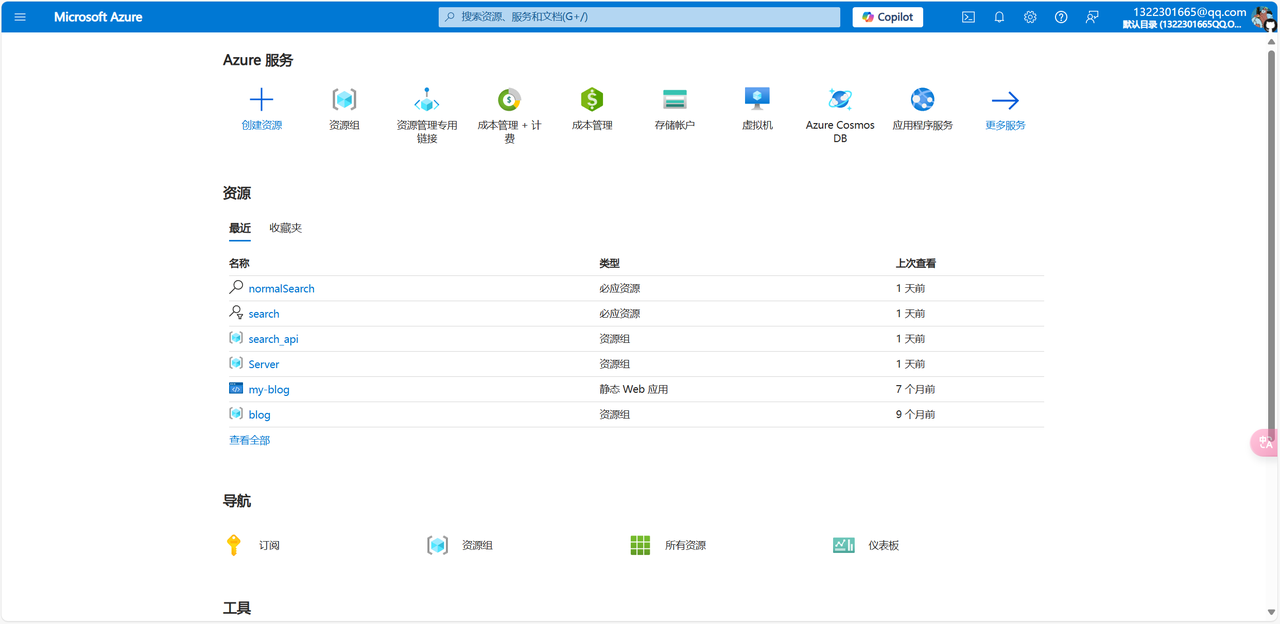

使用 Sealos 一键部署 FastGPT

FastGPT 使用了 one-api 项目来管理模型池,其可以兼容 OpenAI 、Azure 、国内主流模型和本地模型等。

使用 Sealos 服务,无需采购服务器、无需域名,支持高并发 & 动态伸缩,并且数据库应用采用 kubeblocks 的数据库,在 IO 性能方面,远超于简单的 Docker 容器部署。可以根据需求,再下面两个区域选择部署。

新加披区的服务器在国外,可以直接访问 OpenAI,但国内用户需要梯子才可以正常访问新加坡区。国际区价格稍贵,点击下面按键即可部署👇

北京区服务提供商为火山云,国内用户可以稳定访问,但无法访问 OpenAI 等境外服务,价格约为新加坡区的 1/4。点击下面按键即可部署👇

由于需要部署数据库,部署完后需要等待 2~4 分钟才能正常访问。默认用了最低配置,首次访问时会有些慢。

根据提示,输入root_password,和 openai/oneapi 的地址和密钥。

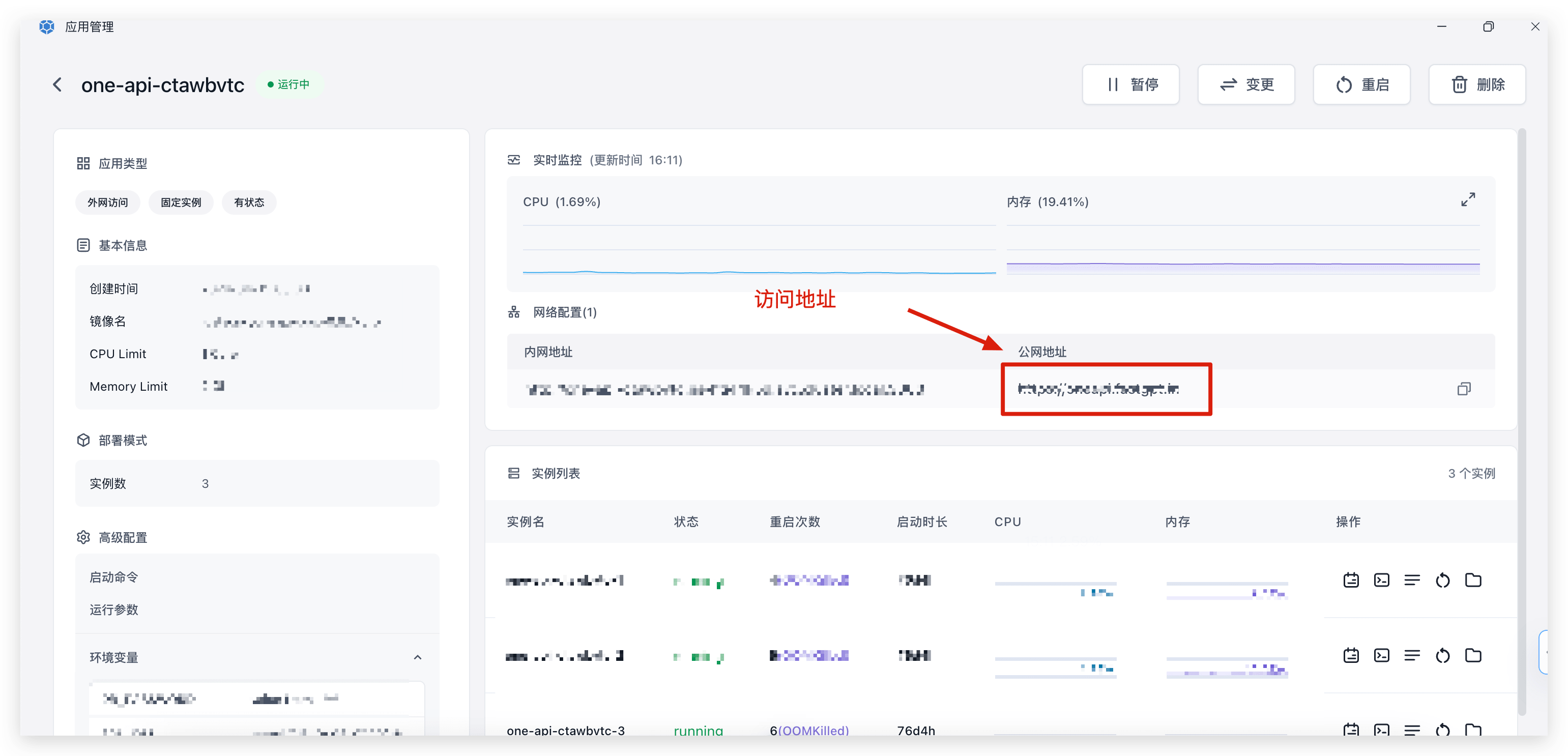

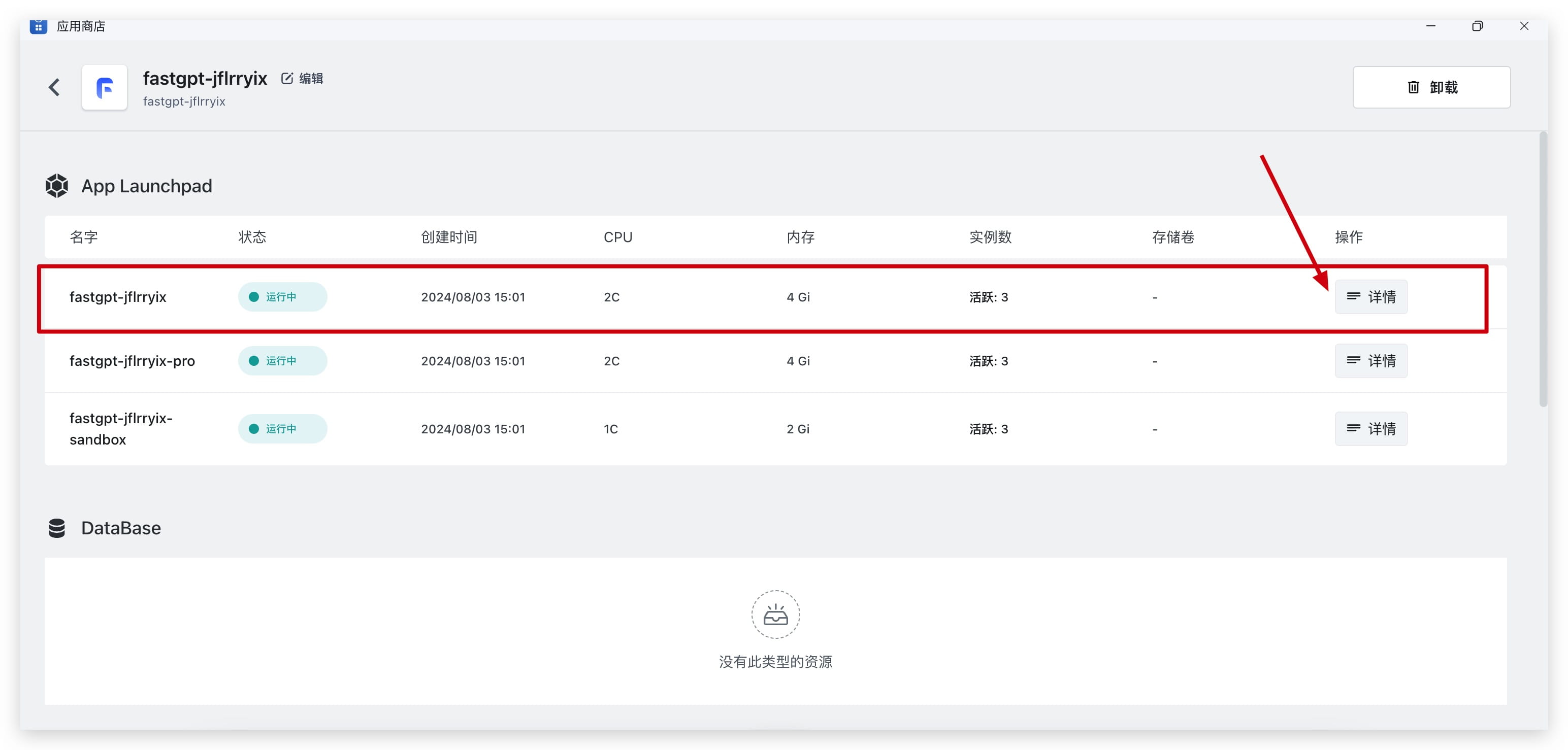

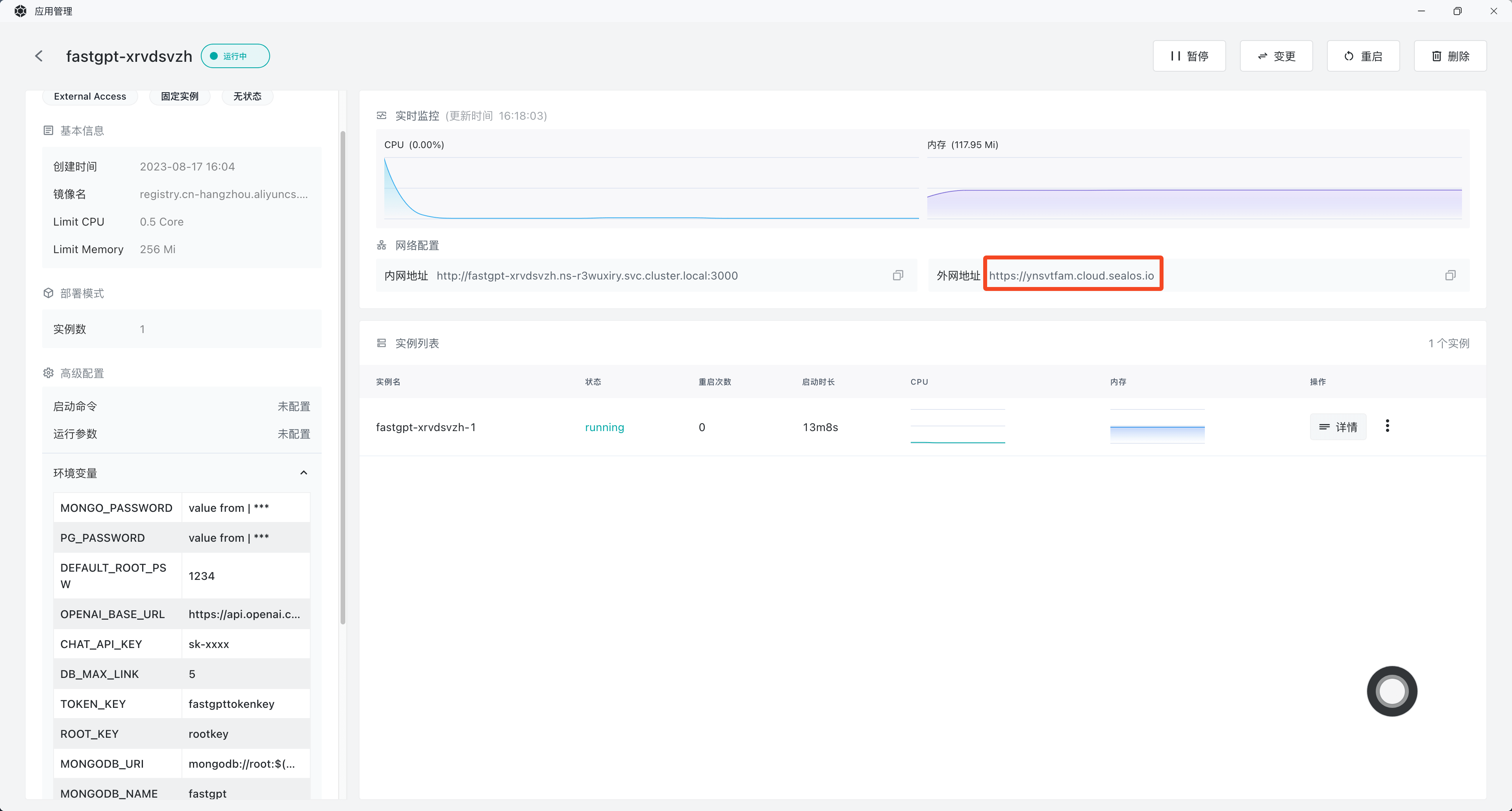

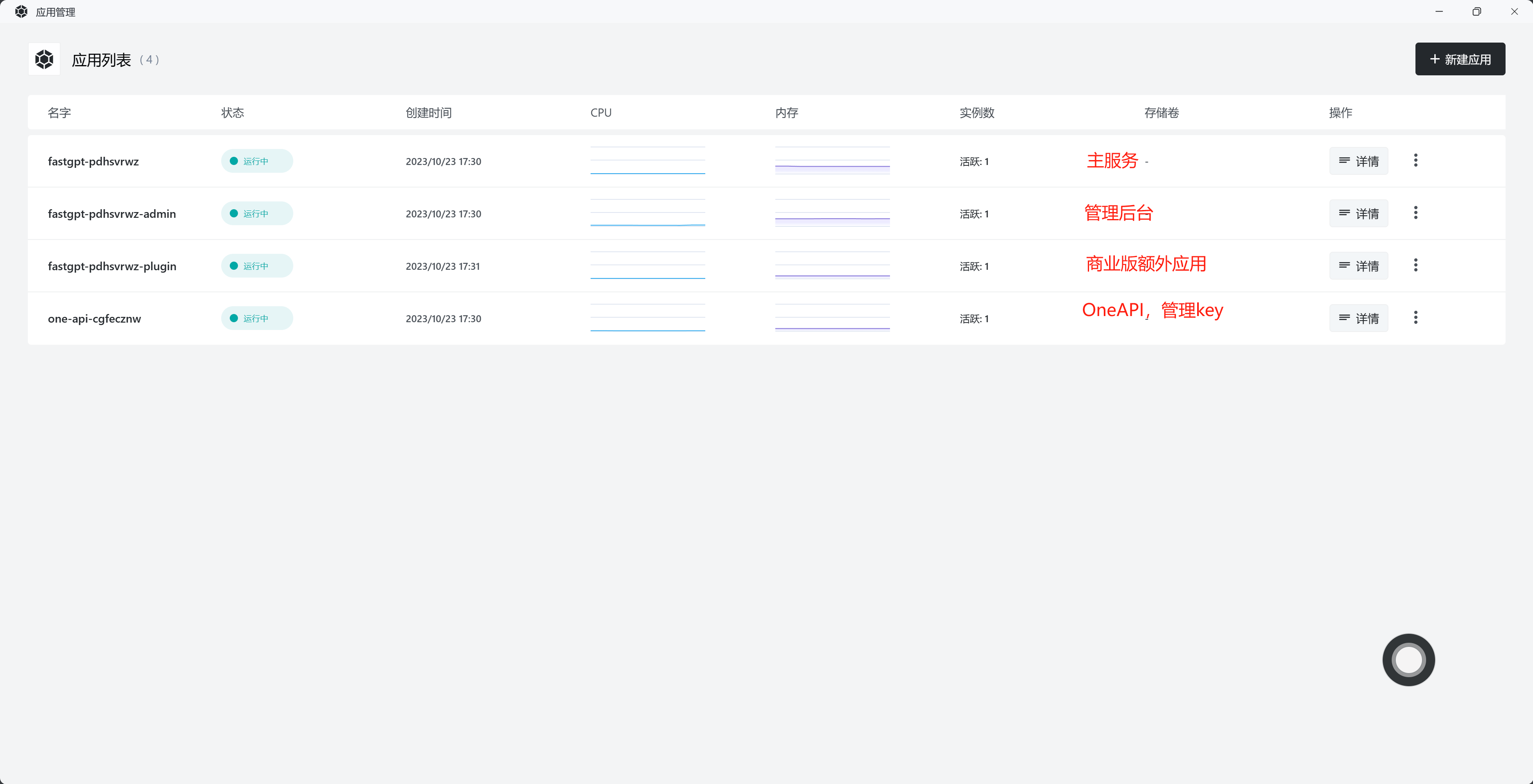

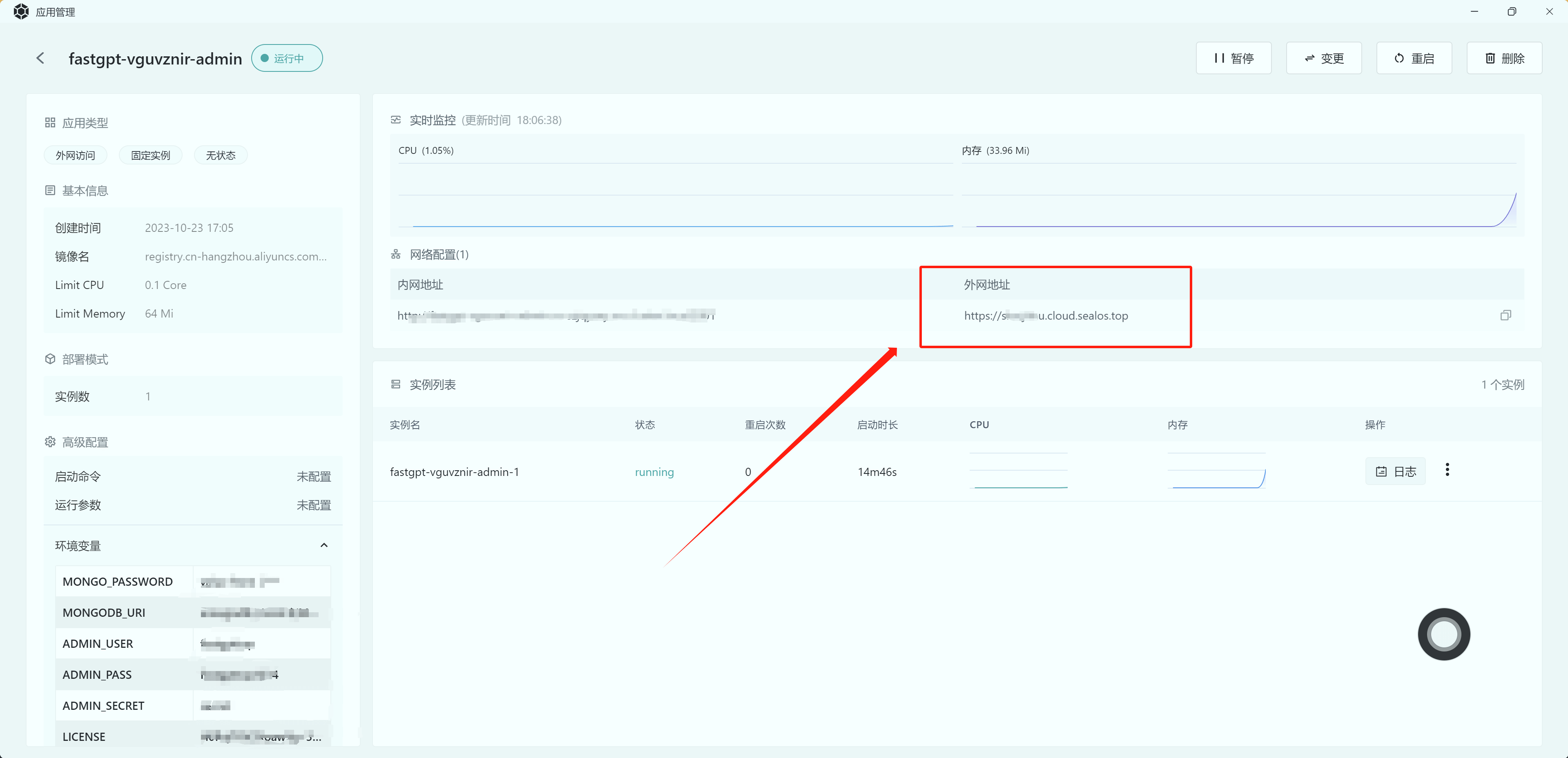

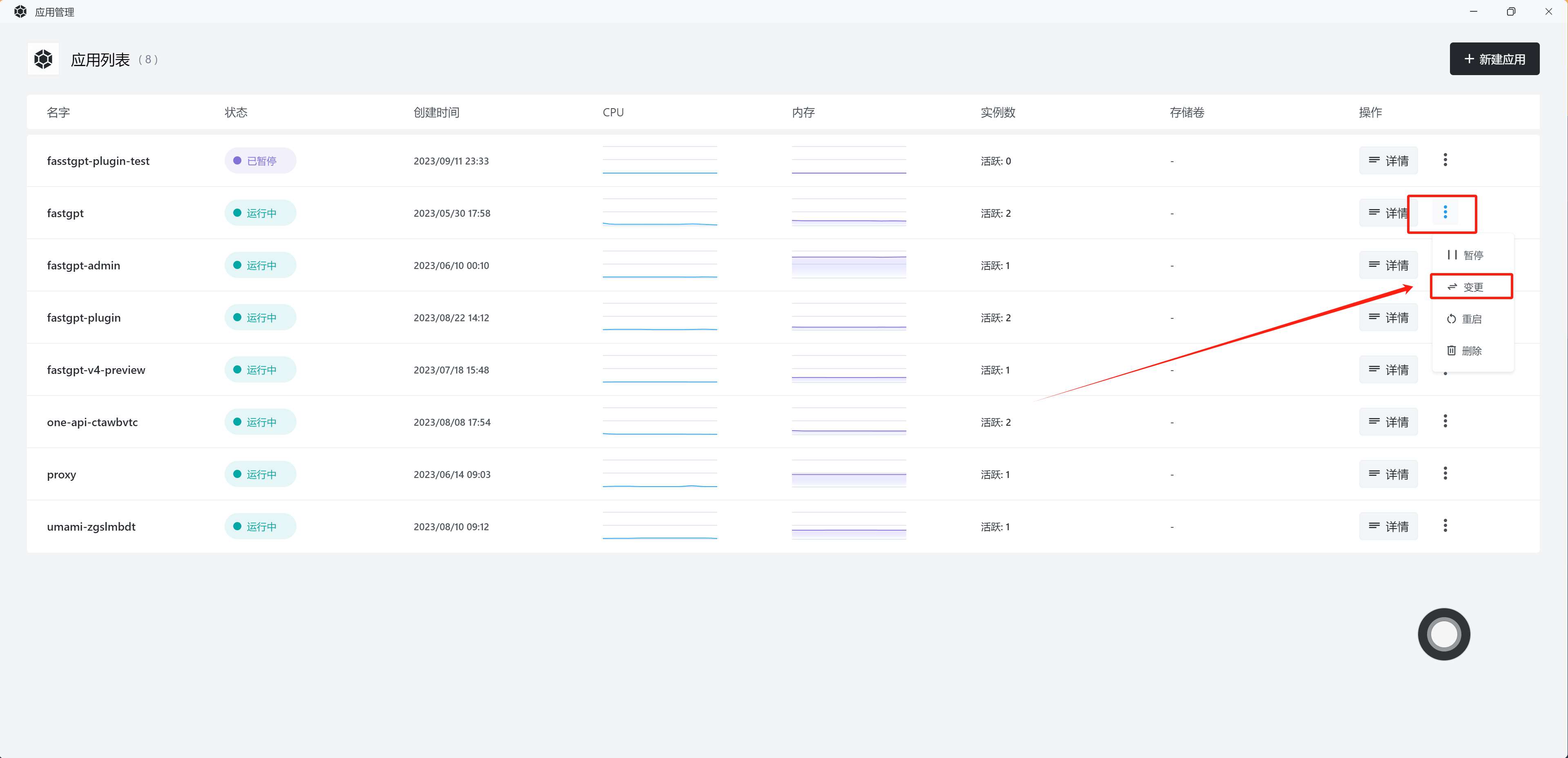

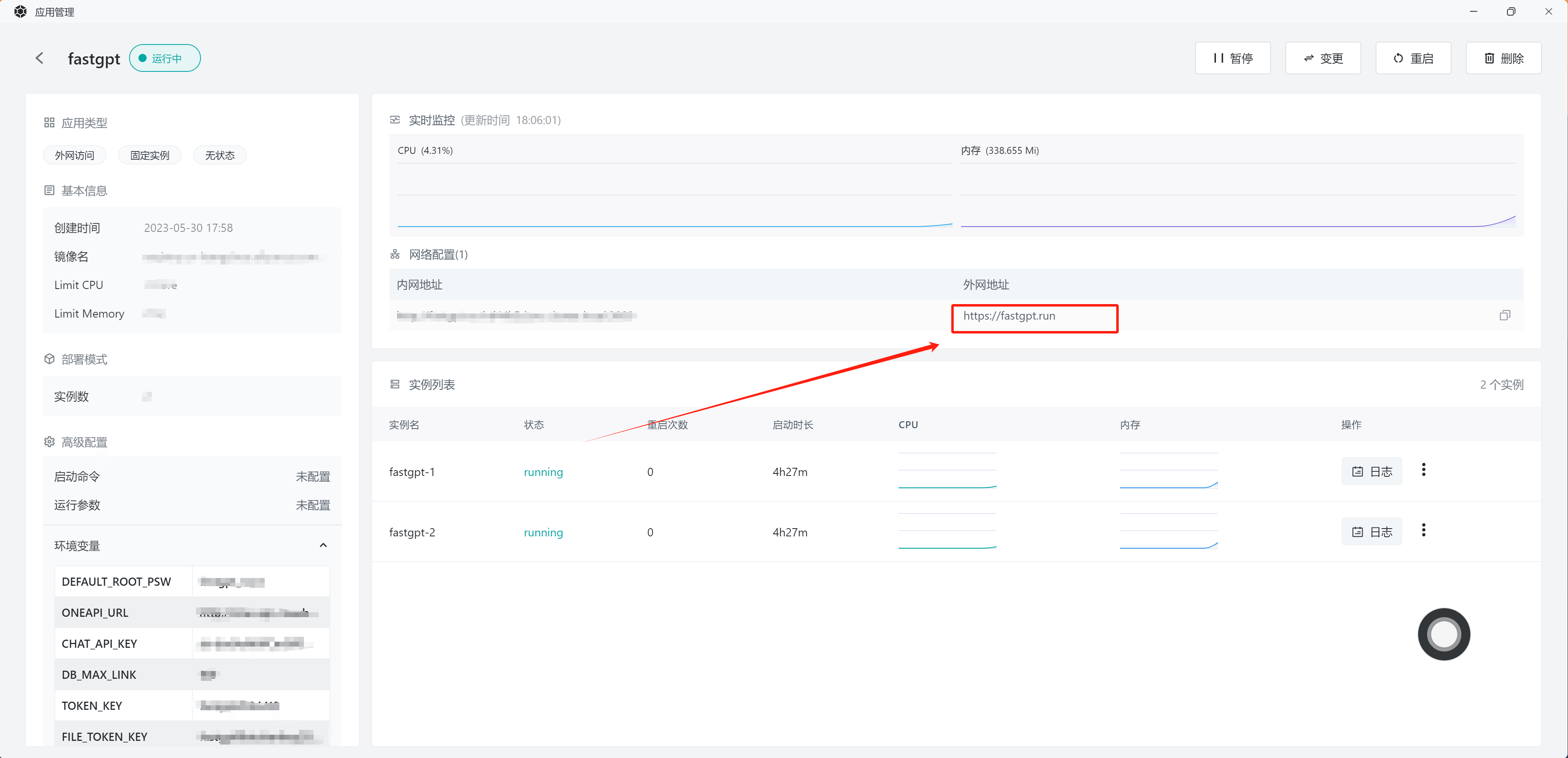

点击部署后,会跳转到应用管理页面。可以点击fastgpt主应用右侧的详情按键(名字为 fastgpt-xxxx), 如下图所示。

点击详情后,会跳转到 fastgpt 的部署管理页面,点击外网访问地址中的链接,即可打开 fastgpt 服务。

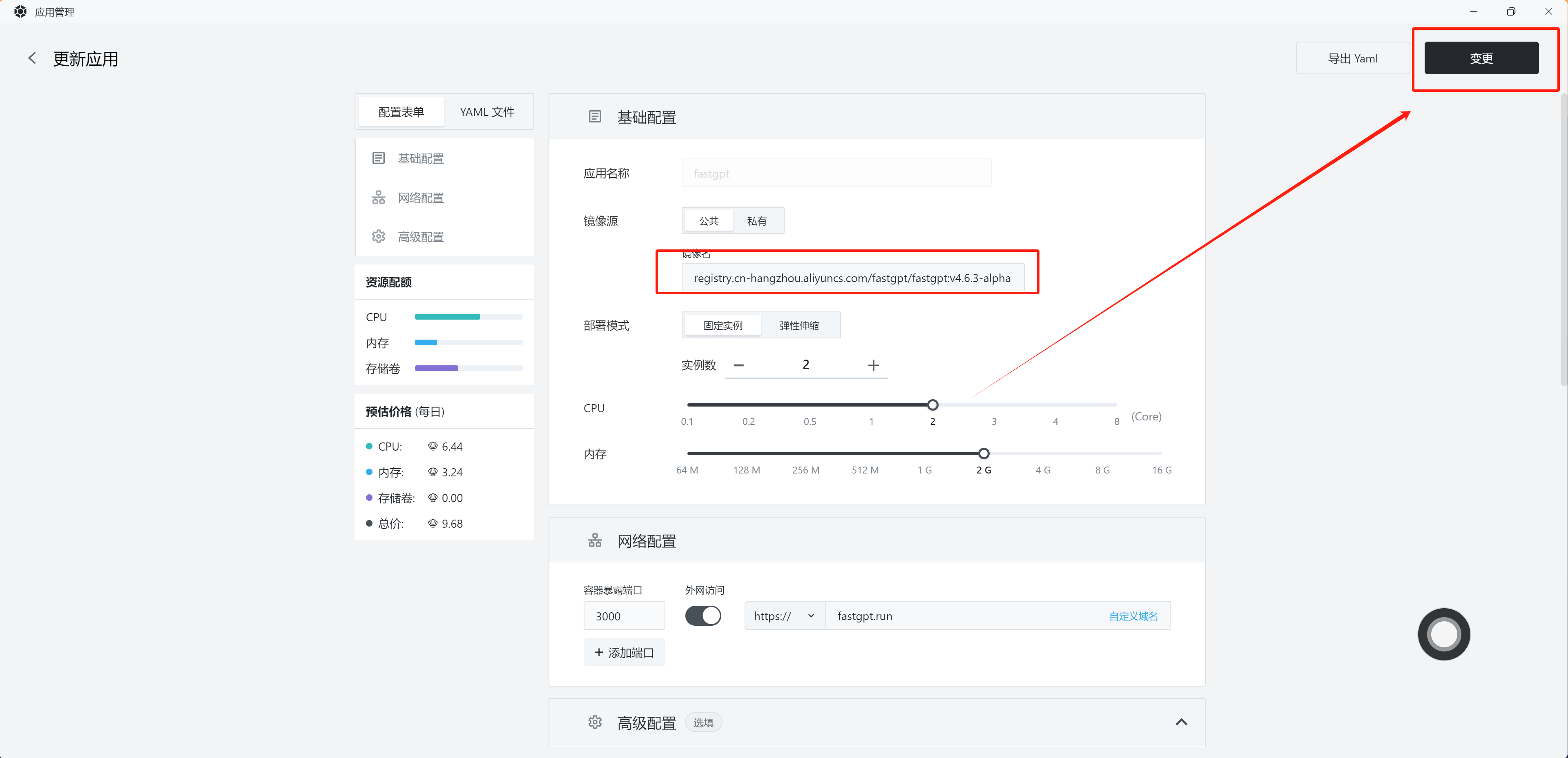

如需绑定自定义域名、修改部署参数,可以点击右上角变更,根据 sealos 的指引完成。

用户名:root

密码是刚刚一键部署时设置的root_password

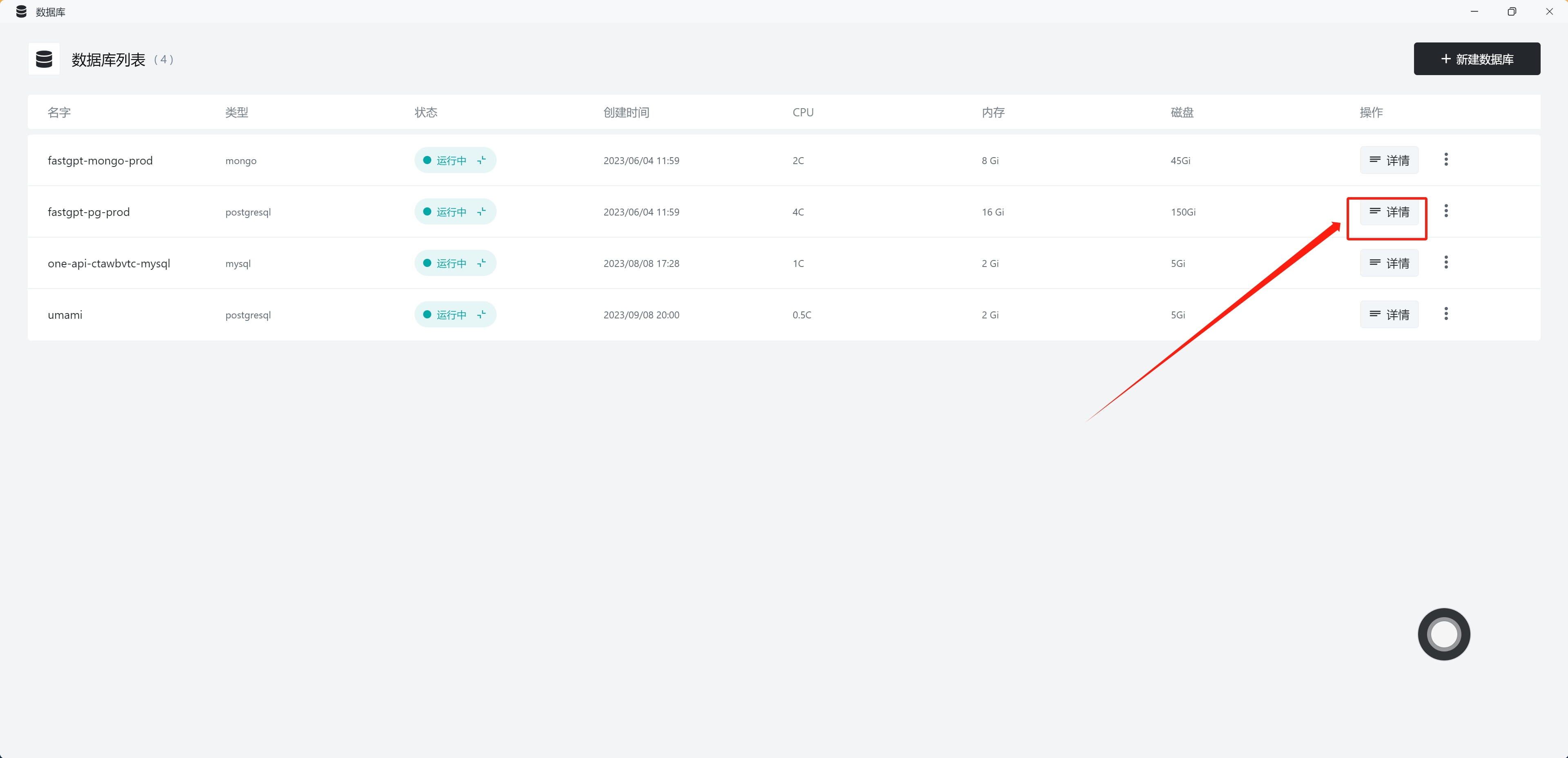

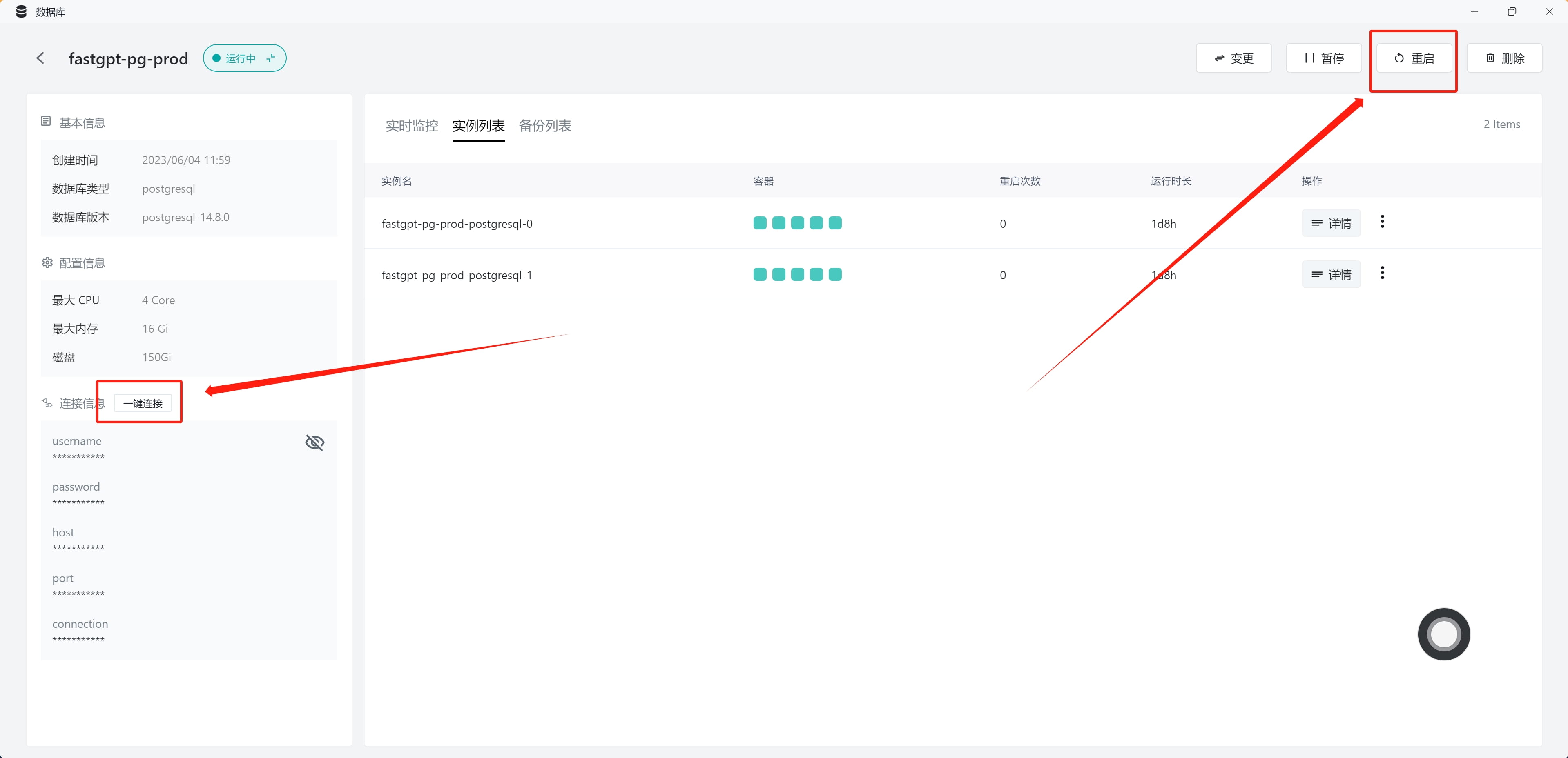

在 Sealos 中,你可以打开应用管理(App Launchpad)看到部署的 FastGPT,可以打开数据库(Database)看到对应的数据库。

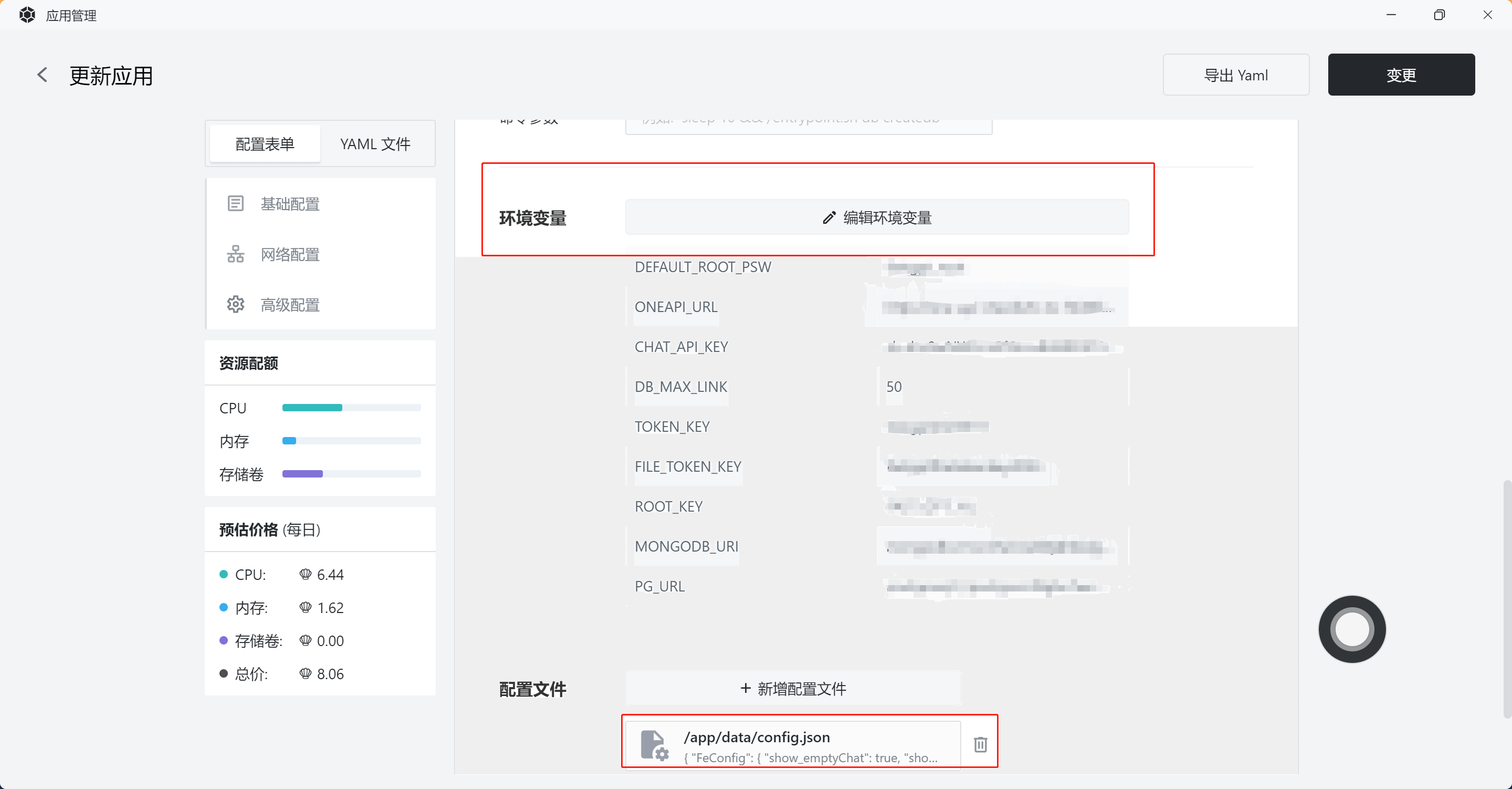

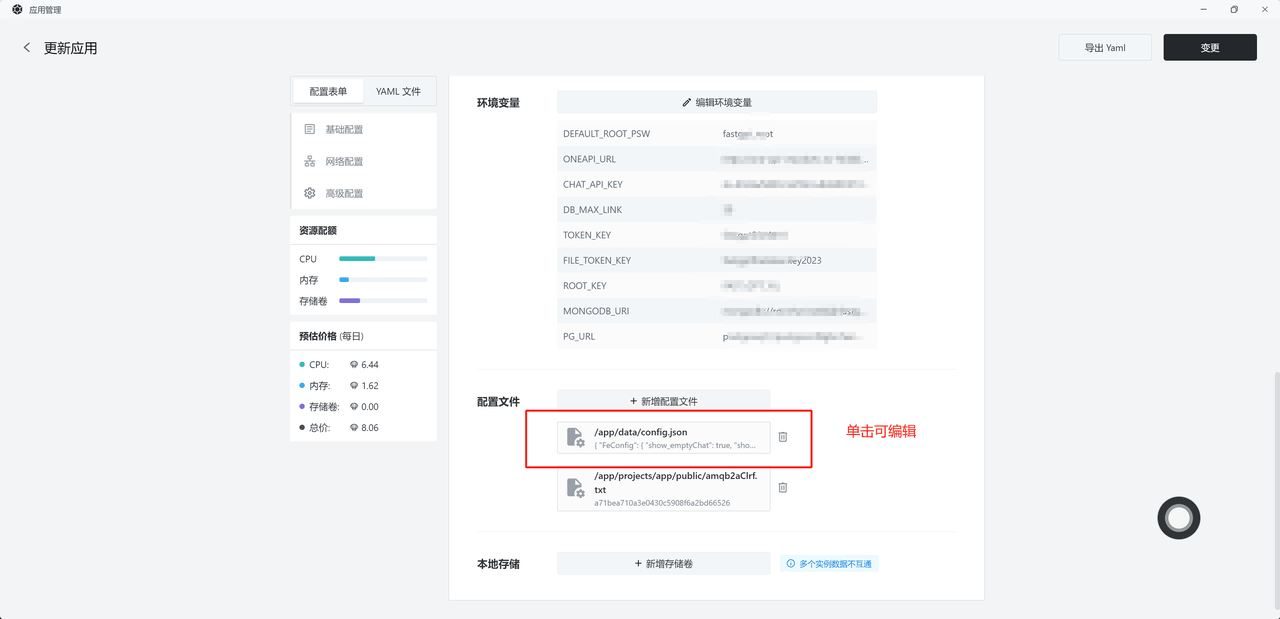

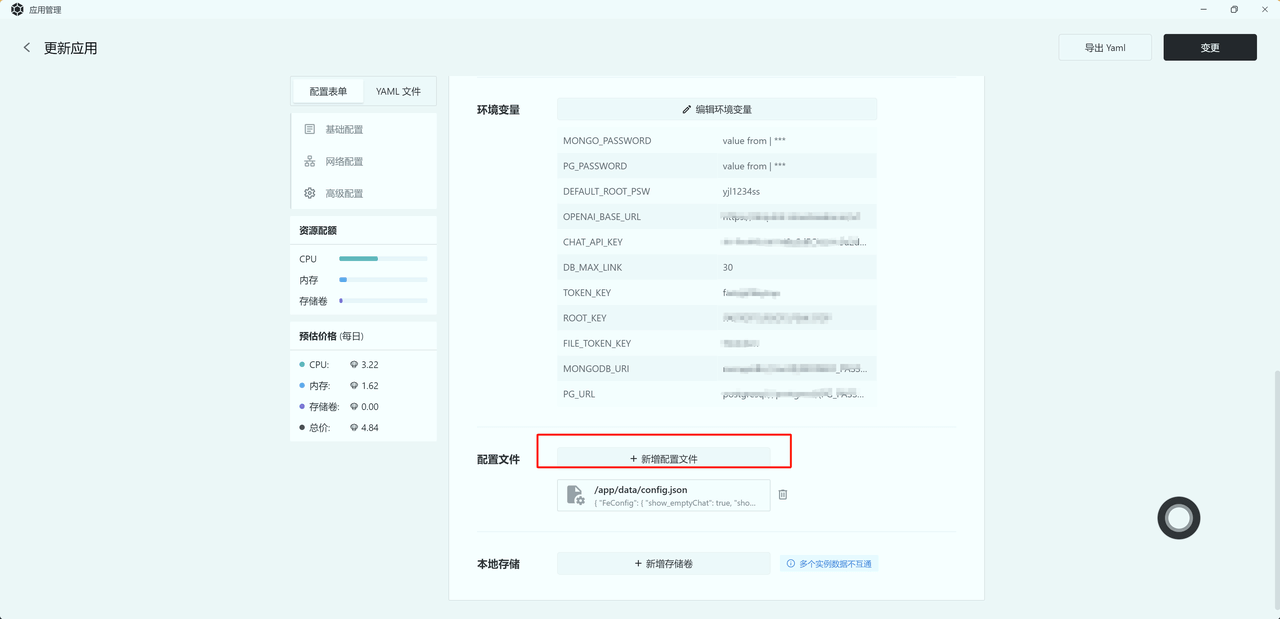

在应用管理中,选中 FastGPT,点击变更,可以看到对应的环境变量和配置文件。

在 Sealos 上,FastGPT 一共运行了 1 个服务和 2 个数据库,如暂停和删除请注意数据库一同操作。(你可以白天启动,晚上暂停它们,省钱大法)

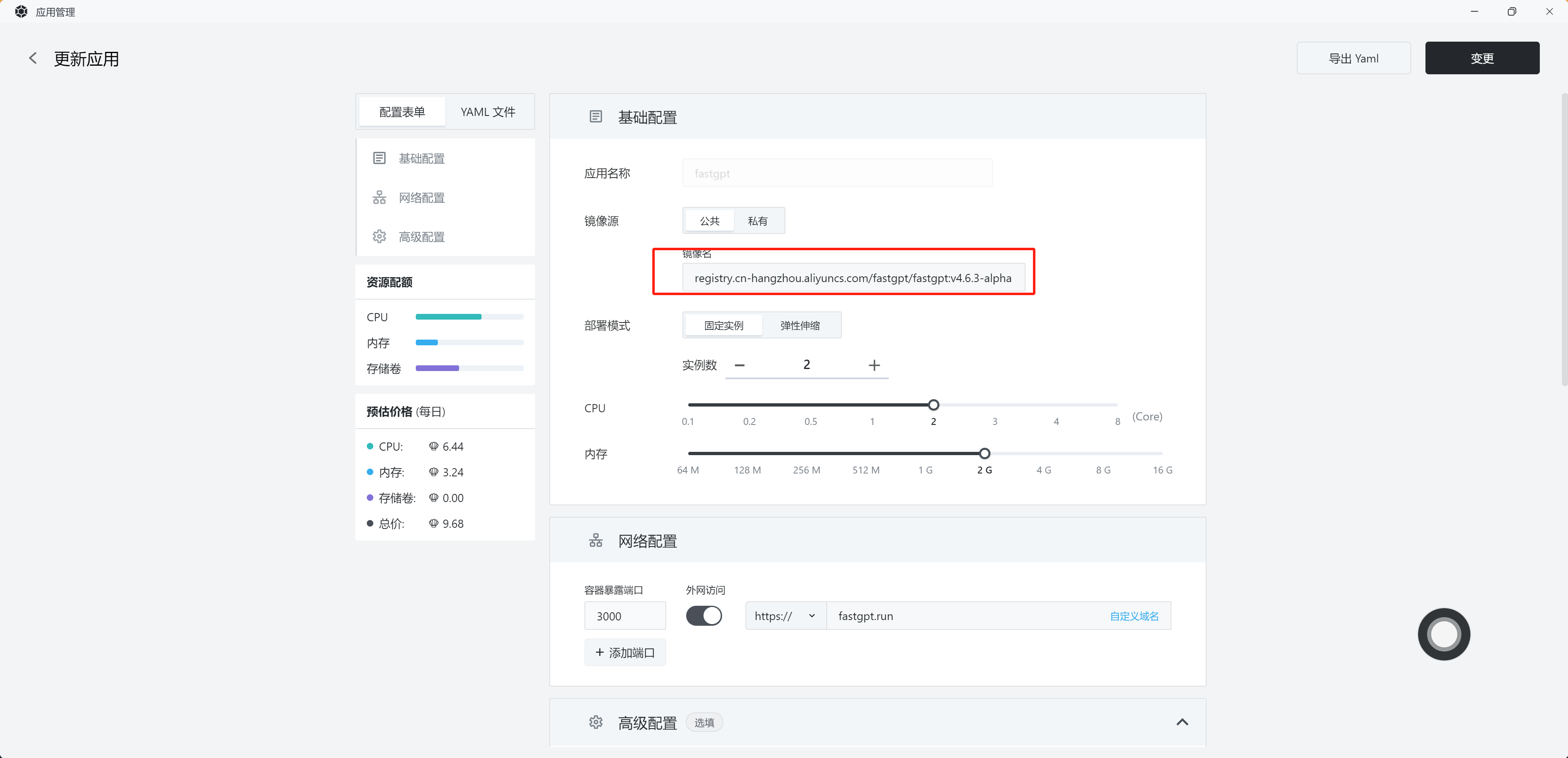

点击变更或重启会自动拉取镜像更新,请确保镜像tag正确。建议不要使用latest,改成固定版本号。

Sealos 采用按量计费的方式,也就是申请了多少 cpu、内存、磁盘,就按该申请量进行计费。具体的计费标准,可以打开sealos控制面板中的费用中心进行查看。

FastGPT 商业版共包含了2个应用(fastgpt, fastgpt-plus)和2个数据库,使用多 Api Key 时候需要安装 OneAPI(一个应用和一个数据库),总计3个应用和3个数据库。

点击右侧的详情,可以查看对应应用的详细信息。

升级脚本文档先看下文档,看下需要升级哪个版本。注意,不要跨版本升级!!!!!

例如,目前是4.5 版本,要升级到4.5.1,就先把镜像版本改成v4.5.1,执行一下升级脚本,等待完成后再继续升级。如果目标版本不需要执行初始化,则可以跳过。

升级步骤:

打开对应的应用,点击外网访问地址。

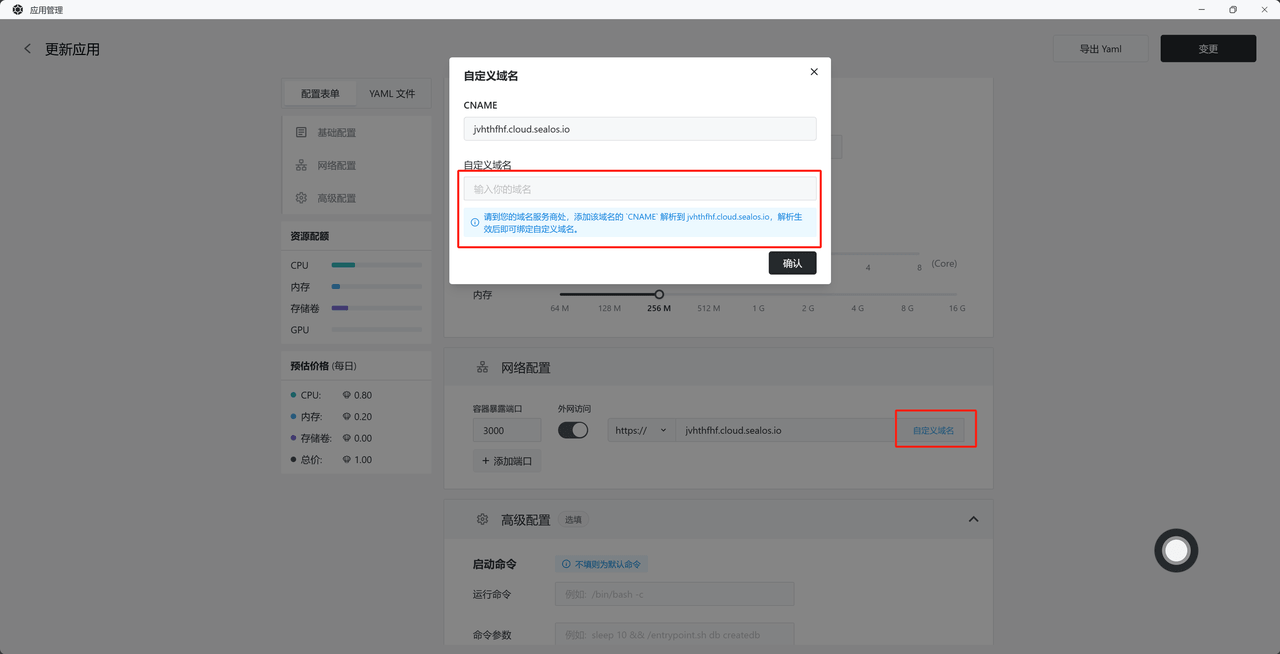

点击对应应用的变更->点击自定义域名->填写域名-> 操作域名 Cname -> 确认 -> 确认变。

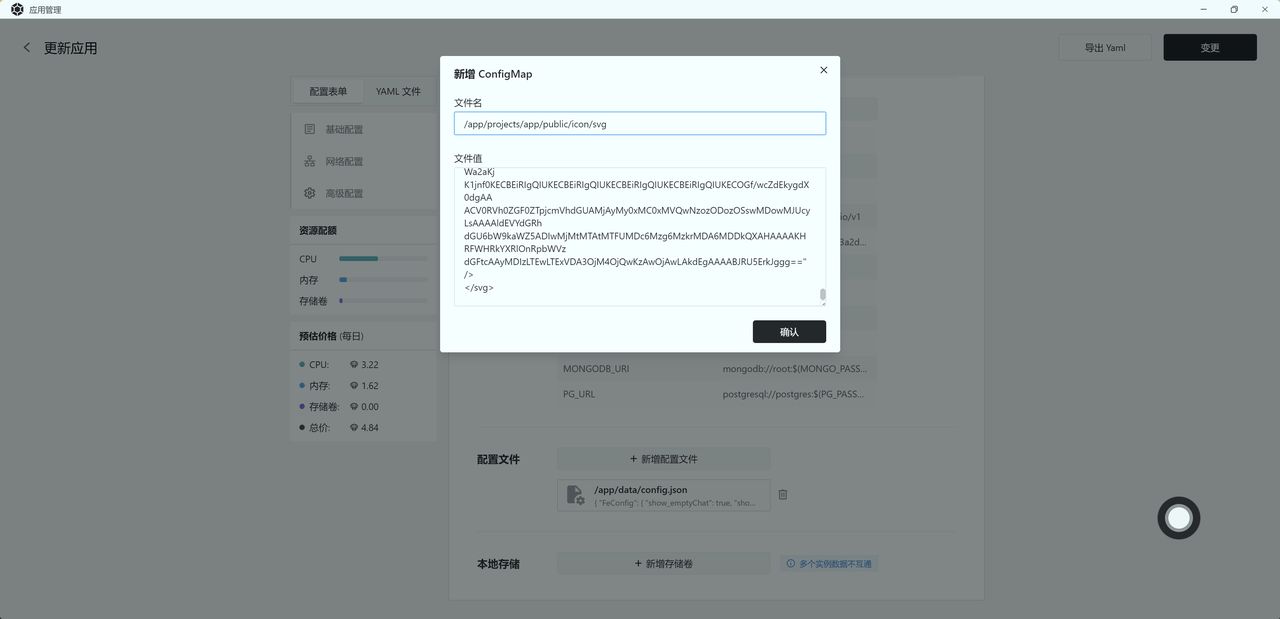

打开 Sealos 的应用管理 -> 找到对应的应用 -> 变更 -> 往下拉到高级配置,里面有个配置文件 -> 新增或点击对应的配置文件可以进行编辑 -> 点击右上角确认变。

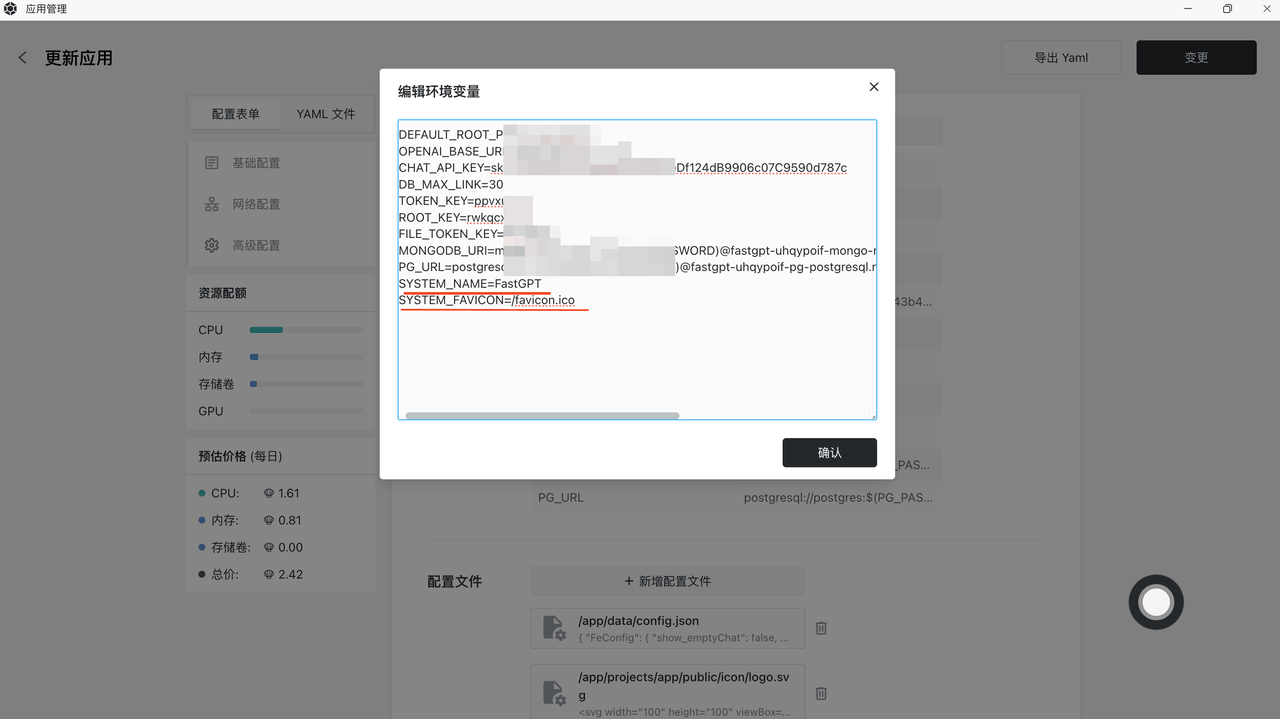

修改应用的环境变量,增加

+ SYSTEM_NAME=FastGPT

+SYSTEM_DESCRIPTION=

+SYSTEM_FAVICON=/favicon.ico

+HOME_URL=/app/list

+ SYSTEM_FAVICON 可以是一个网络地址

目前暂时无法 把浏览器上的logo替换。仅支持svg,待后续可视化做了后可以全部替换。 +新增一个挂载文件,文件名为:/app/projects/app/public/icon/logo.svg ,值为 svg 对应的值。

+ {

+ "license": "",

+ "system": {

+ "title": "" // 系统名称

+ }

+}

+ FastGPT 从旧版本升级到 V4.0 操作指南

如果您是从旧版本升级到 V4,由于新版 MongoDB 表变更比较大,需要按照本文档的说明执行一些初始化脚本。

需要连接上 MongoDB 数据库,执行两条命令:

+ db.models.renameCollection("apps")

+db.sharechats.renameCollection("outlinks")

+ 注意:从旧版更新到 V4, MongoDB 会自动创建空表,你需要先手动删除这两个空表,再执行上面的操作。

依次执行下面 3 条命令,时间比较长,不成功可以重复执行(会跳过已经初始化的数据),直到所有数据更新完成。

+ db.chats.find({appId: {$exists: false}}).forEach(function(item){

+ db.chats.updateOne(

+ {

+ _id: item._id,

+ },

+ { "$set": {"appId":item.modelId}}

+ )

+})

+

+db.collections.find({appId: {$exists: false}}).forEach(function(item){

+ db.collections.updateOne(

+ {

+ _id: item._id,

+ },

+ { "$set": {"appId":item.modelId}}

+ )

+})

+

+db.outlinks.find({shareId: {$exists: false}}).forEach(function(item){

+ db.outlinks.updateOne(

+ {

+ _id: item._id,

+ },

+ { "$set": {"shareId":item._id.toString(),"appId":item.modelId}}

+ )

+})

+ 部署新版项目,并发起 3 个 HTTP 请求(记得携带 headers.rootkey,这个值是环境变量里的)

1 和 2 有可能会因为内存不足挂掉,可以重复执行。

FastGPT 从旧版本升级到 V4.1 操作指南

如果您是从旧版本升级到 V4.1,由于新版重新设置了对话存储结构,需要初始化原来的存储内容。

V4.1 优化了 PostgreSQL 和 MongoDB 的连接变量,只需要填 1 个 URL 即可:

注意:/fastgpt 和 /postgres 是指数据库名称,需要和旧版的变量对应。

+ # mongo 配置,不需要改. 如果连不上,可能需要去掉 ?authSource=admin

+- MONGODB_URI=mongodb://username:password@mongo:27017/fastgpt?authSource=admin

+# pg配置. 不需要改

+- PG_URL=postgresql://username:password@pg:5432/postgres

+ 部署新版项目,并发起 1 个 HTTP 请求(记得携带 headers.rootkey,这个值是环境变量里的)

FastGPT 从旧版本升级到 V4.2 操作指南

99.9%用户不影响,升级 4.2 主要是修改了配置文件中 QAModel 的格式。从原先的数组改成对象:

+ "QAModel": {

+ "model": "gpt-3.5-turbo-16k",

+ "name": "GPT35-16k",

+ "maxToken": 16000,

+ "price": 0

+}

+ 改动目的是,我们认为不需要留有选择余地,选择一个最合适的模型去进行任务即可。

FastGPT 从旧版本升级到 V4.2.1 操作指南

私有部署,如果添加了配置文件,需要在配置文件中修改 VectorModels 字段。增加 defaultToken 和 maxToken,分别对应直接分段时的默认 token 数量和该模型支持的 token 上限 (通常不建议超过 3000)

+ "VectorModels": [

+ {

+ "model": "text-embedding-ada-002",

+ "name": "Embedding-2",

+ "price": 0,

+ "defaultToken": 500,

+ "maxToken": 3000

+ }

+]

+ 改动目的是,我们认为不需要留有选择余地,选择一个最合适的模型去进行任务即可。

FastGPT 从旧版本升级到 V4.3 操作指南

发起 1 个 HTTP 请求 (记得携带 headers.rootkey,这个值是环境变量里的)

+ curl --location --request POST 'https://{{host}}/api/admin/initv43' \

+--header 'rootkey: {{rootkey}}' \

+--header 'Content-Type: application/json'

+ 会给 PG 数据库的 modeldata 表插入一个新列 file_id,用于存储文件 ID。

增加一个 FILE_TOKEN_KEY 环境变量,用于生成文件预览链接,过期时间为 30 分钟。

+ FILE_TOKEN_KEY=filetokenkey

+ FastGPT 从旧版本升级到 V4.4 操作指南

发起 1 个 HTTP 请求 (记得携带 headers.rootkey,这个值是环境变量里的)

+ curl --location --request POST 'https://{{host}}/api/admin/initv44' \

+--header 'rootkey: {{rootkey}}' \

+--header 'Content-Type: application/json'

+ 会给初始化 Mongo 的部分字段。

FastGPT 从旧版本升级到 V4.4.1 操作指南

发起 1 个 HTTP 请求(记得携带 headers.rootkey,这个值是环境变量里的)

+ curl --location --request POST 'https://{{host}}/api/admin/initv441' \

+--header 'rootkey: {{rootkey}}' \

+--header 'Content-Type: application/json'

+ 会给初始化 Mongo 的 dataset.files,将所有数据设置为可用。

FastGPT 从旧版本升级到 V4.4.2 操作指南

发起 1 个 HTTP 请求 (记得携带 headers.rootkey,这个值是环境变量里的)

+ curl --location --request POST 'https://{{host}}/api/admin/initv442' \

+--header 'rootkey: {{rootkey}}' \

+--header 'Content-Type: application/json'

+ 会给初始化 Mongo 的 Bill 表的索引,之前过期时间有误。

FastGPT V4.4.5 更新

发起 1 个 HTTP 请求(记得携带 headers.rootkey,这个值是环境变量里的)

+ curl --location --request POST 'https://{{host}}/api/admin/initv445' \

+--header 'rootkey: {{rootkey}}' \

+--header 'Content-Type: application/json'

+ 初始化了 variable 模块,将其合并到用户引导模块中。

FastGPT V4.4.7 更新(需执行升级脚本)

发起 1 个 HTTP 请求({{rootkey}} 替换成环境变量里的rootkey,{{host}}替换成自己域名)

+ curl --location --request POST 'https://{{host}}/api/admin/initv447' \

+--header 'rootkey: {{rootkey}}' \

+--header 'Content-Type: application/json'

+ 初始化 pg 索引以及将 file_id 中空对象转成 manual 对象。如果数据多,可能需要较长时间,可以通过日志查看进度。

FastGPT V4.5 更新

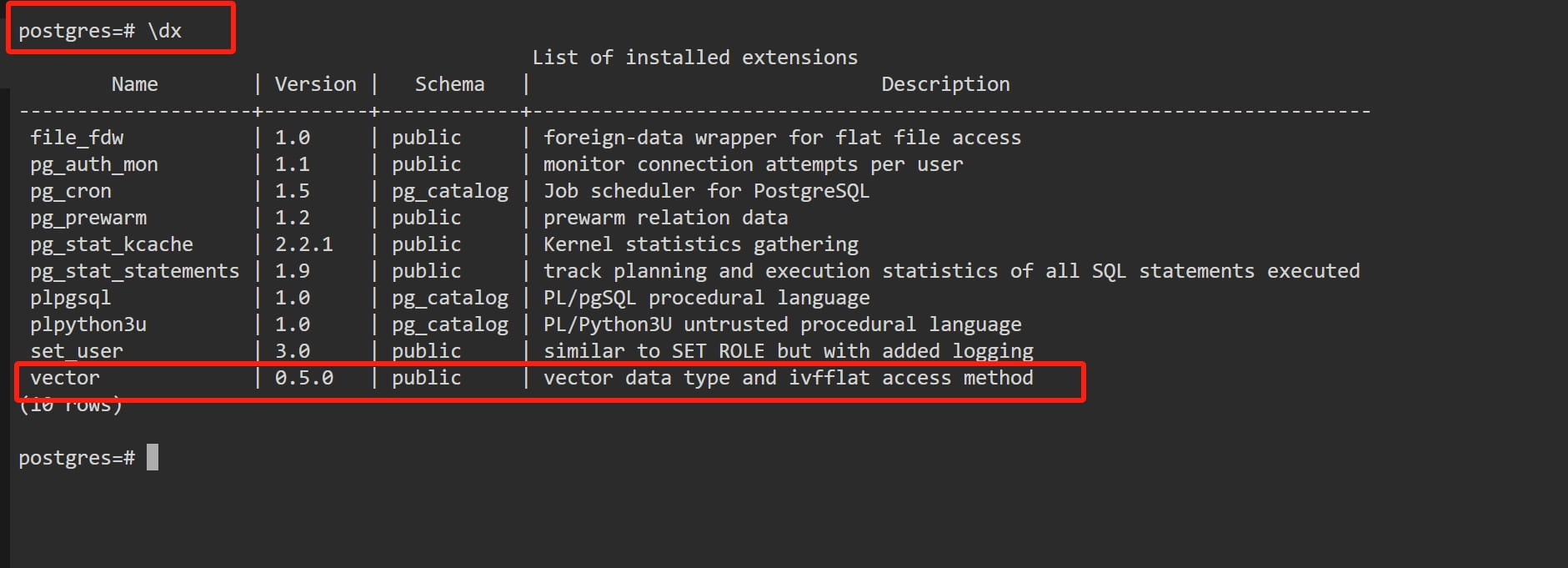

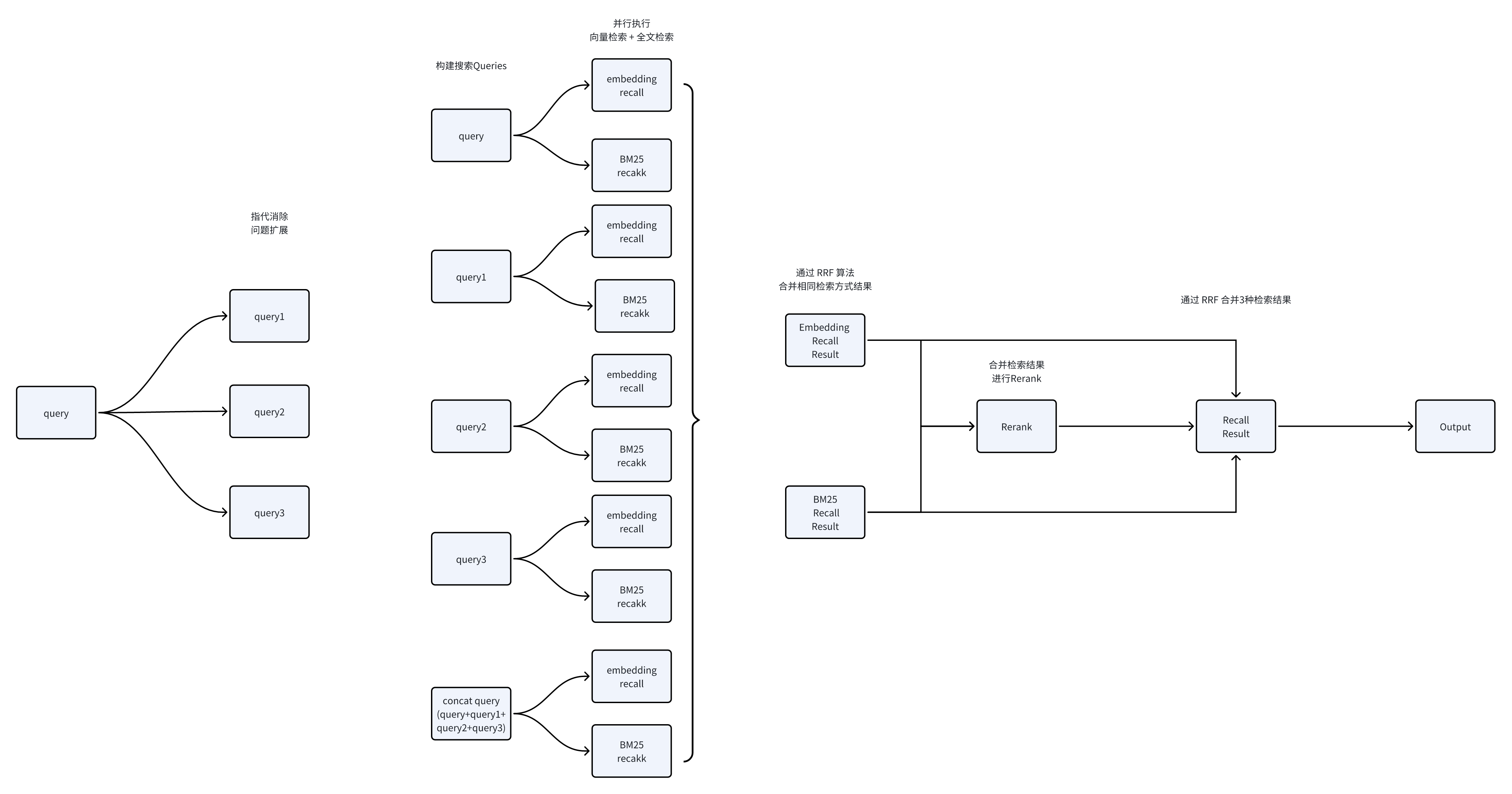

FastGPT V4.5 引入 PgVector0.5 版本的 HNSW 索引,极大的提高了知识库检索的速度,比起IVFFlat索引大致有3~10倍的性能提升,可轻松实现百万数据毫秒级搜索。缺点在于构建索引的速度非常慢,4c16g 500w 组数据使用并行构建大约花了 48 小时。具体参数配置可参考 PgVector官方

下面需要对数据库进行一些操作升级:

+ -- 升级插件名

+ALTER EXTENSION vector UPDATE;

+-- 插件是否升级成功,成功的话,vector插件版本为 0.5.0,旧版的为 0.4.1

+\dx

+

+-- 下面两个语句会设置 pg 在构建索引时可用的内存大小,需根据自身的数据库规格来动态配置,可配置为 1/4 的内存大小

+alter system set maintenance_work_mem = '2400MB';

+select pg_reload_conf();

+

+-- 重构数据库索引和排序

+REINDEX DATABASE postgres;

+

+-- 开始构建索引,该索引构建时间非常久,直接点击右上角的叉,退出 Terminal 即可

+CREATE INDEX CONCURRENTLY vector_index ON modeldata USING hnsw (vector vector_ip_ops) WITH (m = 16, ef_construction = 64);

+-- 可以再次点击一键链接,进入 Terminal,输入下方命令,如果看到 "vector_index" hnsw (vector vector_ip_ops) WITH (m='16', ef_construction='64') 则代表构建完成(注意,后面没有 INVALID)

+\d modeldata

+  |  |

|  |

下面的命令是基于给的 docker-compose 模板,如果数据库账号密码更换了,请自行调整。

docker-compose.yml 中pg的镜像版本,改成 ankane/pgvector:v0.5.0 或 registry.cn-hangzhou.aliyuncs.com/fastgpt/pgvector:v0.5.0docker exec -it pg bashpsql 'postgresql://username:password@localhost:5432/postgres'

+ -- 升级插件名

+ALTER EXTENSION vector UPDATE;

+-- 插件是否升级成功,成功的话,vector插件版本为 0.5.0,旧版的为 0.4.2

+\dx

+

+-- 下面两个语句会设置 pg 在构建索引时可用的内存大小,需根据自身的数据库规格来动态配置,可配置为 1/4 的内存大小

+alter system set maintenance_work_mem = '2400MB';

+select pg_reload_conf();

+

+-- 重构数据库索引和排序

+REINDEX DATABASE postgres;

+ALTER DATABASE postgres REFRESH COLLATION VERSION;

+

+-- 开始构建索引,该索引构建时间非常久,直接关掉终端即可,不要使用 ctrl+c 关闭

+CREATE INDEX CONCURRENTLY vector_index ON modeldata USING hnsw (vector vector_ip_ops) WITH (m = 16, ef_construction = 64);

+-- 可以再次连接数据库,输入下方命令。如果看到 "vector_index" hnsw (vector vector_ip_ops) WITH (m='16', ef_construction='64') 则代表构建完成(注意,后面没有 INVALID)

+\d modeldata

+ config.json 文件 最新配置可参考: V45版本最新 config.json

FastGPT V4.5.1 更新

发起 1 个 HTTP 请求({{rootkey}} 替换成环境变量里的rootkey,{{host}}替换成自己域名)

+ curl --location --request POST 'https://{{host}}/api/admin/initv451' \

+--header 'rootkey: {{rootkey}}' \

+--header 'Content-Type: application/json'

+ 初始化内容:

该初始化接口可能速度很慢,返回超时不用管,注意看日志即可

FastGPT V4.6 更新

V4.6 版本加入了简单的团队功能,可以邀请其他用户进来管理资源。该版本升级后无法执行旧的升级脚本,且无法回退。

更新镜像至 latest 或者 v4.6 版本。商业版镜像更新至 V0.2.1

最新配置可参考:V46 版本最新 config.json,商业镜像配置文件也更新,参考最新的飞书文档。

发起 2 个 HTTP 请求 ({{rootkey}} 替换成环境变量里的 rootkey,{{host}} 替换成自己域名)

该初始化接口可能速度很慢,返回超时不用管,注意看日志即可,需要注意的是,需确保 initv46 成功后,在执行 initv46-2

+ curl --location --request POST 'https://{{host}}/api/admin/initv46' \

+--header 'rootkey: {{rootkey}}' \

+--header 'Content-Type: application/json'

+

+ curl --location --request POST 'https://{{host}}/api/admin/initv46-2' \

+--header 'rootkey: {{rootkey}}' \

+--header 'Content-Type: application/json'

+ 初始化内容: +1。创建默认团队 +2。初始化 Mongo 所有资源的团队字段 +3。初始化 Pg 的字段 +4。初始化 Mongo Data

旧的 4.6 版本由于缺少一个字段,导致文件导入时知识库数据无法显示,可执行下面的脚本:

https://xxxxx/api/admin/initv46-fix

+ curl --location --request POST 'https://{{host}}/api/admin/initv46-fix' \

+--header 'rootkey: {{rootkey}}' \

+--header 'Content-Type: application/json'

+ FastGPT V4.6 .1

FastGPT V4.6.2

发起 1 个 HTTP 请求 ({{rootkey}} 替换成环境变量里的 rootkey,{{host}} 替换成自己域名)

+ curl --location --request POST 'https://{{host}}/api/admin/initv462' \

+--header 'rootkey: {{rootkey}}' \

+--header 'Content-Type: application/json'

+ 初始化说明:

FastGPT V4.6.3

发起 1 个 HTTP 请求 ({{rootkey}} 替换成环境变量里的 rootkey,{{host}} 替换成自己域名)

+ curl --location --request POST 'https://{{host}}/api/admin/initv463' \

+--header 'rootkey: {{rootkey}}' \

+--header 'Content-Type: application/json'

+ 初始化说明:

FastGPT V4.6.4

发起 1 个 HTTP 请求 ({{rootkey}} 替换成环境变量里的 rootkey,{{host}} 替换成自己域名)

+ curl --location --request POST 'https://{{host}}/api/admin/initv464' \

+--header 'rootkey: {{rootkey}}' \

+--header 'Content-Type: application/json'

+ 初始化说明:

身份鉴权地址,仅需3个接口即可完全接入已有用户系统。具体参考分享链接身份鉴权FastGPT V4.6.5

由于 openai 已开始弃用 function call,改为 toolChoice。FastGPT 同步的修改了对于的配置和调用方式,需要对配置文件做一些修改:

functionCall字段,改成toolChoice即可。设置为true的模型,会默认走 openai 的 tools 模式;未设置或设置为false的,会走提示词生成模式。问题优化模型与内容提取模型使用同一组配置。

"ReRankModels": []FastGPT V4.6.6

为了减少代码重复度,我们对配置文件做了一些修改:点击查看最新的配置文件

更新商业版镜像到 4.6.6 版本。

将旧版配置文件中的 SystemParams.pluginBaseUrl 放置到环境变量中:

PRO_URL=商业版镜像地址(此处不再需要以 /api 结尾),例如:

PRO_URL=http://fastgpt-plugin.ns-hsss5d.svc.cluster.local:3000

原本在配置文件中的 FeConfig 已被移除,可以直接打开新的商业版镜像外网地址进行配置。包括 FastGPT 的各个参数和模型都可以直接在商业版镜像中配置,无需再变更 config.json 文件。

FastGPT V4.6.7

发起 1 个 HTTP 请求 ({{rootkey}} 替换成环境变量里的 rootkey,{{host}} 替换成自己域名)

+ curl --location --request POST 'https://{{host}}/api/admin/initv467' \

+--header 'rootkey: {{rootkey}}' \

+--header 'Content-Type: application/json'

+ 初始化说明:

FastGPT V4.6.8更新说明

command和entrypoint

+ mongo:

+ image: mongo:5.0.18

+ # image: registry.cn-hangzhou.aliyuncs.com/fastgpt/mongo:5.0.18 # 阿里云

+ container_name: mongo

+ ports:

+ - 27017:27017

+ networks:

+ - fastgpt

+ command: mongod --keyFile /data/mongodb.key --replSet rs0

+ environment:

+ # 这里密码注意要和以前的一致

+ - MONGO_INITDB_ROOT_USERNAME=username

+ - MONGO_INITDB_ROOT_PASSWORD=password

+ volumes:

+ - ./mongo/data:/data/db

+ entrypoint:

+ - bash

+ - -c

+ - |

+ openssl rand -base64 128 > /data/mongodb.key

+ chmod 400 /data/mongodb.key

+ chown 999:999 /data/mongodb.key

+ echo 'const isInited = rs.status().ok === 1

+ if(!isInited){

+ rs.initiate({

+ _id: "rs0",

+ members: [

+ { _id: 0, host: "mongo:27017" }

+ ]

+ })

+ }' > /data/initReplicaSet.js

+ # 启动MongoDB服务

+ exec docker-entrypoint.sh "$@" &

+

+ # 等待MongoDB服务启动

+ until mongo -u myusername -p mypassword --authenticationDatabase admin --eval "print('waited for connection')" > /dev/null 2>&1; do

+ echo "Waiting for MongoDB to start..."

+ sleep 2

+ done

+

+ # 执行初始化副本集的脚本

+ mongo -u myusername -p mypassword --authenticationDatabase admin /data/initReplicaSet.js

+

+ # 等待docker-entrypoint.sh脚本执行的MongoDB服务进程

+ wait $!

+

+ # 重启 Mongo

+docker-compose down

+docker-compose up -d

+ 去除了重复的模型配置,LLM模型都合并到一个属性中:点击查看最新的配置文件

商业版用户需要执行一个初始化,格式化团队信息。

发起 1 个 HTTP 请求 ({{rootkey}} 替换成环境变量里的 rootkey,{{host}} 替换成商业版域名)

+ curl --location --request POST 'https://{{host}}/api/init/v468' \

+--header 'rootkey: {{rootkey}}' \

+--header 'Content-Type: application/json'

+ 会初始化计费系统,内部使用可把免费的存储拉大。

defaultConfig传入默认的配置。ChatNextWeb的流,更加丝滑。此外,之前提到的乱码、中断,刷新后又正常了,可能会修复)FastGPT V4.6.9更新说明

增加 oneapi 地址和令牌。

+ OPENAI_BASE_URL=http://oneapi:3000/v1

+CHAT_API_KEY=sk-fastgpt

+ 从任意终端,发起 1 个 HTTP 请求。其中 {{rootkey}} 替换成环境变量里的 rootkey;{{host}} 替换成自己域名

+ curl --location --request POST 'https://{{host}}/api/admin/initv469' \

+--header 'rootkey: {{rootkey}}' \

+--header 'Content-Type: application/json'

+ token字段(总token数量)。FastGPT V4.7更新说明

增加一些 Boolean 值,用于决定不同功能块可以使用哪些模型,同时增加了模型的 logo:点击查看最新的配置文件

升级完镜像后。从任意终端,发起 1 个 HTTP 请求。其中 {{rootkey}} 替换成环境变量里的 rootkey;{{host}} 替换成自己域名

+ curl --location --request POST 'https://{{host}}/api/admin/initv47' \

+--header 'rootkey: {{rootkey}}' \

+--header 'Content-Type: application/json'

+ 脚本功能:

4.7对ReRank模型进行了格式变动,兼容 cohere 的格式,可以直接使用 cohere 提供的 API。如果是本地的 ReRank 模型,需要修改镜像为:registry.cn-hangzhou.aliyuncs.com/fastgpt/bge-rerank-base:v0.1 。

cohere的重排模型对中文不是很好,感觉不如 bge 的好用,接入教程如下:

+ {

+ "reRankModels": [

+ {

+ "model": "rerank-multilingual-v2.0", // 这里的 model 需要对应 cohere 的模型名

+ "name": "检索重排", // 随意

+ "requestUrl": "https://api.cohere.ai/v1/rerank",

+ "requestAuth": "Coherer上申请的key"

+ }

+ ]

+}

+ functionCall 设置为 true, toolChoice设置为 false。如果 toolChoice 为 true,会走 tool 模式。FastGPT V4.7.1 更新说明

从任意终端,发起 1 个 HTTP 请求。其中 {{rootkey}} 替换成环境变量里的 rootkey;{{host}} 替换成FastGPT的域名。

+ curl --location --request POST 'https://{{host}}/api/admin/clearInvalidData' \

+--header 'rootkey: {{rootkey}}' \

+--header 'Content-Type: application/json'

+ 该请求会执行脏数据清理(清理无效的文件、清理无效的图片、清理无效的知识库集合、清理无效的向量)

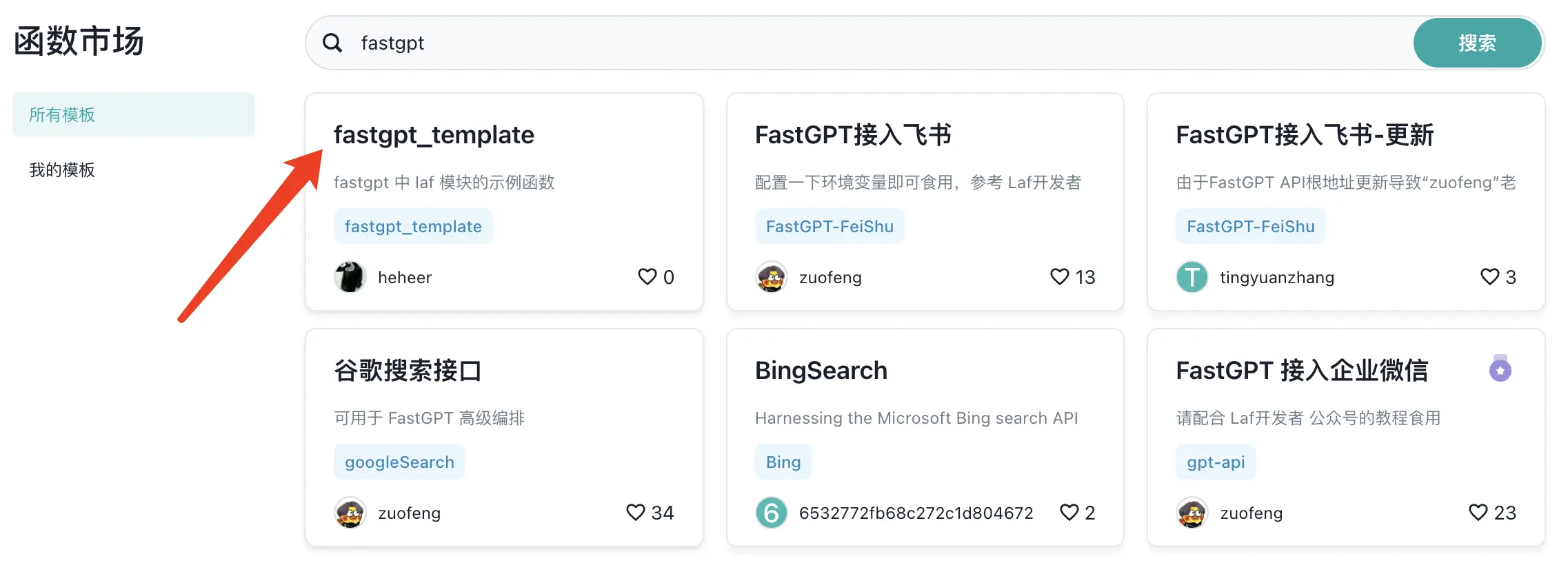

增加了Laf环境配置:点击查看最新的配置文件

FastGPT V4.8 更新说明

FastGPT workflow V2上线,支持更加简洁的工作流模式。

由于工作流差异较大,不少地方需要手动重新构建。请依次重建插件和应用

简易尽快更新工作流,避免未来持续迭代后导致无法兼容。

给应用和插件增加了 version 的字段,用于标识是旧工作流还是新工作流。当你更新 4.8 后,保存和新建的工作流均为新版,旧版工作流会有一个重置的弹窗提示。并且,如果是通过 API 和 分享链接 调用的工作流,仍可以正常使用,直到你下次保存它们。

商业版用户如果配置了邮件验证码,需要在管理端 -> 项目配置 -> 登录配置 -> 邮箱登录配置 -> 修改 邮箱服务SMTP地址,之前只能配置别名,现在可以配置自定义的地址。下面是一组别名和实际地址关系:

qq: smtp.qq.com +gmail: smtp.gmail.com

FastGPT V4.8.1 更新说明

从任意终端,发起 1 个 HTTP 请求。其中 {{rootkey}} 替换成环境变量里的 rootkey;{{host}} 替换成FastGPT的域名。

+ curl --location --request POST 'https://{{host}}/api/admin/initv481' \

+--header 'rootkey: {{rootkey}}' \

+--header 'Content-Type: application/json'

+ 由于之前集合名不规范,该初始化会重置表名。请在初始化前,确保 dataset.trainings 表没有数据。 +最好更新该版本时,暂停所有进行中业务,再进行初始化,避免数据冲突。

从任意终端,发起 1 个 HTTP 请求。其中 {{rootkey}} 替换成环境变量里的 rootkey;{{host}} 替换成FastGPT的域名。

+ curl --location --request POST 'https://{{host}}/api/admin/clearInvalidData' \

+--header 'rootkey: {{rootkey}}' \

+--header 'Content-Type: application/json'

+ 初始化完后,可以执行这个命令。之前定时清理的定时器有些问题,部分数据没被清理,可以手动执行清理。

使用 Chat api 接口需要注意,增加了 event: updateVariables 事件,用于更新变量。

FastGPT V4.8.10 更新说明